共计 6943 个字符,预计需要花费 18 分钟才能阅读完成。

HBase 中的表一般有这样的特点:

1 大:一个表可以有上亿行,上百万列

2 面向列: 面向列 (族) 的存储和权限控制,列 (族) 独立检索。

3 稀疏: 对于为空 (null) 的列,并不占用存储空间,因此,表可以设计的非常稀疏。

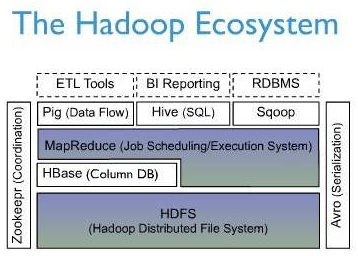

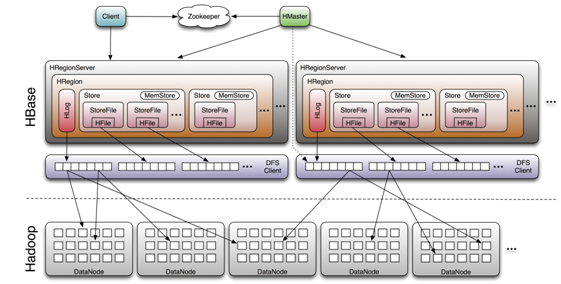

下面一幅图是 Hbase 在 Hadoop Ecosystem 中的位置。

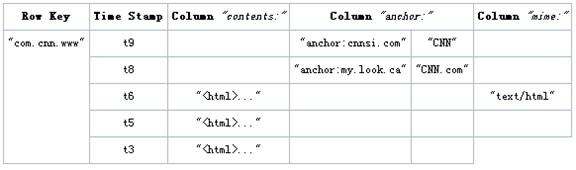

逻辑视图

HBase 以表的形式存储数据。表有行和列组成。列划分为若干个列族(row family)

Row Key

与 nosql 数据库们一样,row key 是用来检索记录的主键。访问 hbase table 中的行,只有三种方式:

1 通过单个 row key 访问

2 通过 row key 的 range

3 全表扫描

Row key 行键 (Row key)可以是任意字符串(最大长度是 64KB,实际应用中长度一般为 10-100bytes),在 hbase 内部,row key 保存为字节数组。

存储时,数据按照 Row key 的字典序 (byte order) 排序存储。设计 key 时,要充分排序存储这个特性,将经常一起读取的行存储放到一起。(位置相关性)

注意:

字典序对 int 排序的结果是:

1,10,100,11,12,13,14,15,16,17,18,19,2,20,21,…,9,91,92,93,94,95,96,97,98,99。要保持整形的自然序,行键必须用 0 作左填充。

行的一次读写是原子操作 (不论一次读写多少列)。这个设计决策能够使用户很容易的理解程序在对同一个行进行并发更新操作时的行为。

列族

hbase 表中的每个列,都归属与某个列族。列族是表的 chema 的一部分(而列不是),必须在使用表之前定义。列名都以列族作为前缀。例如 courses:history,courses:math 都属于 courses 这个列族。

访 问控制、磁盘和内存的使用统计都是在列族层面进行的。实际应用中,列族上的控制权限能帮助我们管理不同类型的应用:我们允许一些应用可以添加新的基本数 据、一些应用可以读取基本数据并创建继承的列族、一些应用则只允许浏览数据(甚至可能因为隐私的原因不能浏览所有数据)。

时间戳

HBase 中通过 row 和 columns 确定的为一个存贮单元称为 cell。每个 cell 都保存着同一份数据的多个版本。版本通过时间戳来索引。时间戳的类型是 64 位整型。时间戳可以由 hbase(在数据写入时自动)赋值,此时时间戳是精确到毫秒的当前系统时间。时间戳也可以由客户显式赋值。如果应用程序要避免数据版本冲突,就必须自己生成具有唯一性的时间戳。每个 cell 中,不同版本的数据按照时间倒序排序,即最新的数据排在最前面。

为了避免数据存在过多版本造成的的管理 (包括存贮和索引)负担,hbase 提供了两种数据版本回收方式。一是保存数据的最后 n 个版本,二是保存最近一段时间内的版本(比如最近七天)。用户可以针对每个列族进行设置。

Cell

由{row key, column(= +), version} 唯一确定的单元。cell 中的数据是没有类型的,全部是字节码形式存贮。

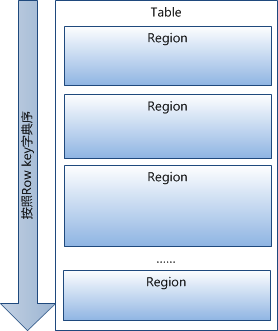

物理存储

1 已经提到过,Table 中的所有行都按照 row key 的字典序排列。

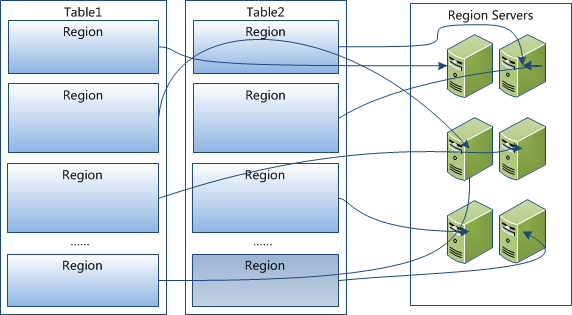

2 Table 在行的方向上分割为多个 Hregion。

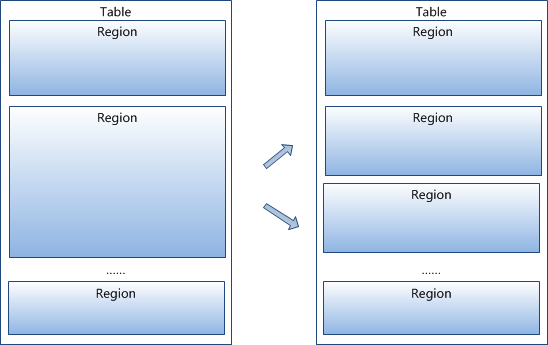

3 region 按大小分割的,每个表一开始只有一个 region,随着数据不断插入表,region 不断增大,当增大到一个阀值的时候,Hregion 就会等分会两个新的 Hregion。当 table 中的行不断增多,就会有越来越多的 Hregion。

4 HRegion 是 Hbase 中分布式存储和负载均衡的最小单元。最小单元就表示不同的 Hregion 可以分布在不同的 HRegion server 上。但一个 Hregion 是不会拆分到多个 server 上的。

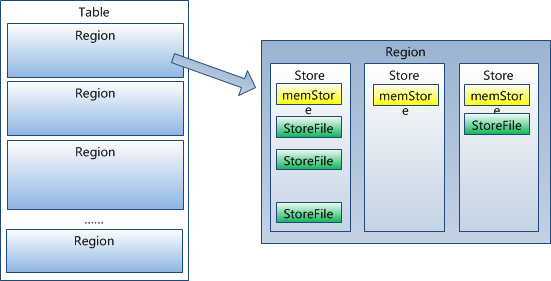

5 HRegion 虽然是分布式存储的最小单元,但并不是存储的最小单元。

事实上,HRegion 由一个或者多个 Store 组成,每个 store 保存一个 columns family。

每个 Strore 又由一个 memStore 和 0 至多个 StoreFile 组成。如图:

StoreFile 以 HFile 格式保存在 HDFS 上。

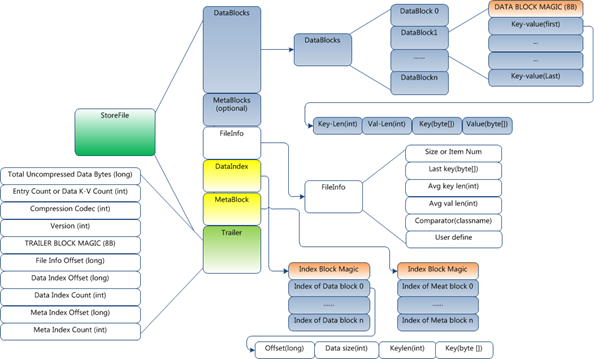

HFile 的格式为:

HFile 分为六个部分:

Data Block 段–保存表中的数据,这部分可以被压缩

Meta Block 段 (可选的)–保存用户自定义的 kv 对,可以被压缩。

File Info 段–Hfile 的元信息,不被压缩,用户也可以在这一部分添加自己的元信息。

Data Block Index 段–Data Block 的索引。每条索引的 key 是被索引的 block 的第一条记录的 key。

Meta Block Index 段 (可选的)–Meta Block 的索引。

Trailer– 这一段是定长的。保存了每一段的偏移量,读取一个 HFile 时,会首先读取 Trailer,Trailer 保存了每个段的起始位置(段的 Magic Number 用来做安全 check),然后,DataBlock Index 会被读取到内存中,这样,当检索某个 key 时,不需要扫描整个 HFile,而只需从内存中找到 key 所在的 block,通过一次磁盘 io 将整个 block 读取到内存中,再找到需要的 key。DataBlock Index 采用 LRU 机制淘汰。

HFile 的 Data Block,Meta Block 通常采用压缩方式存储,压缩之后可以大大减少网络 IO 和磁盘 IO,随之而来的开销当然是需要花费 cpu 进行压缩和解压缩。

目标 Hfile 的压缩支持两种方式:Gzip,Lzo。

shell

进入 hbase shell console

$HBASE_HOME/bin/hbase shell

如果有 kerberos 认证,需要事先使用相应的 keytab 进行一下认证(使用 kinit 命令),认证成功之后再使用 hbase shell 进入可以使用 whoami 命令可查看当前用户

hbase(main)> whoami

表的管理

1)查看有哪些表

hbase(main)> list

使用 exists 命令验证表是否被删除。

hbase(main)> exists ‘test’

Table test does not exist

2)创建表

# 语法:create <table>, {NAME => <family>, VERSIONS => <VERSIONS>}

# 例如:创建表 t1,有两个 column family:f1,f2,且版本数均为 2

hbase(main)> create ‘t1’,{NAME => ‘f1’, VERSIONS => 2},{NAME => ‘f2’, VERSIONS => 2}

3)删除表

分两步:首先 disable,然后 drop

例如:删除表 t1

hbase(main)> disable ‘t1’

hbase(main)> drop ‘t1’

4)查看表的结构

# 语法:describe <table>

# 例如:查看表 t1 的结构

hbase(main)> describe ‘t1’

5)修改表结构

修改表结构必须先 disable

添加列族

# 语法:alter ‘t1’, {NAME => ‘f1’}, {NAME => ‘f2’, METHOD => ‘delete’}

# 例如:修改表 t1 的 cf 的 TTL 为 180 天

hbase(main)> disable ‘t1’

hbase(main)> alter ‘t1′,{NAME=>’body’,TTL=>’15552000′},{NAME=>’meta’, TTL=>’15552000′}

hbase(main)> alter ‘t1′,’body1′,’meta1’

hbase(main)> enable ‘t1’

删除列族

hbase> alter ‘table name’, ‘delete’ => ‘column family’

权限管理

1)分配权限

# 语法 : grant <user> <permissions> <table> <column family> <column qualifier> 参数后面用逗号分隔

# 权限用五个字母表示:“RWXCA”.

# READ(‘R’), WRITE(‘W’), EXEC(‘X’), CREATE(‘C’), ADMIN(‘A’)

# 例如,给用户 ’luanpeng’ 分配对表 t1 有读写的权限,

hbase(main)> grant ‘luanpeng’,’RW’,’t1′

2)查看权限

# 语法:user_permission <table>

# 例如,查看表 t1 的权限列表

hbase(main)> user_permission ‘t1’

3)收回权限

# 与分配权限类似,语法:revoke <user> <table> <column family> <column qualifier>

# 例如,收回 luanpeng 用户在表 t1 上的权限

hbase(main)> revoke ‘luanpeng’,’t1′

表数据的增删改查

1)添加数据

# 语法:put <table>,<rowkey>,<family:column>,<value>,<timestamp>

# 例如:给表 t1 的添加一行记录:rowkey 是 rowkey001,family name 是 f1,column name 是 col1,value 是 value01,timestamp:系统默认

hbase(main)> put ‘t1′,’rowkey001′,’f1:col1′,’value01’

用法比较单一。

2)查询数据

a)查询某行记录

# 语法:get <table>,<rowkey>,[<family:column>,….]

# 例如:查询表 t1,rowkey001 中的 f1 下的 col1 的值

hbase(main)> get ‘t1′,’rowkey001’, ‘f1:col1’

# 或者:

hbase(main)> get ‘t1′,’rowkey001′, {COLUMN=>’f1:col1’}

# 查询表 t1,rowke002 中的 f1 下的所有列值

hbase(main)> get ‘t1′,’rowkey001’

b)扫描表

# 语法:scan <table>, {COLUMNS => [ <family:column>,….], LIMIT => num}

# 另外,还可以添加 STARTROW、TIMERANGE 和 FITLER 等高级功能

# 例如:扫描表 t1 的前 5 条数据

hbase(main)> scan ‘t1’,{LIMIT=>5}

c)查询表中的数据行数

# 语法:count <table>, {INTERVAL => intervalNum, CACHE => cacheNum}

# INTERVAL 设置多少行显示一次及对应的 rowkey,默认 1000;CACHE 每次去取的缓存区大小,默认是 10,调整该参数可提高查询速度

# 例如,查询表 t1 中的行数,每 100 条显示一次,缓存区为 500

hbase(main)> count ‘t1’, {INTERVAL => 100, CACHE => 500}

3)删除数据

a ) 删除行中的某个列值

# 语法:delete <table>, <rowkey>, <family:column> , <timestamp>, 必须指定列名

# 例如:删除表 t1,rowkey001 中的 f1:col1 的数据

hbase(main)> delete ‘t1′,’rowkey001′,’f1:col1’

注:将删除改行 f1:col1 列所有版本的数据

b )删除行

# 语法:deleteall <table>, <rowkey>, <family:column> , <timestamp>,可以不指定列名,删除整行数据

# 例如:删除表 t1,rowk001 的数据

hbase(main)> deleteall ‘t1′,’rowkey001’

c)删除表中的所有数据

# 语法:truncate <table>

# 其具体过程是:disable table -> drop table -> create table

# 例如:删除表 t1 的所有数据

hbase(main)> truncate ‘t1’

Region 管理

1)移动 region

# 语法:move ‘encodeRegionName’, ‘ServerName’

# encodeRegionName 指的 regioName 后面的编码,ServerName 指的是 master-status 的 Region Servers 列表

# 示例

hbase(main)>move ‘4343995a58be8e5bbc739af1e91cd72d’, ‘db-41.xxx.xxx.org,60020,1390274516739’

2)开启 / 关闭 region

# 语法:balance_switch true|false

hbase(main)> balance_switch

3)手动 split

# 语法:split ‘regionName’, ‘splitKey’

4)手动触发 major compaction

# 语法:

#Compact all regions in a table:

#hbase> major_compact ‘t1’

#Compact an entire region:

#hbase> major_compact ‘r1’

#Compact a single column family within a region:

#hbase> major_compact ‘r1’, ‘c1’

#Compact a single column family within a table:

#hbase> major_compact ‘t1’, ‘c1’

配置管理及节点重启

1)修改 hdfs 配置

hdfs 配置位置:/etc/hadoop/conf

# 同步 hdfs 配置

cat /home/hadoop/slaves|xargs -i -t scp /etc/hadoop/conf/hdfs-site.xml hadoop@{}:/etc/hadoop/conf/hdfs-site.xml

# 关闭:

cat /home/hadoop/slaves|xargs -i -t ssh hadoop@{} “sudo /home/hadoop/cdh4/hadoop-2.0.0-cdh4.2.1/sbin/hadoop-daemon.sh –config /etc/hadoop/conf stop datanode”

# 启动:

cat /home/hadoop/slaves|xargs -i -t ssh hadoop@{} “sudo /home/hadoop/cdh4/hadoop-2.0.0-cdh4.2.1/sbin/hadoop-daemon.sh –config /etc/hadoop/conf start datanode”

2)修改 hbase 配置

hbase 配置位置:/home/hadoop/hbase

# 同步 hbase 配置

cat /home/hadoop/hbase/conf/regionservers|xargs -i -t scp /home/hadoop/hbase/conf/hbase-site.xml hadoop@{}:/home/hadoop/hbase/conf/hbase-site.xml

# graceful 重启

cd ~/hbase

bin/graceful_stop.sh –restart –reload –debug inspurXXX.xxx.xxx.org

hbase shell 脚本

编写一个文本文件 hbasedemo.txt:

disable ‘table1’

drop ‘table1’

create ‘table1’, ‘column_family1′,’column_family2’

list ‘table1’

put ‘table1’, ‘row_key1’, ‘column_family1:col1’, ‘value1’

put ‘table1’, ‘row_key2’, ‘column_family1:col2’, ‘value2’

put ‘table1’, ‘row_key3’, ‘column_family2:col3’, ‘value3’

put ‘table1’, ‘row_key4’, ‘column_family2:col4’, ‘value4’

scan ‘table1’

scan ‘table1’,{LIMIT=>5}

get ‘table1’, ‘row_key1’

get ‘table1′,’row_key1’, ‘column_family1:col1’

count ‘table1’

disable ‘table1’

alter ‘table1′,NAME=>’column_family3’

alter ‘table1′,’delete’=>’column_family3’

enable ‘table1’

describe ‘table1’

grant ‘root’,’RW’,’table1′

user_permission ‘table1’

delete ‘table1′,’row_key1′,’column_family1:col1’

deleteall ‘table1′,’row_key1’

truncate ‘table1’

在 HBase shell 中运行这个脚本

hbase shell hbasedemo.txt

需要注意的是,如果编写的 txt 文件中没有 exit 这条命令的话,当脚本执行完成后,会停留在 hbase shell 的界面中,如果有 exit 命令的话,就会退出到系统 shell 中。

: