共计 2641 个字符,预计需要花费 7 分钟才能阅读完成。

Sqoop 安装及验证环境:

系统 | Red Hat linux 6.4 |

Hadoop 版本 | 1.2.1 |

Sqoop 版本 | 1.4.4 |

Mysql 数据库版本 | 5.6.15 |

通过 Sqoop 实现 Mysql / Oracle 与 HDFS / Hbase 互导数据 http://www.linuxidc.com/Linux/2013-06/85817.htm

[Hadoop] Sqoop 安装过程详解 http://www.linuxidc.com/Linux/2013-05/84082.htm

用 Sqoop 进行 MySQL 和 HDFS 系统间的数据互导 http://www.linuxidc.com/Linux/2013-04/83447.htm

Hadoop Oozie 学习笔记 Oozie 不支持 Sqoop 问题解决 http://www.linuxidc.com/Linux/2012-08/67027.htm

Hadoop 生态系统搭建(hadoop hive hbase zookeeper oozie Sqoop)http://www.linuxidc.com/Linux/2012-03/55721.htm

Hadoop 学习全程记录——使用 Sqoop 将 MySQL 中数据导入到 Hive 中 http://www.linuxidc.com/Linux/2012-01/51993.htm

获取 sqoop:http://sqoop.apache.org/

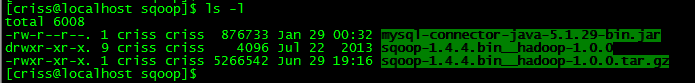

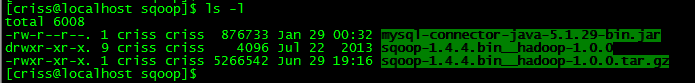

Step1. 下载 sqoop 及 mysqlconnector 并解压

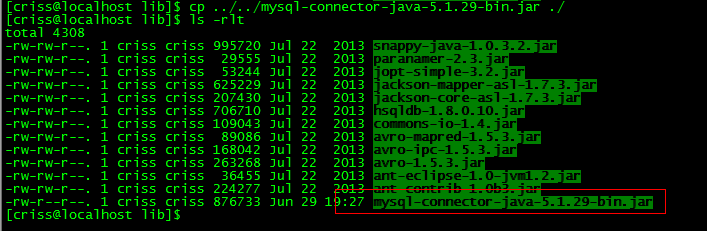

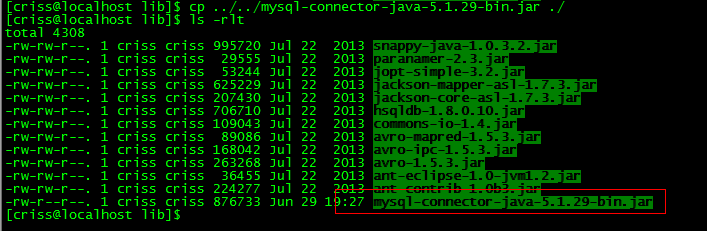

Step2. 将解压后的 connector 中的 jar 包拷贝到 sqoop 的 lib 目录下

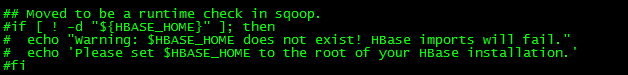

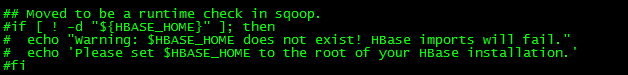

修改 bin 目录下 configure-sqoop 文件:

注释掉 hbase 和 zookeeper 检查,因为目前还没有启用 hbase/zookeeper 等 hadoop 上的组件

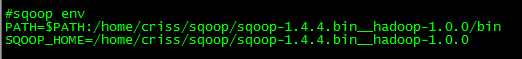

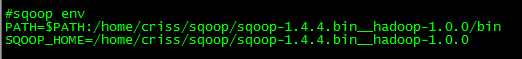

Step3. 设置环境变量

注意重新连接使环境变量生效!

Sqoop:

Hadoop_home:

![]()

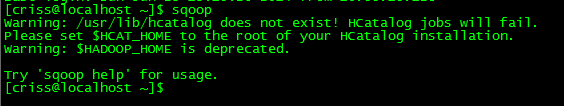

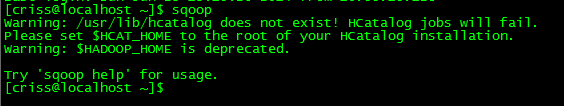

测试运行下 sqoop:

可以使用 help 命令查看帮助:

Step4. 测试 mysql 导入 HDFS:

创建一张测试表并插入数据:

利用 sqoop 将测试表导入到 hdfs:

注意:可以用 sqoop help import 查看帮助信息

登陆 mysql 创建用户,授予从任何 ip 登陆 mysql 权限

这里创建用户 sqoopuser

GRANT ALL PRIVILEGES ON *.* TO ‘sqoopuser’@’%’ IDENTIFIED BY ‘sqoopuser’ WITH GRANT OPTION;

![]()

查看数据库列表:

sqoop list-databases –connect jdbc:mysql://10.55.15.89:3306/ –username sqoopuser –P

执行导入命令将 sqoop_test 表导入到 hdfs:

sqoop import –connect jdbc:mysql://10.55.15.89:3306/sqoop_db –username sqoopuser –P –table sqoop_test -m 1

语法备注:

sqoop import –connect jdbc:mysql://mysqlserver_IP/database_name –username 数据库用户名 –P –table 表名 -m 1

最后一个 - m 表示并发数

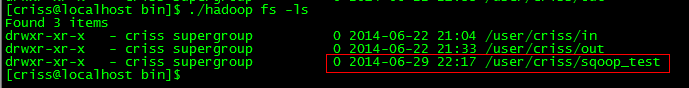

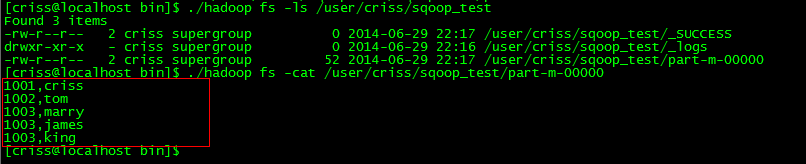

结果查询:

可以看到 hdfs 里面多出了一个文件

查看里面具体的内容:

可以看到 sqoop_test 表内的数据已经导入 HDFS

Sqoop 的详细介绍 :请点这里

Sqoop 的下载地址 :请点这里

Sqoop 安装及验证环境:

系统 | Red Hat linux 6.4 |

Hadoop 版本 | 1.2.1 |

Sqoop 版本 | 1.4.4 |

Mysql 数据库版本 | 5.6.15 |

通过 Sqoop 实现 Mysql / Oracle 与 HDFS / Hbase 互导数据 http://www.linuxidc.com/Linux/2013-06/85817.htm

[Hadoop] Sqoop 安装过程详解 http://www.linuxidc.com/Linux/2013-05/84082.htm

用 Sqoop 进行 MySQL 和 HDFS 系统间的数据互导 http://www.linuxidc.com/Linux/2013-04/83447.htm

Hadoop Oozie 学习笔记 Oozie 不支持 Sqoop 问题解决 http://www.linuxidc.com/Linux/2012-08/67027.htm

Hadoop 生态系统搭建(hadoop hive hbase zookeeper oozie Sqoop)http://www.linuxidc.com/Linux/2012-03/55721.htm

Hadoop 学习全程记录——使用 Sqoop 将 MySQL 中数据导入到 Hive 中 http://www.linuxidc.com/Linux/2012-01/51993.htm

获取 sqoop:http://sqoop.apache.org/

Step1. 下载 sqoop 及 mysqlconnector 并解压

Step2. 将解压后的 connector 中的 jar 包拷贝到 sqoop 的 lib 目录下

修改 bin 目录下 configure-sqoop 文件:

注释掉 hbase 和 zookeeper 检查,因为目前还没有启用 hbase/zookeeper 等 hadoop 上的组件

Step3. 设置环境变量

注意重新连接使环境变量生效!

Sqoop:

Hadoop_home:

![]()

测试运行下 sqoop:

可以使用 help 命令查看帮助:

Step4. 测试 mysql 导入 HDFS:

创建一张测试表并插入数据:

利用 sqoop 将测试表导入到 hdfs:

注意:可以用 sqoop help import 查看帮助信息

登陆 mysql 创建用户,授予从任何 ip 登陆 mysql 权限

这里创建用户 sqoopuser

GRANT ALL PRIVILEGES ON *.* TO ‘sqoopuser’@’%’ IDENTIFIED BY ‘sqoopuser’ WITH GRANT OPTION;

![]()

查看数据库列表:

sqoop list-databases –connect jdbc:mysql://10.55.15.89:3306/ –username sqoopuser –P

执行导入命令将 sqoop_test 表导入到 hdfs:

sqoop import –connect jdbc:mysql://10.55.15.89:3306/sqoop_db –username sqoopuser –P –table sqoop_test -m 1