共计 8594 个字符,预计需要花费 22 分钟才能阅读完成。

Varnish 与 Squid 的对比

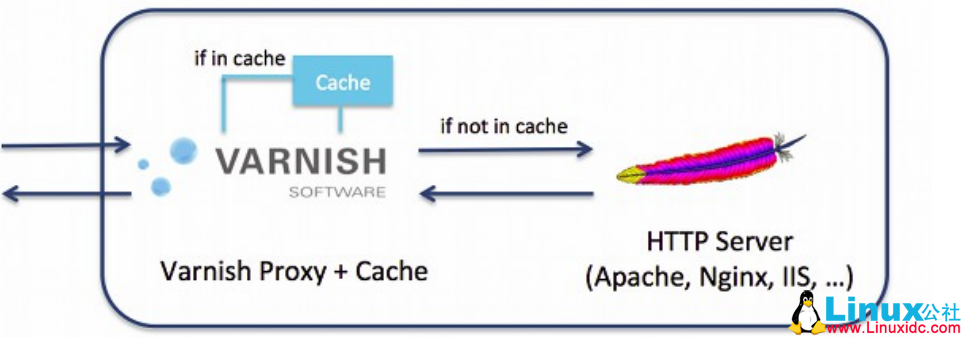

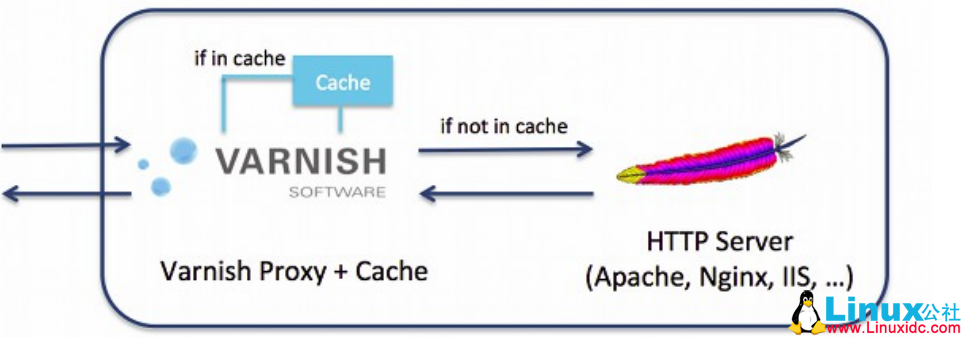

说到 Varnish,不能不提 Squid,Squid 是一个高性能的代理缓存服务器,它和 varnish 之间有诸多的异同点,这里分析如下:

下面是他们之间的相同点:

(1)都是一个反向代理服务器。

(2)都是开源软件。

下面是它们的不同点,也是 Varnish 的优点:

(1)Varnish 的稳定性很高,两者在完成相同负荷的工作时,Squid 服务器发生故障的几率要高于 Varnish,因为使用 Squid 要经常重启。

(2)Varnish 访问速度更快,Varnish 采用了“Visual Page Cache”技术,所有缓存数据都直接从内存读取,而 squid 是从硬盘读取,因而 Varnish 在访问速度方面会更快。

(3)Varnish 可以支持更多的并发连接,因为 Varnish 的 TCP 连接释放要比 Squid 快。因而在高并发连接情况下可以支持更多 TCP 连接。

(4)Varnish 可以通过管理端口,使用正则表达式批量的清除部分缓存,而 Squid 是做不到的。

(5)squid 属于是单进程使用单核 CPU,但 Varnish 是通过 fork 形式打开多进程来做处理,所以是合理的使用所有核来处理相应的请求。

(6)Varnish 的性能更高,挪威最大的在线报纸 Verdens Gang 使用 3 台 Varnish 代替了原来的 12 台 Squid,可见性能比以前更好。

当然,与传统的 Squid 相比,Varnish 也是有缺点的,列举如下:

1)varnish 进程一旦 Hang、Crash 或者重启,缓存数据都会从内存中完全释放,此时所有请求都会发送到后端服务器,在高并发情况下,会给后端服务器造成很大压力。

2)在 varnish 使用中如果单个 url 的请求通过 HA/F5(负载均衡)每次请求不同的 varnish 服务器中,被请求 varnish 服务器都会被穿透到后端,而且同样的请求会在多台服务器上缓存,也会造成 varnish 的缓存的资源浪费,也会造成性能下降。

————————————————————

Varnish Cache 的架构笔记 http://www.linuxidc.com/Linux/2013-10/91016.htm

CentOS 5.8 下 Varnish-2.1.5 的安装配置 http://www.linuxidc.com/Linux/2013-09/89916.htm

RedHat 脚本改用 CentOS 源更新安装 Nginx、PHP 5.3、Varnish http://www.linuxidc.com/Linux/2012-07/65801.htm

利用 Varnish 构建 Cache 服务器笔记 http://www.linuxidc.com/Linux/2012-07/65234.htm

缓存服务 Varnish 安装配置 http://www.linuxidc.com/Linux/2012-07/65228.htm

Varnish 编译安装所需准备 http://www.linuxidc.com/Linux/2012-07/65230.htm

Linux 下 Varnish 缓存的配置优化 http://www.linuxidc.com/Linux/2012-03/56435.htm

Varnish 基础概念详解 http://www.linuxidc.com/Linux/2014-07/104535.htm

———————————————————————————–

解决方案 :

1)综上所述在访问量很大的情况下推荐使用 varnish 的内存缓存方式启动,而且后面需要跟多台 squid 服务器。主要为了防止前面的 varnish 服务、服务器被重启的情况下,前期肯定会有很多的穿透这样 squid 可以担当第二层 CACHE,而且也弥补了 varnish 缓存在内存中重启都会释放的问题。

2)这样的问题可以在负载均衡上做 url 哈希,让单个 url 请求固定请求到一台 varnish 服务器上,可以解决该问题。

注:上面的解决方法还需要全面的测试,没有经过证实。

下面我们就来部署 varnish:

主机环境:rhel6 selinux and iptables disabled

实验主机:www.linuxidc.com bbs.linuxidc.com 192.168.0.50 varnish

server1.example.com 192.168.0.1 apache

server2.example.com 192.168.0.2 apache (各主机做以上解析)

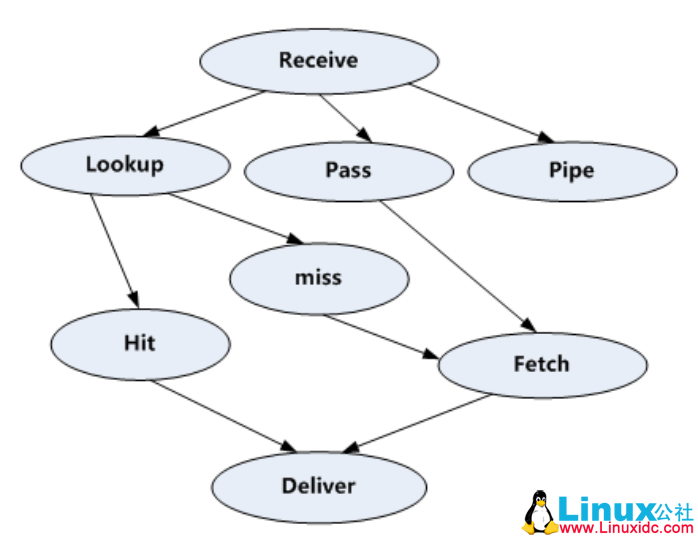

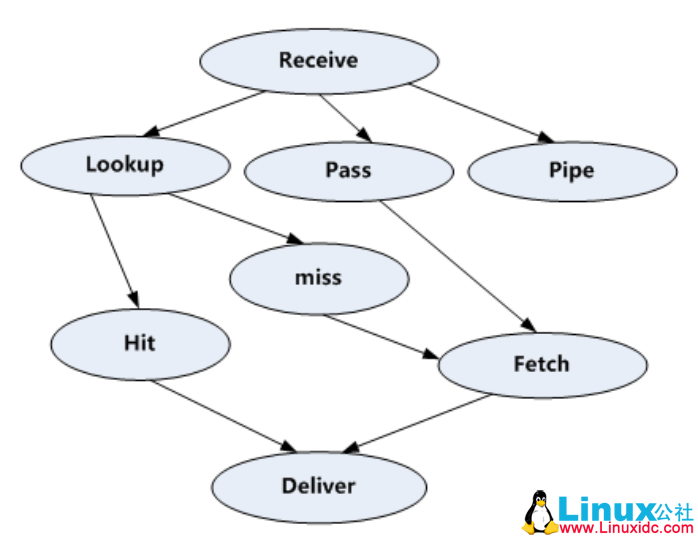

VCL 处理流程图

处理过程大致分为如下几个步骤:

(1)Receive 状态,也就是请求处理的入口状态,根据 VCL 规则判断该请求应该是 Pass 或 Pipe,或者进入 Lookup(本地查询)。

(2)Lookup 状态,进入此状态后,会在 hash 表中查找数据,若找到,则进入 Hit 状态,否则进入 miss 状态。

(3)Pass 状态,在此状态下,会进入后端请求,即进入 fetch 状态。

(4)Fetch 状态,在 Fetch 状态下,对请求进行后端的获取,发送请求,获得数据,并进行本地的存储。

(5)Deliver 状态,将获取到的数据发送给客户端,然后完成本次请求。

更多详情见请继续阅读下一页的精彩内容 :http://www.linuxidc.com/Linux/2014-08/105124p2.htm

1. 安装 (192.168.0.50)

http://repo.varnish-cache.com/RedHat/varnish-3.0/el6/x86_64/

yum localinstall -y varnish-3.0.5-1.el6.x86_64.rpm varnish-libs-3.0.5-1.el6.x86_64.rpm

2. 配置

# vi /etc/varnish/default.vcl

### 配置一个后端服务器

backend web1 {

.host = “192.168.0.1”;

.port = “80”;

}

### 查看缓存命中情况

sub vcl_deliver {

if (obj.hits > 0) {

set resp.http.X-Cache = “HIT from linuxidc cache”;

}

else {

set resp.http.X-Cache = “MISS from linuxidc cache”;

}

return (deliver);

}

### 配置 varnish 服务端口

# vi /etc/sysconfig/varnish

VARNISH_LISTEN_PORT=80

# service varnish start

3. 测试缓存命中

# curl -I 192.168.0.50

HTTP/1.1 200 OK

Server: Apache/2.2.15 (Red Hat)

Last-Modified: Mon, 20 Aug 2012 15:22:19 GMT

ETag: “1c13aa-16-4c7b4135e08a6″Content-Type: text/html; charset=UTF-8

Content-Length: 22

Accept-Ranges: bytes

Date: Fri, 24 Aug 2012 14:30:40 GMT

X-Varnish: 766467032

Age: 0

Via: 1.1 varnish

Connection: keep-alive

X-Cache: MISS from linuxidc cache #未命中

# curl -I 192.168.0.50

HTTP/1.1 200 OK

Server: Apache/2.2.15 (Red Hat)

Last-Modified: Mon, 20 Aug 2012 15:22:19 GMT

ETag: “1c13aa-16-4c7b4135e08a6”

Content-Type: text/html; charset=UTF-8

Content-Length: 22

Accept-Ranges: bytes

Date: Fri, 24 Aug 2012 14:30:54 GMT

X-Varnish: 766467033 766467032

Age: 14

Via: 1.1 varnish

Connection: keep-alive

X-Cache:HIT from linuxidc cache #命中

### 通过 varnishadm 手动清除缓存

# varnishadm ban.url .*$ #清除所有

# varnishadm ban.url /index.html #清除 index.html 页面缓存

# varnishadm ban.url /admin/$ #清除 admin 目录缓存

4. 定义多个不同域名站点的后端服务器

#vim /etc/varnish/default.vcl

backend web1 {

.host = “192.168.0.1”;

.port = “80”;

}

backend web2 {

.host = “192.168.0.2”;

.port = “80”;

}

# 当访问 www.linuxidc.com 域名时从 web1 上取数据,访问 bbs.linuxidc.com 域名时到 web2 取数据,访问其他页面报错。

sub vcl_recv {

if (req.http.host ~ “^(www.)?linuxidc.com”) {

set req.http.host = “www.linuxidc.com”;

set req.backend = web1;

} elsif (req.http.host ~ “^bbs.linuxidc.com”) {

set req.backend = web2;

} else {error 404 “linuxidc cache”;

}

}

sub vcl_deliver {

if (obj.hits > 0){

set resp.http.X-Cache = “HIT from linuxidc cache”;

}

else {

set resp.http.X-Cache = “MISS from linuxidc cache”;

}

return (deliver);

}

# service varnish reload

网页访问 web:www.linuxidc.com web:bbs.linuxidc.com 则会显示不同的内容。

5. 定义负载均衡

## 添加虚拟主机

vim /etc/httpd/conf/httpd.conf(192.168.0.2 上的操作)

NameVirtualHost *:80

<VirtualHost *:80>

DocumentRoot /var/www/html

ServerName www.linuxidc.com

</VirtualHost>

<VirtualHost *:80>

DocumentRoot /var/www/web2(你要自己创建这么目录哦!)

ServerName bbs.linuxidc.com

</VirtualHost>

#echo bbs.linuxidc.com > /var/www/web2/index.html

#service httpd restart

## 定义健康检查

probe healthcheck {

.url = “/index.html”; # 哪个 url 需要 varnish 请求

.interval = 5s; #检查的间隔时间

.timeout = 1s; #等待多长时间探针超时

.window = 5; #维持 5 个 sliding window 的结果

.threshold = 3; #至少有三次 window 是成功的,就宣告 bachend 健康

}

backend web1 {

.host = “192.168.0.1”;

.port = “80”;

.probe = healthcheck;

}

backend web2 {

.host = “192.168.0.2”;

.port = “80”;

.probe = healthcheck;

}

director lb round-robin {#把多个后端聚合为一个组,并检测后端健康状况

{.backend = web1;}

{.backend = web2;}

}sub vcl_recv {

if (req.http.host ~ “^(www.)?linuxidc.com”) {

set req.http.host = “www.linuxidc.com”;

set req.backend = lb;

return (pass); #为了测试方便,不进行缓存。

} elsif (req.http.host ~ “^bbs.linuxidc.com”) {

set req.backend = web2;

} else {

error 404 “linuxidc cache”;

}

}

# service varnish reload

这时 web 访问 http://www.linuxidc.com/ 就会显示不同的内容,即实现了负载均衡。

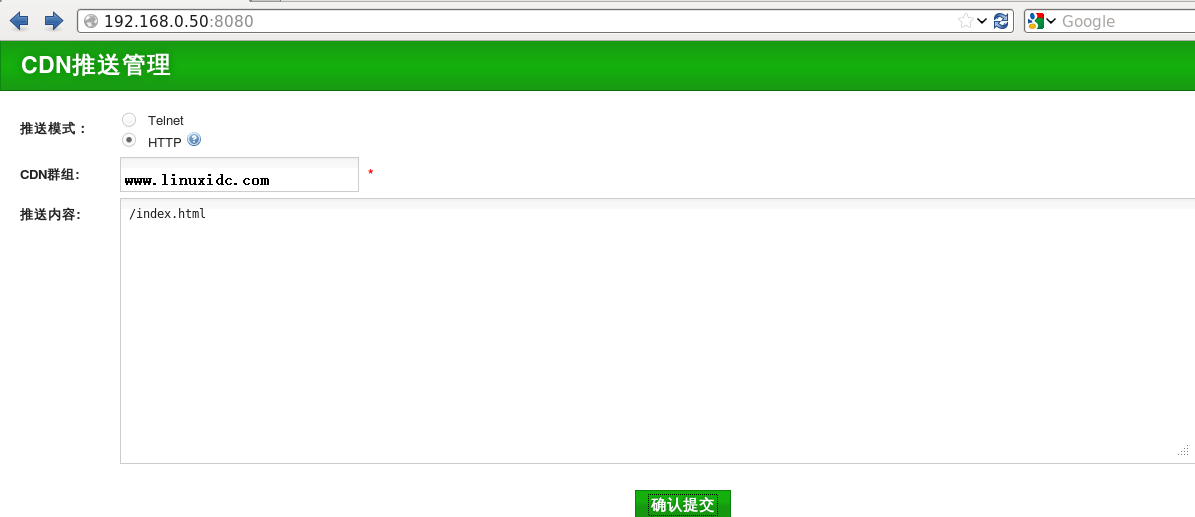

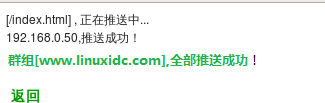

6.varnish cdn 推送平台

http://code.google.com/p/varnish-php-bansys/

# 需要安装 php 支持

# unzip bansys.zip -d /var/www/html

# vi /var/www/html/bansys/config.php #只保留如下设置,其余注释掉 (注意:注释掉并不是删除掉,删除会造成推送网页的乱码!)

<?php

$var_group1 = array(

‘host’ => array(‘192.168.0.50’),

‘port’ => ‘6082’,

);

//varnish 群组定义

// 对主机列表进行绑定

$VAR_CLUSTER = array(

‘www.linuxidc.com’ => $var_group1,

);

//varnish 版本 //2.x 和 3.x 推送命令不一样

$VAR_VERSION = “3”;

?>

#bansys 有两种工作模式,分别是:telnet 和 http 模式。

#telnet 模式需要关闭 varnish 服务管理端口的验证, 注释掉 /etc/sysconfig/varnish“文件中的 -S ${VARNISH_SECRET_FILE}”这行,重启 varnish 服务即可。

# 如果是 http 模式需要对 varnish 做以下设置:

# vi /etc/varnish/default.vcl

acl linuxidc {

# 设置访问控制

“127.0.0.1”;

“192.168.0.0”/24;

}

sub vcl_recv {

if (req.request == “BAN”) {

if (!client.ip ~ linuxidc) {

error 405 “Not allowed.”;

}

ban(“req.url ~ ” + req.url);

error 200 “ban added”;

}

}

修改 httpd 的端口号

#vim /etc/httpd/conf/httpd.conf Listen 8080(大概是 136 行)

# service varnish reload

## 推送是为了更新 cache,让原网页失效,这样从外网访问内网的时候就是最新的数据。

Varnish 的详细介绍 :请点这里

Varnish 的下载地址 :请点这里

Varnish 与 Squid 的对比

说到 Varnish,不能不提 Squid,Squid 是一个高性能的代理缓存服务器,它和 varnish 之间有诸多的异同点,这里分析如下:

下面是他们之间的相同点:

(1)都是一个反向代理服务器。

(2)都是开源软件。

下面是它们的不同点,也是 Varnish 的优点:

(1)Varnish 的稳定性很高,两者在完成相同负荷的工作时,Squid 服务器发生故障的几率要高于 Varnish,因为使用 Squid 要经常重启。

(2)Varnish 访问速度更快,Varnish 采用了“Visual Page Cache”技术,所有缓存数据都直接从内存读取,而 squid 是从硬盘读取,因而 Varnish 在访问速度方面会更快。

(3)Varnish 可以支持更多的并发连接,因为 Varnish 的 TCP 连接释放要比 Squid 快。因而在高并发连接情况下可以支持更多 TCP 连接。

(4)Varnish 可以通过管理端口,使用正则表达式批量的清除部分缓存,而 Squid 是做不到的。

(5)squid 属于是单进程使用单核 CPU,但 Varnish 是通过 fork 形式打开多进程来做处理,所以是合理的使用所有核来处理相应的请求。

(6)Varnish 的性能更高,挪威最大的在线报纸 Verdens Gang 使用 3 台 Varnish 代替了原来的 12 台 Squid,可见性能比以前更好。

当然,与传统的 Squid 相比,Varnish 也是有缺点的,列举如下:

1)varnish 进程一旦 Hang、Crash 或者重启,缓存数据都会从内存中完全释放,此时所有请求都会发送到后端服务器,在高并发情况下,会给后端服务器造成很大压力。

2)在 varnish 使用中如果单个 url 的请求通过 HA/F5(负载均衡)每次请求不同的 varnish 服务器中,被请求 varnish 服务器都会被穿透到后端,而且同样的请求会在多台服务器上缓存,也会造成 varnish 的缓存的资源浪费,也会造成性能下降。

————————————————————

Varnish Cache 的架构笔记 http://www.linuxidc.com/Linux/2013-10/91016.htm

CentOS 5.8 下 Varnish-2.1.5 的安装配置 http://www.linuxidc.com/Linux/2013-09/89916.htm

RedHat 脚本改用 CentOS 源更新安装 Nginx、PHP 5.3、Varnish http://www.linuxidc.com/Linux/2012-07/65801.htm

利用 Varnish 构建 Cache 服务器笔记 http://www.linuxidc.com/Linux/2012-07/65234.htm

缓存服务 Varnish 安装配置 http://www.linuxidc.com/Linux/2012-07/65228.htm

Varnish 编译安装所需准备 http://www.linuxidc.com/Linux/2012-07/65230.htm

Linux 下 Varnish 缓存的配置优化 http://www.linuxidc.com/Linux/2012-03/56435.htm

Varnish 基础概念详解 http://www.linuxidc.com/Linux/2014-07/104535.htm

———————————————————————————–

解决方案 :

1)综上所述在访问量很大的情况下推荐使用 varnish 的内存缓存方式启动,而且后面需要跟多台 squid 服务器。主要为了防止前面的 varnish 服务、服务器被重启的情况下,前期肯定会有很多的穿透这样 squid 可以担当第二层 CACHE,而且也弥补了 varnish 缓存在内存中重启都会释放的问题。

2)这样的问题可以在负载均衡上做 url 哈希,让单个 url 请求固定请求到一台 varnish 服务器上,可以解决该问题。

注:上面的解决方法还需要全面的测试,没有经过证实。

下面我们就来部署 varnish:

主机环境:rhel6 selinux and iptables disabled

实验主机:www.linuxidc.com bbs.linuxidc.com 192.168.0.50 varnish

server1.example.com 192.168.0.1 apache

server2.example.com 192.168.0.2 apache (各主机做以上解析)

VCL 处理流程图

处理过程大致分为如下几个步骤:

(1)Receive 状态,也就是请求处理的入口状态,根据 VCL 规则判断该请求应该是 Pass 或 Pipe,或者进入 Lookup(本地查询)。

(2)Lookup 状态,进入此状态后,会在 hash 表中查找数据,若找到,则进入 Hit 状态,否则进入 miss 状态。

(3)Pass 状态,在此状态下,会进入后端请求,即进入 fetch 状态。

(4)Fetch 状态,在 Fetch 状态下,对请求进行后端的获取,发送请求,获得数据,并进行本地的存储。

(5)Deliver 状态,将获取到的数据发送给客户端,然后完成本次请求。

更多详情见请继续阅读下一页的精彩内容 :http://www.linuxidc.com/Linux/2014-08/105124p2.htm