共计 3020 个字符,预计需要花费 8 分钟才能阅读完成。

因为我原来对 maven 和 sbt 都不熟悉,因此使用两种方法都编译了一下。下面记录一下编译时候遇到的问题。然后介绍一下如果使用 IntelliJ IDEA 13.1 构建开发环境。

首先准备 Java 环境和 scala 环境:

1. jdk 1.7

2. scala 2.11.1

1. maven

首先安装 maven,我安装的是 3.2.3,可以直接下载 binary。解压即可用。需要设置一下环境变量:

export MAVEN_HOME=/project/spark_maven/spark/apache-maven-3.2.3

export MAVEN_OPTS="-Xmx4096m -XX:MaxPermSize=4096m"

export PATH=$PATH:$MAVEN_HOME/bin由于我的笔记本有 16G 内存,因此可以给 maven 比较大的内存。如果 MAVEN_OPTS 设置的不合理,那么会导致 OOM 的错误,具体信息可以看这里。

使用以下命令编译:

mvn -X -Pyarn -PHadoop-2.2 -Dhadoop.version=2.2.0 -DskipTests clean package这里使用的是 Apache Hadoop 2.2,如果使用比如其他的商业发行版,可以参照官网的信息去编译。

————————————– 分割线 ————————————–

Spark1.0.0 部署指南 http://www.linuxidc.com/Linux/2014-07/104304.htm

CentOS 6.2(64 位) 下安装 Spark0.8.0 详细记录 http://www.linuxidc.com/Linux/2014-06/102583.htm

Spark 简介及其在 Ubuntu 下的安装使用 http://www.linuxidc.com/Linux/2013-08/88606.htm

安装 Spark 集群 (在 CentOS 上) http://www.linuxidc.com/Linux/2013-08/88599.htm

Hadoop vs Spark 性能对比 http://www.linuxidc.com/Linux/2013-08/88597.htm

Spark 安装与学习 http://www.linuxidc.com/Linux/2013-08/88596.htm

Spark 并行计算模型 http://www.linuxidc.com/Linux/2012-12/76490.htm

————————————– 分割线 ————————————–

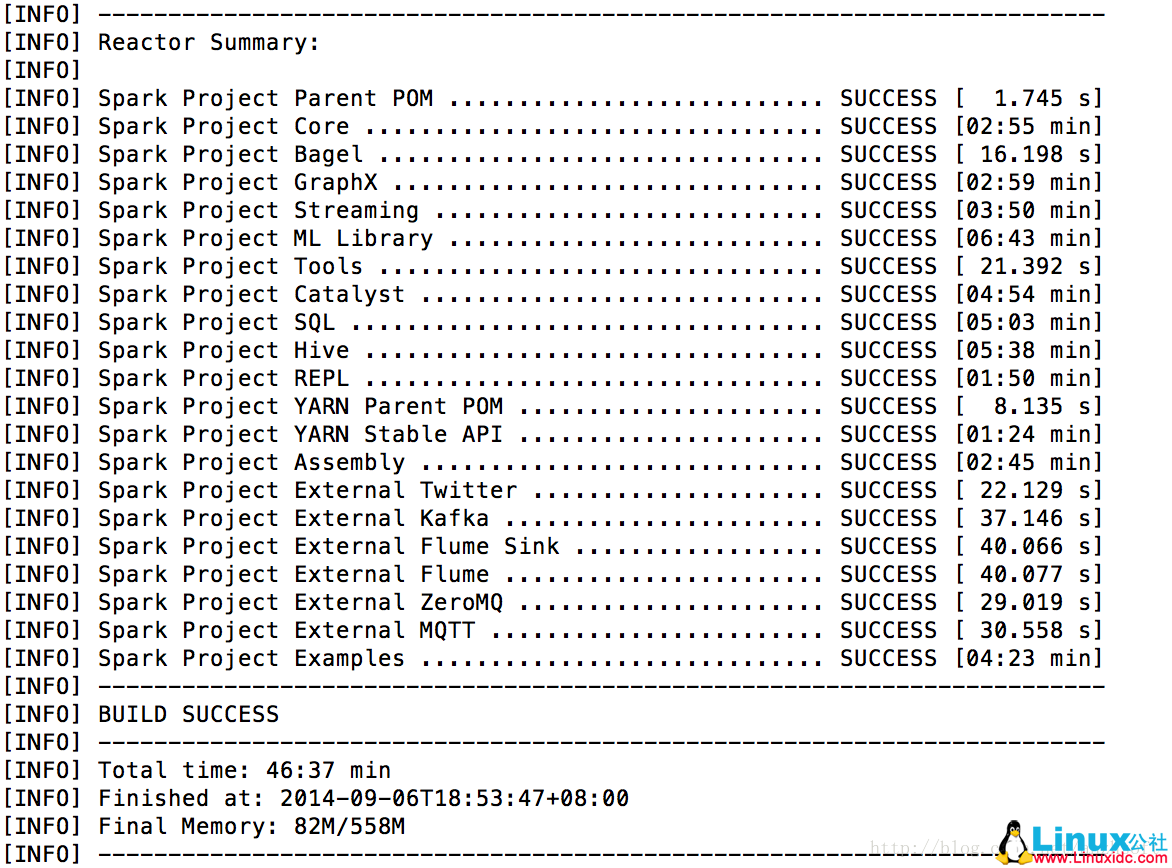

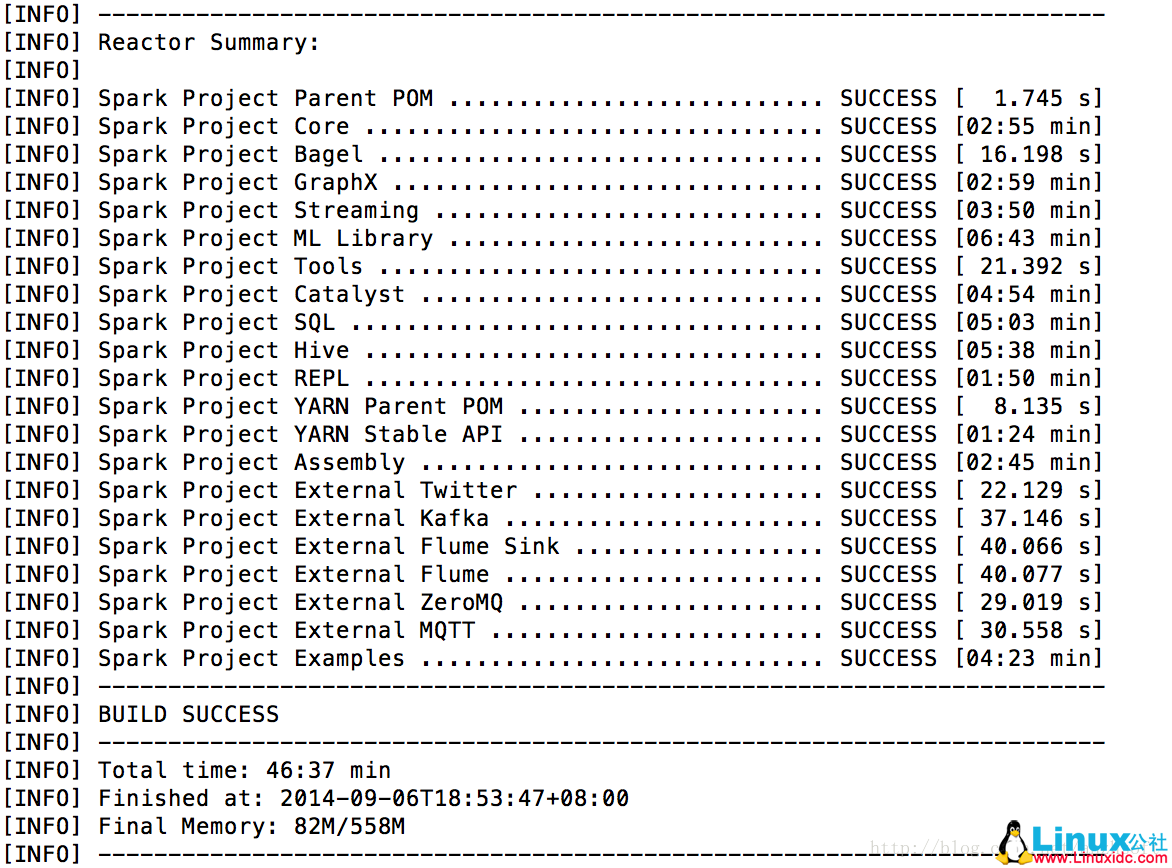

等待一段时间,如果没有 error 的话,恭喜你编译成功。下面是编译成功的结果:

2. sbt

sbt 编译过程比较慢。如果运行 sbt 说 sbt-launch.jar 的错误,那么需要手动的安装以下,可以看这里。

实际上使用以下命令既可以开始编译了:

./sbt/sbt assembly 有时候由于网络问题可能导致编译 hang 在某个地方,或者你重启了,那么下次开始变异前需要删除 $HOME/.ivy2/

.sbt.ivy.lock

。然后重启开始。sbt 会进行增量编译。

3. IDEA

将 sbt 导入 idea,先做以下准备工作:

./sbt/sbt gen-idea

如果发生了错误,再次进行。现在应该不需要设置代理即可完成了。如果要等待 lock,那么参照上述的方法删除 lock 即可。

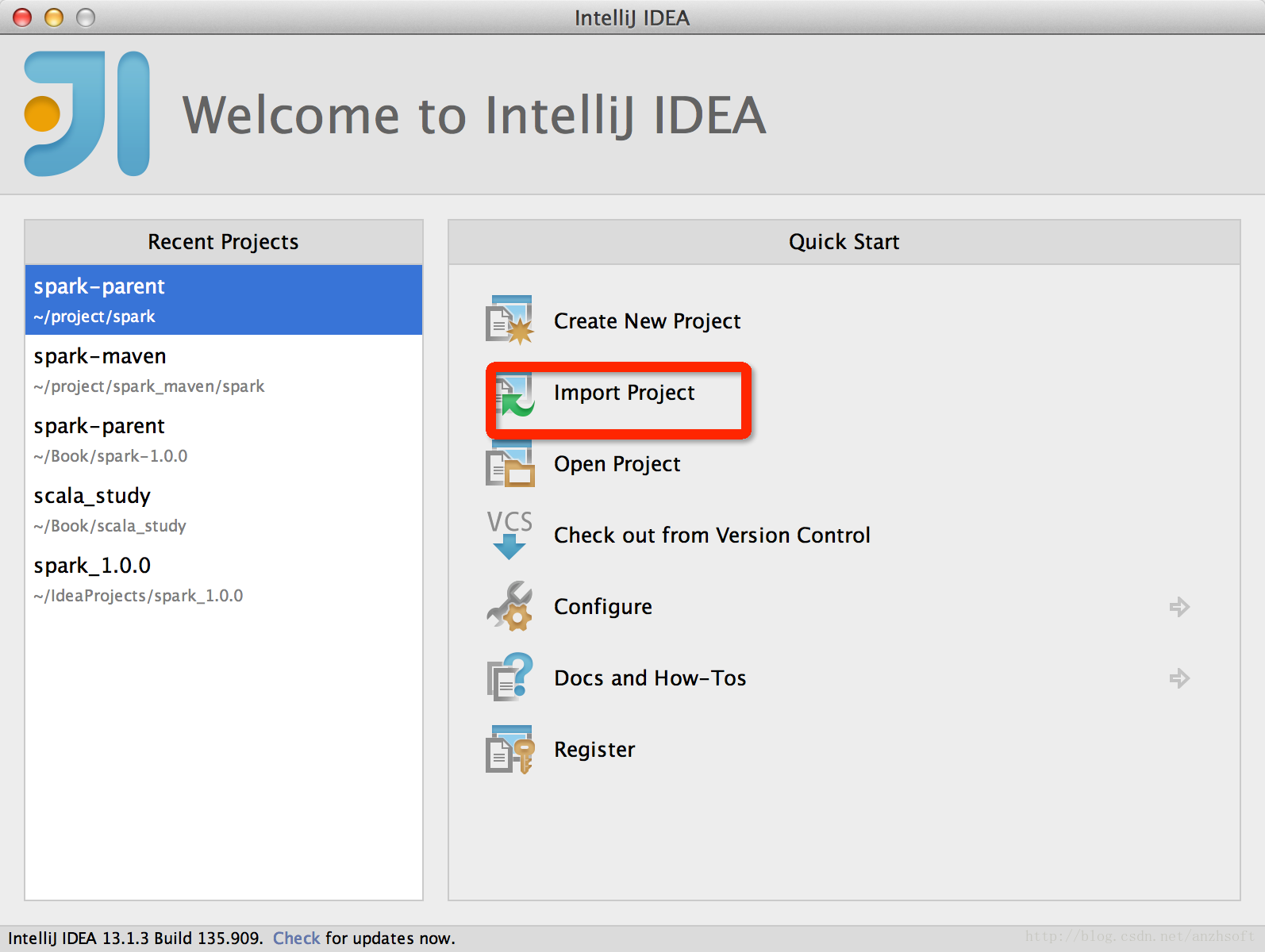

然后打开 IDEA,点击 Import Project:

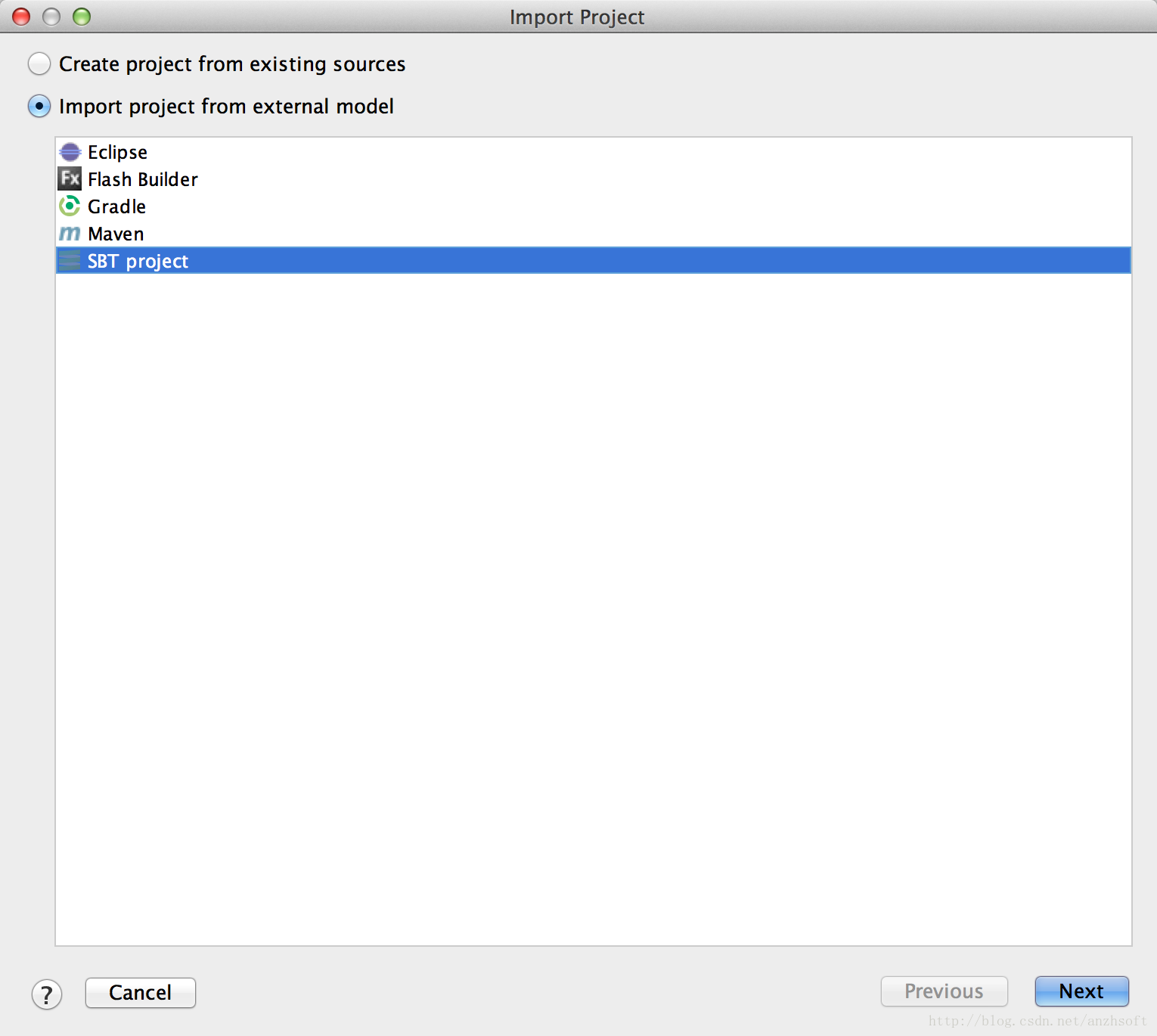

选择工程的默认路径后, 选择 SBT Project

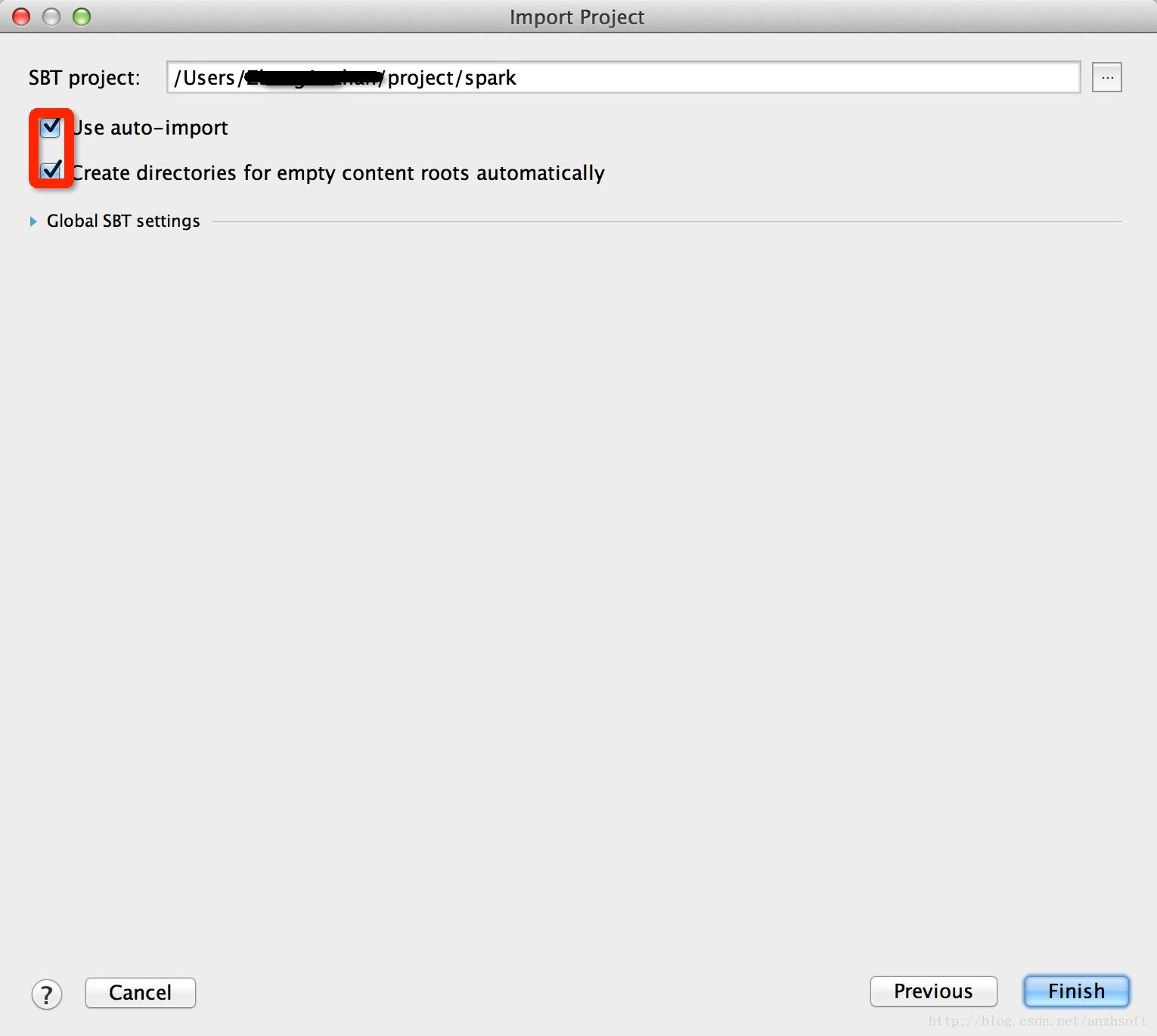

选择 auto 即可:

点击 Finish 即完成了工程的导入。

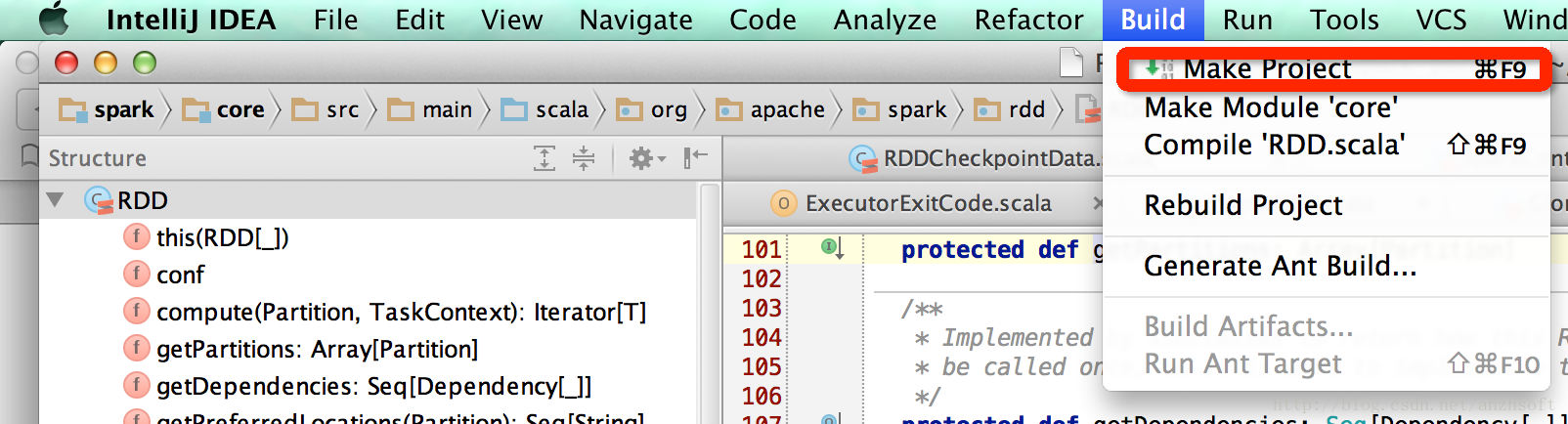

下面可以使用 IDEA 编译以下整个工程:

4. IDEA 的常用快捷键:

Spark 的详细介绍 :请点这里

Spark 的下载地址 :请点这里

因为我原来对 maven 和 sbt 都不熟悉,因此使用两种方法都编译了一下。下面记录一下编译时候遇到的问题。然后介绍一下如果使用 IntelliJ IDEA 13.1 构建开发环境。

首先准备 Java 环境和 scala 环境:

1. jdk 1.7

2. scala 2.11.1

1. maven

首先安装 maven,我安装的是 3.2.3,可以直接下载 binary。解压即可用。需要设置一下环境变量:

export MAVEN_HOME=/project/spark_maven/spark/apache-maven-3.2.3

export MAVEN_OPTS="-Xmx4096m -XX:MaxPermSize=4096m"

export PATH=$PATH:$MAVEN_HOME/bin由于我的笔记本有 16G 内存,因此可以给 maven 比较大的内存。如果 MAVEN_OPTS 设置的不合理,那么会导致 OOM 的错误,具体信息可以看这里。

使用以下命令编译:

mvn -X -Pyarn -PHadoop-2.2 -Dhadoop.version=2.2.0 -DskipTests clean package这里使用的是 Apache Hadoop 2.2,如果使用比如其他的商业发行版,可以参照官网的信息去编译。

————————————– 分割线 ————————————–

Spark1.0.0 部署指南 http://www.linuxidc.com/Linux/2014-07/104304.htm

CentOS 6.2(64 位) 下安装 Spark0.8.0 详细记录 http://www.linuxidc.com/Linux/2014-06/102583.htm

Spark 简介及其在 Ubuntu 下的安装使用 http://www.linuxidc.com/Linux/2013-08/88606.htm

安装 Spark 集群 (在 CentOS 上) http://www.linuxidc.com/Linux/2013-08/88599.htm

Hadoop vs Spark 性能对比 http://www.linuxidc.com/Linux/2013-08/88597.htm

Spark 安装与学习 http://www.linuxidc.com/Linux/2013-08/88596.htm

Spark 并行计算模型 http://www.linuxidc.com/Linux/2012-12/76490.htm

————————————– 分割线 ————————————–

等待一段时间,如果没有 error 的话,恭喜你编译成功。下面是编译成功的结果:

2. sbt

sbt 编译过程比较慢。如果运行 sbt 说 sbt-launch.jar 的错误,那么需要手动的安装以下,可以看这里。

实际上使用以下命令既可以开始编译了:

./sbt/sbt assembly 有时候由于网络问题可能导致编译 hang 在某个地方,或者你重启了,那么下次开始变异前需要删除 $HOME/.ivy2/

.sbt.ivy.lock

。然后重启开始。sbt 会进行增量编译。