共计 6363 个字符,预计需要花费 16 分钟才能阅读完成。

实现负载均衡有很多种方式, 土豪直接 F5, 性能最好, 价格最贵

没钱也可以使用 Apache,Nginx 工作在网络的第四层, 虽然性能一般, 但是很灵活, 比如可以将 80 端口映射到真实服务器的 8080 端口.

还有一种选择 LVS , 它工作在网络的第三层, 性能较好, 非常稳定. 但是它不能实现端口的重新映射. 因为在网络的第三层, 并不清楚端口的信息。

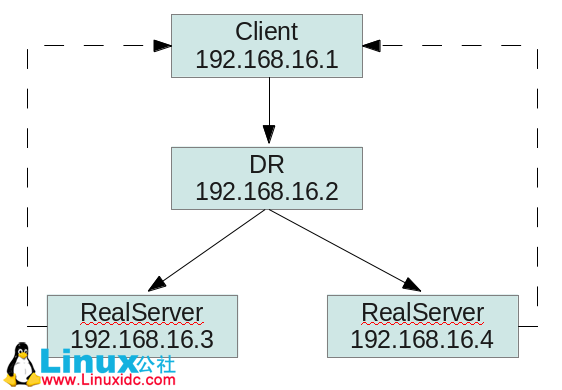

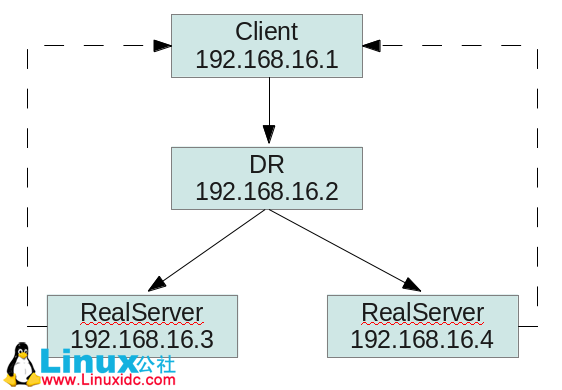

下面的实验搭建了一个 LVS 负载均衡测试环境, 采用 DR 的方式。

Linux 服务器 LB 群集之 LVS-NAT http://www.linuxidc.com/Linux/2013-05/84774.htm

Linux 下群集服务之 LB 集群 -LVS-NAT 模式 http://www.linuxidc.com/Linux/2012-05/59839.htm

LVS-NAT+ipvsadm 实现 RHEL 5.7 上的服务集群 http://www.linuxidc.com/Linux/2012-04/58936.htm

Linux 虚拟服务器 LVS-NAT 和 LVS-DR 模型的实现 http://www.linuxidc.com/Linux/2011-09/42934.htm

客户端访问 LVS 前置机

这个请求如下

源 MAC(client mac) 目标 MAC(DR mac) 源 IP(client IP) 目标 IP(DR IP,VIP)

LVS 前置机会将报文改写之后转发真实的服务器

改写如下

源 MAC(client mac) 目标 MAX(真实服务器 MAC) 源 IP(client IP) 目标 IP(DR IP,VIP)

因为真实的服务器将 VIP 绑定到了环回地址, 所以会处理这个请求, 并返回响应的报文.

网络层的源目对掉

源 MAC(真实服务器 MAC) 目标 MAC(client mac) 源 IP(DR IP,VIP) 目标 IP(client IP)

所以 LVS DR 的本质就是网络层的欺骗。

实验采用 VirtualBox 虚拟机, 并且配置内部网络, 关闭 SELinux 和防火墙

首先, 在 LVS DR 前置机上安装 ipvsadm 命令

yum install ipvsadm -y

然后配置两台真实服务器 (RealServer) 的 Http 服务

yum install httpd -y

service httpd start

chkconfig httpd on

并分别改写 /var/www/html/index.html 的内容为 ”real server 1″ 和 ”real server 2″

然后在两台真实服务器上执行如下的脚本

vim lvs_real.sh

#!/bin/bash

# description: Config realserver lo and apply noarp

SNS_VIP=192.168.16.199

source /etc/rc.d/init.d/functions

case “$1” in

start)

ifconfig lo:0 $SNS_VIP netmask 255.255.255.255 broadcast $SNS_VIP

/sbin/route add -host $SNS_VIP dev lo:0

echo “1” >/proc/sys/net/ipv4/conf/lo/arp_ignore

echo “2” >/proc/sys/net/ipv4/conf/lo/arp_announce

echo “1” >/proc/sys/net/ipv4/conf/all/arp_ignore

echo “2” >/proc/sys/net/ipv4/conf/all/arp_announce

sysctl -p >/dev/null 2>&1

echo “RealServer Start OK”

;;

stop)

ifconfig lo:0 down

route del $SNS_VIP >/dev/null 2>&1

echo “0” >/proc/sys/net/ipv4/conf/lo/arp_ignore

echo “0” >/proc/sys/net/ipv4/conf/lo/arp_announce

echo “0” >/proc/sys/net/ipv4/conf/all/arp_ignore

echo “0” >/proc/sys/net/ipv4/conf/all/arp_announce

echo “RealServer Stoped”

;;

*)

echo “Usage: $0 {start|stop}”

exit 1

esac

exit 0

最后, 在 DR 前置机上执行如下脚本

vim lvs_dr.sh

#!/bin/bash

VIP1=192.168.16.199

RIP1=192.168.16.3

RIP2=192.168.16.4

case “$1” in

start)

echo ” start LVS of DirectorServer”

/sbin/ifconfig eth1:0 $VIP1 broadcast $VIP1 netmask 255.255.255.255 broadcast $VIP1 up

/sbin/route add -host $VIP1 dev eth1:0

echo “1” >/proc/sys/net/ipv4/ip_forward

/sbin/ipvsadm -C

/sbin/ipvsadm -A -t $VIP1:80 -s rr

/sbin/ipvsadm -a -t $VIP1:80 -r $RIP1:80 -g -w 1

/sbin/ipvsadm -a -t $VIP1:80 -r $RIP2:80 -g -w 1

/sbin/ipvsadm

;;

stop)

echo “close LVS Directorserver”

echo “0” >/proc/sys/net/ipv4/ip_forward

/sbin/ipvsadm -C

/sbin/ifconfig eth1:0 down

;;

*)

echo “Usage: $0 {start|stop}”

exit 1

esac

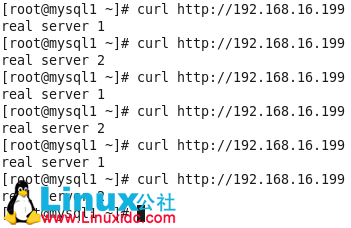

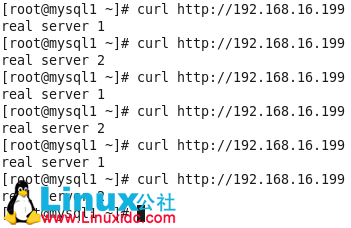

通过 client 访问 LVS 前置服务器, 可以看到已经实现了负载均衡的效果。

更多详情见请继续阅读下一页的精彩内容:http://www.linuxidc.com/Linux/2014-09/106636p2.htm

关于 LVS 的调度算法

1. 大锅饭调度(Round-Robin Scheduling RR)

rr – 纯轮询方式,比较垃圾。把每项请求按顺序在真正服务器中分派。

2. 带权重的大锅饭调度(Weighted Round-Robin Scheduling WRR)

wrr - 带权重轮询方式。把每项请求按顺序在真正服务器中循环分派,但是给能力较大的服务器分派较多的作业。

3. 谁不干活就给谁分配(Least-Connection LC)

lc – 根据最小连接数分派

4. 带权重的谁不干活就给谁分配(Weighted Least-Connections WLC 默认)

wlc – 带权重的。机器配置好的权重高。

5. 基于地区的最少连接调度(Locality-Based Least-Connection

Scheduling LBLC)

lblc – 缓存服务器集群。基于本地的最小连接。把请求传递到负载小的服务器上。

6. 带有复制调度的基于地区的最少连接调度(Locality-Based Least-Connection Scheduling with Replication Scheduling LBLCR)

lblcr – 带复制调度的缓存服务器集群。某页面缓存在服务器 A 上,被访问次数极高,而其他缓存服务器负载较低,监视是否访问同一页面,如果是访问同一页面则把请求分到其他服务器。

7. 目标散列调度(Destination Hash Scheduling DH)

realserver 中绑定两个 ip。ld 判断来者的 ISP 商,将其转到相应的 IP。

8. 源散列调度 (Source Hash Scheduling SH)

源地址散列。基于 client 地址的来源区分。(用的很少)

9. 最短的期望的延迟(Shortest Expected Delay Scheduling SED)

基于 wlc 算法。这个必须举例来说了

ABC 三台机器分别权重 123,连接数也分别是 123。那么如果使用 WLC 算法的话一个新请求进入时它可能会分给 ABC 中的任意一个。使用 sed 算法后会进行这样一个运算

A:(1+1)/1

B:(1+2)/2

C:(1+3)/3

根据运算结果,把连接交给 C。

10. 最少队列调度(Never Queue Scheduling NQ)

无需队列。如果有台 realserver 的连接数=0 就直接分配过去,不需要在进行 sed 运算。

遇到的问题..

这个实验看着简单, 做了足足半个月, 但是还有一些不明白的问题, 可能和网络知识的匮乏有关系。

在 DR 前置机上不能通过 VIP 访问真实的服务器

在 DR 前置机上执行命令, 报错如下

查看 ipvsadm, 连接状态是 SYN_RECV

一开始我使用了三台虚拟机, 卡在这个地方很长时间。

后来偶然发现, 用第四台虚拟机就可以正常访问了..

实现负载均衡有很多种方式, 土豪直接 F5, 性能最好, 价格最贵

没钱也可以使用 Apache,Nginx 工作在网络的第四层, 虽然性能一般, 但是很灵活, 比如可以将 80 端口映射到真实服务器的 8080 端口.

还有一种选择 LVS , 它工作在网络的第三层, 性能较好, 非常稳定. 但是它不能实现端口的重新映射. 因为在网络的第三层, 并不清楚端口的信息。

下面的实验搭建了一个 LVS 负载均衡测试环境, 采用 DR 的方式。

Linux 服务器 LB 群集之 LVS-NAT http://www.linuxidc.com/Linux/2013-05/84774.htm

Linux 下群集服务之 LB 集群 -LVS-NAT 模式 http://www.linuxidc.com/Linux/2012-05/59839.htm

LVS-NAT+ipvsadm 实现 RHEL 5.7 上的服务集群 http://www.linuxidc.com/Linux/2012-04/58936.htm

Linux 虚拟服务器 LVS-NAT 和 LVS-DR 模型的实现 http://www.linuxidc.com/Linux/2011-09/42934.htm

客户端访问 LVS 前置机

这个请求如下

源 MAC(client mac) 目标 MAC(DR mac) 源 IP(client IP) 目标 IP(DR IP,VIP)

LVS 前置机会将报文改写之后转发真实的服务器

改写如下

源 MAC(client mac) 目标 MAX(真实服务器 MAC) 源 IP(client IP) 目标 IP(DR IP,VIP)

因为真实的服务器将 VIP 绑定到了环回地址, 所以会处理这个请求, 并返回响应的报文.

网络层的源目对掉

源 MAC(真实服务器 MAC) 目标 MAC(client mac) 源 IP(DR IP,VIP) 目标 IP(client IP)

所以 LVS DR 的本质就是网络层的欺骗。

实验采用 VirtualBox 虚拟机, 并且配置内部网络, 关闭 SELinux 和防火墙

首先, 在 LVS DR 前置机上安装 ipvsadm 命令

yum install ipvsadm -y

然后配置两台真实服务器 (RealServer) 的 Http 服务

yum install httpd -y

service httpd start

chkconfig httpd on

并分别改写 /var/www/html/index.html 的内容为 ”real server 1″ 和 ”real server 2″

然后在两台真实服务器上执行如下的脚本

vim lvs_real.sh

#!/bin/bash

# description: Config realserver lo and apply noarp

SNS_VIP=192.168.16.199

source /etc/rc.d/init.d/functions

case “$1” in

start)

ifconfig lo:0 $SNS_VIP netmask 255.255.255.255 broadcast $SNS_VIP

/sbin/route add -host $SNS_VIP dev lo:0

echo “1” >/proc/sys/net/ipv4/conf/lo/arp_ignore

echo “2” >/proc/sys/net/ipv4/conf/lo/arp_announce

echo “1” >/proc/sys/net/ipv4/conf/all/arp_ignore

echo “2” >/proc/sys/net/ipv4/conf/all/arp_announce

sysctl -p >/dev/null 2>&1

echo “RealServer Start OK”

;;

stop)

ifconfig lo:0 down

route del $SNS_VIP >/dev/null 2>&1

echo “0” >/proc/sys/net/ipv4/conf/lo/arp_ignore

echo “0” >/proc/sys/net/ipv4/conf/lo/arp_announce

echo “0” >/proc/sys/net/ipv4/conf/all/arp_ignore

echo “0” >/proc/sys/net/ipv4/conf/all/arp_announce

echo “RealServer Stoped”

;;

*)

echo “Usage: $0 {start|stop}”

exit 1

esac

exit 0

最后, 在 DR 前置机上执行如下脚本

vim lvs_dr.sh

#!/bin/bash

VIP1=192.168.16.199

RIP1=192.168.16.3

RIP2=192.168.16.4

case “$1” in

start)

echo ” start LVS of DirectorServer”

/sbin/ifconfig eth1:0 $VIP1 broadcast $VIP1 netmask 255.255.255.255 broadcast $VIP1 up

/sbin/route add -host $VIP1 dev eth1:0

echo “1” >/proc/sys/net/ipv4/ip_forward

/sbin/ipvsadm -C

/sbin/ipvsadm -A -t $VIP1:80 -s rr

/sbin/ipvsadm -a -t $VIP1:80 -r $RIP1:80 -g -w 1

/sbin/ipvsadm -a -t $VIP1:80 -r $RIP2:80 -g -w 1

/sbin/ipvsadm

;;

stop)

echo “close LVS Directorserver”

echo “0” >/proc/sys/net/ipv4/ip_forward

/sbin/ipvsadm -C

/sbin/ifconfig eth1:0 down

;;

*)

echo “Usage: $0 {start|stop}”

exit 1

esac

通过 client 访问 LVS 前置服务器, 可以看到已经实现了负载均衡的效果。

更多详情见请继续阅读下一页的精彩内容:http://www.linuxidc.com/Linux/2014-09/106636p2.htm