共计 5831 个字符,预计需要花费 15 分钟才能阅读完成。

一、Hadoop 的运行模式

单机模式(standalone)

单机模式是 Hadoop 的默认模式。当首次解压 Hadoop 的源码包时,Hadoop 无法了解硬件安装环境,便保守地选择了最小配置。在这种默认模式下所有 3 个 XML 文件均为空。当配置文件为空时,Hadoop 会完全运行在本地。因为不需要与其他节点交互,单机模式就不使用 HDFS,也不加载任何 Hadoop 的守护进程。该模式主要用于开发调试 MapReduce 程序的应用逻辑。

伪分布模式(Pseudo-Distributed Mode)

伪分布模式在“单节点集群”上运行 Hadoop,其中所有的守护进程都运行在同一台机器上。该模式在单机模式之上增加了代码调试功能,允许你检查内存使用情况,HDFS 输入输出,以及其他的守护进程交互。

全分布模式(Fully Distributed Mode)

Hadoop 守护进程运行在一个集群上。

二、创建 hadoop 组和 hadoop 用户

增加 hadoop 用户组,同时在该组里增加 hadoop 用户,后续在涉及到 hadoop 操作时,我们使用该用户。

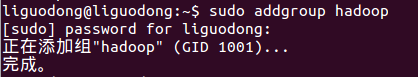

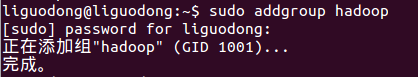

1、创建 hadoop 用户组

sudo addgroup hadoop

groupdel users 删除组 users

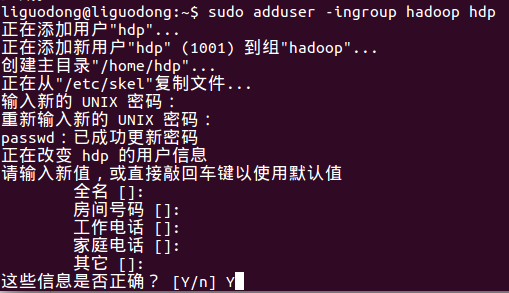

2、创建 hadoop 用户

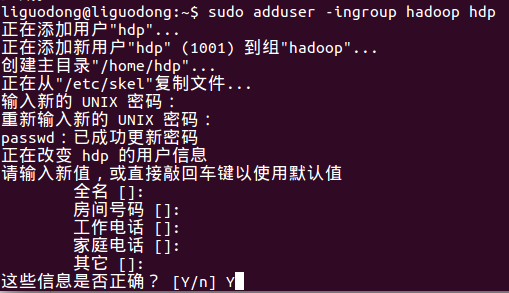

sudo adduser -ingroup hadoop hdp

回车后会提示输入新的 UNIX 密码,这是新建用户 hdp 的密码,输入回车即可。如果不输入密码,回车后会重新提示输入密码,即密码不能为空。最后确认信息是否正确,如果没问题,输入 Y,回车即可。

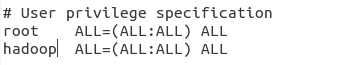

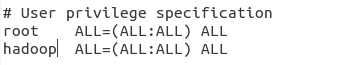

3、为 hadoop 用户添加权限

输入:sudo gedit /etc/sudoers,回车,

打开 sudoers 文件,给 hadoop 用户赋予和 root 用户同样的权限。

三、用新增加的 hdp 用户登录 Ubuntu 系统

命令行输入 su hpd 并输入密码。

或者

直接切换图形操作系统。

四、安装 SSH

sudo apt-get install openssh-server

安装完成后,启动服务:sudo /etc/init.d/ssh start

并查看服务是否正确启动:ps -e | grep ssh

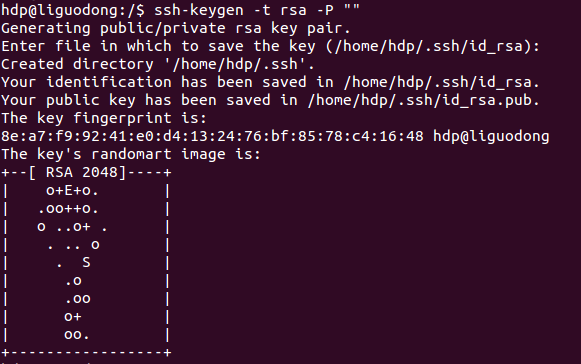

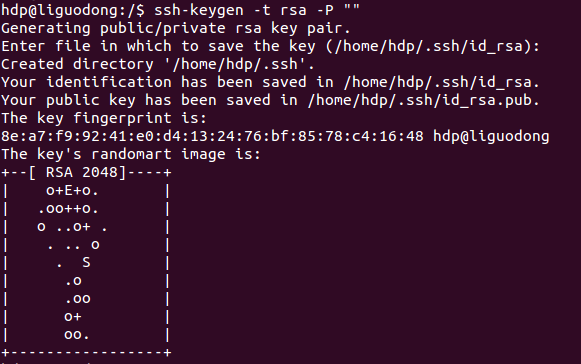

作为一个安全通信协议,使用时需要密码,因此我们要设置成免密码登录,生成私钥和公钥:

ssh-keygen -t rsa -P ""

第一次操作时会提示输入密码,按 Enter 直接过,这时会在~/home/{username}/.ssh 下生成两个文件:id_rsa 和 id_rsa.pub,前者为私钥,后者为公钥。

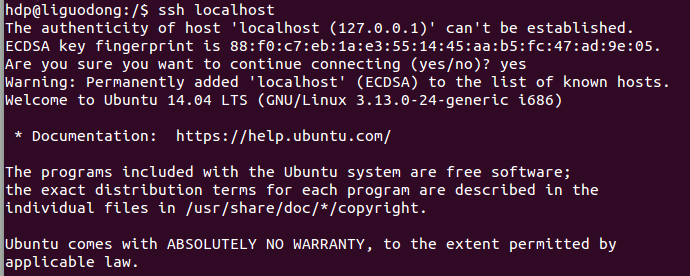

现在将公钥追加到 authorized_keys 中(authorized_keys 用于保存所有允许以当前用户身份登录到 ssh 客户端的用户)

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys 现在可以登入 ssh 确认以后登录时不用输入密码:

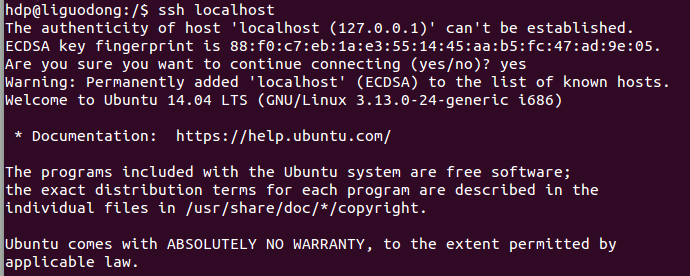

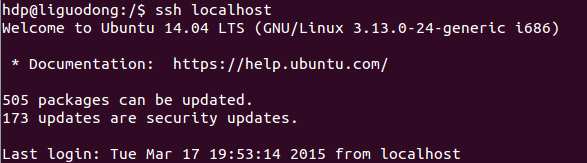

ssh localhost

登出:exit

第二次登录:

登出:exit

五、安装 Java 环境

安装 jdk:sudo apt-get install openjdk-7-jdk

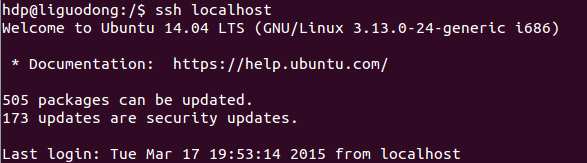

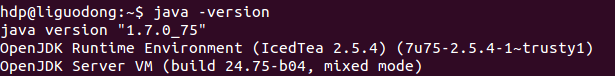

查看安装结果,输入命令:java -version,结果如下表示安装成功。

六、安装 hadoop2.5.2

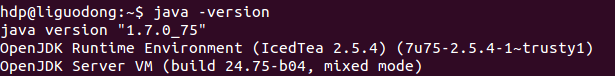

1、下载

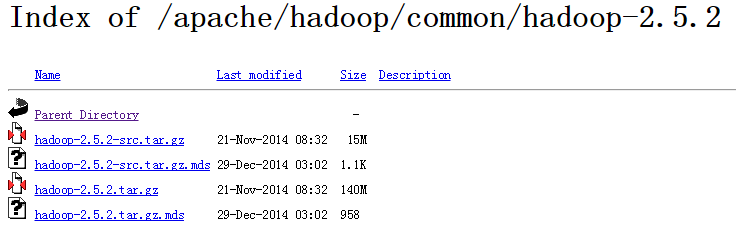

官网下载 http://mirror.bit.edu.cn/apache/hadoop/common/

下载 hadoop-2.5.2-src.tar.gz 并放到你希望的目录中,

我是放到 /software/ 中。

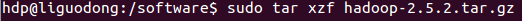

2、安装

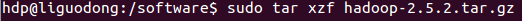

解压sudo tar xzf hadoop-2.5.2.tar.gz

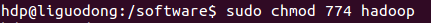

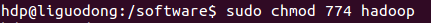

修改文件夹名,并且赋予用户对该文件夹的读写权限。

sudo mv hadoop-2.5.2 hadoopsudo chmod 774 hadoop

更多详情见请继续阅读下一页的精彩内容:http://www.linuxidc.com/Linux/2015-03/115173.htm

————————————– 分割线 ————————————–

Ubuntu14.04 下 Hadoop2.4.1 单机 / 伪分布式安装配置教程 http://www.linuxidc.com/Linux/2015-02/113487.htm

CentOS 安装和配置 Hadoop2.2.0 http://www.linuxidc.com/Linux/2014-01/94685.htm

Ubuntu 13.04 上搭建 Hadoop 环境 http://www.linuxidc.com/Linux/2013-06/86106.htm

Ubuntu 12.10 +Hadoop 1.2.1 版本集群配置 http://www.linuxidc.com/Linux/2013-09/90600.htm

Ubuntu 上搭建 Hadoop 环境(单机模式 + 伪分布模式)http://www.linuxidc.com/Linux/2013-01/77681.htm

Ubuntu 下 Hadoop 环境的配置 http://www.linuxidc.com/Linux/2012-11/74539.htm

单机版搭建 Hadoop 环境图文教程详解 http://www.linuxidc.com/Linux/2012-02/53927.htm

搭建 Hadoop 环境(在 Winodws 环境下用虚拟机虚拟两个 Ubuntu 系统进行搭建)http://www.linuxidc.com/Linux/2011-12/48894.htm

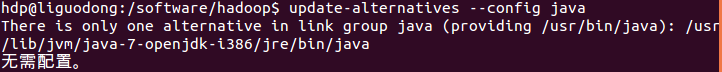

3、配置.bashrc 文件

配置.bashrc 文件前需要知道 Java 的安装路径,用来设置 JAVA_HOME 环境变量,可以使用下面命令行查看安装路径:

update-alternatives --config java执行后,完整路径为:

/usr/lib/jvm/java-7-openjdk-i386/jre/bin/java

我们只取前面的部分 /usr/lib/jvm/java-7-openjdk-i386

配置.bashrc 文件

sudo gedit ~/.bashrc该命令会打开该文件的编辑窗口,在 文件末尾 追加下面内容,然后 保存 , 关闭编辑窗口。

#Hadoop VARIABLES START

export JAVA_HOME=/usr/lib/jvm/java-7-openjdk-i386

export HADOOP_INSTALL=/software/hadoop

export PATH=$PATH:$HADOOP_INSTALL/bin

export PATH=$PATH:$HADOOP_INSTALL/sbin

export HADOOP_MAPRED_HOME=$HADOOP_INSTALL

export HADOOP_COMMON_HOME=$HADOOP_INSTALL

export HADOOP_HDFS_HOME=$HADOOP_INSTALL

export YARN_HOME=$HADOOP_INSTALL

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_INSTALL/lib/native

export HADOOP_OPTS="-Djava.library.path=$HADOOP_INSTALL/lib"

#HADOOP VARIABLES END

使添加的环境变量生效:source ~/.bashrc

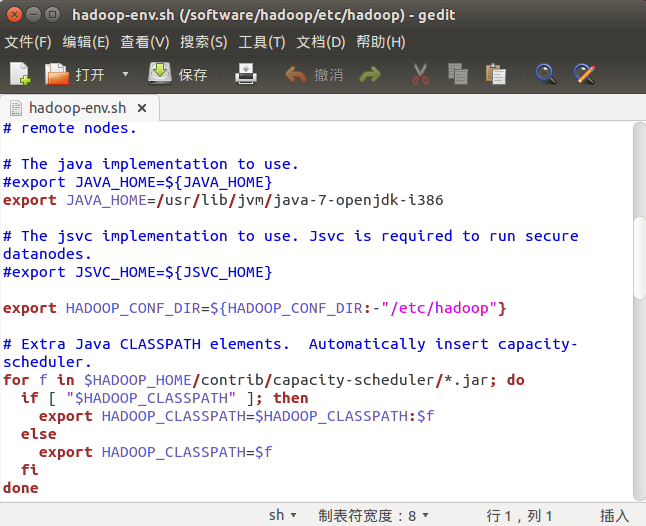

4、编辑 /usr/local/hadoop/etc/hadoop/hadoop-env.sh

执行下面命令,打开该文件的编辑窗口

sudo gedit /software/hadoop/etc/hadoop/hadoop-env.sh找到 JAVA_HOME 变量,修改此变量如下:

export JAVA_HOME=/usr/lib/jvm/java-7-openjdk-i386- 1

单机模式安装完成。

七、WordCount 测试

下面通过执行 hadoop 自带实例 WordCount 验证是否安装成功。

/software/hadoop 路径下创建 input 文件夹

mkdir input拷贝 README.txt 到 input cp README.txt input

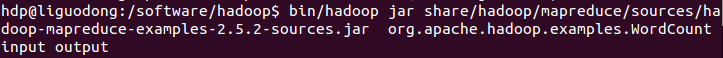

执行 WordCount

bin/hadoop jar share/hadoop/mapreduce/sources/hadoop-mapreduce-examples-2.5.2-sources.jar org.apache.hadoop.examples.WordCount input output

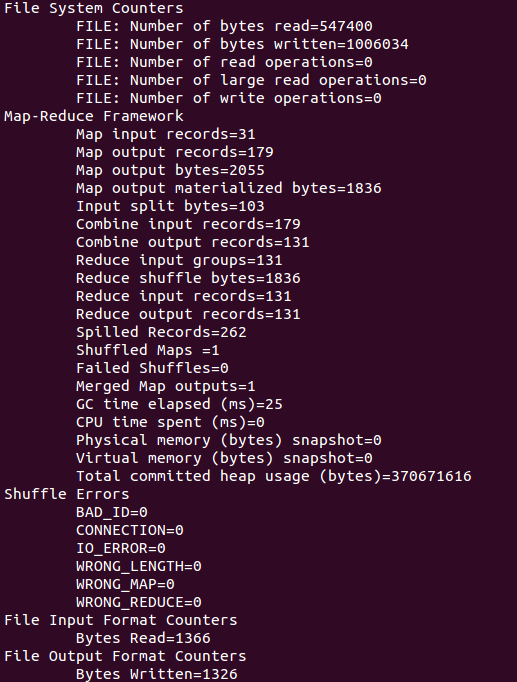

执行结果:

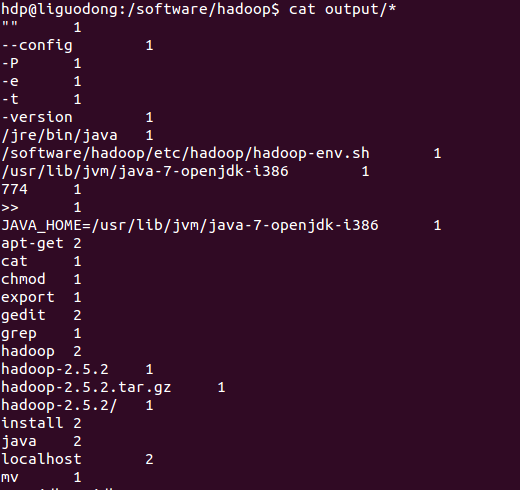

执行 cat output/*,查看字符统计结果。

更多 Hadoop 相关信息见Hadoop 专题页面 http://www.linuxidc.com/topicnews.aspx?tid=13

本文永久更新链接地址:http://www.linuxidc.com/Linux/2015-03/115173.htm

一、Hadoop 的运行模式

单机模式(standalone)

单机模式是 Hadoop 的默认模式。当首次解压 Hadoop 的源码包时,Hadoop 无法了解硬件安装环境,便保守地选择了最小配置。在这种默认模式下所有 3 个 XML 文件均为空。当配置文件为空时,Hadoop 会完全运行在本地。因为不需要与其他节点交互,单机模式就不使用 HDFS,也不加载任何 Hadoop 的守护进程。该模式主要用于开发调试 MapReduce 程序的应用逻辑。

伪分布模式(Pseudo-Distributed Mode)

伪分布模式在“单节点集群”上运行 Hadoop,其中所有的守护进程都运行在同一台机器上。该模式在单机模式之上增加了代码调试功能,允许你检查内存使用情况,HDFS 输入输出,以及其他的守护进程交互。

全分布模式(Fully Distributed Mode)

Hadoop 守护进程运行在一个集群上。

二、创建 hadoop 组和 hadoop 用户

增加 hadoop 用户组,同时在该组里增加 hadoop 用户,后续在涉及到 hadoop 操作时,我们使用该用户。

1、创建 hadoop 用户组

sudo addgroup hadoop

groupdel users 删除组 users

2、创建 hadoop 用户

sudo adduser -ingroup hadoop hdp

回车后会提示输入新的 UNIX 密码,这是新建用户 hdp 的密码,输入回车即可。如果不输入密码,回车后会重新提示输入密码,即密码不能为空。最后确认信息是否正确,如果没问题,输入 Y,回车即可。

3、为 hadoop 用户添加权限

输入:sudo gedit /etc/sudoers,回车,

打开 sudoers 文件,给 hadoop 用户赋予和 root 用户同样的权限。

三、用新增加的 hdp 用户登录 Ubuntu 系统

命令行输入 su hpd 并输入密码。

或者

直接切换图形操作系统。

四、安装 SSH

sudo apt-get install openssh-server

安装完成后,启动服务:sudo /etc/init.d/ssh start

并查看服务是否正确启动:ps -e | grep ssh

作为一个安全通信协议,使用时需要密码,因此我们要设置成免密码登录,生成私钥和公钥:

ssh-keygen -t rsa -P ""

第一次操作时会提示输入密码,按 Enter 直接过,这时会在~/home/{username}/.ssh 下生成两个文件:id_rsa 和 id_rsa.pub,前者为私钥,后者为公钥。

现在将公钥追加到 authorized_keys 中(authorized_keys 用于保存所有允许以当前用户身份登录到 ssh 客户端的用户)

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys 现在可以登入 ssh 确认以后登录时不用输入密码:

ssh localhost

登出:exit

第二次登录:

登出:exit

五、安装 Java 环境

安装 jdk:sudo apt-get install openjdk-7-jdk

查看安装结果,输入命令:java -version,结果如下表示安装成功。

六、安装 hadoop2.5.2

1、下载

官网下载 http://mirror.bit.edu.cn/apache/hadoop/common/

下载 hadoop-2.5.2-src.tar.gz 并放到你希望的目录中,

我是放到 /software/ 中。

2、安装

解压sudo tar xzf hadoop-2.5.2.tar.gz

修改文件夹名,并且赋予用户对该文件夹的读写权限。

sudo mv hadoop-2.5.2 hadoopsudo chmod 774 hadoop

更多详情见请继续阅读下一页的精彩内容:http://www.linuxidc.com/Linux/2015-03/115173.htm

————————————– 分割线 ————————————–

Ubuntu14.04 下 Hadoop2.4.1 单机 / 伪分布式安装配置教程 http://www.linuxidc.com/Linux/2015-02/113487.htm

CentOS 安装和配置 Hadoop2.2.0 http://www.linuxidc.com/Linux/2014-01/94685.htm

Ubuntu 13.04 上搭建 Hadoop 环境 http://www.linuxidc.com/Linux/2013-06/86106.htm

Ubuntu 12.10 +Hadoop 1.2.1 版本集群配置 http://www.linuxidc.com/Linux/2013-09/90600.htm

Ubuntu 上搭建 Hadoop 环境(单机模式 + 伪分布模式)http://www.linuxidc.com/Linux/2013-01/77681.htm

Ubuntu 下 Hadoop 环境的配置 http://www.linuxidc.com/Linux/2012-11/74539.htm

单机版搭建 Hadoop 环境图文教程详解 http://www.linuxidc.com/Linux/2012-02/53927.htm

搭建 Hadoop 环境(在 Winodws 环境下用虚拟机虚拟两个 Ubuntu 系统进行搭建)http://www.linuxidc.com/Linux/2011-12/48894.htm