共计 896 个字符,预计需要花费 3 分钟才能阅读完成。

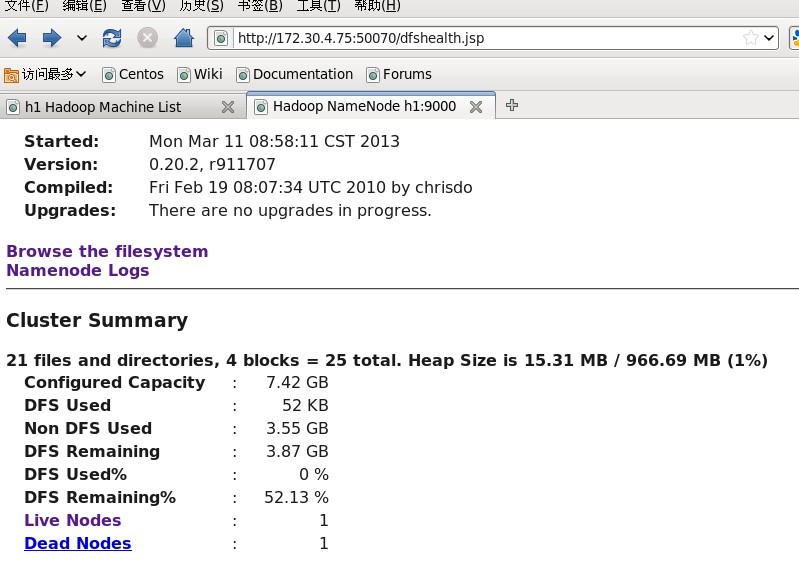

今天把集群重新扩容了一下,把之前的两台电脑重新装了系统,结果启动 Hadoop 发现报错了。

问题原因:在 hdfs-site 中配置的副本书为 1,而且把两台机子的文件给清理了,导致一部分数据丢失,而且无法恢复,报错导致 hbase 无法访问 60010 端口

解决办法:使用 hadoop fsck / 列出损坏文件,损坏的文件无法恢复,只能删除损坏的文件 hadoop fsck -delete

————————————– 分割线 ————————————–

Ubuntu14.04 下 Hadoop2.4.1 单机 / 伪分布式安装配置教程 http://www.linuxidc.com/Linux/2015-02/113487.htm

CentOS 安装和配置 Hadoop2.2.0 http://www.linuxidc.com/Linux/2014-01/94685.htm

Ubuntu 13.04 上搭建 Hadoop 环境 http://www.linuxidc.com/Linux/2013-06/86106.htm

Ubuntu 12.10 +Hadoop 1.2.1 版本集群配置 http://www.linuxidc.com/Linux/2013-09/90600.htm

Ubuntu 上搭建 Hadoop 环境(单机模式 + 伪分布模式)http://www.linuxidc.com/Linux/2013-01/77681.htm

Ubuntu 下 Hadoop 环境的配置 http://www.linuxidc.com/Linux/2012-11/74539.htm

单机版搭建 Hadoop 环境图文教程详解 http://www.linuxidc.com/Linux/2012-02/53927.htm

更多 Hadoop 相关信息见 Hadoop 专题页面 http://www.linuxidc.com/topicnews.aspx?tid=13

本文永久更新链接地址 :http://www.linuxidc.com/Linux/2015-04/116176.htm