共计 4544 个字符,预计需要花费 12 分钟才能阅读完成。

近几年大数据越来越火热。由于工作需要以及个人兴趣,最近开始学习大数据相关技术。学习过程中的一些经验教训希望能通过博文沉淀下来,与网友分享讨论,作为个人备忘。

第一篇,在 Win7 虚拟机下搭建 Hadoop2.6.0 伪分布式环境。

1. 所需要的软件

使用 VMware 11.0 搭建虚拟机,安装 Ubuntu 14.04.2 系统。

Jdk 1.7.0_80

Hadoop 2.6.0

2. 安装 VMware 和 Ubuntu

Windows 7 下用 VMware Workstation 10 虚拟机安装 Ubuntu 14.04 http://www.linuxidc.com/Linux/2014-04/100473.htm

3. 在 Ubuntu 中安装 JDK

将 jdk 解压缩到目录:/home/vm/tools/jdk

在~/.bash_profile 中配置环境变量,并通过 source ~/.bash_profile 生效。

#java export JAVA_HOME=/home/vm/tools/jdk export JRE_HOME=/home/vm/tools/jdk/jre export PATH=$JAVA_HOME/bin:$JRE_HOME/bin:$PATH export CLASSPATH=$JAVA_HOME/lib:$JRE_HOME/lib:$CLASSPATH |

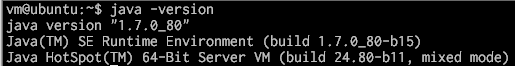

检验 jdk 安装是否成功。

4. 配置 ssh 信任关系,实现无密码登录

4.1 安装 ssh

Ubuntu 默认安装了 ssh 客户端,但没有安装 ssh 服务端,因此可以通过 apt-get 安装。

安装 ssh-server:sudo apt-get install openssh-server

如果没有 ssh 客户端,也可以通过 apt-get 安装。

安装 ssh-client:sudo apt-get install openssh-client

启动 ssh-server:sudo service ssh start

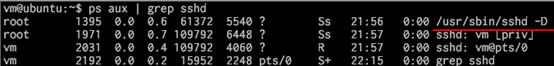

启动以后,通过 ps –aux | grep sshd 查看 ssh 服务器是否安装成功。

SSH 服务远程访问 Linux 服务器登陆慢 http://www.linuxidc.com/Linux/2011-08/39742.htm

提高 Ubuntu 的 SSH 登陆认证速度的办法 http://www.linuxidc.com/Linux/2014-09/106810.htm

开启 SSH 服务让 Android 手机远程访问 Ubuntu 14.04 http://www.linuxidc.com/Linux/2014-09/106809.htm

如何为 Linux 系统中的 SSH 添加双重认证 http://www.linuxidc.com/Linux/2014-08/105998.htm

在 Linux 中为非 SSH 用户配置 SFTP 环境 http://www.linuxidc.com/Linux/2014-08/105865.htm

Linux 上 SSH 服务的配置和管理 http://www.linuxidc.com/Linux/2014-06/103627.htm

SSH 入门学习基础教程 http://www.linuxidc.com/Linux/2014-06/103008.htm

SSH 免密码登录详解 http://www.linuxidc.com/Linux/2015-03/114709.htm

4.2 配置 ssh 信任关系

生成机器 A 的公私密钥对:ssh-keygen -t rsa,之后一路回车。在~/.ssh 目录下生成公钥 id_rsa.pub,私钥 id_ras。

拷贝机器 A 的 id_rsa.pub 到机器 B 的认证文件中:

cat id_rsa.pub >> ~/.ssh/authorized_keys

这时候机器 A 到机器 B 的信任关系就建立好了,此时在机器 A 可以不需要密码直接 ssh 登录机器 B 了。

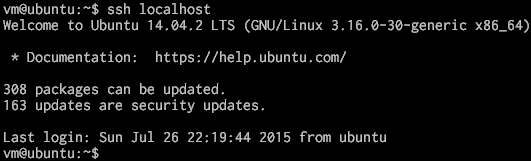

本例中机器 A 和 B 是同一台机器,配置 ssh 信任关系以后可以使用 ssh localhost 或者 ssh 机器 IP 地址来验证。

5. 安装 Hadoop2.6.0

5.1 解压 Hadoop2.6.0

从官网下载 hadoop-2.6.0.tar.gz,解压到目录 /home/vm/tools/hadoop,并配置~/.bash_profile 环境变量。通过 source ~/.bash_profile 生效。

#hadoop export HADOOP_HOME=/home/vm/tools/hadoop export PATH=$HADOOP_HOME/bin:$PATH export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native export HADOOP_OPTS=”-Djava.library.path=$HADOOP_HOME/lib” |

5.2 修改配置文件

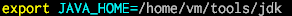

修改 $HADOOP_HOME/etc/hadoop/hadoop-env.sh 和 yarn-evn.sh,配置 JAVA_HOME 路径:

修改 $HADOOP_HOME/etc/hadoop/slaves,增加本机 IP 地址:

cat “192.168.62.129” >> slaves

修改 $HADOOP_HOME/etc/hadoop/ 下的几个重要的 *-site.xml:

core-site.xml 192.168.62.129 是我虚拟机的 IP 地址

<configuration> <property> <name>fs.defaultFS</name> <value>hdfs://192.168.62.129:9000</value> </property> <property> <name>hadoop.tmp.dir</name> <value>file:/home/vm/app/hadoop/tmp</value> <description>a base for other temporary directories.</description> </property> </configuration> |

hdfs-site.xml

<configuration> <property> <name>dfs.replication</name> <value>1</value> </property> <property> <name>dfs.namenode.name.dir</name> <value>file:/home/vm/app/hadoop/dfs/nn</value> </property> <property> <name>dfs.namenode.data.dir</name> <value>file:/home/vm/app/hadoop/dfs/dn</value> </property> <property> <name>dfs.permissions</name> <value>false</value> <description> permission checking is turned off </description> </property> </configuration> |

mapred-site.xml

<configuration> <property> <name>mapred.job.tracker</name> <value>hdfs://192.168.62.129:9001</value> </property> <property> <name>mapreduce.framework.name</name> <value>yarn</value> </property> </configuration> |

yarn-site.xml

<configuration> <!– Site specific YARN configuration properties –> <property> <name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value> </property> </configuration> |

5.3 格式化文件系统

在 $HADOOP_HOME 下执行 bin/hdfs namenode –format格式化文件系统

5.4 启停

在 $HADOOP_HOME 下执行sbin/start-dfs.sh 和 sbin/start-yarn.sh 启动 hadoop 集群, 执行sbin/stop-dfs.sh 和 sbin/stop-yarn.sh 停止 hadoop 集群。

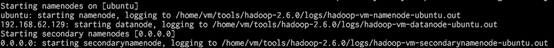

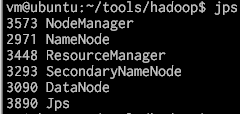

启动过程例如:

启动完毕进程如下:

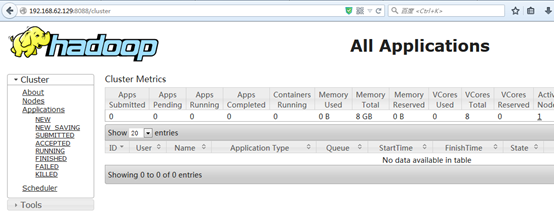

6. 查询集群信息

8088 端口,查看 All Applications 信息:

50070 端口,查看 hdfs 信息:

7. 验证 hadoop 环境搭建是否成功

7.1 验证 hdfs 是否正常

可以使用各种 hdfs 命令测试。例如:

hdfs dfs -ls ./

hdfs dfs -put file.1 ./

hdfs dfs -get ./file1

hdfs dfs -rm -f ./file.1

hdfs dfs -cat ./file1

hdfs dfs -df -h

7.2 验证 map/reduce 计算框架是否正常

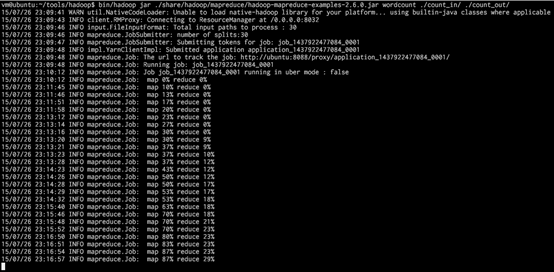

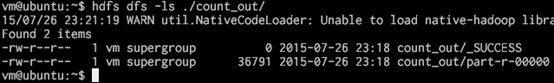

在 $HADOOP_HOME 目录下执行:bin/hadoop jar ./share/hadoop/mapreduce/hadoop-mapreduce-examples-2.6.0.jar wordcount ./count_in/ ./count_out/

其中./count_in/ 提前在 hdfs 集群创建,统计该目录下所有文件的单词数量,输出到./count_out/ 目录。

执行过程示例如下:

执行完毕生成结果:

至此,Hadoop2.6.0 的伪分布式环境搭建完成。

Ubuntu14.04 下 Hadoop2.4.1 单机 / 伪分布式安装配置教程 http://www.linuxidc.com/Linux/2015-02/113487.htm

CentOS 安装和配置 Hadoop2.2.0 http://www.linuxidc.com/Linux/2014-01/94685.htm

Ubuntu 13.04 上搭建 Hadoop 环境 http://www.linuxidc.com/Linux/2013-06/86106.htm

Ubuntu 12.10 +Hadoop 1.2.1 版本集群配置 http://www.linuxidc.com/Linux/2013-09/90600.htm

Ubuntu 上搭建 Hadoop 环境(单机模式 + 伪分布模式)http://www.linuxidc.com/Linux/2013-01/77681.htm

Ubuntu 下 Hadoop 环境的配置 http://www.linuxidc.com/Linux/2012-11/74539.htm

单机版搭建 Hadoop 环境图文教程详解 http://www.linuxidc.com/Linux/2012-02/53927.htm

更多 Hadoop 相关信息见Hadoop 专题页面 http://www.linuxidc.com/topicnews.aspx?tid=13

本文永久更新链接地址:http://www.linuxidc.com/Linux/2015-08/120942.htm