共计 1747 个字符,预计需要花费 5 分钟才能阅读完成。

Spark 集群处理能力不足需要扩容,如何在现有 spark 集群中新增新节点?本文以一个实例介绍如何给 Spark 集群新增一个节点。

1. 集群环境

现有 Spark 集群包括 3 台机器,用户名都是 cdahdp,主目录 /home/ap/cdahdp,配置是 2C8G 虚拟机,集群基于 yarn 架构。

Master:128.196.54.112/W118PC01VM01

Slave1:128.196.54.113/W118PC02VM01

Slave2:128.196.54.114/W118PC03VM01

相关软件版本:jdk1.7、scala2.10.4、Hadoop2.6.0、spark1.1

现在需要新增一个节点:128.196.54.115/W118PC04VM01,2C8G

首先停止当前集群:停止 spark,停止 hdfs 和 yarn。

2. 新节点要求

(1)新节点需要增加用户 cdahdp,主目录 /home/ap/cdahdp。与集群现有机器一致。

(2)修改所有节点的 /etc/hosts 文件,更新新节点的 ip hostname 配置。

(3)配置 ssh,使新节点与集群中各节点能够无密码互相 ssh 登录。

(4)在新节点上安装 jdk、scala、hadoop 和 spark。其版本,安装目录,环境变量设置与集群中现有节点保持一致。比如可以直接从集群节点赋值。

3. 配置文件修改

(1)修改 $HADOOP_HOME/etc/hadoop/slaves 文件,增加新节点作为 slave 节点。

(2)修改 $SPARK_HOME/conf/slaves 文件,增加新节点作为 slave 节点。

(3)格式化新节点的 namenode:

cd $HADOOP_HOME/bin

./hdfs namenode -format

4. 启动新集群

启动 hdfs,yarn,以及 spark。

cd $HADOOP_HOME/sbin

./start-dfs.sh && ./start-yarn.sh

cd $SPARK_HOME/sbin

./start-all.sh

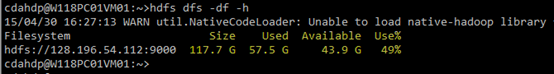

扩容以前:

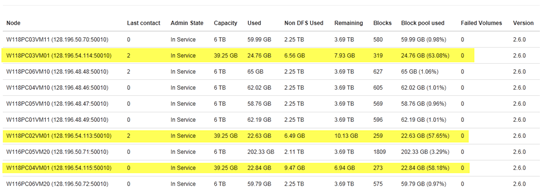

扩容以后:

5. 集群的负载均衡

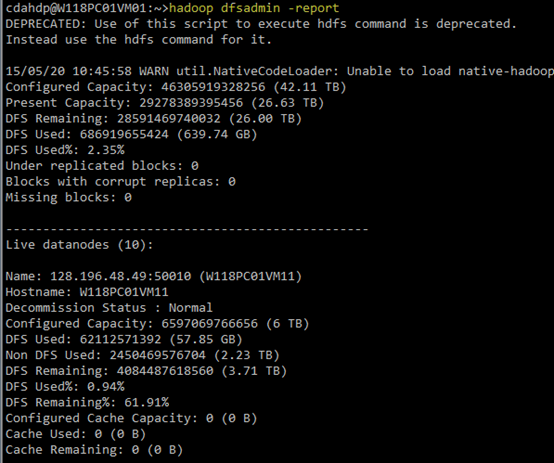

(1)查看 HDFS 集群的基本信息:执行 hadoop dfsadmin -report

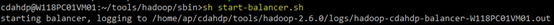

(2)负载均衡:在 $HADOOP_HOME/sbin/ 下执行 start-balancer.sh

说明:balancer 操作是一个较慢的过程,所以在后台执行。balance 过程中,数据在各节点之间迁移的速度默认是 1M/s。

负载均衡之前:

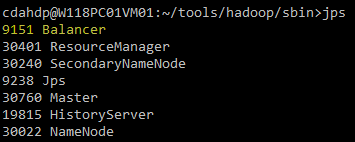

执行负载均衡:

负载均衡之后:

至此,在 spark 集群增加新节点完毕。

————————————– 分割线 ————————————–

Spark1.0.0 部署指南 http://www.linuxidc.com/Linux/2014-07/104304.htm

CentOS 6.2(64 位) 下安装 Spark0.8.0 详细记录 http://www.linuxidc.com/Linux/2014-06/102583.htm

Spark 简介及其在 Ubuntu 下的安装使用 http://www.linuxidc.com/Linux/2013-08/88606.htm

安装 Spark 集群 (在 CentOS 上) http://www.linuxidc.com/Linux/2013-08/88599.htm

Hadoop vs Spark 性能对比 http://www.linuxidc.com/Linux/2013-08/88597.htm

Spark 安装与学习 http://www.linuxidc.com/Linux/2013-08/88596.htm

Spark 并行计算模型 http://www.linuxidc.com/Linux/2012-12/76490.htm

————————————– 分割线 ————————————–

Spark 的详细介绍 :请点这里

Spark 的下载地址 :请点这里

本文永久更新链接地址 :http://www.linuxidc.com/Linux/2015-08/120937.htm