共计 3277 个字符,预计需要花费 9 分钟才能阅读完成。

1、搭建 Linux 环境

我准备的环境是 VM RedHat Linux 6.5 64bit

设置固定 IP

vim /etc/sysconfig/network-scripts/ifcfg-eth0

将 IP 地址设定为 192.168.38.128

修改主机名:vim /etc/hosts

将主机名改为 itbuilder1

2、安装 JDK

配置好 JDK 的环境变量

3、安装 Hadoop 环境

从 Apache 官网下载 2.7.1 版本的 hadoop 核心包

地址:http://archive.apache.org/dist/hadoop/core/stable2/hadoop-2.7.1.tar.gz

3.1 将安装包解压到制定目录下

首先创建一个目录:mkdir /usr/local/hadoop

将文件解压到 /usr/local/hadoop 目录下:tar -zxvf hadoop-2.7.1.tar.gz -C /usr/local/hadoop

3.2 修改配置文件

hadoop2.7.1 版本需要修改 5 个配置文件,如下

1、hadoop-env.sh

2、core-site.xml

3、hdfs-site.xml

4、mapred-site.xml(mapred-site.xml.template)

5、yarn-site.xml

这 5 个文件都在 hadoop 木下的 etc 中,具体目录为:/usr/local/hadoop/hadoop-2.7.1/etc/hadoop/

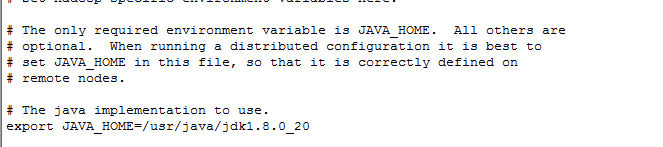

3.2.1 修改环境变量 (hadoop-env.sh)

使用 vim 命令打开 hadoop-env.sh 文件

在指定 JavaHome 的地方设置好 JDK 的根目录,如下图:

export JAVA_HOME=/usr/java/jdk1.8.0_20

3.2.2 core-site.xml 配置,指定 HDFS 的 namenode 以及临时文件地址

<configuration>

<!– 指定 HDFS 的老大(NameNode)的地址 –>

<property>

<name>fs.defaultFS</name>

<value>hdfs://itbuilder1:9000</value>

</property>

<!– 指定 hadoop 运行时产生文件的存放目录 –>

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/hadoop/hadoop-2.7.1/tmp</value>

</property>

</configuration>

3.2.3 hdfs-site.xml(指定副本数量)

<!– 制定 HDFS 保存数据副本的数量 –>

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

3.2.4 mapred-site.xml 告诉 hadoop 以后 MR 运行在 yarn 上

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

3.2.5 yarn-site.xml

<configuration>

<!– 告诉 nodemanager 获取数据的方式是 shuffle 的方式 –>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<!– 制定 yarn 的老大(ResourceManager)的地址 –>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>itbuilder1</value>

</property>

</configuration>

4、将 hadoop 添加到环境变量中

vim /etc/profile

export JAVA_HOME=/usr/java/jdk1.8.0_20

export HADOOP_HOME=/usr/local/hadoop/hadoop-2.7.1

export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin

# 刷新一下 /etc/profile

source /etc/profile

5、初始化(格式化)文件系统(HDFS)

#hadoop namenode -format (已经过时了)

hdfs namenode -format(最新的 等待时间较长)

6、启动 hadoop(hdfs yarn)

./start-all.sh(过时了,需要多次确认并且输入 linux 密码) 以后改用一下两个命令

./start-hdfs.sh

./start-yarn.sh

通过 jps 命令查看当前打开的进程

[root@linuxidc ~]# jps

3461 ResourceManager

3142 DataNode

3751 NodeManager

3016 NameNode

5034 Jps

3307 SecondaryNameNode

访问管理界面:

http://192.168.38.128:50070(hdfs 管理界面)

http://192.168.38.128:8088(mr 管理界面)

这两个界面打开,说明安装成功

Ubuntu14.04 下 Hadoop2.4.1 单机 / 伪分布式安装配置教程 http://www.linuxidc.com/Linux/2015-02/113487.htm

CentOS 安装和配置 Hadoop2.2.0 http://www.linuxidc.com/Linux/2014-01/94685.htm

Ubuntu 13.04 上搭建 Hadoop 环境 http://www.linuxidc.com/Linux/2013-06/86106.htm

Ubuntu 12.10 +Hadoop 1.2.1 版本集群配置 http://www.linuxidc.com/Linux/2013-09/90600.htm

Ubuntu 上搭建 Hadoop 环境(单机模式 + 伪分布模式)http://www.linuxidc.com/Linux/2013-01/77681.htm

Ubuntu 下 Hadoop 环境的配置 http://www.linuxidc.com/Linux/2012-11/74539.htm

单机版搭建 Hadoop 环境图文教程详解 http://www.linuxidc.com/Linux/2012-02/53927.htm

更多 Hadoop 相关信息见 Hadoop 专题页面 http://www.linuxidc.com/topicnews.aspx?tid=13

本文永久更新链接地址 :http://www.linuxidc.com/Linux/2015-09/122938.htm