共计 3460 个字符,预计需要花费 9 分钟才能阅读完成。

本人编译 Hadoop 的过程比较曲折,但收获也很多,下面系统介绍一下 CentOS7 下编译 Hadoop-2.7.1 的全过程吧。先说明,32 位 Linux 操作系统可以直接下载编译好的 Hadoop 使用,但是 64 位 Linux 操作系统需要自己编译。

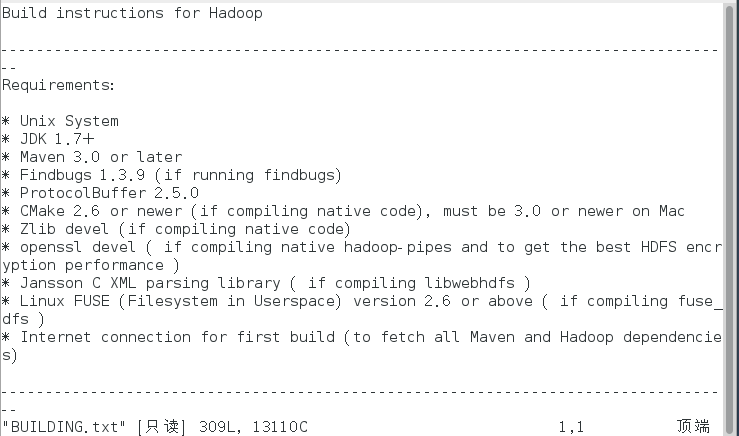

1. 工具准备,最靠谱的是 hadoop 说明文档里要求具备的那些工具。

到 hadoop 官网,点击 source 下载 hadoop-2.7.1-src.tar.gz。

解压之

tar -zxvf hadoop-2.7.1-src.tar.gz

得到 hadoop-2.7.1-src 文件夹。

进入 hadoop-2.7.1-src 文件夹,查看 BUILDING.txt

cd hadoop-2.7.1-src

vim BUILDING.txt

可以看到编译所需的库或者工具:

包括:

- JDK1.7+

- maven 3.0 or later

- findbugs 1.3.9

- protocolBuffer 2.5.0

- cmake 2.6

- zlib-devel

- openssl-devel

除了上面这些,为了不出错,实际还需要 autoconf automake gcc 等。

下面开始准备这些工具:

首先使用 su 命令获取 root 权限,以免受到各种限制

2. 下载 jdk-7u79-linux-x64.tar.gz,解压后移动到 /opt 目录下

tar -zxvf jdk-7u79-linux-x64.tar.gz

mv jdk1.7.0_79 /opt

然后打开 /etc/profile 配置 jdk 环境变量

vim /etc/profile

按 i 进入插入模式,在文件末尾添加

export JAVA_HOME=/opt/jdk1.7.0_79

export CLASSPATH=.:$JAVA_HOME/jre/lib/rt.jar:$JAVA_HOME/lib/tools.jar

export PATH=$PATH:$JAVA_HOME/bin

export JRE_HOME=/opt/jdk1.7.0_79/jre

export PATH=$PATH:$JRE_HOME/bin<br> 先后按 Esc, Shift+:,wq,回车即可保存并退出编辑。<br> 输入 source /etc/profile 回车即可保存更改。

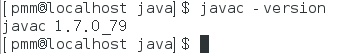

运行 javac -version 查看状态:

3. 下面安装各种库,

yum -y install svn ncurses-devel gcc*

yum -y install lzo-devel zlib-devel autoconf automake libtool cmake openssl-devel

4. 安装 protobuf-2.5.0.tar.gz(注意版本必须是 2.5.0)

protobuf-2.5.0.tar.gz 下载地址:

—————————————— 分割线 ——————————————

免费下载地址在 http://linux.linuxidc.com/

用户名与密码都是www.linuxidc.com

具体下载目录在 /2015 年资料 /10 月 /10 日 /CentOS7 下用 JDK1.7 编译 Hadoop-2.7.1 全过程详解 /

下载方法见 http://www.linuxidc.com/Linux/2013-07/87684.htm

—————————————— 分割线 ——————————————

tar zxvf protobuf-2.5.0.tar.gz

进入 protobuf-2.5.0 依次执行

cd protobuf-2.5.0

./configure

make

make install

验证安装是否完成

protoc –version

出现

5. 安装 maven

下载 apache- maven- 3.2.3- bin.tar.gz

解压缩并配置环境变量

解压:

tar -zxvf apache-maven-3.3.3-bin.tar.gz

移动到 /opt 目录下:

mv apache-maven-3.3.3 /opt

配置环境变量:

vim /etc/profile

在末尾添加:

export MAVEN_HOME=/opt/apache-maven-3.3.3

export MAVEN_OPTS=”-Xms256m -Xmx512m”

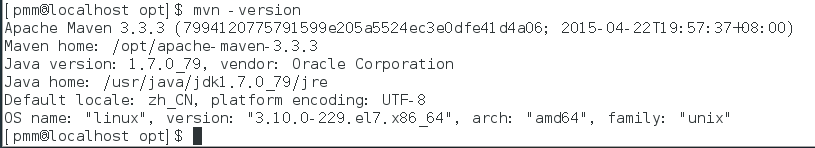

export PATH=$PATH:$MAVEN_HOME/bin<br><br> 先按 Esc, Shift+:,wq,回车即可保存并推出编辑。<br> 输入 source /etc/profile 回车即可保存更改。<br><br> 查看安装状态:mvn -version

看到

6. 安装 ant

下载 apache-ant-1.9.4-bin.tar.gz

解压缩并配置环境变量

解压:

tar -zxvf apache-ant-1.9.4-bin.tar.gz

移动到 /opt 目录下

mv apache-ant-1.9.4 /opt

配置环境变量

同上,在 /etc/profile 文件末未添加:

export ANT_HOME=/opt/apache-ant-1.9.4

export PATH=$PATH:$ANT_HOME/bin

然后保存,退出,并使更改生效。

查看安装结果:

ant -version

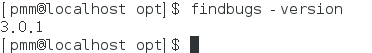

7. 安装 findbugs

下载 findbugs-3.0.1.tar.gz,选择上面的 standard version 即可

解压缩并配置环境变量

解压:

tar -zxvf findbugs-3.0.1.tar.gz

移动到 /opt 目录下

mv findbugs-3.0.1 /opt

配置环境变量:

在 /etc/profile 文件末尾添加:

export FINDBUGS_HOME=/opt/findbugs-3.0.1

export PATH=$PATH:$FINDBUGS_HOME/bin

保存退出,并使更改生效。

查看安装结果

8. 准备完成,下面开始编译 hadoop

进入到 hadoop-2.7.1-src 目录

使用命令:

mvn clean package –Pdist,native –DskipTests –Dtar

或者:

mvn package -Pdist,native -DskipTests -Dtar

进行编译。

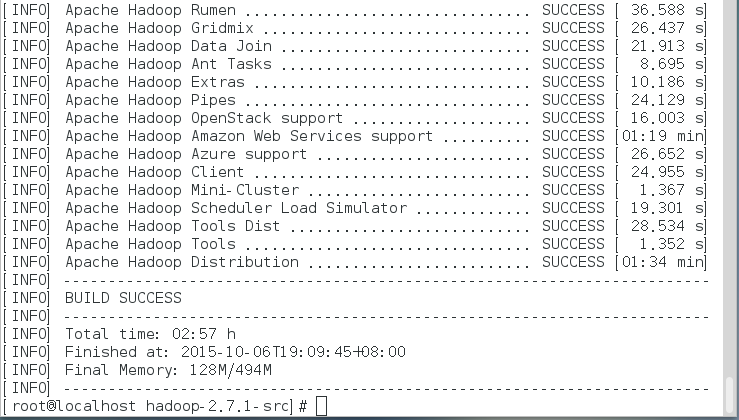

务必保持网络畅通,经过漫长的等待(本人的比较慢,花了 2 小时 57 分钟)看到下图即表明编译成功!

编译好的文件在 /hadoop-dist/target/hadoop-2.7.1.tar.gz 下。

注意事项:

1. 所有命令,建议手敲,不建议复制粘贴,以避免因为页面空格造成的不必要错误。

2. 务必保持网络畅通,如果出现缺少某个文件,则要先清理 maven(使用命令 mvn clean) 再重新编译。

3. 如果总是出现同一个错误导致编译失败,则可能是缺少某个库或者工具,检查上述工具是否都安装成功,并且版本正确。

下面关于 Hadoop 的文章您也可能喜欢,不妨看看:

Ubuntu14.04 下 Hadoop2.4.1 单机 / 伪分布式安装配置教程 http://www.linuxidc.com/Linux/2015-02/113487.htm

CentOS 安装和配置 Hadoop2.2.0 http://www.linuxidc.com/Linux/2014-01/94685.htm

Ubuntu 13.04 上搭建 Hadoop 环境 http://www.linuxidc.com/Linux/2013-06/86106.htm

Ubuntu 12.10 +Hadoop 1.2.1 版本集群配置 http://www.linuxidc.com/Linux/2013-09/90600.htm

Ubuntu 上搭建 Hadoop 环境(单机模式 + 伪分布模式)http://www.linuxidc.com/Linux/2013-01/77681.htm

Ubuntu 下 Hadoop 环境的配置 http://www.linuxidc.com/Linux/2012-11/74539.htm

单机版搭建 Hadoop 环境图文教程详解 http://www.linuxidc.com/Linux/2012-02/53927.htm

更多 Hadoop 相关信息见Hadoop 专题页面 http://www.linuxidc.com/topicnews.aspx?tid=13

本文永久更新链接地址:http://www.linuxidc.com/Linux/2015-10/123983.htm