共计 1799 个字符,预计需要花费 5 分钟才能阅读完成。

Hadoop 企业级集群架构 – NFS 安装

服务器地址:192.168.1.230

安装 NFS 软件

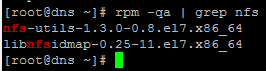

检查 nfs 是否安装完成

rpm -qa | grep nfs

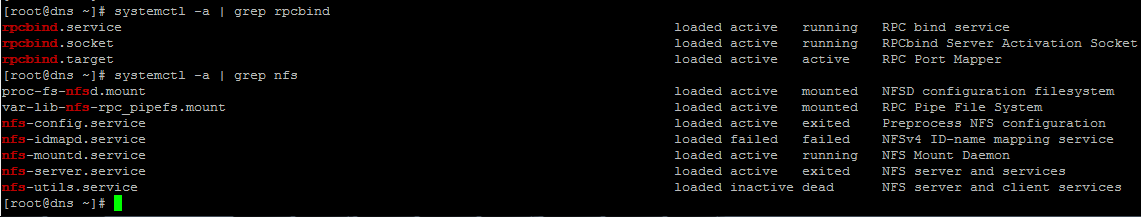

检查 rpcbind 和 nfs 服务

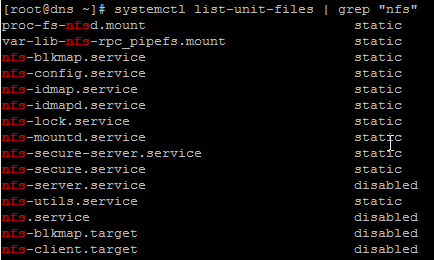

systemctl list-unit-files | grep “nfs”

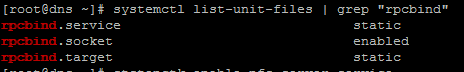

systemctl list-unit-files | grep “rpcbind”

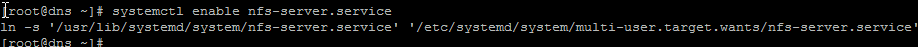

systemctl enable nfs-server.service

systemctl enable rpcbind.service

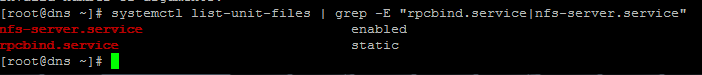

systemctl list-unit-files | grep -E “rpcbind.service|nfs-server.service”

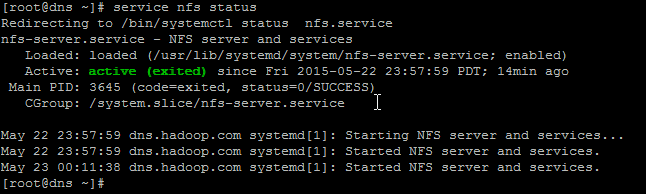

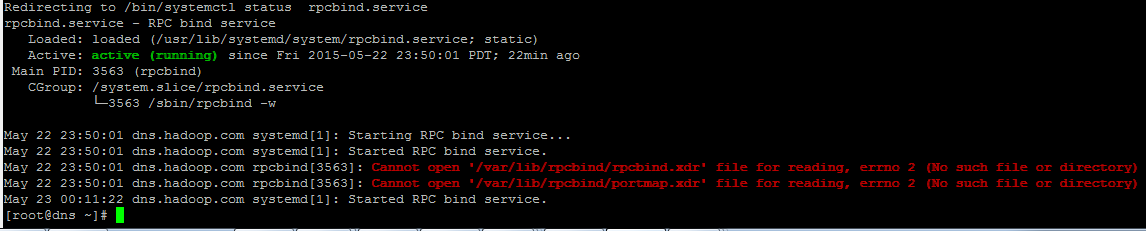

检查 NFS,RPC 状态

service rpcbind status

service rpcbind status

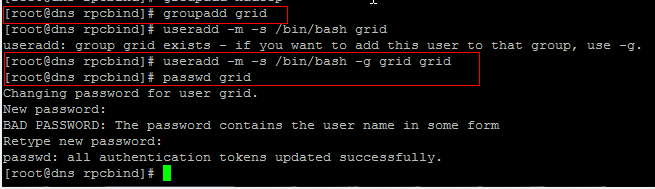

建立运行帐户:

groupadd grid

useradd -m -s /bin/bash -g grid grid

passwd grid

<grid123>

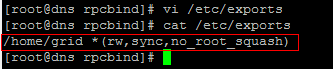

修改 /ecc/expots

添加:

/home/grid *(rw,sync,no_root_squash)

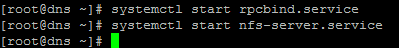

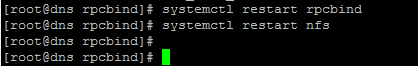

重启 rpcbind,nfs

systemctl restart rpcbind

systemctl restart nfs

验证:

showmount -e 192.168.1.230

在节点上挂载共享目录

NSF 挂载 Errror “wrong fs type,bad option

解决办法:

yum -y install nfs-utils

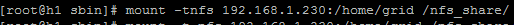

mount -t nfs 192.168.1.230:/home/grid /nfs_share/

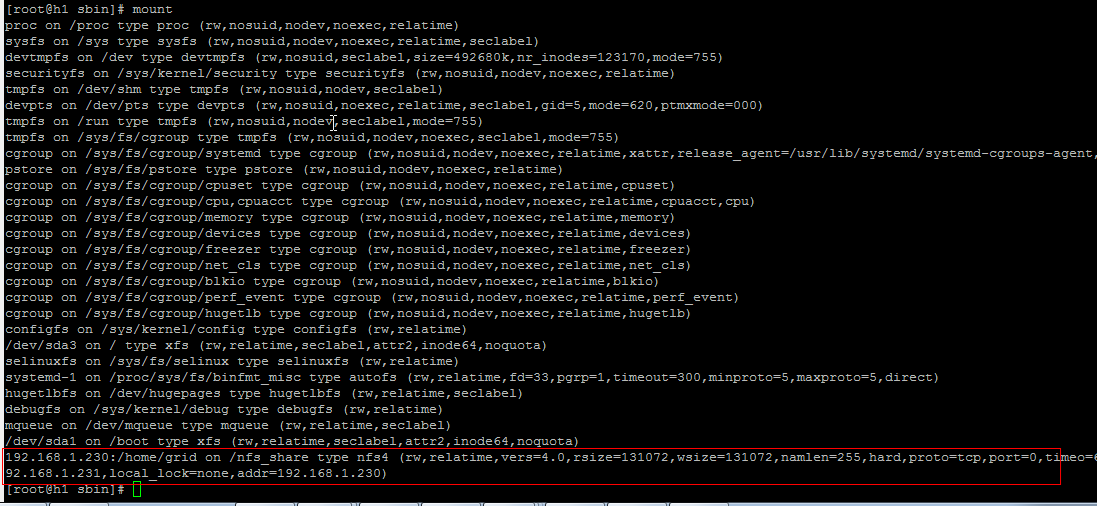

查看 mount

mount

设置开机自动挂载

vi /etc/fstab

添加如下一行:

192.168.1.230:/home/grid /nfs_share nfs defaults 0 0

在 NFS 服务器及各节点配置 SSH

将各节点的密钥加到 NFS 服务器上

ssh h1.hadoop.com cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

ssh h2.hadoop.com cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

ssh h3.hadoop.com cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

id_rsa.pub

在各节点创建共享目录文件 authorized_keys 的软连接

在各节点上安装

yum -y install nfs-utils

mkdir /nfs_share

mount -t nfs 192.168.1.230:/home/grid /nfs_share/

ln -s /nfs_share/.ssh/authorized_keys ~/.ssh/authorized_keys

下面关于 Hadoop 的文章您也可能喜欢,不妨看看:

Ubuntu14.04 下 Hadoop2.4.1 单机 / 伪分布式安装配置教程 http://www.linuxidc.com/Linux/2015-02/113487.htm

CentOS 安装和配置 Hadoop2.2.0 http://www.linuxidc.com/Linux/2014-01/94685.htm

Ubuntu 13.04 上搭建 Hadoop 环境 http://www.linuxidc.com/Linux/2013-06/86106.htm

Ubuntu 12.10 +Hadoop 1.2.1 版本集群配置 http://www.linuxidc.com/Linux/2013-09/90600.htm

Ubuntu 上搭建 Hadoop 环境(单机模式 + 伪分布模式)http://www.linuxidc.com/Linux/2013-01/77681.htm

Ubuntu 下 Hadoop 环境的配置 http://www.linuxidc.com/Linux/2012-11/74539.htm

单机版搭建 Hadoop 环境图文教程详解 http://www.linuxidc.com/Linux/2012-02/53927.htm

更多 Hadoop 相关信息见Hadoop 专题页面 http://www.linuxidc.com/topicnews.aspx?tid=13

本文永久更新链接地址:http://www.linuxidc.com/Linux/2015-11/125227.htm