共计 5136 个字符,预计需要花费 13 分钟才能阅读完成。

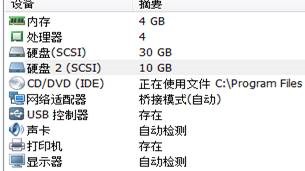

实验环境:

(1)使用 CentOS6.5 版本两台

(2)使用 163 的 yum 源(配置方法参考下方)

(3)两台虚拟机添加相同的虚拟硬盘,我采用的是 10G

操作系统 主机名 IP drbd 磁盘

CentOS6.5 local.aaa.com 192.168.1.13 /dev/sdb4

CentOS6.5 local2.aaa.com 192.168.1.12 /dev/sdb4

注意事项:

(1)配置 ip 地址如果存在 DNS 请保证虚拟机的主机名符合 FQDA,并在 DNS 上做正常解析,或者写入 hosts 文件(/etc/hosts)

(2)关闭 selinux(setenforce 0)关闭 iptables(service iptables stop)或者写入规则

一、DRBD 准备

1、yum 配置

(1)进入 yum 源配置目录 cd /etc/yum.repos.d

(2)备份系统自带的 yum 源 mv CentOS-Base.repo CentOS-Base.repo.bak

(3)下载 163 网易的 yum 源:wget http://mirrors.163.com/.help/CentOS6-Base-163.repo

(4)更改文件名 mv CentOS6-Base-163.repo CentOS-Base.repo

(5)更新玩 yum 源后,执行下边命令更新 yum 配置,使操作立即生效 yum clean all yum makecache

2、DRBD 安装

(1)首先我们要升级内核,升级之后我们重启 yum -y update kernel

yum install kernel-devel 这里请注意要加载新的内核

(2)rpm -Uvh http://www.elrepo.org/elrepo-release-6-6.el6.elrepo.noarch.rpm

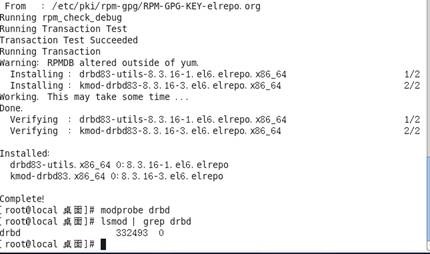

(3)安装 DRBD yum -y install drbd83-utils kmod-drbd83

(4)加载 DRBD 模块到内核 modprobe drbd

(5)检测 DRBD 是否安装成功 lsmod | grep drbd

显示信息:drbd 332493 0

(6)modprobe -l | grep -i drbd 可以查看路径

安装完成后会在 /etc/init.d/drbd 生成启动脚本

3、初始化磁盘

(1)首先使用 fdisk –l 确定你新加虚拟磁盘的盘号

(2)使用 fdisk /dev/ 盘号 进行分区不需要格式化(具体操作请参考(http://liumingyuan.blog.51cto.com/9065923/1604923)

二、DRBD 配置

(DRBD 的配置文件主要分三个比分:global、common 和 resource。在运行的时候默认读取配置文件的路径是 /etc/drbd.conf,这个文件描述了 DRBD 的一些配置参数以及设备与硬盘分区的映射关系,默认情况下是空的,不过在 DRBD 的源代码包中包含了配置文件的样例)

一般情况下 global_common.conf(本次实验文件所在目录 /etc/drbd.d/)文件仅包含 global 和 common 部分配置(理解为全局配置),在 /etc/drbd.d/*.res 的文件定义于一个资源(理解为主机定义)。

其实可以将 DRBD 配置整合到 drbd.conf 文件中,不过这样做在资源比较多的情况下会变得混乱。

(1)本次采用分布式配置首先我们来配置 /etc/drbd.d/global_common.conf

内容如下:

global {

usage-count no; #是否参加 DRBD 使用者统计,默认是参加

}

common {

syncer {rate 200M;} #主节点和备用节点同步时最大的网络速率

protocol C; #使用 DRBD 的第三种同步协议,表示收到远程主机的写入确认后认为写入完成

handlers {

pri-on-incon-degr “echo o > /proc/sysrq-trigger ;halt -f”;

pri-lost-after-sb “echo o > /proc/sysrq-trigger ;halt -f”;

local-io-error “echo o >/proc/sysrq-trigger ;halt -f”;

fence-peer “/usr/lib64/heartbeat/drbd-peer-outdater -t 5”;

pri-lost “echo pri-lost. Have a look at the log files. | mail -s ‘DRBD Alert’root”;

split-brain “/usr/lib/drbd/notify-splot-brain.sh root”;

out-of-sync “/usr/lib/drbd/notify-out-of-sync.sh root”;

}

net {#DRBD 同步时使用的验证方式和密码

cram-hmac-alg “sha1”;

shared-secret “MySQL-HA”;

}

disk {#使用 dpod 功能(drbd outdate-peer daemon)保证数据在同步时不能进行切换

on-io-error detach;

fencing resource-only;

}

startup {

wfc-timeout 120;

degr-wfc-timeout 120;

}

}

(2)其次我们在 drbd.d 目录下创建以.res 为后缀的文件,本次创建的文件是 drbd.res 目录是 /etc/drbd.d/

内容如下:

resource r0 {#定义资源名称为 r0

on local.aaa.com {#每个主机的说明以 on 开头 后面是主机名 hostname

device /dev/drbd0; #定义 DRBD 使用磁盘的逻辑路径

disk /dev/sdb4; #/dev/drbd0 使用的磁盘分区

address 192.168.1.13:7788; #设置 DRBD 的监听端口,与另一台主机通信

meta-disk internal; #DRBD 元数据存放方式 internal 内部

}

on local2.aaa.com {

device /dev/drbd0;

disk /dev/sdb4;

address 192.168.1.12:7788;

meta-disk internal;

}

}

(3)创建 haclient 组并设置权限 原因是:我们会使用 drbd-peer-outdater fence-peer 程序。使用该机制 dopd 心跳插件程序,就需要能够调用 drbdsetup 和 drbdmeta 根特权。

命令如下:

groupadd haclient

chgrp haclient /sbin/drbdsetup

chmod o-x /sbin/drbdsetup

chmod u+s /sbin/drbdsetup

chgrp haclient /sbin/drbdmeta

chmod o-x /sbin/drbdmeta

chmod u+s /sbin/drbdmeta

(4)使用 scp 将配置文件复制到另一台计算机上 scp 192.168.1.13:/etc/dbrd.d/* /etc/drbd.d/

并执行 groupadd haclient

chgrp haclient /sbin/drbdsetup

chmod o-x /sbin/drbdsetup

chmod u+s /sbin/drbdsetup

chgrp haclient /sbin/drbdmeta

chmod o-x /sbin/drbdmeta

chmod u+s /sbin/drbdmeta

(5)在启动 DBRD 之前,需要分别在两台主机上的指定分区 (这里是 sdb4) 上创建提供 DRBD 记录信息的数据块

drbdadm create-md r0(r0 表示之前定义的资源)或者执行 drbdadm create-md all

正确的提示是:

Writing meta data…

initializing activity log

NOT initialized bitmap

New drbd meta data block successfully created.

(6)在两个节点上启动 DRBD 服务 服务脚本位于 /etc/init.d/drbd

/etc/init.d/drbd start

(7)执行 cat /proc/drbd

输出内容如下

version: 8.3.16 (api:88/proto:86-97)

GIT-hash: a798fa7e274428a357657fb52f0ecf40192c1985 build by phil@Build64R6, 2014-11-24 14:51:37

0: cs:Connected ro:Secondary/Secondary ds:Inconsistent/Inconsistent C r—–

ns:0 nr:0 dw:0 dr:0 al:0 bm:0 lo:0 pe:0 ua:0 ap:0 ep:1 wo:f oos:10482024

输出解释:

ro 表示角色信息,第一次启动 DRBD 时,两个节点默认都处于 Secondary 状态

ds 表示磁盘状态信息,“nconsistent/Inconsistent”即“不一致 / 不一致”状态表示两个节点的磁盘数据不一样

ns 表示网络发送的数据包信息

dw 表示磁盘写信息

dr 表示磁盘读信息

(8)设置主用节点在默认情况下没有主用节点和备用节点之分因此需要设置两个主机的主次,选择需要设置为主用节点的主机执行以下命令

drbdsetup /dev/drbd0 primary -o 也可以执行以下命令 drbdadm — –overwrite-data-of-peer primary all

执行之后需要设置哪个主用节点就可以使用另一条命令

/sbin/drbdadm primary r0 或者 /sbin/drbdadm primary all

稍等片刻后查看 /proc/drbd

输出如下:

version: 8.3.16 (api:88/proto:86-97)

GIT-hash: a798fa7e274428a357657fb52f0ecf40192c1985 build by phil@Build64R6, 2014-11-24 14:51:37

0: cs:Connected ro:Primary/Secondary ds:UpToDate/UpToDate C r—–

ns:10482024 nr:0 dw:0 dr:10482696 al:0 bm:640 lo:0 pe:0 ua:0 ap:0 ep:1 wo:f oos:0

ro 的状态变成 Primary/Secondary

ds 状态也变成 UpToDate/UpToDate 表示实时同步

(9)挂载 DRBD 设备在主节点上挂载以下操作

mkfs.ext4 /dev/drbd0

mount /dev/drbd0 /mnt (这里是挂载到 mnt 下根据需要自行挂载)

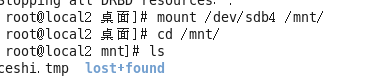

(10)测试 DRBD 数据镜像

在主节点的挂载点 /mnt 下创建一个文件

dd if=/dev/zero of=/mnt/ceshi.tmp bs=10M count=20

完成后接着查看备用主机上的文件是否同步过去了

首先先停止 DRBD 服务,为了保证数据的一致性

/etc/init.d/drbd stop

mount /dev/sdb4 /mnt(这里挂载是 /dev/sdb4 物理分区,因为 DRBD 在启动的时候才会加载 DRBD 设备到系统中)

ls /mnt 即可查看到文件

检查完成后 umount 卸载挂载点后在开启服务

有关 DRBD 的相关知识,可以参考:

DRBD 原理及特性概述 http://www.linuxidc.com/Linux/2015-11/124759.htm

快速安装及部署 DRBD http://www.linuxidc.com/Linux/2015-11/124760.htm

Linux 高可用(HA)集群之 DRBD 详解 http://www.linuxidc.com/Linux/2013-08/89035.htm

DRBD 中文应用指南 PDF http://www.linuxidc.com/Linux/2013-08/89034.htm

CentOS 6.3 下 DRBD 安装配置笔记 http://www.linuxidc.com/Linux/2013-06/85600.htm

基于 DRBD+Corosync 实现高可用 MySQL http://www.linuxidc.com/Linux/2013-05/84471.htm

CentOS 6.4 下 DRBD 安装配置 http://www.linuxidc.com/Linux/2013-09/90536.htm

DRBD 的详细介绍:请点这里

DRBD 的下载地址:请点这里

本文永久更新链接地址:http://www.linuxidc.com/Linux/2015-11/125332.htm