共计 1839 个字符,预计需要花费 5 分钟才能阅读完成。

分享我的 Hadoop2.7.2 完全分布式环境搭建过程。

服务器:

用户:hadoop

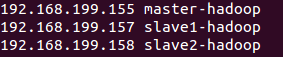

| ip | 机器名 | 系统 |

| 192.168.199.155 | master-hadoop | Ubuntu desktop 15 |

| 192.168.199.157 | slave1-hadoop | ubuntu desktop 15 |

| 192.168.199.158 | slave2-hadoop | ubuntu desktop 15 |

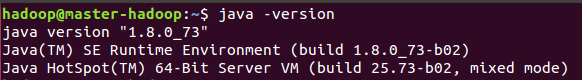

java:

版本:1.8.0_73

路径:/usr/local/jdk

hadoop:

- 版本:2.7.2

- 路径:/usr/local/hadoop

——————————————————————————–

开始部署

以下部署动作全部在 master 上执行,slave1 和 slave2 通过虚拟机克隆的方式生成。

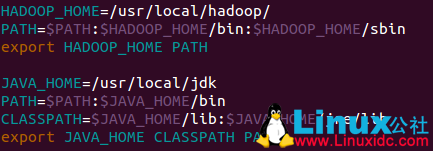

设置系统环境变量,编辑 /etc/profile,末尾添加:

修改 hosts, 编辑 /etc/hosts,末尾添加:

配置 ssh 免密登陆

[hadoop@master-hadoop ~]$ ssh-keygen -t rsa

[hadoop@slave1-hadoop ~]$ cd/home/hadoop/.ssh/

[hadoop@slave1-hadoop .ssh]$ cat id_rsa.pub >> authorized_keys

[hadoop@slave1-hadoop .ssh]$ chmod 600 authorized_keys

[hadoop@slave1-hadoop .ssh]$ chmod 700 ../.ssh/

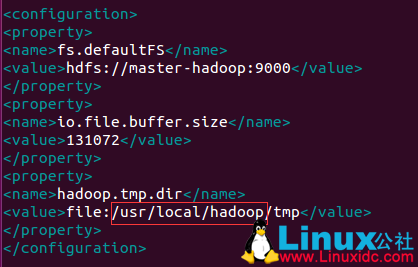

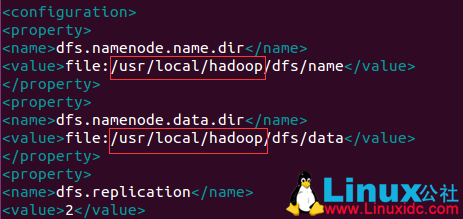

修改 hadoop 配置文件(core-site.xml 和 hdfs-site.xml 文件中根据 hadoop 路径修改节点内容)

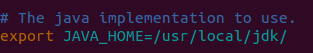

hadoop-env.sh

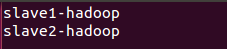

slaves

core-site.xml

hdfs-site.xml

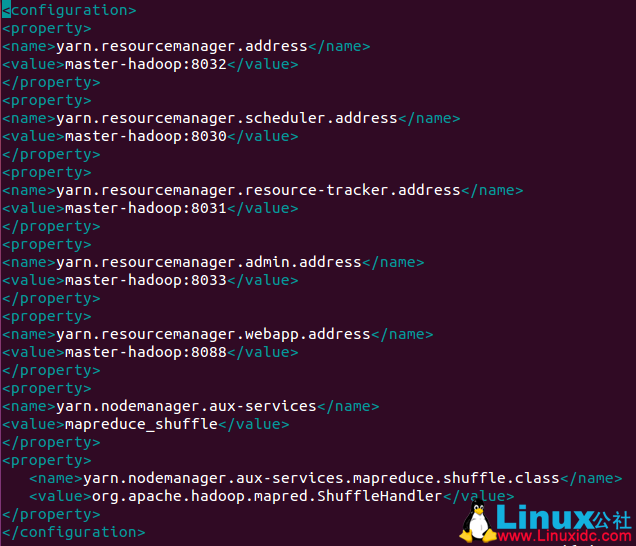

yarn-site.xml

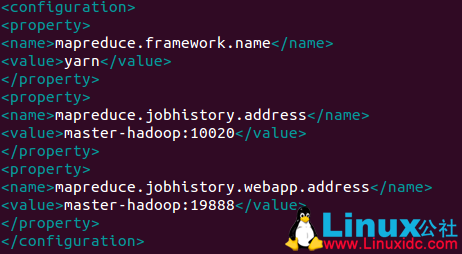

mapred-site.xml

克隆虚拟机,生成 slave 节点(vmware 克隆后网卡 mac 要重新生成,然后在 ubuntu 网络设置里重新设置 mac 地址)

1. 修改机器名,编辑 /etc/hostname,文件内容改为 slave1|slave2 后重启系统。

2. 在 master 上 ssh 连接 slave1 和 slave2,测试免密码登陆是否成功,执行

ssh slave1-hadoop

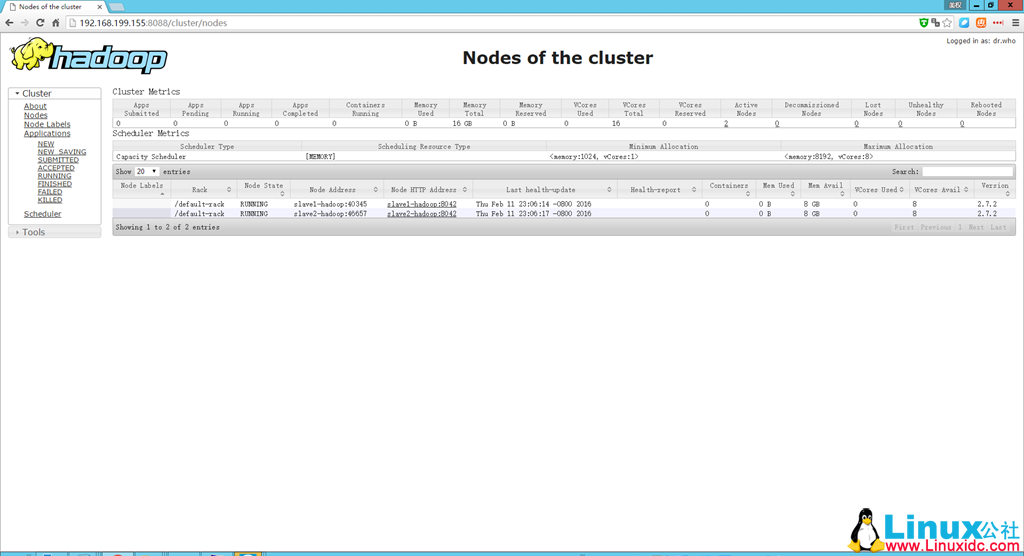

3. 在 master 上启动 hadoop, 执行

start-all.sh

注意事项:

1.hadoop 用户必须有 /usr/local/hadoop 文件夹读写权限

2.ssh 登陆提示 The authenticity of host can’t be established,修改 /etc/ssh/ssh_config 文件的配置,最后面添加:

StrictHostKeyChecking no

UserKnownHostsFile /dev/null

下面关于 Hadoop 的文章您也可能喜欢,不妨看看:

Ubuntu14.04 下 Hadoop2.4.1 单机 / 伪分布式安装配置教程 http://www.linuxidc.com/Linux/2015-02/113487.htm

CentOS 安装和配置 Hadoop2.2.0 http://www.linuxidc.com/Linux/2014-01/94685.htm

Ubuntu 13.04 上搭建 Hadoop 环境 http://www.linuxidc.com/Linux/2013-06/86106.htm

Ubuntu 12.10 +Hadoop 1.2.1 版本集群配置 http://www.linuxidc.com/Linux/2013-09/90600.htm

Ubuntu 上搭建 Hadoop 环境(单机模式 + 伪分布模式)http://www.linuxidc.com/Linux/2013-01/77681.htm

Ubuntu 下 Hadoop 环境的配置 http://www.linuxidc.com/Linux/2012-11/74539.htm

单机版搭建 Hadoop 环境图文教程详解 http://www.linuxidc.com/Linux/2012-02/53927.htm

更多 Hadoop 相关信息见Hadoop 专题页面 http://www.linuxidc.com/topicnews.aspx?tid=13

本文永久更新链接地址:http://www.linuxidc.com/Linux/2016-02/128729.htm