共计 1454 个字符,预计需要花费 4 分钟才能阅读完成。

要求:Hadoop-2.0.0-cdh4.1.2 升级到 hadoop-2.7.2

升级前准备:

配置好新的 hadoop-2.7.2 到各个集群服务器上

配置好新的环境变量备用

开始升级:

1. 停止 hive、hbase、zookeeper 等相关服务

2. 检查文件(如果文件太多太费时间可以不做)

hadoop dfsadmin -safemode enter

检查元数据块(过滤所有以小圆点开始的行):

hadoop fsck / -files -blocks -locations |grep -v -E ‘^\.’ > old-fsck.log

hadoop dfsadmin -safemode leave

3. 停止 hadoop 集群

$HADOOP_HOME/bin/stop-all.sh

4. 修改环境变量

source /etc/profile 各个集群都执行

echo $HADOOP_HOME 看是否是新的 hadoop 目录了

5. 开始升级

hadoop-daemon.sh start namenode -upgrade 启动 namenode 升级

hadoop-daemons.sh start datanode 启动各个数据节点

打开日志文件观察有误错误,如果报内存溢出,修改 hadoop-env.sh 文件的 export HADOOP_HEAPSIZE,HADOOP_CLIENT_OPTS 参数值和 yarn-env.sh 文件 JAVA_HEAP_MAX 参数值

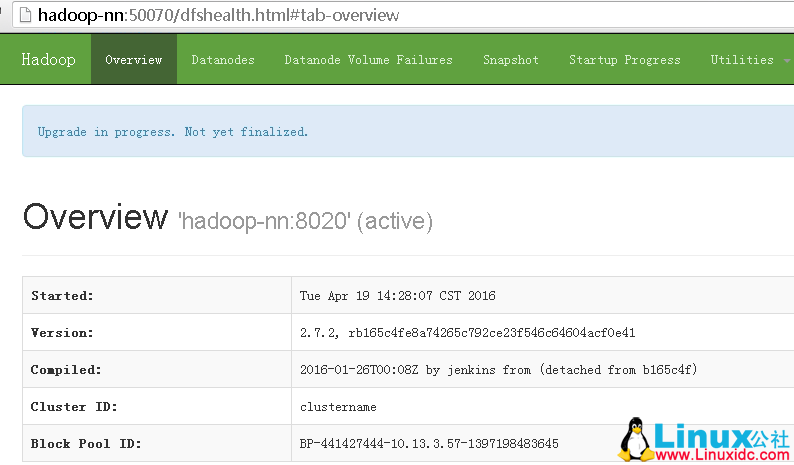

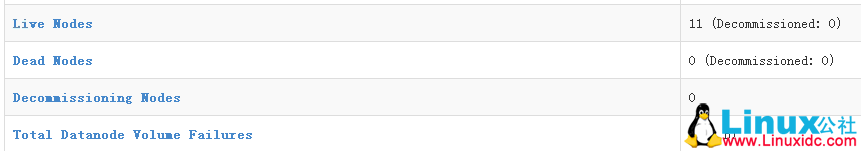

打开 50070 端口 web 页面观察升级过程

等所有数据节点全部升级完成后,检查数据完整性(此过程根据集群数量得等一段时间)

hadoop fsck /

有问题回滚命令:

hadoop-daemon.sh start namenode -rollback

hadoop-daemons.sh start datanode –rollback

6. 提交升级

运行一段时间后,观察没有问题,可以提交升级

hdfs dfsadmin -finalizeUpgrade

下面关于 Hadoop 的文章您也可能喜欢,不妨看看:

Ubuntu14.04 下 Hadoop2.4.1 单机 / 伪分布式安装配置教程 http://www.linuxidc.com/Linux/2015-02/113487.htm

CentOS 安装和配置 Hadoop2.2.0 http://www.linuxidc.com/Linux/2014-01/94685.htm

Ubuntu 13.04 上搭建 Hadoop 环境 http://www.linuxidc.com/Linux/2013-06/86106.htm

Ubuntu 12.10 +Hadoop 1.2.1 版本集群配置 http://www.linuxidc.com/Linux/2013-09/90600.htm

Ubuntu 上搭建 Hadoop 环境(单机模式 + 伪分布模式)http://www.linuxidc.com/Linux/2013-01/77681.htm

Ubuntu 下 Hadoop 环境的配置 http://www.linuxidc.com/Linux/2012-11/74539.htm

单机版搭建 Hadoop 环境图文教程详解 http://www.linuxidc.com/Linux/2012-02/53927.htm

更多 Hadoop 相关信息见Hadoop 专题页面 http://www.linuxidc.com/topicnews.aspx?tid=13

本文永久更新链接地址:http://www.linuxidc.com/Linux/2016-04/130407.htm