共计 1101 个字符,预计需要花费 3 分钟才能阅读完成。

集群安装完毕,该如何测试和使用集群:

运行 Hadoop 首先进入 hadoop 所在目录,第一次执行要格式化文件系统 bin/hadoop namenode –format

启动 bin/start-all.sh

用 jps 命令查看进程,显示:

root@Ubuntu:/usr/hadoop/hadoop-1# jps

6449 DataNode

6998 TaskTracker

33851 Jps

6200 NameNode

6765 JobTracker

6683 SecondaryNameNode

少一个都不对

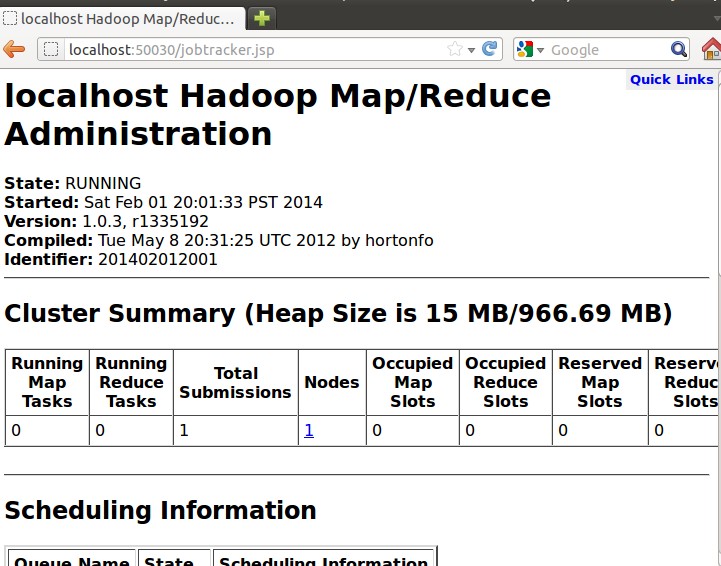

还有就是使用 web 接口访问

http://localhost:50030

可以查看 JobTracker 的运行状态

http://localhost:50060

可以查看 TaskTracker 的运行状态

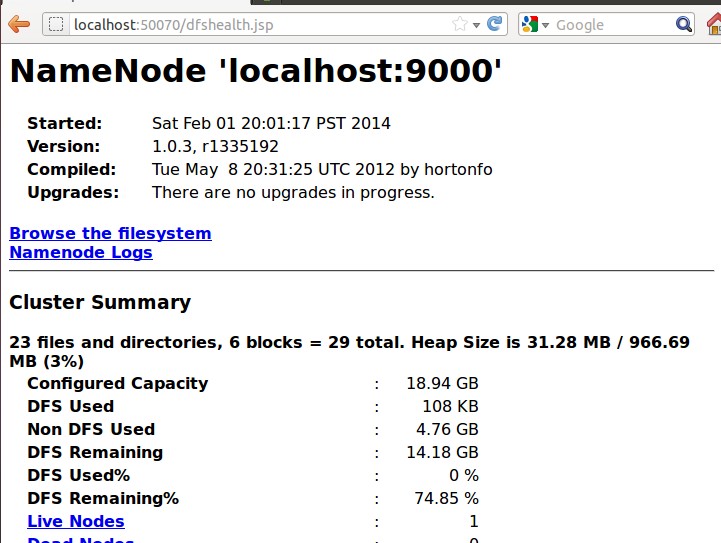

http://localhost:50070

可以查看 NameNode 以及整个分布式文件系统的状态,浏览分布式文件系统中的文件以及 log 等。

运行测试实例 wordcount

注意:1. 注意 wordcount 大小写,这里都是小写

2. 复制命令可能会出现命令不识别,尽量手写

copyFromLocal: Unknown command

Usage: Java FsShell

[-ls <path>]

…….

[-help [cmd]]

这里使用附带 jar 包里的 wordcount

(1)先在本地磁盘建立两个输入文件 file01 和 file02:

$ echo “Hello World Bye World” > file01

$ echo “Hello Hadoop Goodbye Hadoop” > file02

(2)在 hdfs 中建立一个 input 目录:

$ hadoop fs –mkdir input

(3)将 file01 和 file02 拷贝到 hdfs 中:

$ hadoop fs –copyFromLocal file0* input

(4)执行 wordcount:

$ hadoop jar hadoop-examples-1.2.0.jar wordcount input output

(5)完成之后,查看结果:

$ bin/hadoop fs -ls . 查看已有的文件列表

$ hadoop fs -cat output/part-r-00000 查看结果

结果为:可见把单词都统计了

Bye 1

Goodbye 1

Hadoop 2

Hello 2

World 2

更多 Ubuntu 相关信息见Ubuntu 专题页面 http://www.linuxidc.com/topicnews.aspx?tid=2

本文永久更新链接地址:http://www.linuxidc.com/Linux/2016-06/132220.htm