共计 18348 个字符,预计需要花费 46 分钟才能阅读完成。

这段时间一直在安装 CDH,安装第三次,终于成功了。第一次问题很多,后面卸载了,由于没有卸载干净导致第二次安装失败。后来索性重装系统了,直接使用了纯净系统进行安装。一个人跑到学院机房去装系统,苦逼惨了。

,不扯了,记录下安装流程。

系统环境

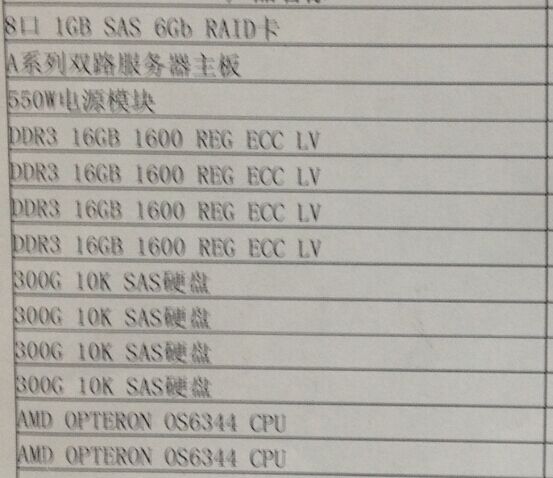

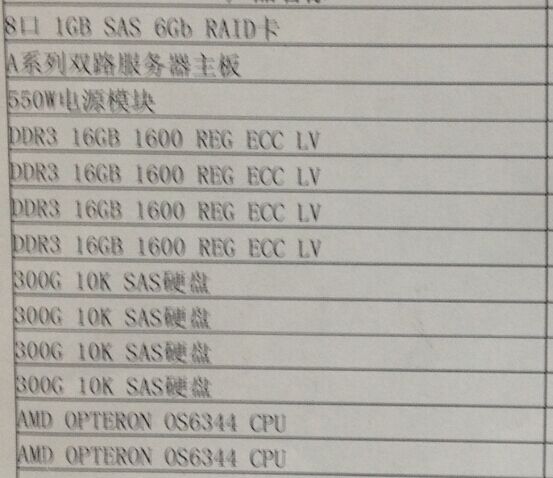

操作系统:CentOS 6.5 x64,配置如下:

Cloudera Manager:5.3.4 CDH: 5.3.4

前期准备工作(系统环境搭建)

所需软件 cloudera-manager-el6-cm5.3.4_x86_64.tar.gz、mysql-connector-Java-5.1.25-bin.jar

1、设置静态 IP 地址

vi /etc/sysconfig/network-scripts/ifcfg-eth0

2、修改主机名

hostname 主机名(当前生效)

vi /etc/sysconfig/network(下次启动生效)

[root@Hadoop2 opt]# cat /etc/sysconfig/network

NETWORKING=yes

HOSTNAME=hadoop2

GATEWAY=172.23.253.1

NTPSERVERARGS=iburst

3、绑定 IP 与 HostName

vi /etc/hosts

172.23.253.20 hadoop1

172.23.253.22 hadoop2

172.23.253.23 hadoop3

172.23.253.24 hadoop4

172.23.253.25 hadoop5

172.23.253.26 hadoop6

复制到其它节点(hadoop2~hadoop6)

scp /etc/hosts hadoop2:/etc/

scp /etc/hosts hadoop6:/etc/

4、设置 SSH 免密码登录(所有节点)

[root@hadoop1 /]# cd /root/.ssh/

[root@hadoop1 .ssh]# ssh-keygen -t rsa

[root@hadoop1 .ssh]# cat id_rsa.pub >> authorized_keys

其他其它节点同样的方式生成密钥。

hadoop2~hadoop6 将自己的公钥复制给对方主机

ssh-copy-id -i hadoop1

hadoop1 复制自己的 authorized_keys 给其他主机 hadoop2~hadoop6,这样都可以互相免密码登录了。

scp /root/.ssh/authorized_keys hadoop2:/root/.ssh/

scp /root/.ssh/authorized_keys hadoop6:/root/.ssh/

5、安装 Oracle 的 Java

首先,卸载自带的 OpenJdk,使用 rpm -qa | grep java 查询 java 相关的包,使用 rpm -e –nodeps 包名卸载掉。

由于是 rpm 包并不需要我们来配置环境变量,我们只需要配置一个全局的 JAVA_HOME 变量即可,执行命令:

echo “JAVA_HOME=/usr/java/latest/” >> /etc/environment

执行命令 java -version 和 javac -version,查看 Jdk 是否安装正确。

[root@hadoop1 .ssh]# rpm -qa | grep java

java-1.7.0-openjdk-1.7.0.45-2.4.3.3.el6.x86_64

tzdata-java-2013g-1.el6.noarch

java-1.6.0-openjdk-1.6.0.0-1.66.1.13.0.el6.x86_64

[root@hadoop1 .ssh]# rpm -e –nodeps java-1.7.0-openjdk-1.7.0.45-2.4.3.3.el6.x86_64

tzdata-java-2013g-1.el6.noarch java-1.6.0-openjdk-1.6.0.0-1.66.1.13.0.el6.x86_64

2、安装 Oracle 的 JDK(所有节点)

[root@hadoop1 opt]# rpm -ivh jdk-7u80-linux-x64.rpm

Preparing… ########################################### [100%]

1:jdk ########################################### [100%]

Unpacking JAR files…

rt.jar…

jsse.jar…

charsets.jar…

tools.jar…

localedata.jar…

jfxrt.jar…

[root@hadoop1 opt]# echo “JAVA_HOME=/usr/java/latest/” >> /etc/environment

[root@hadoop1 opt]# java -version

java version “1.7.0_80”

Java(TM) SE Runtime Environment (build 1.7.0_80-b15)

Java HotSpot(TM) 64-Bit Server VM (build 24.80-b11, mixed mode)

[root@hadoop1 opt]# javac -version

javac 1.7.0_80

6、安装和配置 MySql(主节点)

设置开机启动 chkconfig mysqld on,

并启动 mysql 服务 service mysqld start,

并根据提示设置 root 的初始密码:mysqladmin -u root password ‘xxxx’。

[root@hadoop1 opt]# yum install mysql-server

[root@hadoop1 opt]# chkconfig mysqld on

[root@hadoop1 opt]# service mysqld start

[root@hadoop1 opt]# service mysqld status

[root@hadoop1 opt]# mysqladmin -u root password ‘liguodong’

进入 mysql 命令行 mysql -uroot -pxxxx,创建以下数据库:

[root@hadoop1 opt]# mysql -uroot -pliguodong

mysql> create database hive DEFAULT CHARSET utf8 COLLATE utf8_general_ci;

Query OK, 1 row affected (0.00 sec)

mysql> create database amon DEFAULT CHARSET utf8 COLLATE utf8_general_ci;

Query OK, 1 row affected (0.00 sec)

mysql> create database hue DEFAULT CHARSET utf8 COLLATE utf8_general_ci;

Query OK, 1 row affected (0.00 sec)

设置 root 授权访问以上所有的数据库。

mysql> grant all privileges on *.* to ‘root’@’hadoop1’ identified by ‘liguodong’ with grant option;

Query OK, 0 rows affected (0.00 sec)

mysql> flush privileges;

Query OK, 0 rows affected (0.00 sec)

http://www.cloudera.com/content/cloudera/en/documentation/core/latest/topics/cm_ig_mysql.html#cmig_topic_5_5

7、关闭防火墙和 SELinux(所有节点)

关闭防火墙:

service iptables stop(临时关闭)

chkconfig iptables off(重启后生效)

(实际安装过程中发现没有关闭也是可以的,不知道会不会有问题,还需进一步进行验证)

setenforce 0(临时生效)

修改 /etc/selinux/config 下的 SELINUX=disabled(重启后永久生效)

[root@hadoop1 opt]# service iptables stop

iptables:将链设置为政策 ACCEPT:filter [确定]

iptables:清除防火墙规则:[确定]

iptables:正在卸载模块:[确定]

[root@hadoop1 opt]# chkconfig iptables off

[root@hadoop1 opt]# setenforce 0

[root@hadoop1 opt]# vi /etc/selinux/config

[root@hadoop1 opt]# cat /etc/selinux//config

SELINUXTYPE=targeted

SELINUX=disabled

8、安装和配置 NTP 服务(所有节点)

具体思路如下:

master 节点作为 ntp 服务器与外界对时中心同步时间,随后对所有 datanode 节点提供时间同步服务。所有 datanode 节点以 master 节点为基础同步时间。

所有节点安装相关组件:yum install ntp。

完成后,配置开机启动:chkconfig ntpd on,

检查是否设置成功:chkconfig –list ntpd,其中 2 - 5 为 on 状态就代表成功。

[root@hadoop1 opt]# yum install ntp

[root@hadoop1 opt]# chkconfig ntpd on

[root@hadoop1 opt]# chkconfig –list ntpd

ntpd 0: 关闭 1: 关闭 2: 启用 3: 启用 4: 启用 5: 启用 6: 关闭

配置内网 NTP 服务器(主节点)

# ntpdate -u 202.112.10.36

22 Dec 16:52:38 ntpdate[6400]: adjust time server 202.112.10.36 offset 0.012135 sec

ntp 服务只有一个配置文件,配置好就可以。这里只给出有用的配置,不需要的配置都用 #注掉,这里就不在给出。

[root@hadoop1 opt]# vi /etc/ntp.conf

[root@hadoop1 opt]# cat /etc/ntp.conf

driftfile /var/lib/ntp/drift

restrict 127.0.0.1

restrict -6 ::1

restrict default nomodify notrap

server 202.112.10.36 prefer

includefile /etc/ntp/crypto/pw

keys /etc/ntp/keys

[root@hadoop1 opt]# service ntpd start

检查是否成功,用 ntpstat 命令查看同步状态,出现以下状态代表启动成功:

[root@hadoop1 ~]# ntpstat

synchronised to NTP server (202.112.10.36) at stratum 3

time correct to within 133 ms

polling server every 1024 s

配置 ntp 客户端(hadoop2~hadoop6)

driftfile /var/lib/ntp/drift

restrict 127.0.0.1

restrict -6 ::1

restrict default kod nomodify notrap nopeer noquery

restrict -6 default kod nomodify notrap nopeer noquery

# 这里是主节点 (内网 NTP 服务器) 的主机名或者 ip

server hadoop1

includefile /etc/ntp/crypto/pw

keys /etc/ntp/keys

这里可能出现同步失败的情况,请不要着急,一般是本��的 ntp 服务器还没有正常启动,一般需要等待 5 -10 分钟才可以正常同步。

启动服务:service ntpd start

[root@hadoop2 ~]# ntpdate -u hadoop1

27 Jun 08:14:38 ntpdate[1899]: adjust time server 172.23.253.20 offset 0.000293 sec

[root@hadoop2 ~]# service ntpd start

[root@hadoop2 ~]# chkconfig ntpd on

安装与配置 Cloudera Manager Server 和 AgentServer 配置(主节点)

根据自己的系统选择相应的版本,本次安装选用的是 cloudera-manager-el6-cm5.3.4_x86_64.tar.gz,下载完成后只上传到主节点即可。

然后解压到 /opt 目录下,不能解压到其它地方。

因为 cdh5 的源会默认在 /opt/cloudera/parcel-repo 寻找,怎么制作 cdh5 的本地源文件会在之后介绍。

[root@hadoop1 opt]# tar -zxvf cloudera-manager-el6-cm5.3.4_x86_64.tar.gz

给所有节点添加 cloudera-scm 用户:

[root@hadoop1 lib]# useradd –system –home=/opt/cm-5.3.4/run/cloudera-scm-server/ –no-create-home –shell=/bin/false

–comment “Cloudera SCM User” cloudera-scm

因为我们用的是 Mysql 数据库,所以我们需要下载 Mysql 的 JDBC 驱动,本次从官网上下载的版本是:mysql-connector-java-5.1.25-bin.jar 放到 /opt/cm-5.3.4/share/cmf/lib/ 目录下。

[root@hadoop1 opt]# mv mysql-connector-java-5.1.25-bin.jar /opt/cm-5.3.4/share/cmf/lib/

[root@hadoop1 opt]#/opt/cm-5.3.4/share/cmf/schema/scm_prepare_database.sh mysql

cm -hlocalhost -uroot -pliguodong –scm-host localhost scm scm scm

[root@hadoop1 lib]# /opt/cm-5.3.4/etc/init.d/cloudera-scm-server start

server 首次启动不要立即关闭或重启,因为首次启动会自动创建相关表以及数据,

如果因为特殊原因中途退出,请先删除所有表以及数据之后再次启动,否则将会出现启动不成功的情况。

Agent 配置(所有节点)

[root@hadoop1 lib]# vi /opt/cm-5.3.4/etc/cloudera-scm-agent/config.ini

server_host=hadoop1

先复制 /opt/cm-5.3.4 到 hadoop2~hadoop6 节点上,

scp -r /opt/cm-5.3.4 hadoop2:/opt/

···

scp -r /opt/cm-5.3.4 hadoop6:/opt/

等待拷贝成功,在所有节点上启动 Agent:(注意必须以管理员权限启动)

[root@hadoop1 lib]# /opt/cm-5.3.4/etc/init.d/cloudera-scm-agent start

更多详情见请继续阅读下一页的精彩内容:http://www.linuxidc.com/Linux/2016-07/133359p2.htm

Cloudera Manager Server 和 Agent 所有后发先至。也能够进行 CDH5 的安装和配置。

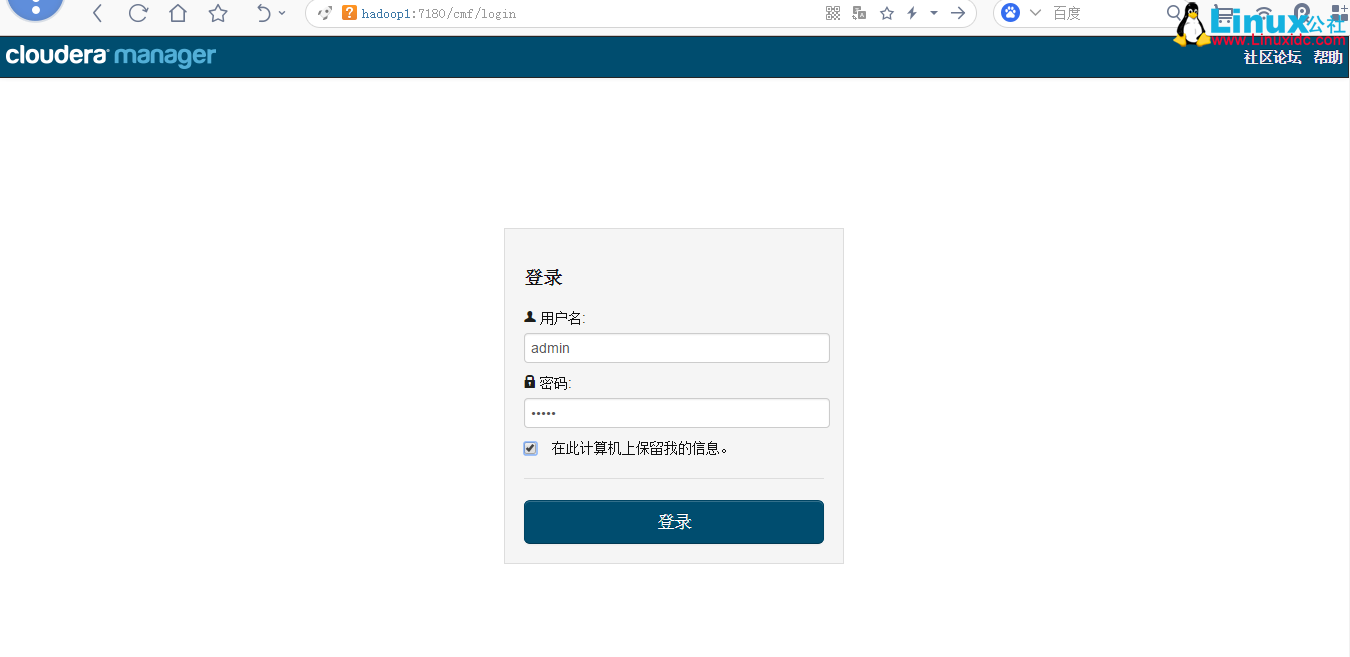

然后,主节点可以通过浏览器访问 7180port 测试(因为 CM Server 需要花时间来启动,可能要等待一会才干訪问),默认的 username 和 password 均为 admin。

制作本地源

先下载 CDH 到本地 http://archive-primary.cloudera.com/cdh5/parcels/5.3.4/,

这里须要下载三样东西。

首先是与自己系统版本号相相应的 parcel 包,然后是 manifest.json 文件。

CDH-5.2.0-1.cdh5.2.0.p0.12-el6.parcel、CDH-5.2.0-1.cdh5.2.0.p0.12-el6.parcel.sha1、manifest.json下载完毕后。将这两个文件放到 master 节点的 /opt/cloudera/parcel-repo 下(文件夹在安装 Cloudera Manager 5 时已经生成),注意文件夹一个字都不能错。

[root@Hadoop1 parcel-repo]# pwd

/opt/cloudera/parcel-repo

[root@hadoop1 parcel-repo]# ll

总用量 1533188

-rw-r-----. 1 root root 1569930781 6月 27 11:49 CDH-5.3.4-1.cdh5.3.4.p0.4-el6.parcel

-rw-r--r--. 1 root root 41 6月 27 11:49 CDH-5.3.4-1.cdh5.3.4.p0.4-el6.parcel.sha

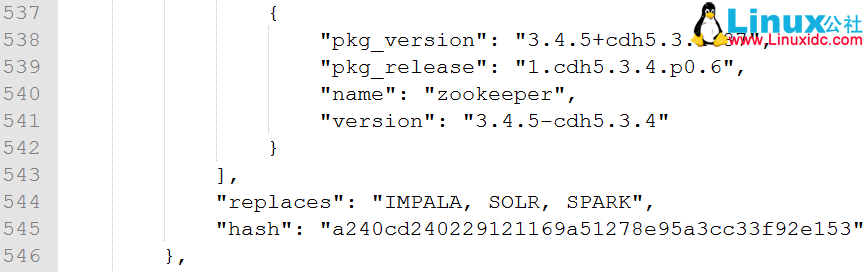

-rw-r--r--. 1 root root 42475 6月 27 10:18 manifest.json接下来打开 manifest.json 文件。里面是 json 格式的配置。我们须要的就是与我们系统版本号相相应的 hash 码。因为我们用的是 CentOS6.5,所以找到例如以下位置:

在这个大括号的最下面找到“hash”所相应的值。

将“hash”的值复制下来,然后,将 CDH-5.2.0-1.cdh5.2.0.p0.12-el6.parcel.sha1 文件名称改为 CDH-5.2.0-1.cdh5.2.0.p0.12-el6.parcel.sha。将复制下来的 hash 值替换掉文本中的 hash 值,按理说应该是一致的。保存好了,这样。我们的本地源制作完毕了。

然后的操作就是控制台依照步骤安装就可以。

安装 CDH

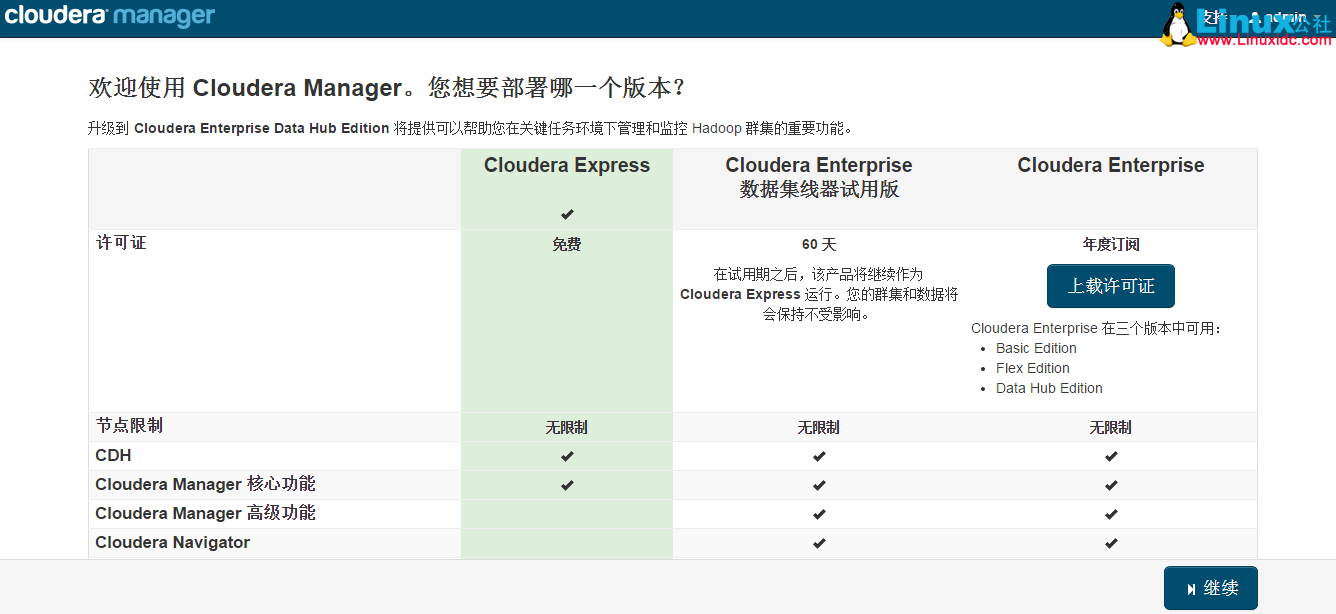

打开 http://hadoop1:7180。登陆控制台,默认账户和 password 都是 admin,安装时选择免费版,之后因为 cm5 对中文的支持非常强大,依照提示安装就可以,假设系统配置有什么问题在安装过程中会有提示,依据提示给系统安装组件就能够了。

登录界面

选取安装版本号

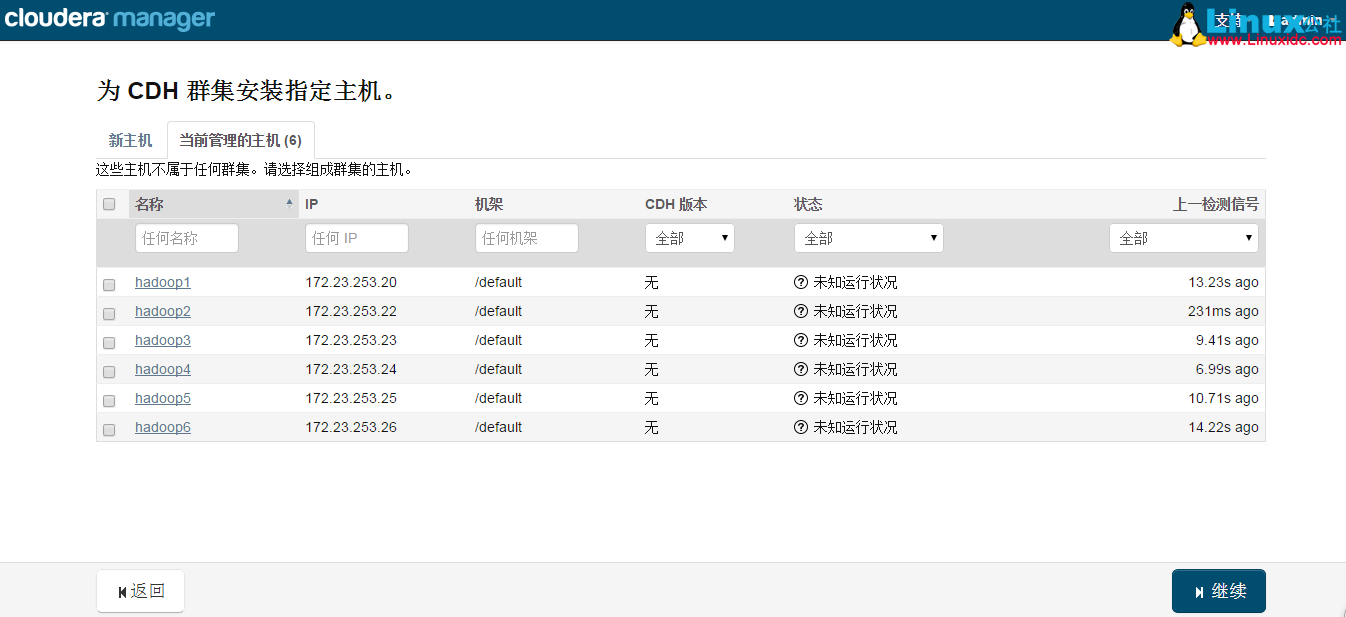

指定安装主机

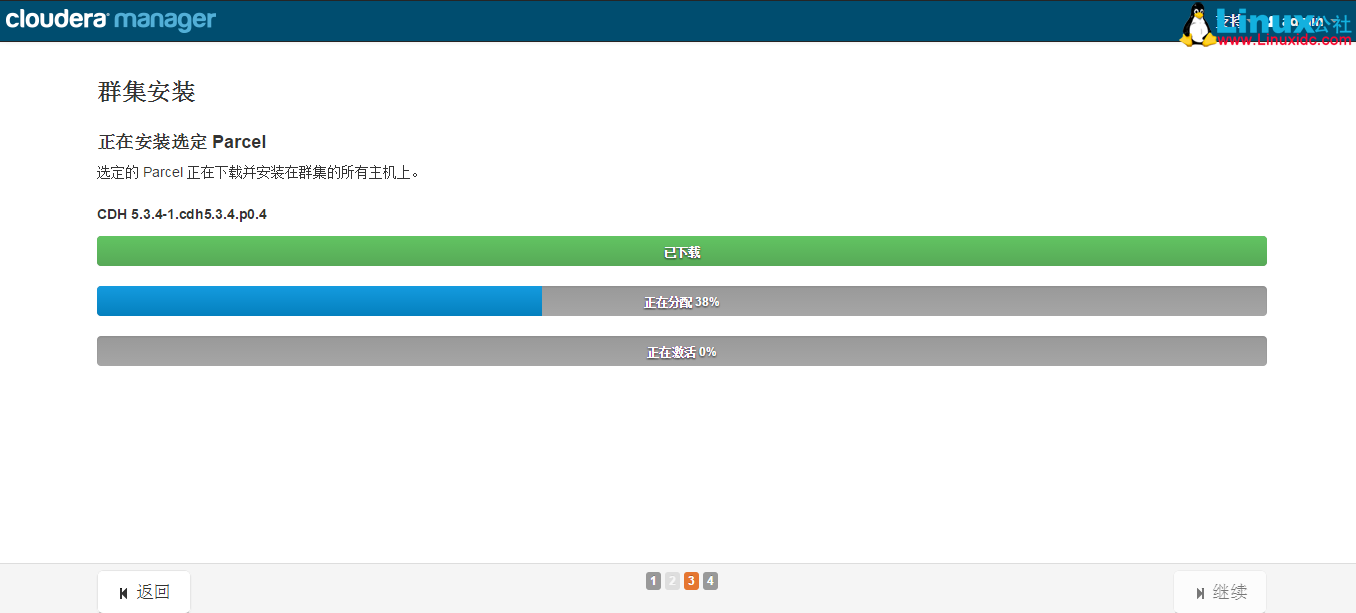

选取本地 Parcel 包

接下来,出现下面包名。说明本地 Parcel 包配置无误,直接点继续就能够了。

集群安装

检查主机正确性

接下来是 server 检查。可能会遇到下面问题:

Cloudera 建议将 /proc/sys/vm/swappiness 设置为 0。当前设置为 60。使用 sysctl 命令在执行时更改该设置并编辑 /etc/sysctl.conf 以在重新启动后保存该设置。您能够继续进行安装,但可能会遇到问题。Cloudera Manager 报告您的主机因为交换执行状况不佳。下面主机受到影响:···

- 1

- 2

- 3

在会受到影响的主机上执行 echo 0 > /proc/sys/vm/swappiness 命令就可以解决。

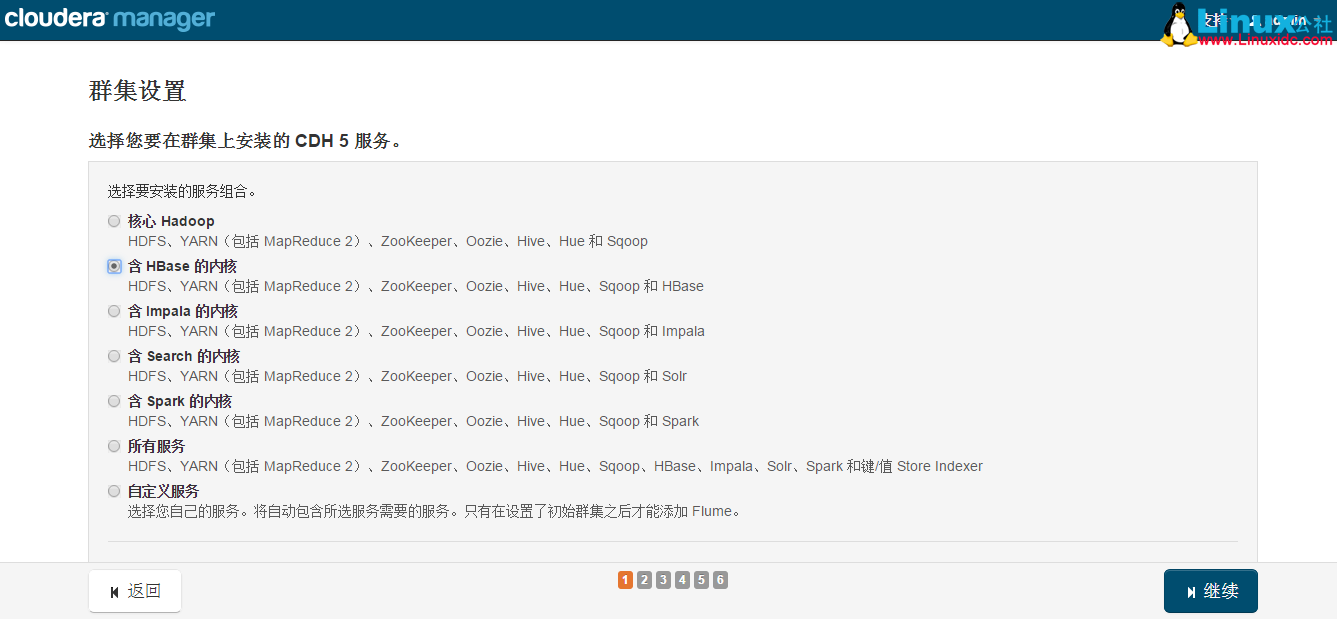

选择安装服务

集群角色分配

普通情况下保持默认就能够了(Cloudera Manager 会依据机器的配置自己主动进行配置,假设须要特殊调整,自行进行设置就能够了)。

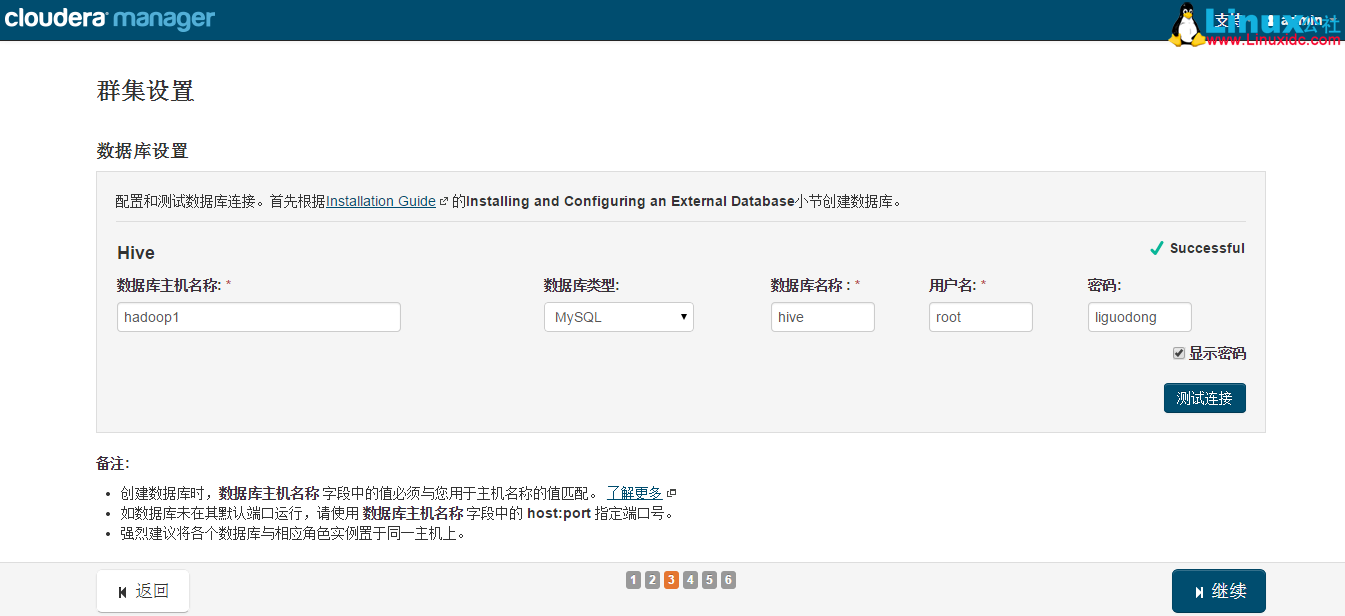

集群数据库设置

集群审查更改

假设没有其它需求保持默认配置。

最终到安装各个服务的地方了。

注意,这里安装 Hive 的时候可能会报错,因为我们使用了 MySql 作为 hive 的元数据存储。hive 默认没有带 mysql 的驱动。通过下面命令拷贝一个就可以了:

cp /opt/cm-5.3.4/share/cmf/lib/mysql-connector-Java-5.1.25-bin.jar

/opt/cloudera/parcels/CDH-5.3.4-1.cdh5.3.4.p0.12/lib/hive/lib/之后再继续安装就不会遇到问题了。

经过漫长的等待后,服务的安装完毕:

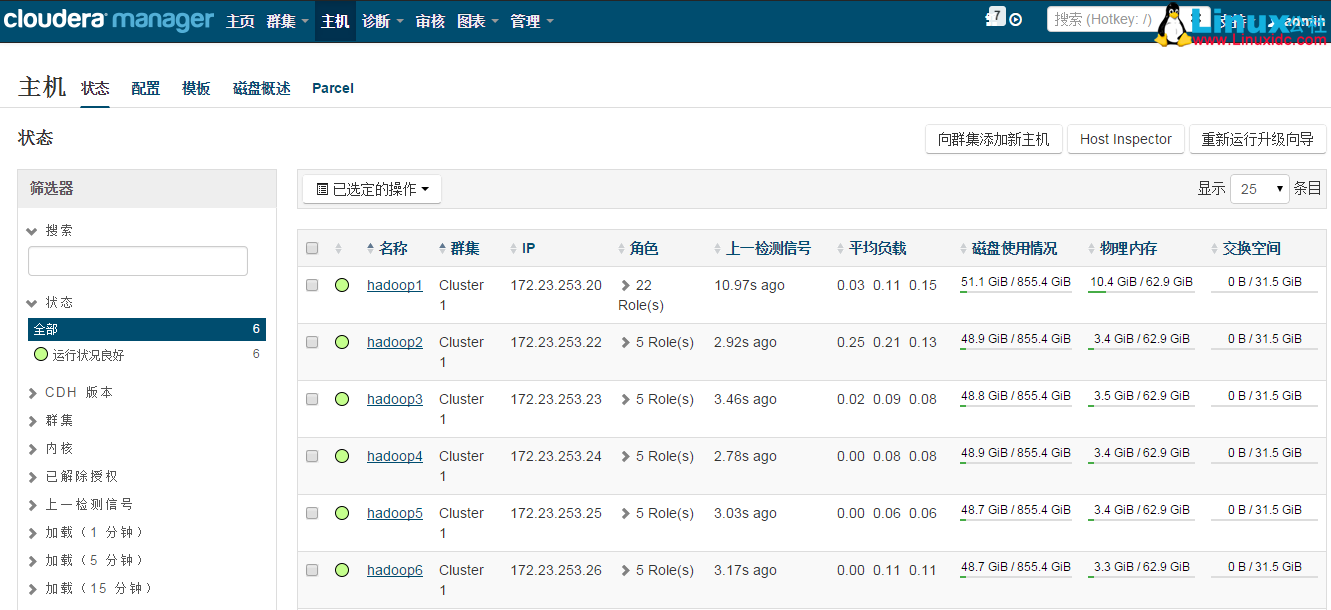

安装完毕后,就能够进入集群界面看一下集群的当前状况了。

測试

[root@hadoop1 /]# su hdfs

[hdfs@hadoop1 /]$ yarn jar /opt/cloudera/parcels/CDH/lib/hadoop-mapreduce/hadoop-mapreduce-examples.jar pi 100 1000

Number of Maps = 100

Samples per Map = 1000

Wrote input for Map #0

Wrote input for Map #1

Wrote input for Map #2

Wrote input for Map #3

Wrote input for Map #4

Wrote input for Map #5

Wrote input for Map #6

Wrote input for Map #7

Wrote input for Map #8

Wrote input for Map #9

Wrote input for Map #10

····

15/06/27 22:45:55 INFO mapreduce.Job: map 100% reduce 0%

15/06/27 22:46:00 INFO mapreduce.Job: map 100% reduce 100%

15/06/27 22:46:01 INFO mapreduce.Job: Job job_1435378145639_0001 completed successfully

15/06/27 22:46:01 INFO mapreduce.Job: Counters: 49

Map-Reduce Framework

Map input records=100

Map output records=200

Map output bytes=1800

Map output materialized bytes=3400

Input split bytes=14490

Combine input records=0

Combine output records=0

Reduce input groups=2

Reduce shuffle bytes=3400

Reduce input records=200

Reduce output records=0

Spilled Records=400

Shuffled Maps =100

Failed Shuffles=0

Merged Map outputs=100

GC time elapsed (ms)=3791

CPU time spent (ms)=134370

Physical memory (bytes) snapshot=57824903168

Virtual memory (bytes) snapshot=160584515584

Total committed heap usage (bytes)=80012115968

Shuffle Errors

BAD_ID=0

CONNECTION=0

IO_ERROR=0

WRONG_LENGTH=0

WRONG_MAP=0

WRONG_REDUCE=0

File Input Format Counters

Bytes Read=11800

File Output Format Counters

Bytes Written=97

Job Finished in 50.543 seconds

Estimated value of Pi is 3.14120000000000000000查看 mapreduce 作业

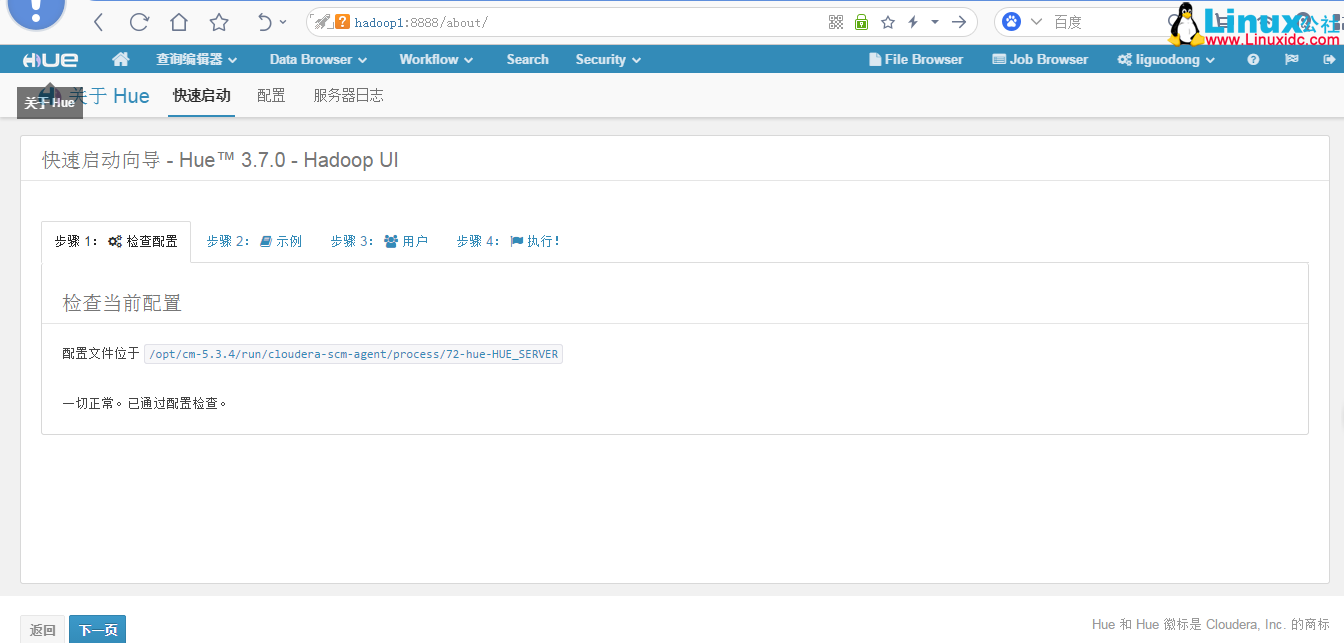

检查 Hue

首次登陆 Hue 会让设置一个初试的 username 和 password,设置好,登陆到后台。会做一次检查,一切正常后会提示。

到这里表明我们的集群能够使用了。

更多 Hadoop 相关信息见Hadoop 专题页面 http://www.linuxidc.com/topicnews.aspx?tid=13

本文永久更新链接地址:http://www.linuxidc.com/Linux/2016-07/133359.htm

这段时间一直在安装 CDH,安装第三次,终于成功了。第一次问题很多,后面卸载了,由于没有卸载干净导致第二次安装失败。后来索性重装系统了,直接使用了纯净系统进行安装。一个人跑到学院机房去装系统,苦逼惨了。

,不扯了,记录下安装流程。

系统环境

操作系统:CentOS 6.5 x64,配置如下:

Cloudera Manager:5.3.4 CDH: 5.3.4

前期准备工作(系统环境搭建)

所需软件 cloudera-manager-el6-cm5.3.4_x86_64.tar.gz、mysql-connector-Java-5.1.25-bin.jar

1、设置静态 IP 地址

vi /etc/sysconfig/network-scripts/ifcfg-eth0

2、修改主机名

hostname 主机名(当前生效)

vi /etc/sysconfig/network(下次启动生效)

[root@Hadoop2 opt]# cat /etc/sysconfig/network

NETWORKING=yes

HOSTNAME=hadoop2

GATEWAY=172.23.253.1

NTPSERVERARGS=iburst

3、绑定 IP 与 HostName

vi /etc/hosts

172.23.253.20 hadoop1

172.23.253.22 hadoop2

172.23.253.23 hadoop3

172.23.253.24 hadoop4

172.23.253.25 hadoop5

172.23.253.26 hadoop6

复制到其它节点(hadoop2~hadoop6)

scp /etc/hosts hadoop2:/etc/

scp /etc/hosts hadoop6:/etc/

4、设置 SSH 免密码登录(所有节点)

[root@hadoop1 /]# cd /root/.ssh/

[root@hadoop1 .ssh]# ssh-keygen -t rsa

[root@hadoop1 .ssh]# cat id_rsa.pub >> authorized_keys

其他其它节点同样的方式生成密钥。

hadoop2~hadoop6 将自己的公钥复制给对方主机

ssh-copy-id -i hadoop1

hadoop1 复制自己的 authorized_keys 给其他主机 hadoop2~hadoop6,这样都可以互相免密码登录了。

scp /root/.ssh/authorized_keys hadoop2:/root/.ssh/

scp /root/.ssh/authorized_keys hadoop6:/root/.ssh/

5、安装 Oracle 的 Java

首先,卸载自带的 OpenJdk,使用 rpm -qa | grep java 查询 java 相关的包,使用 rpm -e –nodeps 包名卸载掉。

由于是 rpm 包并不需要我们来配置环境变量,我们只需要配置一个全局的 JAVA_HOME 变量即可,执行命令:

echo “JAVA_HOME=/usr/java/latest/” >> /etc/environment

执行命令 java -version 和 javac -version,查看 Jdk 是否安装正确。

[root@hadoop1 .ssh]# rpm -qa | grep java

java-1.7.0-openjdk-1.7.0.45-2.4.3.3.el6.x86_64

tzdata-java-2013g-1.el6.noarch

java-1.6.0-openjdk-1.6.0.0-1.66.1.13.0.el6.x86_64

[root@hadoop1 .ssh]# rpm -e –nodeps java-1.7.0-openjdk-1.7.0.45-2.4.3.3.el6.x86_64

tzdata-java-2013g-1.el6.noarch java-1.6.0-openjdk-1.6.0.0-1.66.1.13.0.el6.x86_64

2、安装 Oracle 的 JDK(所有节点)

[root@hadoop1 opt]# rpm -ivh jdk-7u80-linux-x64.rpm

Preparing… ########################################### [100%]

1:jdk ########################################### [100%]

Unpacking JAR files…

rt.jar…

jsse.jar…

charsets.jar…

tools.jar…

localedata.jar…

jfxrt.jar…

[root@hadoop1 opt]# echo “JAVA_HOME=/usr/java/latest/” >> /etc/environment

[root@hadoop1 opt]# java -version

java version “1.7.0_80”

Java(TM) SE Runtime Environment (build 1.7.0_80-b15)

Java HotSpot(TM) 64-Bit Server VM (build 24.80-b11, mixed mode)

[root@hadoop1 opt]# javac -version

javac 1.7.0_80

6、安装和配置 MySql(主节点)

设置开机启动 chkconfig mysqld on,

并启动 mysql 服务 service mysqld start,

并根据提示设置 root 的初始密码:mysqladmin -u root password ‘xxxx’。

[root@hadoop1 opt]# yum install mysql-server

[root@hadoop1 opt]# chkconfig mysqld on

[root@hadoop1 opt]# service mysqld start

[root@hadoop1 opt]# service mysqld status

[root@hadoop1 opt]# mysqladmin -u root password ‘liguodong’

进入 mysql 命令行 mysql -uroot -pxxxx,创建以下数据库:

[root@hadoop1 opt]# mysql -uroot -pliguodong

mysql> create database hive DEFAULT CHARSET utf8 COLLATE utf8_general_ci;

Query OK, 1 row affected (0.00 sec)

mysql> create database amon DEFAULT CHARSET utf8 COLLATE utf8_general_ci;

Query OK, 1 row affected (0.00 sec)

mysql> create database hue DEFAULT CHARSET utf8 COLLATE utf8_general_ci;

Query OK, 1 row affected (0.00 sec)

设置 root 授权访问以上所有的数据库。

mysql> grant all privileges on *.* to ‘root’@’hadoop1’ identified by ‘liguodong’ with grant option;

Query OK, 0 rows affected (0.00 sec)

mysql> flush privileges;

Query OK, 0 rows affected (0.00 sec)

http://www.cloudera.com/content/cloudera/en/documentation/core/latest/topics/cm_ig_mysql.html#cmig_topic_5_5

7、关闭防火墙和 SELinux(所有节点)

关闭防火墙:

service iptables stop(临时关闭)

chkconfig iptables off(重启后生效)

(实际安装过程中发现没有关闭也是可以的,不知道会不会有问题,还需进一步进行验证)

setenforce 0(临时生效)

修改 /etc/selinux/config 下的 SELINUX=disabled(重启后永久生效)

[root@hadoop1 opt]# service iptables stop

iptables:将链设置为政策 ACCEPT:filter [确定]

iptables:清除防火墙规则:[确定]

iptables:正在卸载模块:[确定]

[root@hadoop1 opt]# chkconfig iptables off

[root@hadoop1 opt]# setenforce 0

[root@hadoop1 opt]# vi /etc/selinux/config

[root@hadoop1 opt]# cat /etc/selinux//config

SELINUXTYPE=targeted

SELINUX=disabled

8、安装和配置 NTP 服务(所有节点)

具体思路如下:

master 节点作为 ntp 服务器与外界对时中心同步时间,随后对所有 datanode 节点提供时间同步服务。所有 datanode 节点以 master 节点为基础同步时间。

所有节点安装相关组件:yum install ntp。

完成后,配置开机启动:chkconfig ntpd on,

检查是否设置成功:chkconfig –list ntpd,其中 2 - 5 为 on 状态就代表成功。

[root@hadoop1 opt]# yum install ntp

[root@hadoop1 opt]# chkconfig ntpd on

[root@hadoop1 opt]# chkconfig –list ntpd

ntpd 0: 关闭 1: 关闭 2: 启用 3: 启用 4: 启用 5: 启用 6: 关闭

配置内网 NTP 服务器(主节点)

# ntpdate -u 202.112.10.36

22 Dec 16:52:38 ntpdate[6400]: adjust time server 202.112.10.36 offset 0.012135 sec

ntp 服务只有一个配置文件,配置好就可以。这里只给出有用的配置,不需要的配置都用 #注掉,这里就不在给出。

[root@hadoop1 opt]# vi /etc/ntp.conf

[root@hadoop1 opt]# cat /etc/ntp.conf

driftfile /var/lib/ntp/drift

restrict 127.0.0.1

restrict -6 ::1

restrict default nomodify notrap

server 202.112.10.36 prefer

includefile /etc/ntp/crypto/pw

keys /etc/ntp/keys

[root@hadoop1 opt]# service ntpd start

检查是否成功,用 ntpstat 命令查看同步状态,出现以下状态代表启动成功:

[root@hadoop1 ~]# ntpstat

synchronised to NTP server (202.112.10.36) at stratum 3

time correct to within 133 ms

polling server every 1024 s

配置 ntp 客户端(hadoop2~hadoop6)

driftfile /var/lib/ntp/drift

restrict 127.0.0.1

restrict -6 ::1

restrict default kod nomodify notrap nopeer noquery

restrict -6 default kod nomodify notrap nopeer noquery

# 这里是主节点 (内网 NTP 服务器) 的主机名或者 ip

server hadoop1

includefile /etc/ntp/crypto/pw

keys /etc/ntp/keys

这里可能出现同步失败的情况,请不要着急,一般是本��的 ntp 服务器还没有正常启动,一般需要等待 5 -10 分钟才可以正常同步。

启动服务:service ntpd start

[root@hadoop2 ~]# ntpdate -u hadoop1

27 Jun 08:14:38 ntpdate[1899]: adjust time server 172.23.253.20 offset 0.000293 sec

[root@hadoop2 ~]# service ntpd start

[root@hadoop2 ~]# chkconfig ntpd on

安装与配置 Cloudera Manager Server 和 AgentServer 配置(主节点)

根据自己的系统选择相应的版本,本次安装选用的是 cloudera-manager-el6-cm5.3.4_x86_64.tar.gz,下载完成后只上传到主节点即可。

然后解压到 /opt 目录下,不能解压到其它地方。

因为 cdh5 的源会默认在 /opt/cloudera/parcel-repo 寻找,怎么制作 cdh5 的本地源文件会在之后介绍。

[root@hadoop1 opt]# tar -zxvf cloudera-manager-el6-cm5.3.4_x86_64.tar.gz

给所有节点添加 cloudera-scm 用户:

[root@hadoop1 lib]# useradd –system –home=/opt/cm-5.3.4/run/cloudera-scm-server/ –no-create-home –shell=/bin/false

–comment “Cloudera SCM User” cloudera-scm

因为我们用的是 Mysql 数据库,所以我们需要下载 Mysql 的 JDBC 驱动,本次从官网上下载的版本是:mysql-connector-java-5.1.25-bin.jar 放到 /opt/cm-5.3.4/share/cmf/lib/ 目录下。

[root@hadoop1 opt]# mv mysql-connector-java-5.1.25-bin.jar /opt/cm-5.3.4/share/cmf/lib/

[root@hadoop1 opt]#/opt/cm-5.3.4/share/cmf/schema/scm_prepare_database.sh mysql

cm -hlocalhost -uroot -pliguodong –scm-host localhost scm scm scm

[root@hadoop1 lib]# /opt/cm-5.3.4/etc/init.d/cloudera-scm-server start

server 首次启动不要立即关闭或重启,因为首次启动会自动创建相关表以及数据,

如果因为特殊原因中途退出,请先删除所有表以及数据之后再次启动,否则将会出现启动不成功的情况。

Agent 配置(所有节点)

[root@hadoop1 lib]# vi /opt/cm-5.3.4/etc/cloudera-scm-agent/config.ini

server_host=hadoop1

先复制 /opt/cm-5.3.4 到 hadoop2~hadoop6 节点上,

scp -r /opt/cm-5.3.4 hadoop2:/opt/

···

scp -r /opt/cm-5.3.4 hadoop6:/opt/

等待拷贝成功,在所有节点上启动 Agent:(注意必须以管理员权限启动)

[root@hadoop1 lib]# /opt/cm-5.3.4/etc/init.d/cloudera-scm-agent start

更多详情见请继续阅读下一页的精彩内容:http://www.linuxidc.com/Linux/2016-07/133359p2.htm