共计 127547 个字符,预计需要花费 319 分钟才能阅读完成。

1. 硬件服务器

- 名称:浪潮 P8000 工作站

- CPU:Intel Xeon CPU E5-2620 v3 2.40GHz * 2,共 12 个物理核,24 个逻辑核

- 内存:16 * 8 = 128GB

- 存储:SAS 300GB * 3 = 900GB

- 网络:千兆网卡 * 6

- 操作系统:Windows Server 2012 R2 DataCenter

2. OpenStack 部署分析及规划

2.1 目的

- 部署一个 OpenStack 测试环境

- 硬件虚拟化,提供一个 Infrastructure-as-a-Service (IaaS) 解决方案

- 基于 OpenStack 云计算平台提供 Hadoop MapReduce、Spark 等计算服务

- 提供 OpenStack 开源云计算学习平台

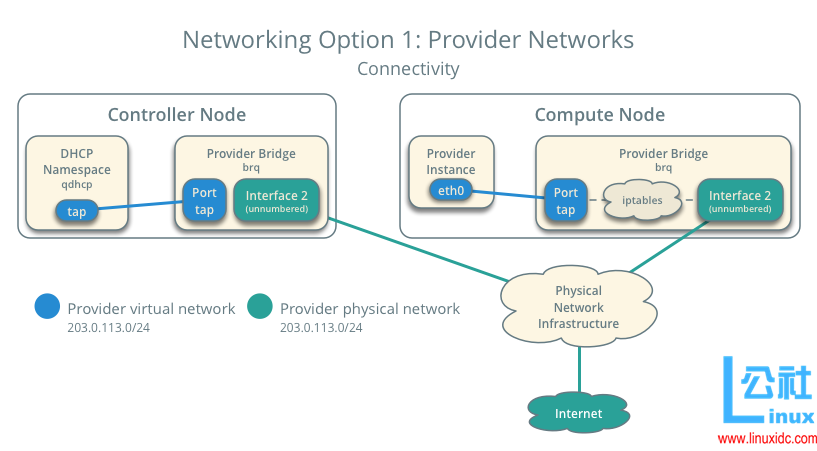

2.2 OpenStack 网络模型选择

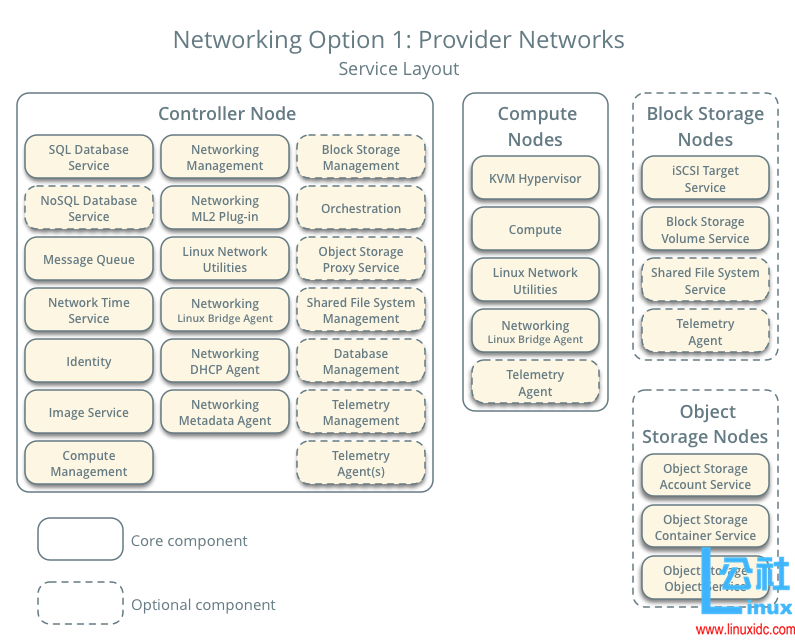

官方文档中 OpenStack 提供了两种网络模型架构

-

Provider Networks

OpenStack 最简单的部署方式,主要利用二层网络服务(Layer-2 Services)(通过网桥和交换机连接不同网络)和VLAN 划分,其本质上是将虚拟机网络(Virtual Networks)通过桥接到物理网络(Physical Networks)并利用物理网络设施提供三层网络服务(Layer-3 Services);此外,通过DHCP服务向虚拟网络实例提供 IP 地址。

注:该方式不支持私有自服务网络(Private Self-Service Networks),如三层路由服务(Layer-3 Routing Services)。

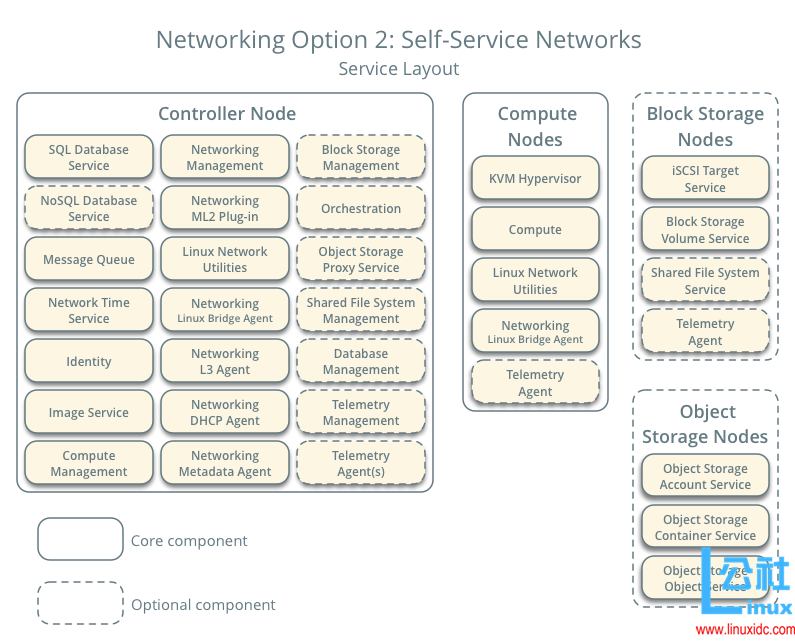

-

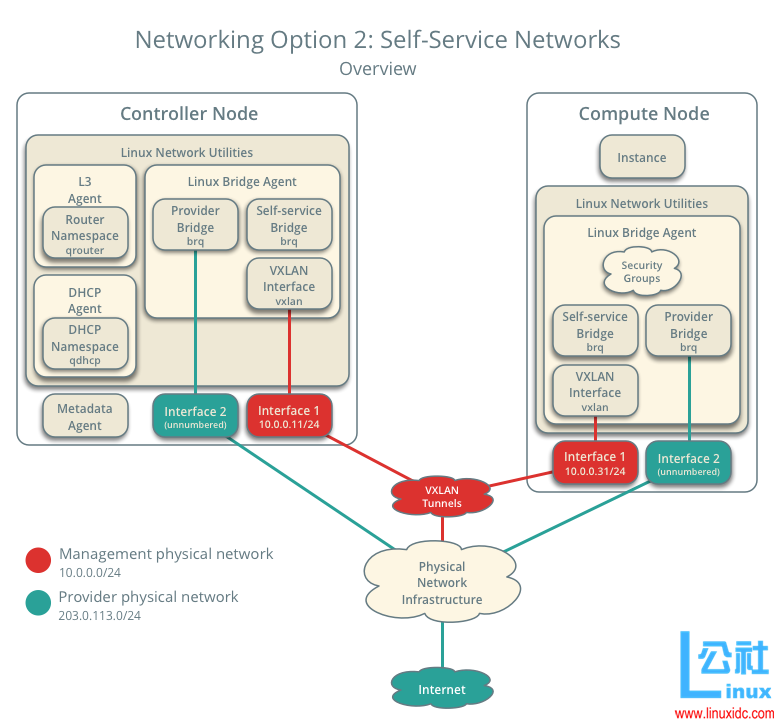

Self-Service Networks

该方式和Provider Networks方式相比,通过诸如VXLAN方式在自服务网络中支持三层路由服务。

本文采用 Provider Networks 网络模型设计

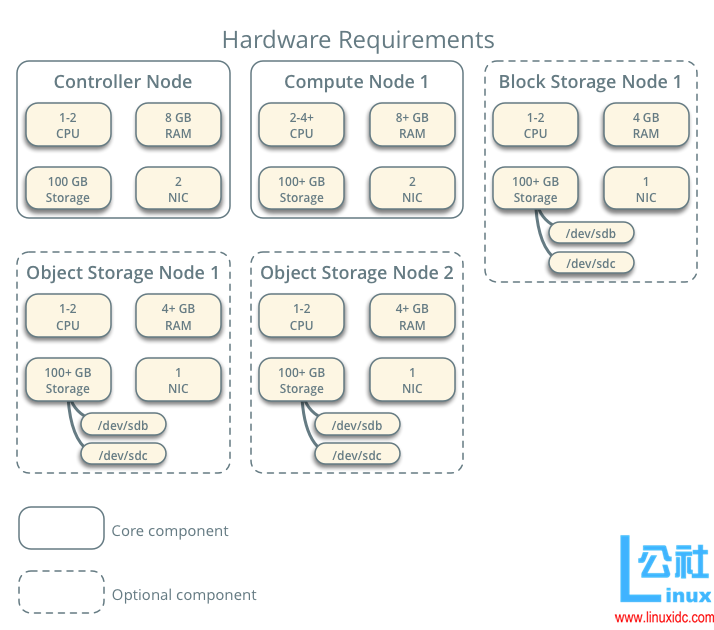

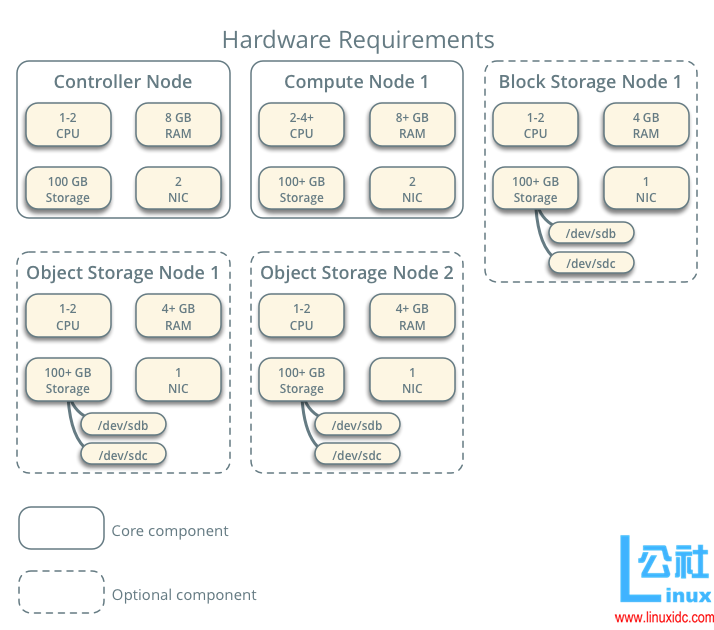

2.3 OpenStack 节点硬件需求

2.4 OpenStack 服务组件选择

本文选择 OpenStack Mitaka 版本

-

Compute-Focused OpenStack Design

根据 OpenStack 官方文档,以计算服务为主的 OpenStack 私有云计算平台可选取以下组件:For a compute-focused OpenStack design architecture, the following components may be present: Identity (keystone) Dashboard (horizon) Compute (nova) Object Storage (swift) Image (glance) Networking (neutron) Orchestration (heat) -

OpenStack 服务组件选择:

注:本文选择MariaDB(MySQL 的一个分支,完全兼容 MySQL)开源数据库为 OpenStack 组件提供后端数据访问服务。Service Name Component Name Brief Description Identity Service Keystone 身份服务,提供单点集成方式管理身份认证、授权、服务目录服务 Image Service Glance 镜像服务 Compute Service Nova 计算服务 Networking Service Neutron 网络服务 Dashboard Service Horizon 仪表盘,访问 OpenStack 服务的图形化接口 Block Storage Service Cinder 块存储服务 Shared File Systems Service Manila 共享文件系统服务,用于文件存储 Object Storage Service Swift 对象存储服务,用于对象存储和检索 Orchestration Service Heat 编排服务,基于模板创建管理云资源 Telemetry Data Collection Service Ceilometer 计量服务 Telemetry Alarming Service Aodh 警报服务 Database Service Trove 数据库服务,用于云部署关系型和非关系性数据库引擎 Data Processing Service Sahara 数据处理服务,提供一个数据处理框架,如 Hadoop、Spark、Storm

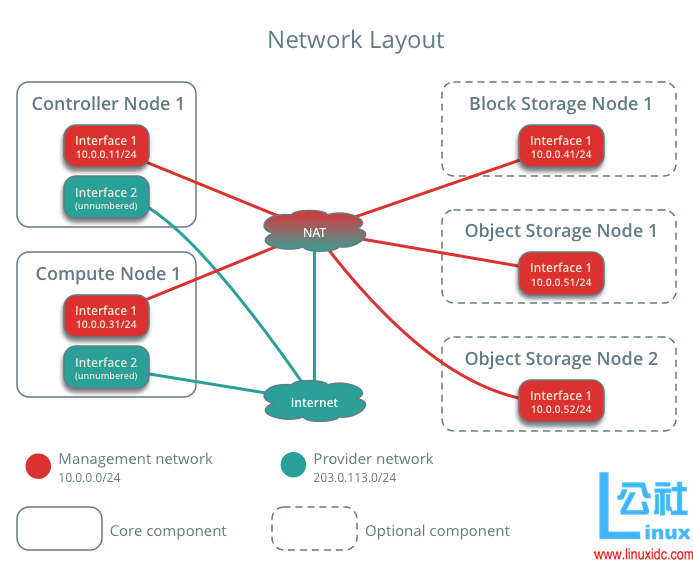

2.5 OpenStack 节点网络设计

-

OpenStack 官方文档建议网络布局如下:

-

本文采用如下网络设计

总共 3 个子网:

① 互联网连接 / 对外出口(External)

② Openstack 管理网络(Management)

③ VM 虚拟机内网连接(Data)

注:此外,本文将 Block Storage Node 和Object Storage Node加入Management Network。

2.6 OpenStack 节点服务器规划

-

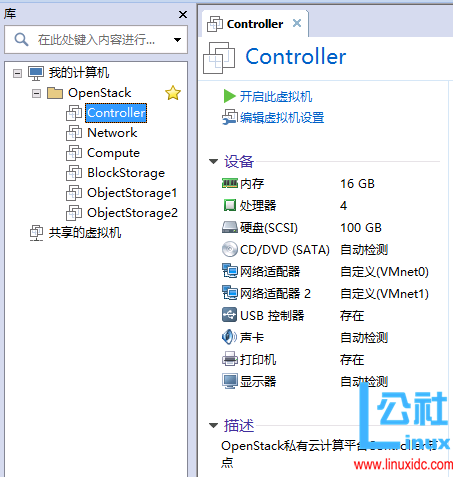

6台 Ubuntu 16.04 LTS:

① Cotroller:用于整个集群的控制,高可靠性要求。承载数据库(MySQL)、队列服务器(RabbitMQ)、和最终的 web 入口(Apache+Memcache)。设置一块虚拟硬盘。要求网卡 eth0 接 External Network,eth1 接 Management Network 子网。

② Network:网络控制节点,高网络吞吐型节点。设置一块虚拟硬盘。要求 3 网卡,eth0 接 External Network,eth1 接 Management Network 子网, eth2 接 Data Network 子网。

③ Compute:计算节点,高内存 +CPU+IO 消耗型节点。设置一块虚拟硬盘。要求网卡 eth0 接 External Network,eth1 接 Management Network 子网,eth2 接 Data Network 子网。

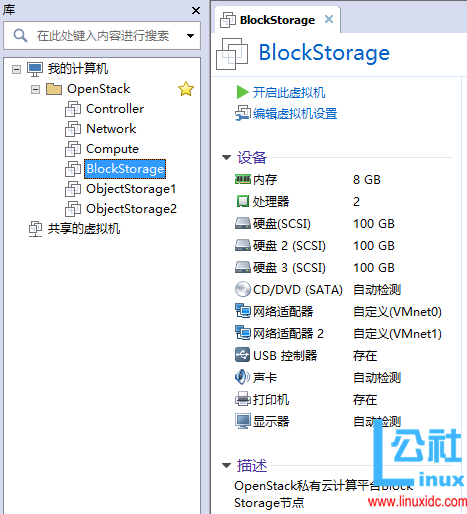

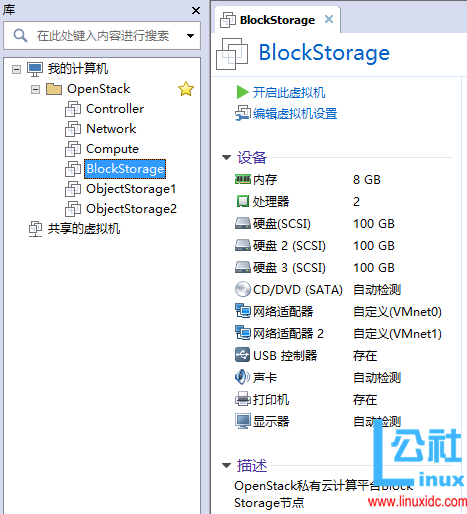

④ BlockStorage:块存储节点,提供块存储和共享文件系统服务。设置三块虚拟硬盘,一块安装操作系统,一块用于块存储服务,一块用于共享文件系统服务。要求网卡 eth0 接 External Network,eth1 接 Management Network 子网。

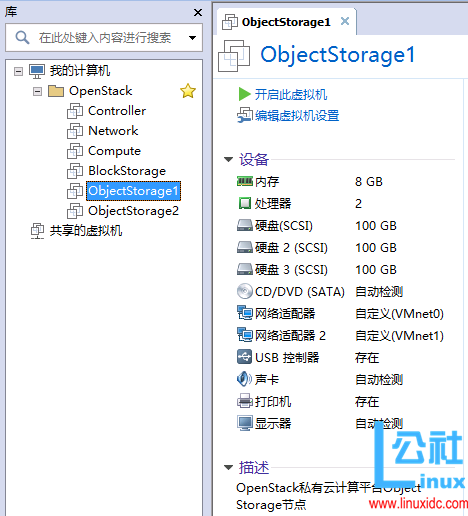

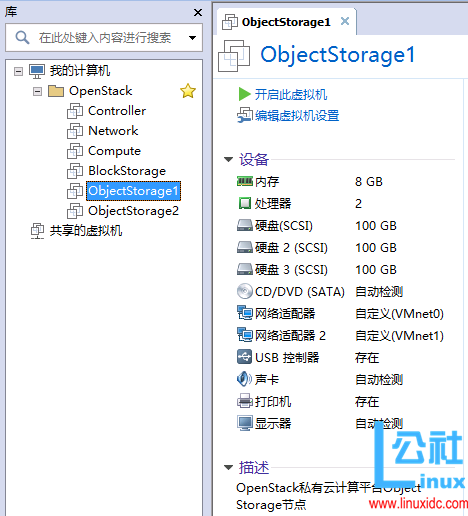

⑤ ObjectStorage:两个对象存储节点,提供对象存储服务。设置三块虚拟硬盘,一块安装操作系统,两块用于对象存储服务。要求网卡 eth0 接 External Network,eth1 接 Management Network 子网。

注:上述为了方便管理,对每个节点都添加了eth0网络接口,实际生产环境请根据实际情况配置。 -

服务器配置:

Node CPU 内存 存储 Controller 4 核 16GB 100GB Network 2 核 8GB 100GB Compute 16 核 64GB 300GB BlockStorage 2 核 8GB 100GB+100GB+100GB ObjectStorage1 2 核 8GB 100GB+100GB+100GB ObjectStorage2 2 核 8GB 100GB+100GB+100GB 注:此处资源分配超出了实际物理资源,可根据实际分配资源。

-

网络配置:

Node eth0 eth1 eth2 External Network Management Network Data Network Controller 192.168.1.11 10.0.0.11 Network 192.168.1.21 10.0.0.21 10.0.1.21 Compute 192.168.1.31 10.0.0.31 10.0.1.31 BlockStorage 192.168.1.41 10.0.0.41 ObjectStorage1 192.168.1.51 10.0.0.51 ObjectStorage2 192.168.1.52 10.0.0.52 Subnet Mask 255.255.255.0 255.255.255.0 255.255.255.0 Gateway 192.168.1.1 10.0.0.1 10.0.1.1 注:由于实际网络限制,External Network 通过虚拟网卡

192.168.1.1共享主机网络来访问外网 -

物理主机端口映射信息:

物理机端口 虚拟机 IP 虚拟机端口 服务描述 11122 192.168.1.11 22 Controller SSH 服务 12122 192.168.1.21 22 Network SSH 服务 13122 192.168.1.31 22 Compute SSH 服务 14122 192.168.1.41 22 BlockStorage SSH 服务 15122 192.168.1.51 22 ObjectStorage1 SSH 服务 15222 192.168.1.52 22 ObjectStorage2 SSH 服务 11180 192.168.1.11 80 OpenStack Dashboard 服务 6080 192.168.1.11 6080 OpenStack Compute Service of Nova Proxy 注:将虚拟机 SSH 端口映射到物理主机特定端口,以便外网通过物理主机访问虚拟机。

物理主机端口:为方便管理,针对 SSH 服务,将物理主机映射端口设计如下,前三位表示对应虚拟机地址末两字节,最后两位表示对应虚拟机端口。 -

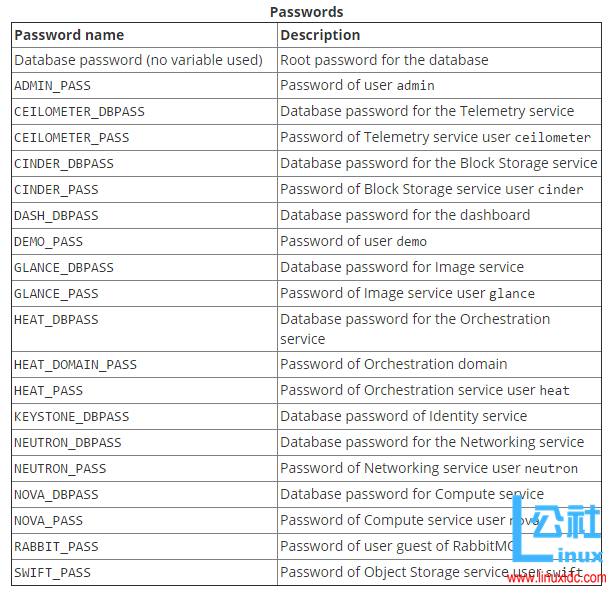

OpenStack 服务密码要求:

根据 OpenStack 官方文档

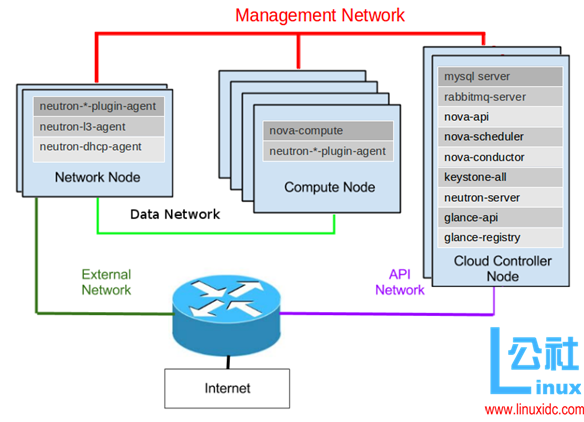

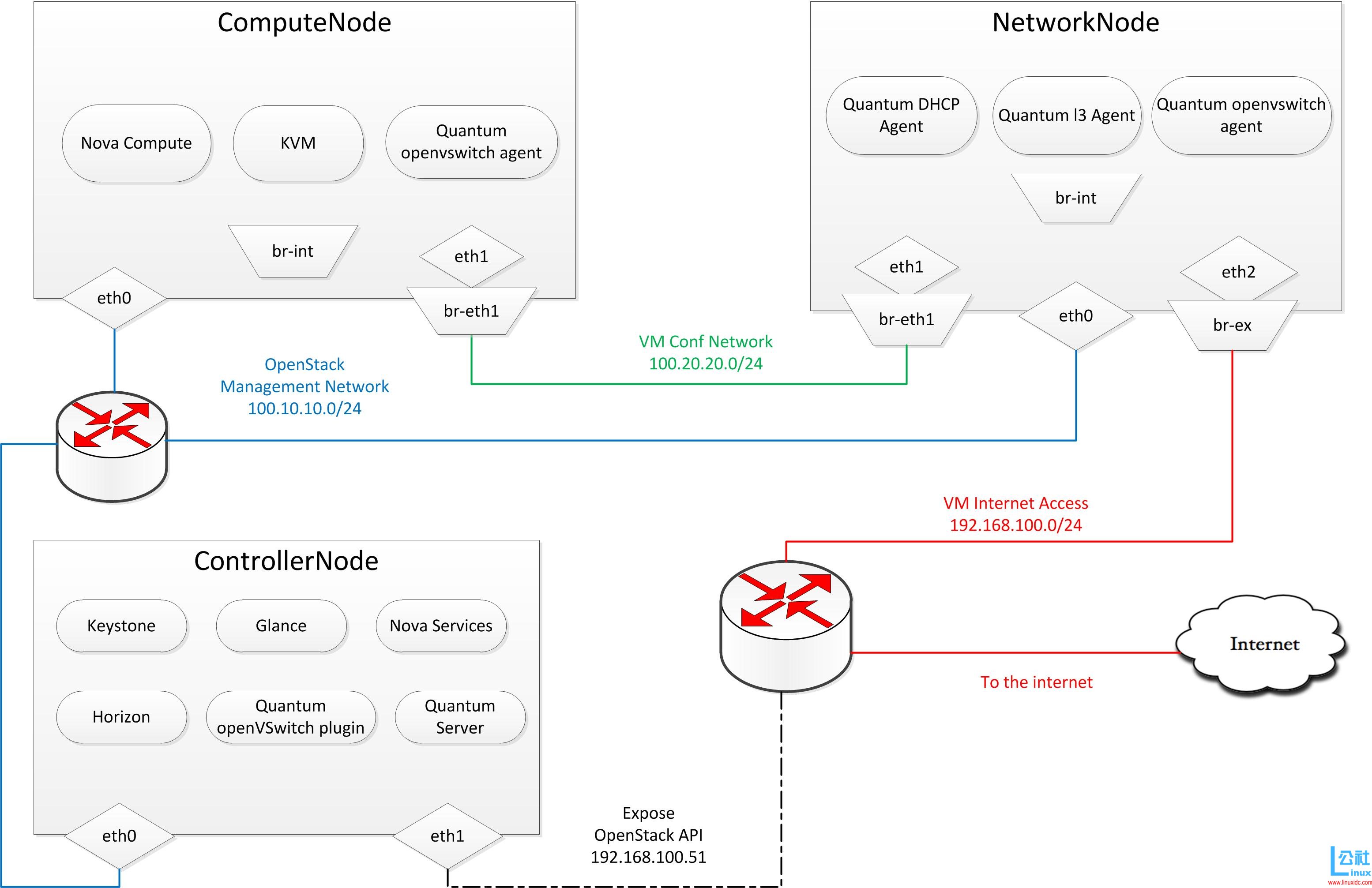

2.7 OpenStack 各节点组件规划

-

节点组件信息:

Node OpenStack Service Controller mariadb-server、mongodb-server、rabbitmq-server、memcached、keystone、apache2、glance、nova-api、nova-conductor、nova-consoleauth、nova-novncproxy、nova-scheduler、neutron-server、neutron-plugin-ml2、horizon(dashboard)、cinder-api cinder-scheduler、manila-api、manila-scheduler、Python-manilaclient、swift、swift-proxy、python-swiftclient、heat-api、heat-api-cfn、heat-engine、ceilometer-api、ceilometer-collector、ceilometer-agent-central、ceilometer-agent-notification、python-ceilometerclient、python-ceilometermiddleware、aodh-api、aodh-evaluator、aodh-notifier、aodh-listener、aodh-expirer、python-trove、python-troveclient、python-glanceclient、trove-common、trove-api、trove-taskmanager、trove-conductor、sahara-api、sahara-engine、sahara-templates、sahara-wsgi-api Network neutron-linuxbridge-agent、neutron-l3-agent、neutron-dhcp-agent、neutron-metadata-agent Compute nova-compute、neutron-linuxbridge-agent、kvm、ceilometer-agent-compute BlockStorage lvm2、cinder-volume、manila-share、neutron-plugin-linuxbridge-agent ObjectStorage xfsprogs、rsync、swift、swift-account、swift-container、swift-object -

各节点功能可参考下图

注:仅供参考理解,具体根据实际情况而定

2.8 用户、密码、地址、端口信息登记

注:

① 请提前设计好所需密码并登记存档,并及时登记用到的服务地址 & 端口信息。

② 根据实际情况,将下面 Password 列替换为实际密码。

(若为测试环境,建议密码采用一定规则,方便记忆,但数据库等服务密码不要包含一些特殊字符,如:、/、+、@)

-

OpenStack 节点主机用户 & 密码:

Node Hostname User Password Controller controller controller your_password Controller controller root your_password Network network network your_password Network network root your_password Compute compute compute your_password Compute compute root your_password BlockStorage blockstorage blockstorage your_password BlockStorage blockstorage root your_password ObjectStorage1 objectstorage1 objectstorage your_password ObjectStorage1 objectstorage1 root your_password ObjectStorage2 objectstorage2 objectstorage your_password ObjectStorage2 objectstorage2 root your_password -

OpenStack 服务用户 & 密码:

Name User Password Database_PASS(MariaDB/MySQL) root your_password RABBIT_PASS openstack your_password KEYSTONE_DBPASS keystone your_password ADMIN_PASS admin your_password DEMO_PASS demo your_password GLANCE_DBPASS glance your_password GLANCE_PASS glance your_password NOVA_DBPASS nova your_password NOVA_PASS nova your_password NEUTRON_DBPASS nuetron your_password NEUTRON_PASS nuetron your_password METADATA_SECRET your_password CINDER_DBPASS cinder your_password CINDER_PASS cinder your_password MANILA_DBPASS manila your_password MANILA_PASS manila your_password SWIFT_PASS swift your_password HASH_PATH_PREFIX your_password HASH_PATH_SUFFIX your_password HEAT_DBPASS heat your_password HEAT_PASS heat your_password HEAT_DOMAIN_PASS heat_domain_admin your_password CEILOMETER_DBPASS ceilometer your_password CEILOMETER_PASS ceilometer your_password AODH_DBPASS aodh your_password AODH_PASS aodh your_password TROVE_DBPASS trove your_password TROVE_PASS trove your_password SAHARA_DBPASS sahara your_password SAHARA_PASS sahara your_password -

OpenStack 各节点服务地址 & 端口

参考:Firewalls and default ports

注:可执行sudo netstat -tnlp查看节点 IP 地址 端口 服务描述 Controller 192.168.1.11 22 SSH Controller 10.0.0.11 3306 MariaDB(MySQL) Controller 10.0.0.11 27017 MongoDB Controller 10.0.0.11 5672、25672 RabbitMQ Controller 10.0.0.11 4369 Erlang 端口映射守护进程(Erlang Port Mapper Daemon) Controller 10.0.0.11 11211 Memcached Controller 10.0.0.11 35357 OpenStack Identity Service of Apache HTTP Server(Admin) Controller 10.0.0.11 5000 OpenStack Identity Service of Apache HTTP Server(User) Controller 10.0.0.11 9191 OpenStack Image Service of Glance Registry Controller 10.0.0.11 9292 OpenStack Image Service of Glance API Controller 10.0.0.11 8774、8775 OpenStack Compute Service of Nova API Controller 10.0.0.11 6080 OpenStack Compute Service of Nova Proxy Controller 10.0.0.11 9696 OpenStack Networking Service of Neutron Server Controller 10.0.0.11 80 OpenStack Dashboard Service of Apache HTTP Server Controller 10.0.0.11 8776 OpenStack Block Storage Service of Cinder API Controller 10.0.0.11 8786 OpenStack Shared File Systems Service of Manila API Controller 10.0.0.11 8080 OpenStack Object Storage Service of Swift Proxy Controller 10.0.0.11 8000 OpenStack Orchestration Service of Heat API (CloudFormation) Controller 10.0.0.11 8004 OpenStack Orchestration Service of Heat API Controller 10.0.0.11 8777 OpenStack Telemetry Alarming Service of Ceilometer API Controller 10.0.0.11 8042 OpenStack Telemetry Alarming Service of Aodh API Controller 10.0.0.11 8779 OpenStack Database Service of Trove API Controller 10.0.0.11 8386 OpenStack Data Processing Service of Sahara API Network 192.168.1.21 22 SSH Compute 192.168.1.31 22 SSH Compute 192.168.122.1 53 Libvirt Dnsmasq BlockStorage 192.168.1.41 22 SSH BlockStorage 10.0.0.41 3260 OpenStack Block Storage Service of Tgtd(iSCSI target 后台服务) ObjectStorage 192.168.1.51/52 22 SSH ObjectStorage 10.0.0.51/52 873 OpenStack Object Storage Service of Remote Sync ObjectStorage 10.0.0.51/52 6000 OpenStack Object Storage Service of Object ObjectStorage 10.0.0.51/52 6001 OpenStack Object Storage Service of Container ObjectStorage 10.0.0.51/52 6002 OpenStack Object Storage Service of Account

3. 环境准备

3.1 物理主机基本配置

-

物理机基本配置

① 开启物理主机虚拟化功能

② 在物理主机上安装 VMware Workstation 12.1 Pro -

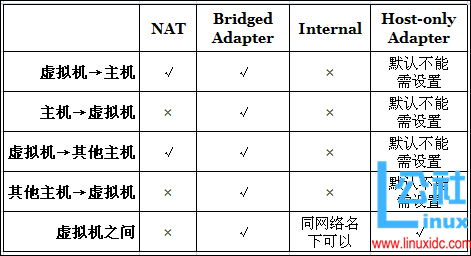

VMware 虚拟机配置

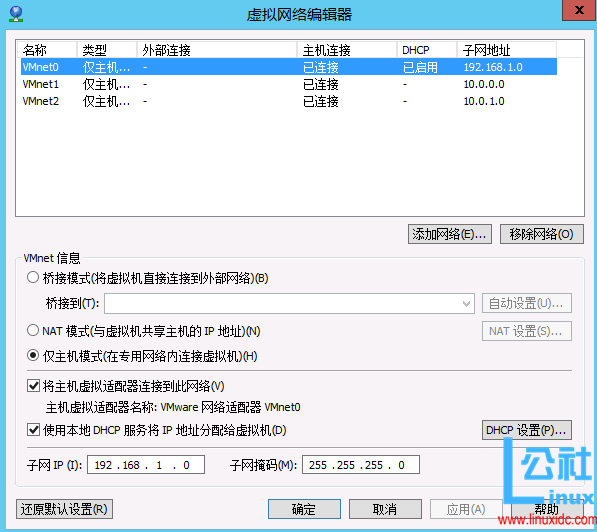

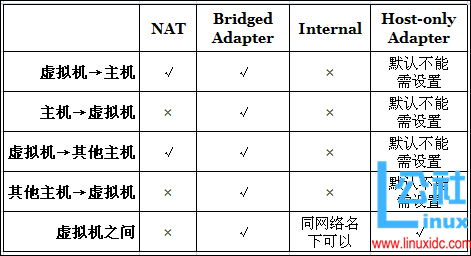

① 配置虚拟机网络

虚拟机网络连接方式图解:

打开 VMware Workstation 虚拟网络编辑器,添加如下虚拟网卡:

其中 VMnet0 用于配置 External Network,VMnet1 用于配置 Management Network 子网, VMnet2 用于配置 Data Network 子网。如下图:

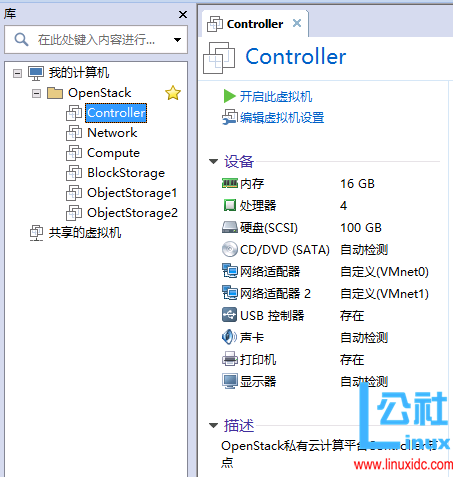

② 创建虚拟机,按前面要求设置 CPU、内存大小,并新建网络适配器同时指定网络连接方式,各节点对应名称如下表:Node VMnet0 VMnet1 VMnet2 Controller 网络适配器 网络适配器 2 Network 网络适配器 网络适配器 2 网络适配器 3 Compute 网络适配器 网络适配器 2 网络适配器 3 BlockStorage 网络适配器 网络适配器 2 ObjectStorage1 网络适配器 网络适配器 2 ObjectStorage2 网络适配器 网络适配器 2 注:虚拟机中添加网络适配器的顺序跟系统内默认网卡名

eth0、eth1、eth2对应。

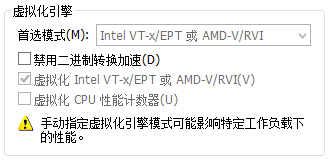

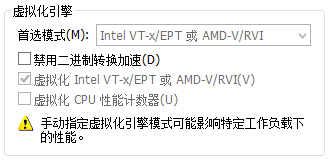

③ 开启虚拟机 CPU 虚拟化功能

对于每个虚拟机,虚拟机设置–> 处理器设置–> 虚拟化引擎,选择Intel VT-x/EPT 或 AMD-V/RVI,如下图:

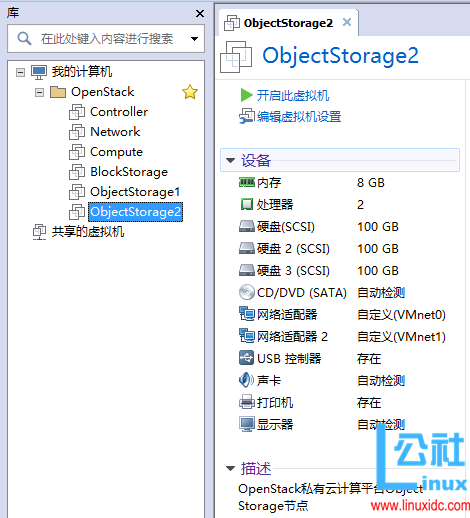

④ 各节点虚拟机配置如下图:

Controller 节点:

Network 节点:

Compute 节点:

BlockStorage 节点:

ObjectStorage1 节点:

ObjectStorage2 节点:

3.2 节点系统安装

在 VMware 中创建虚拟机,安装 Ubuntu 16.04 LTS

- 创建虚拟机,设置 CPU 核心数、内存大小、存储大小。

- 添加两块(或三块)虚拟网卡

- 加载 Ubuntu Server 16.04 LTS 系统镜像

- 启动系统,选择时区、语言,设置主机名和用户名、密码。

Partition disks配置步骤:

① 单独设置分区/dev/sda1,大小200MB,用于挂载/boot

选择手动配置–> 选择硬盘–> 创建新的分区表–> 选择空闲空间–> 新建分区–> 设置大小 200MB–> 选择主分区–> 选择开始位置–> 设置文件系统格式Ext4–> 设置挂载点/boot–> 设置分区。

② 设置 LVM,方便扩展存储,挂载/和swap

配置逻辑卷 LVM–> 将修改写入磁盘并配置 LVM–> 新建卷组–> 卷组名称:vg_system–> 按空格键选中剩余空闲空间/dev/sda–> 将修改写入磁盘并配置 LVM–> 新建逻辑卷–> 选择卷组vg_system–> 逻辑卷名:lv_root–> 设置逻辑卷大小:91GB–> 新建逻辑卷–> 选择卷组vg_system–> 逻辑卷名:lv_swap–> 设置逻辑卷大小为剩余空间–> 完成。

③ 分别对每一个逻辑卷进行配置

磁盘格式:lv_root 选择 ext4,lv_swap 选择 swap area。

挂载点:lv_root 选择”/”。

最后选择完成分区并将更改写入磁盘,点击确定即可。- 选择服务器默认安装软件包

空格键选择 OpenSSH Server,方便使用 SSH 传输文件。 - 安装 Grub。

按照上述步骤,创建其他节点服务器并安装 Ubuntu 16.04 LTS 系统

3.3 节点系统基本环境配置

-

启用 root 用户,设置 root 密码

sudo passwd root -

为普通用户添加 sudo 权限

只需修改/etc/sudoers文件 :

切换到 root 用户,输入命令su -,输入 root 用户密码。

输入命令vi /etc/sudoers编辑/etc/sudoers文件,在下面内容下添加一行your_username ALL=(ALL:ALL) ALL,输入w!强制保存,退出 vi。# User privilege specification root ALL=(ALL:ALL) ALL # controller controller ALL=(ALL:ALL) ALL注:如没有修改权限,则为

/etc/sudoers文件添加写权限chmod u+w /etc/sudoers,修改后撤销权限chmod u-w /etc/sudoers。 -

修改网卡命名方式

输入ifconfig -a查看,发现网卡名称由 udev 管理命名为ens33和ens38,为了方便,将网卡名称修改为上述表格所示eth0、eth1、eth2。

①sudo vi /etc/default/grub把 /etc/default/grub 中GRUB_CMDLINE_LINUX_DEFAULT="" GRUB_CMDLINE_LINUX=""改成:

GRUB_CMDLINE_LINUX_DEFAULT="quiet splash" GRUB_CMDLINE_LINUX="net.ifnames=0 biosdevname=0"② 重新生成 grub 文件

sudo update-grub sudo grub-mkconfig -o /boot/grub/grub.cfg③ 重启系统,发现网卡名称已经改回

eth0、eth1、eth2命名格式。

注:以上步骤在 Controller 节点、Compute 节点、Network 节点配置方法相同 -

修改各节点网卡和 VMware 虚拟网卡绑定关系

可选环节:若网卡和虚拟网卡绑定关系不同,可手动指定

按照前面表格所示,修改各节点网卡名称为对应的eth0、eth1、eth2

以 Controller 节点为例

将默认网卡名eth0和eth1修改为eth0和eth2sudo vi /etc/udev/rules.d/70-persistent-net.rules // 如无该文件,新建一个即可添加如下内容,其中

00:0c:29:a9:66:8c和00:0c:29:a9:66:96为网卡 MAC,可执行ifconfig -a查看,根据情况自行设定:# eth0 SUBSYSTEM=="net", ACTION=="add", ATTR{address}=="00:0c:29:a9:66:8c", NAME="eth0" # eth2 SUBSYSTEM=="net", ACTION=="add", ATTR{address}=="00:0c:29:a9:66:96", NAME="eth2"保存并重启电脑

sudo reboot。

注:配置完成后,不能 在虚拟机设置 --> 网络适配器 --> 高级中点击生成 MAC,否则上面 MAC 地址需要修改配置。

注:Compute 节点、Network 节点配置方法类似 -

设置静态 IP/DNS

以 Controller 节点为例

① 修改文件sudo vi /etc/network/interfaces,将默认生成的(下面内容可能没有,可能不一样,配置时视自己情况而定):auto ens33 iface ens33 inet dhcp改为:

#eth0 config (connect to internet) auto eth0 iface eth0 inet static address 192.168.1.11 #IP 地址 netmask 255.255.255.0 # 子网掩码 gateway 192.168.1.1 # 网关 dns-nameserver 192.168.1.1 #DNS # eth1 config (connect to openstack management network) auto eth1 iface eth1 inet static address 10.0.0.11 #IP 地址 netmask 255.255.255.0 # 子网掩码② 重启网卡,使配置生效:

sudo /etc/init.d/networking restart sudo service networking restart注:若找不到上述命令或重启无效可尝试下面命令:

sudo ifdown eth0 sudo ifdown eth1 sudo ifup eth0 sudo ifup eth1注:若提示

ifdown: interface eth0 not configured,可换下面命令尝试:sudo ifconfig eth0 down sudo ifconfig eth1 down sudo ifconfig eth0 up sudo ifconfig eth1 up③ 运行

ifconfig -a查看网络配置信息。

④ 通过ping www.baidu.com测试能否正常访问外网。若不能,可sudo reboot重启节点试试。

注:Compute 节点、Network 节点配置方法类似 -

在物理主机中为各节点 SSH 连接配置端口映射

可参考:Windows 下实现端口映射 http://www.linuxidc.com/Linux/2016-09/135489.htm

以 Controller 节点为例

① 利用 Windows 自带的netsh配置端口映射,打开cmd命令行,输入:

注:下面xxx.xxx.xxx.xxx为物理主机实际 IP// 配置端口映射 netsh interface portproxy add v4tov4 listenaddress=xxx.xxx.xxx.xxx listenport=11122 connectaddress=192.168.1.11 connectport=22 // 或者 netsh interface portproxy add v4tov4 listenport=11122 connectaddress=192.168.1.11 connectport=22 // 查看已配置的端口映射 netsh interface portproxy show v4tov4 // all 侦听 ipv4: 连接到 ipv4: 地址 端口 地址 端口 --------------- ---------- --------------- ---------- xxx.xxx.xxx.xxx 11122 192.168.1.11 22 * 11122 192.168.1.11 22 // 删除端口映射 netsh interface portproxy delete v4tov4 listenaddress=xxx.xxx.xxx.xxx listenport=11122 netsh interface portproxy delete v4tov4 listenport=11122② 在系统防火墙高级设置中配置入站规则

新建规则–> 端口–> 特定本地端口:11122–> 允许连接–> 选择域 / 专用 / 公用–> 名称:VMware OpenStack Controller SSH、描述:用于 VMware 中 OpenStack 云计算平台 Controller 节点 SSH 连接

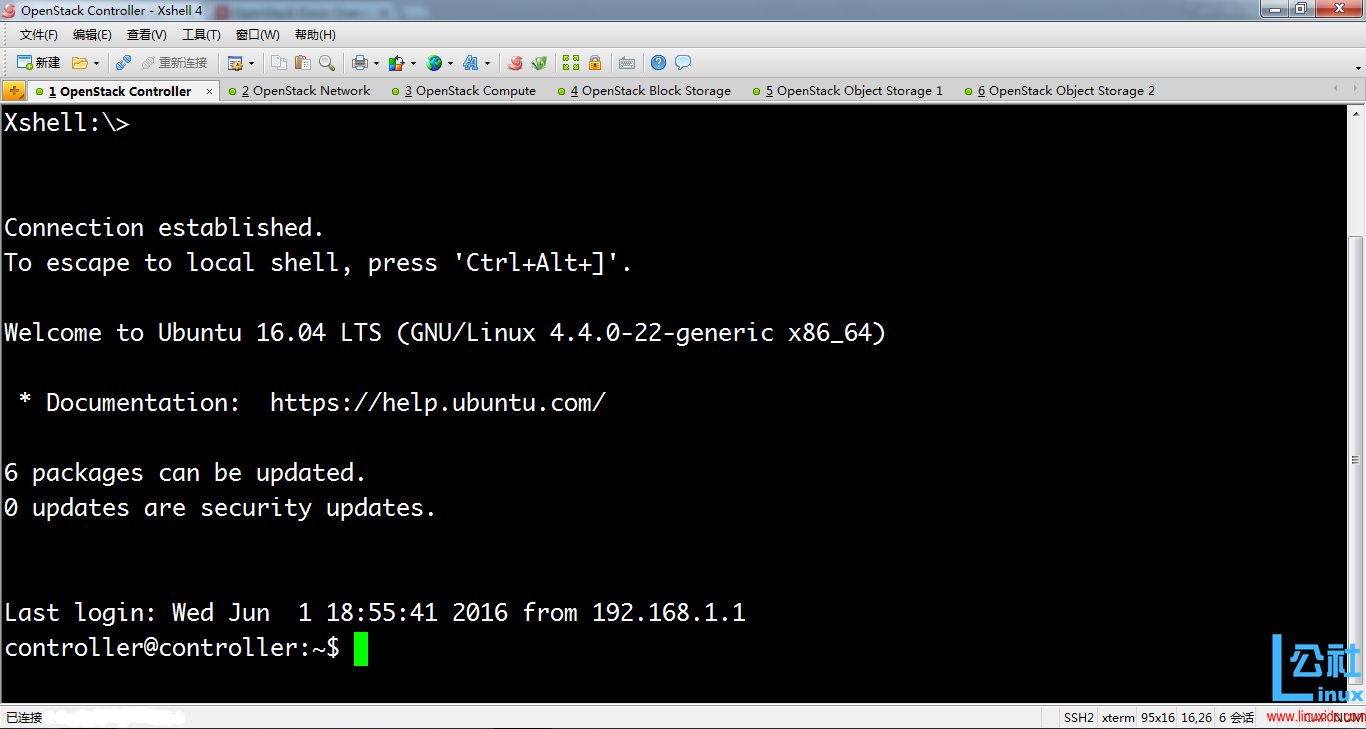

③ 配置完成后,可在外网主机,通过 Xshell 连接 Controller 节点, 如下图:

注 :若 XShell 连接��败,提示Xshell no matching outgoing encryption,可升级 Xshell 版本, 在链接的属性(SSH–> 安全性) 的加密算法列表中选择 aes256-ctr,mac 加密列表中选择 hmac-sha2-256,保存即可。

注:其他节点配置方法类似

-

配置 hosts 文件

以 Controller 节点为例

OpenStack 要求所有的节点主机之间都是通过 host 互信的,编辑所有节点主机的 /etc/hosts 文件,注意将 YOUR_HOST_NAME 替换成本节点主机名称。配置完成后在每台主机上 ping 通 3 个主机名。此外,通过配置 hosts 文件,可在网络环境发生变化时提供可扩展性且便于迁移。

可参考:OpenStack Doc : Controller hosts 文件配置

① 执行sudo vi /etc/hosts,添加如下内容# config all nodes 10.0.0.11 controller 10.0.0.21 network 10.0.0.31 compute 10.0.0.41 blockstorage 10.0.0.51 objectstorage1 10.0.0.52 objectstorage2② 注释掉除

127.0.0.1之外的环回地址项,如下:#127.0.1.1 controller`注:其他节点配置方法类似

至此,节点网络配置完成:

① Controller、Network、Compute 等节点可互相 ping 通;

② Controller、Network、Compute 等节点均可访问外网和进行地址解析。 -

配置 ubuntu 的更新源

使用阿里云的更新源,修改配置文件sudo vi /etc/apt/sources.list,添加:deb http://mirrors.aliyun.com/ubuntu/ xenial main restricted universe multiverse deb http://mirrors.aliyun.com/ubuntu/ xenial-security main restricted universe multiverse deb http://mirrors.aliyun.com/ubuntu/ xenial-updates main restricted universe multiverse deb http://mirrors.aliyun.com/ubuntu/ xenial-proposed main restricted universe multiverse deb http://mirrors.aliyun.com/ubuntu/ xenial-backports main restricted universe multiverse deb-src http://mirrors.aliyun.com/ubuntu/ xenial main restricted universe multiverse deb-src http://mirrors.aliyun.com/ubuntu/ xenial-security main restricted universe multiverse deb-src http://mirrors.aliyun.com/ubuntu/ xenial-updates main restricted universe multiverse deb-src http://mirrors.aliyun.com/ubuntu/ xenial-proposed main restricted universe multiverse deb-src http://mirrors.aliyun.com/ubuntu/ xenial-backports main restricted universe multiverse -

更新系统

① 更新系统sudo apt update sudo apt upgrade sudo apt dist-upgrade sudo apt autoremove可能遇到的问题:

Ubuntu 系统 /boot 容量不足引起的无法更新系统

解决方法:

查看/boot分区容量df -h /boot;查看当前使用内核版本号uname -a;删除旧内核,输入sudo apt-get remove linux-image-,接着按两下 tab 键,将显示所有的内核版本,把目前使用的版本之前的版本全部删除。最后执行sudo update-grub sudo grub-mkconfig -o /boot/grub/grub.cfg② 查看系统发行版本和内核版本

network@network:~$ sudo lsb_release -a No LSB modules are available. Distributor ID: Ubuntu Description: Ubuntu 16.04 LTS Release: 16.04 Codename: xenial network@network:~$ uname -srpi Linux 4.4.0-23-generic x86_64 x86_64 -

服务器时区设置

① 执行sudo tzselect–> 选择亚洲(Asia)–> 选择中国(China)–> 选择北京(Beijing)–>

② 复制文件到 /etc 目录下:sudo cp /usr/share/zoneinfo/Asia/Shanghai /etc/localtime

注:若在系统安装时已设置正确时区,可跳过该步骤。

更多详情见请继续阅读下一页的精彩内容:http://www.linuxidc.com/Linux/2016-09/135488p2.htm

4. OpenStack 节点服务配置

4.1 OpenStack 基本配置

-

统一时间源,安装 NTP 服务

时间服务器将为所有节点提供支持,OpenStack 所有组件的时间都必须同步。本文选择安装chrony。

Controller 节点

① 安装 NTP 服务:sudo apt-get install chrony

② 打开文件sudo vi /etc/chrony/chrony.conf增加以下内容,使本服务器时间与外部服务器时间同步。如果不能访问外网,NTP 服务器将使用本机硬件时钟作为第二选择。allow 10.0.0.0/24 server cn.pool.ntp.org iburst server 127.127.1.0 iburst③ 重启 NTP 使配置生效:

sudo service chrony restart

注 :确保网络时间服务器 IP 地址可以被 DNS 解析,如果不能,则在 /etc/hosts 文件中手工加入。

其他节点

① 安装 NTP 服务:sudo apt-get install chrony

② 打开配置文件sudo vi /etc/chrony/chrony.conf,删除全部默认设置,只添加如下内容:server controller iburst③ 重启 NTP 服务:

sudo service chrony restart

验证配置是否成功chronyc sources -v

注:若默认配置文件误删,可执行sudo apt-get --purge remove chrony清除式卸载 chrony,再重新安装。 -

配置 OpenStack

安装 OpenStack client:sudo apt-get install software-properties-common sudo apt-get update sudo apt-get dist-upgrade sudo apt-get install Python-openstackclient -

安装 SQL 数据库(MySQL/MariaDB)

Controller Node

① 安装 MariaDBsudo apt-get install mariadb-server python-mysqldb② 为 MySQL 的 root 用户设置密码

Database_PASS。(将Database_PASS替换为前面设计的实际密码),若无输入密码提示,可执行下面命令设置 root 用户密码:sudo mysqladmin -u root password Database_PASS注:修改 mysql 用户密码可用以下命令

mysqladmin -u用户名 -p旧密码 password 新密码③ 创建文件

sudo vi /etc/mysql/mariadb.conf.d/openstack.cnf,添加如下配置信息:[mysqld] bind-address = 10.0.0.11 default-storage-engine = innodb innodb_file_per_table collation-server = utf8_general_ci character-set-server = utf8其中,bind-address 用于绑定 MySQL 服务监听地址到 Controller 节点的 Management Network 网口 IP, 以便 Compute&Network 节点访问 MySQL 中的 OpenStack 配置信息。

④ 重启 MySQL 数据库:sudo service mysql restart sudo service mysql status⑤ 查看端口监听情况。

controller@controller:~$ netstat -ntlp | grep 3306 tcp 0 0 10.0.0.11:3306 0.0.0.0:* LISTEN -⑥ 开启 MySQL 安全保护措施

注:测试环境对安全要求较低可忽略该步骤sudo mysql_secure_installation根据提示输入当前 root 用户密码,根据实际需要选择后续操作。

⑦ 测试root用户能否在本机localhost正常登录,执行以下命令:mysql -uroot -p mysql -h localhost -uroot -p若报错:

ERROR 1698 (28000): Access denied for user 'root'@'localhost'解决方法:

sudo mysql -u root use mysql; update user set plugin='' where User='root'; flush privileges; exit;注:下面步骤可省略。

⑧ 测试root用户是否具有远程登录的权限

通常,不赋予root用户远程登录的权限 ,即只允许root用户在本机localhost上登录。可执行如下命令测试:mysql -h controller -uroot -p mysql -h 10.0.0.11 -uroot -p若报错,表示当前

root用户没有远程登录权限:ERROR 1130 (HY000): Host 'controller' is not allowed to connect to this MariaDB server若需要赋予

root远程登录权限,可执行以下命令:

注:将Database_PASS替换为前面设计的实际密码mysql -uroot -p use mysql; GRANT ALL PRIVILEGES ON *.* TO 'root'@'%' IDENTIFIED BY 'Database_PASS'; FLUSH PRIVILEGES;若不报错,可正常登录,表示当前

root用户具有远程登录权限。 -

安装 NoSQL 数据库(MongoDB)

注:只有计量服务(Telemetry Service)用到

Controller Node

① 安装 MongoDBsudo apt-get install mongodb-server mongodb-clients python-pymongo② 打开文件

sudo vi /etc/mongodb.conf,修改配置信息:

绑定 MongoDB 服务监听地址到 Controller 节点的 Management Network 网口 IP。bind_ip = 10.0.0.11MongoDB 数据库默认在目录

/var/lib/mongodb/journal下创建若干 1GB 大小的日志文件,通过添加如下配置信息,可将每个日志文件大小限制为 128 MB,总的日志文件空间大小为 512MB。# Set Journal File Size smallfiles = true③ 删除初始日志文件,重启 MongoDB 服务:

sudo service mongodb stop sudo rm /var/lib/mongodb/journal/prealloc.* sudo service mongodb start -

安装消息队列服务(RabbitMQ)

Controller Node

① 安装 RabbitMQsudo apt-get install rabbitmq-server② 为 OpenStack 添加用户

openstacksudo rabbitmqctl add_user openstack RABBIT_PASS注:将

RABBIT_PASS替换为前面设计的实际密码

③ 为openstack用户配置读、写访问权限:sudo rabbitmqctl set_permissions openstack ".*" ".*" ".*" -

安装 Memcached

身份服务(Identity Service)认证机制需要使用 Memcached 缓存令牌(Token)

Controller Node

① 安装 Memcachedsudo apt-get install memcached python-memcache② 修改配置文件

sudo vi /etc/memcached.conf, 设置 Memcached 服务监听地址(Controller 节点的 Management Network 网口 IP)。-l 10.0.0.11③ 重启 Memcached 服务

sudo service memcached restart注:配置完上面几步后,再

Controller节点上执行netstat -ntlp,查看上面几种服务端口监听是否正常。

4.2 身份服务配置(Identity Service – Keystone)

Identity 服务采用 RESTful 设计,使用 REST API 提供 Web 服务接口。

注:常见的 Web Service 方式有SOAP、WSDL、REST。

部署节点:Controller Node

-

在 MariaDB(MySQL)中创建 Keystone 数据库

① 以 root 用户登录 MySQLmysql -u root -p② 创建数据库

keystoneCREATE DATABASE keystone;③ 授予数据库

keystone适当的权限

注:将KEYSTONE_DBPASS替换为前面设计的实际密码。GRANT ALL PRIVILEGES ON keystone.* TO 'keystone'@'localhost' IDENTIFIED BY 'KEYSTONE_DBPASS'; GRANT ALL PRIVILEGES ON keystone.* TO 'keystone'@'%' IDENTIFIED BY 'KEYSTONE_DBPASS';注:上述授权命令中,

%则代表了所有的 host 都能远程访问该 mysql。但 MySQL 官方文档指出,%并不包括localhost。因此需要对localhost和%都进行授权。

④ 测试keystone用户能否正常登录mysql -hlocalhost -ukeystone -p mysql -hcontroller -ukeystone -p⑤ 测试 Controller 节点上的 MariaDB 能否被 Compute&Network 节点访问。可用

telnet测试,分别在 Compute 节点和 Network 节点上执行以下命令:telnet controller 3306 -

生成临时管理身份认证令牌(ADMIN_TOKEN)

生成一个随机值,作为 keystone 初始配置时的 ADMIN_TOKENopenssl rand -hex 10记住 ADMIN_TOKEN:

d57ea40f3a5eedcc70ef -

安装 Keystone 和 Apache HTTP Server with mod_wsgi

本文采用Apache HTTP server with mod_wsgi监听端口5000和35357提供身份服务。默认keystone服务已经监听端口5000和35357,为避免冲突,需首先关闭keystone服务。

① 关闭keystone服务

新建文件sudo vi /etc/init/keystone.override,添加内容:manual。

② 安装keystone和Apache HTTP serversudo apt-get install keystone apache2 libapache2-mod-wsgi③ 修改配置文件

sudo vi /etc/keystone/keystone.conf

在[DEFAULT]处,修改管理令牌admin_token为前面生成的ADMIN_TOKEN值。

注:修改ADMIN_TOKEN为实际 Token 值:d57ea40f3a5eedcc70efadmin_token = ADMIN_TOKEN在

[database]处,配置数据库访问连接。

注:将KEYSTONE_DBPASS替换为前面设计的实际密码。connection = mysql+pymysql://keystone:KEYSTONE_DBPASS@controller/keystone在

[token]处,配置 Fernet 令牌提供者。provider = fernet④ 将配置信息写入到身份服务数据库

keystone:su root su -s /bin/sh -c "keystone-manage db_sync" keystone⑤ 初始化 Fernet keys:

sudo keystone-manage fernet_setup --keystone-user keystone --keystone-group keystone -

配置 Apache HTTP Server

① 修改配置文件sudo vi /etc/apache2/apache2.conf,将服务器名称 ServerName 指向 Controller 节点的 hostname,添加如下信息:ServerName controller② 新建文件

sudo vi /etc/apache2/sites-available/wsgi-keystone.conf,添加 Apache HTTP Server 配置信息,如下:Listen 5000 Listen 35357 <VirtualHost *:5000> WSGIDaemonProcess keystone-public processes=5 threads=1 user=keystone group=keystone display-name=%{GROUP} WSGIProcessGroup keystone-public WSGIScriptAlias / /usr/bin/keystone-wsgi-public WSGIApplicationGroup %{GLOBAL} WSGIPassAuthorization On ErrorLogFormat "%{cu}t %M" ErrorLog /var/log/apache2/keystone.log CustomLog /var/log/apache2/keystone_access.log combined <Directory /usr/bin> Require all granted </Directory> </VirtualHost> <VirtualHost *:35357> WSGIDaemonProcess keystone-admin processes=5 threads=1 user=keystone group=keystone display-name=%{GROUP} WSGIProcessGroup keystone-admin WSGIScriptAlias / /usr/bin/keystone-wsgi-admin WSGIApplicationGroup %{GLOBAL} WSGIPassAuthorization On ErrorLogFormat "%{cu}t %M" ErrorLog /var/log/apache2/keystone.log CustomLog /var/log/apache2/keystone_access.log combined <Directory /usr/bin> Require all granted </Directory> </VirtualHost>③ 启用身份服务虚拟主机

sudo ln -s /etc/apache2/sites-available/wsgi-keystone.conf /etc/apache2/sites-enabled④ 重启 Apache HTTP Server

sudo service apache2 restart测试是否 Apache HTTP Server 是否正常:

在各节点(Controller、Compute、Network)上,执行 telnet 命令,看能否建立连接telnet controller 35357 telnet controller 5000⑤ 删除 keystone 配置信息默认数据库,Ubuntu 安装包安装 keystone 时默认配置采用 SQLite 数据库存放,但本文改用 MySQL 数据库存储 keystone 配置信息,因此可删除默认 SQLite 数据库。

sudo rm -f /var/lib/keystone/keystone.db -

创建服务实体(Service Entity)和 API 路径(API Endpoints)

身份服务数据库keystone默认是空的,必须使用之前配置时生成的临时认证令牌ADMIN_TOKEN来初始化用于身份服务的服务实体和 API 路径。

① 向openstack命令传递认证令牌值和身份服务 URL

有两种方式:通过 openstack 命令行参数--os-token和--os-url;或者通过设置环境变量OS_TOKEN和OS_URL。建议采用设置环境变量的方式,如下:

注:修改ADMIN_TOKEN为前面生成的实际 Token 值:d57ea40f3a5eedcc70efexport OS_TOKEN=ADMIN_TOKEN export OS_URL=http://controller:35357/v3 export OS_IDENTITY_API_VERSION=3② 创建服务实体

身份服务管理着一个 OpenStack 的服务目录,通过服务目录确定其他服务是否可用。创建服务实体命令如下:openstack service create --name keystone --description "OpenStack Identity" identity③ 创建 API 路径

OpenStack 每个服务可使用三种 API 路径变体:admin,internal和public。默认情况,admin类型的 API 路径可修改用户(user)和租户(tenant),而internal和public类型的 API 路径不允许该操作。创建 API 路径命令如下:openstack endpoint create --region RegionOne identity public http://controller:5000/v3 openstack endpoint create --region RegionOne identity internal http://controller:5000/v3 openstack endpoint create --region RegionOne identity admin http://controller:35357/v3 -

创建域(Domain)、计划(Project)、用户(User)、角色(Role)

① 创建默认域openstack domain create --description "Default Domain" default② 创建管理计划、管理用户、管理角色

admin project、admin user、admin role

注:添加admin用户时需设置密码ADMIN_PASS为前面设计的实际密码。openstack project create --domain default --description "Admin Project" admin openstack user create --domain default --password-prompt admin openstack role create admin注:创建的任何角色都必须映射到 OpenStack 配置文件

policy.json指定的角色。

将admin角色授予admin计划和admin用户:openstack role add --project admin --user admin admin③ 创建服务计划

本文创建的服务计划每个服务仅包含一个唯一用户,可根据实际情况调整。openstack project create --domain default --description "Service Project" service④ 创建示例计划、示例用户、普通用户角色

常规任务(非管理任务)应该使用非特权计划和用户。

注:添加demo用户时需设置密码DEMO_PASS为前面设计的实际密码。openstack project create --domain default --description "Demo Project" demo openstack user create --domain default --password-prompt demo openstack role create user将普通用户角色授予示例计划和示例用户:

openstack role add --project demo --user demo user注:可重复执行上面步骤,创建其他需要的计划和用户。

-

验证 Keystone 组件配置是否正确

① 处于安全考虑,禁用临时身份认证令牌机制。

修改文件sudo vi /etc/keystone/keystone-paste.ini,从[pipeline:public_api]、[pipeline:admin_api],[pipeline:api_v3]处移除admin_token_auth配置信息。

② 取消环境变量OS_TOKEN和OS_URLunset OS_TOKEN OS_URL③ 为

admin用户申请一个身份认证令牌openstack --os-auth-url http://controller:35357/v3 --os-project-domain-name default --os-user-domain-name default --os-project-name admin --os-username admin token issue输入

admin用户密码ADMIN_PASS。(将ADMIN_PASS替换为前面设计的实际密码)

若报错:'NoneType' object has no attribute 'service_catalog'可执行:

export OS_AUTH_TYPE=password

可能还会报错:__init__() got an unexpected keyword argument 'token'在执行下面创建环境脚本后重新测试发现已解决,猜测是环境变量

OS_TOKEN OS_URL未取消,可再次执行unset OS_TOKEN OS_URL试试。

③ 为demo用户申请一个身份认证令牌openstack --os-auth-url http://controller:5000/v3 --os-project-domain-name default --os-user-domain-name default --os-project-name demo --os-username demo token issue输入

demo用户密码DEMO_PASS。(将DEMO_PASS替换为前面设计的实际密码)

注:上述设置 OpenStack 命令行参数的方式比较繁琐,可采用预先创建用户脚本的方式,在申请身份认证令牌时,只需执行如下命令:source ~/.openstack/.admin-openrc openstack token issue或者

source ~/.openstack/.demo-openrc openstack token issue注:创建 OpenStack 客户端环境脚本方法如下

cd ~ mkdir ~/.openstack为管理用户

admin创建 OpenStack 客户端环境脚本,vi ~/.openstack/.admin-openrc,添加

注:将下面ADMIN_PASS替换为前面设计的实际密码# Add environment variables for admin export OS_PROJECT_DOMAIN_NAME=default export OS_USER_DOMAIN_NAME=default export OS_PROJECT_NAME=admin export OS_USERNAME=admin export OS_PASSWORD=ADMIN_PASS export OS_AUTH_URL=http://controller:35357/v3 export OS_AUTH_TYPE=password export OS_IDENTITY_API_VERSION=3 export OS_IMAGE_API_VERSION=2为示例用户

demo创建 OpenStack 客户端环境脚本,vi ~/.openstack/.demo-openrc,添加

注:将下面DEMO_PASS替换为前面设计的实际密码# Add environment variables for demo export OS_PROJECT_DOMAIN_NAME=default export OS_USER_DOMAIN_NAME=default export OS_PROJECT_NAME=demo export OS_USERNAME=demo export OS_PASSWORD=DEMO_PASS export OS_AUTH_URL=http://controller:5000/v3 export OS_AUTH_TYPE=password export OS_IDENTITY_API_VERSION=3 export OS_IMAGE_API_VERSION=2最后,测试 Identity 服务是否正常,访问

http://192.168.1.11:35357/v3或http://192.168.1.11:5000/v3。可在各节点上安装curl,访问服务 API 路径,下载查看信息,如下:sudo apt-get install curl curl http://192.168.1.11:35357/v3 curl http://192.168.1.11:5000/v3 curl http://controller:35357/v3 curl http://controller:5000/v3得到如下信息:

{"version": {"status": "stable", "updated": "2016-04-04T00:00:00Z", "media-types": [{"base": "application/json", "type": "application/vnd.openstack.identity-v3+json"}], "id": "v3.6", "links": [{"href": "http://192.168.10.3:35357/v3/", "rel": "self"}]}}

4.3 镜像服务配置(Image Service – Glance)

用户可使用 OpenStack 镜像服务提供的 REST API 查询、注册、恢复虚拟机镜像。

部署节点:Controller Node

-

在 MariaDB 中创建 glance 数据库

① 以root用户登录 MySQLmysql -u root -p② 创建

glance数据库CREATE DATABASE glance;③ 授予

glance数据库适当权限

注:将GLANCE_DBPASS替换为前面设计的实际密码GRANT ALL PRIVILEGES ON glance.* TO 'glance'@'localhost' IDENTIFIED BY 'GLANCE_DBPASS'; GRANT ALL PRIVILEGES ON glance.* TO 'glance'@'%' IDENTIFIED BY 'GLANCE_DBPASS'; -

创建 Glance 服务实体和 API 路径

① 设置 OpenStack 中admin用户环境变量source ~/.openstack/.admin-openrc② 在 OpenStack 中创建一个 glance 用户

openstack user create --domain default --password-prompt glance输入用户

glance的密码GLANCE_PASS(将GLANCE_PASS替换为前面设计的实际密码)。

③ 将admin角色授予glance用户和service计划openstack role add --project service --user glance admin④ 创建 glance 服务实体

openstack service create --name glance --description "OpenStack Image" image⑤ 创建镜像服务 API 路径

openstack endpoint create --region RegionOne image public http://controller:9292 openstack endpoint create --region RegionOne image internal http://controller:9292 openstack endpoint create --region RegionOne image admin http://controller:9292 -

安装和配置 Glance 服务组件

① 安装 Glancesudo apt-get install glance② 修改配置文件

sudo vi /etc/glance/glance-api.conf。

注:将GLANCE_DBPASS和GLANCE_PASS替换为前面设计的实际密码。

在[database]处,配置数据库访问连接。connection = mysql+pymysql://glance:GLANCE_DBPASS@controller/glance在

[keystone_authtoken]和[paste_deploy]处,配置身份服务访问。

注:注释掉[keystone_authtoken]处所有默认内容[keystone_authtoken] auth_uri = http://controller:5000 auth_url = http://controller:35357 memcached_servers = controller:11211 auth_type = password project_domain_name = default user_domain_name = default project_name = service username = glance password = GLANCE_PASS [paste_deploy] flavor = keystone在 `[glance_store]处配置本地文件系统存储和镜像文件存储位置。

stores = file,http default_store = file filesystem_store_datadir = /var/lib/glance/images/③ 修改配置文件

sudo vi /etc/glance/glance-registry.conf。

注:将GLANCE_DBPASS和GLANCE_PASS替换为前面设计的实际密码。

在[database]处,配置数据库访问连接。connection = mysql+pymysql://glance:GLANCE_DBPASS@controller/glance在

[keystone_authtoken]和[paste_deploy]处,配置身份服务访问。

注:注释掉[keystone_authtoken]处所有默认内容[keystone_authtoken] auth_uri = http://controller:5000 auth_url = http://controller:35357 memcached_servers = controller:11211 auth_type = password project_domain_name = default user_domain_name = default project_name = service username = glance password = GLANCE_PASS [paste_deploy] flavor = keystone④ 将配置信息写入 glance 数据库

su root su -s /bin/sh -c "glance-manage db_sync" glance⑥ 重启 Image Service

sudo service glance-registry restart sudo service glance-api restart -

验证 Glance 服务组件配置是否正确

① 设置 OpenStackadmin用户环境变量source ~/.openstack/.admin-openrc② 下载 CirrOS 系统镜像

注:此处采用CirrOS镜像测试,也可自行选择其他系统镜像wget http://download.cirros-cloud.net/0.3.4/cirros-0.3.4-x86_64-disk.img③ 上传镜像,设置镜像参数磁盘格式

QEMU Copy On Write 2 (QCOW2)、容器格式bare及可见性public。openstack image create "cirros" --file cirros-0.3.4-x86_64-disk.img --disk-format qcow2 --container-format bare --public④ 确认上传是否成功,验证镜像属性。

controller@controller:~$ openstack image list Password: +--------------------------------------+-------------------------+--------+ | ID | Name | Status | +--------------------------------------+-------------------------+--------+ | 6d07d4e1-3b9d-4986-b1d7-8dd92ec9bd2c | cirros | active | +--------------------------------------+-------------------------+--------+

4.4 计算服务配置(Compute Service – Nova)

部署节点:Controller Node

在 Controller 节点上需要安装 nova-api、nova-conductor、nova-consoleauth、nova-novncproxy、nova-scheduler

-

在 MariaDB(MySQL)中创建数据库

nova_api和nova

① 以root用户登录 MySQLmysql -u root -p② 创建

nova_api和nova数据库CREATE DATABASE nova_api; CREATE DATABASE nova;③ 授予

nova_api和nova数据库适当权限

注:将NOVA_DBPASS替换为前面设计的实际密码GRANT ALL PRIVILEGES ON nova_api.* TO 'nova'@'localhost' IDENTIFIED BY 'NOVA_DBPASS'; GRANT ALL PRIVILEGES ON nova_api.* TO 'nova'@'%' IDENTIFIED BY 'NOVA_DBPASS'; GRANT ALL PRIVILEGES ON nova.* TO 'nova'@'localhost' IDENTIFIED BY 'NOVA_DBPASS'; GRANT ALL PRIVILEGES ON nova.* TO 'nova'@'%' IDENTIFIED BY 'NOVA_DBPASS'; -

创建计算服务证书和 API 路径

① 设置 OpenStackadmin用户环境变量source ~/.openstack/.admin-openrc② 在 OpenStack 中创建

nova用户openstack user create --domain default --password-prompt nova输入用户

nova的密码NOVA_PASS(将NOVA_PASS替换为前面设计的实际密码)。

③ 将admin角色授予nova用户openstack role add --project service --user nova admin④ 创建

nova服务实体openstack service create --name nova --description "OpenStack Compute" compute⑤ 创建计算服务 API 路径

openstack endpoint create --region RegionOne compute public http://controller:8774/v2.1/%\(tenant_id\)s openstack endpoint create --region RegionOne compute internal http://controller:8774/v2.1/%\(tenant_id\)s openstack endpoint create --region RegionOne compute admin http://controller:8774/v2.1/%\(tenant_id\)s -

安装计算服务组件

① 安装 Nova 组件sudo apt-get install nova-api nova-conductor nova-consoleauth nova-novncproxy nova-scheduler② 修改配置文件

sudo vi /etc/nova/nova.conf。

在[DEFAULT]处只启用compute和metadataAPIs,将enabled_apis=ec2,osapi_compute,metadata修改为:

enabled_apis = osapi_compute,metadata在

[api_database]和[database]处配置数据库访问连接(若没有[api_database]和[database]标记,则手动添加)

注:将NOVA_DBPASS替换为前面设计的实际密码[api_database] connection = mysql+pymysql://nova:NOVA_DBPASS@controller/nova_api [database] connection = mysql+pymysql://nova:NOVA_DBPASS@controller/nova在

[DEFAULT]和[oslo_messaging_rabbit]处配置 RabbitMQ 消息队里访问

注:将RABBIT_PASS替换为前面设计的实际密码[DEFAULT] rpc_backend = rabbit [oslo_messaging_rabbit] rabbit_host = controller rabbit_userid = openstack rabbit_password = RABBIT_PASS在

[DEFAULT]和[keystone_authtoken]处配置身份服务访问

注:将NOVA_PASS替换为前面设计的实际密码

注:注释或删除[keystone_authtoken]处其他内容[DEFAULT] auth_strategy = keystone [keystone_authtoken] auth_uri = http://controller:5000 auth_url = http://controller:35357 memcached_servers = controller:11211 auth_type = password project_domain_name = default user_domain_name = default project_name = service username = nova password = NOVA_PASS在

[DEFAULT]处配置my_ip为 Controller 节点 Management Network 网口地址[DEFAULT] my_ip = 10.0.0.11在

[DEFAULT]处启用网络服务支持

注:默认情况下,计算服务使用主机内部防火墙驱动,因此必须禁用 OpenStack 网络服务中的防火墙驱动。[DEFAULT] use_neutron = True firewall_driver = nova.virt.firewall.NoopFirewallDriver在

[vnc]处,使用 Controller 节点 Management Network 网口地址配置 VNC 代理(VNC proxy)。[vnc] vncserver_listen = $my_ip vncserver_proxyclient_address = $my_ip在

[glance]处配置镜像服务 API 位置[glance] api_servers = http://controller:9292在

[oslo_concurrency]处配置lock_path[oslo_concurrency] lock_path = /var/lib/nova/tmp最后,由于安装包 BUG,需要在

[DEFAULT]处移除logdir。在[DEFAULT]处删除,以下内容logdir=/var/log/nova③ 将配置信息写入计算服务数据库

novasu root su -s /bin/sh -c "nova-manage api_db sync" nova su -s /bin/sh -c "nova-manage db sync" nova④ 重启计算服务

sudo service nova-api restart sudo service nova-consoleauth restart sudo service nova-scheduler restart sudo service nova-conductor restart sudo service nova-novncproxy restart

部署节点:Compute Node

在 Compute 节点上需要安装 nova-compute。

注:以下步骤在 Compute 节点上执行

-

安装配置计算服务组件

安装nova-compute组件sudo apt-get install nova-compute -

修改配置文件

sudo vi /etc/nova/nova.conf

① 在[DEFAULT]和[oslo_messaging_rabbit]处配置 RabbitMQ 消息队列访问

注:将RABBIT_PASS替换为前面设计的实际密码[DEFAULT] rpc_backend = rabbit [oslo_messaging_rabbit] rabbit_host = controller rabbit_userid = openstack rabbit_password = RABBIT_PASS② 在

[DEFAULT]和[keystone_authtoken]处配置身份服务访问

注:将NOVA_PASS替换为前面设计的实际密码

注:注释或删除[keystone_authtoken]处其他内容[DEFAULT] auth_strategy = keystone [keystone_authtoken] auth_uri = http://controller:5000 auth_url = http://controller:35357 memcached_servers = controller:11211 auth_type = password project_domain_name = default user_domain_name = default project_name = service username = nova password = NOVA_PASS在

[DEFAULT]处配置my_ip为 Compute 节点 Management Network 网口地址[DEFAULT] my_ip = 10.0.0.31在

[DEFAULT]处启用网络服务支持[DEFAULT] use_neutron = True firewall_driver = nova.virt.firewall.NoopFirewallDriver在

[vnc]处配置远程控制访问[vnc] enabled = True vncserver_listen = 0.0.0.0 vncserver_proxyclient_address = $my_ip novncproxy_base_url = http://controller:6080/vnc_auto.html注: VNC 服务器端监听所有地址,VNC 代理客户端只监听 Compute 节点 Management Network 网口地址,base URL 设置 Compute 节点远程控制台浏览器访问地址(若浏览无法解析 controller,则需替换为相应 IP 地址)。

在[glance]处配置镜像服务 API[glance] api_servers = http://controller:9292在

[oslo_concurrency]处配置lock_path[oslo_concurrency] lock_path = /var/lib/nova/tmp最后,由于安装包 BUG,需要在

[DEFAULT]处移除logdir。在[DEFAULT]处删除,以下内容logdir=/var/log/nova -

完成安装,重启计算服务

① 检测是否支持虚拟机硬件加速egrep -c '(vmx|svm)' /proc/cpuinfo若返回结果大于等于 1,则支持,无需做额外配置;

若返回结果 0,则不支持硬件加速,需要做以下额外配置:修改配置文件sudo vi /etc/nova/nova-compute.conf中的libvirt设置项,使用QEMU代替KVM。[libvirt] virt_type = qemu② 重启计算服务

sudo service nova-compute restart -

验证计算服务是否安装正确

注:以下步骤需在 Controller 节点执行

① 设置 OpenStackadmin用户环境变量source ~/.openstack/.admin-openrc② 打印服务组件列表,验证每个成功启动和注册的进程。

openstack compute service list结果如下:

+--+----------------+----------+--------+-------+-----+--------------------------+ |Id| Binary | Host | Zone |Status |State| Updated At | +--+----------------+----------+--------+-------+-----+--------------------------+ | 4|nova-consoleauth|controller|internal|enabled| up |2016-05-29T06:28:52.000000| | 5|nova-scheduler |controller|internal|enabled| up |2016-05-29T06:28:51.000000| | 6|nova-conductor |controller|internal|enabled| up |2016-05-29T06:28:53.000000| | 7|nova-compute |compute |nova |enabled| up |2016-05-29T06:28:45.000000| +--+----------------+----------+--------+-------+-----+--------------------------+

4.5 网络服务配置(Networking Service – Neutron)

部署节点:Controller Node

-

在 MariaDB(MySQL)中创建

neutron数据库

① 以 root 用户登录 MySQLmysql -u root -p② 创建数据库

neutronCREATE DATABASE neutron;③ 授予数据库

neutron适当的权限

注:将NEUTRON_DBPASS替换为前面设计的实际密码。GRANT ALL PRIVILEGES ON neutron.* TO 'neutron'@'localhost' IDENTIFIED BY 'NEUTRON_DBPASS'; GRANT ALL PRIVILEGES ON neutron.* TO 'neutron'@'%' IDENTIFIED BY 'NEUTRON_DBPASS'; -

创建网络服务证书和 API 路径

① 设置 OpenStackadmin用户环境变量source ~/.openstack/.admin-openrc② 在 OpenStack 中创建

neutron用户openstack user create --domain default --password-prompt neutron输入用户

neutron的密码NEUTRON_PASS(将NEUTRON_PASS替换为前面设计的实际密码)。

③ 将admin角色授予neutron用户openstack role add --project service --user neutron admin④ 创建

neutron服务实体openstack service create --name neutron --description "OpenStack Networking" network⑤ 创建网络服务 API 路径

openstack endpoint create --region RegionOne network public http://controller:9696 openstack endpoint create --region RegionOne network internal http://controller:9696 openstack endpoint create --region RegionOne network admin http://controller:9696 -

安装配置

neutron-server服务组件

① 安装neutron-server组件sudo apt-get install neutron-server neutron-plugin-ml2② 修改配置文件

sudo vi /etc/neutron/neutron.conf

在[database]处配置网络服务数据库neutron访问连接

注:将NEUTRON_DBPASS替换为前面设计的实际密码

注:首先注释掉[database]处已存在的默认的connection[database] # connection = sqlite:////var/lib/neutron/neutron.sqlite connection = mysql+pymysql://neutron:NEUTRON_DBPASS@controller/neutron在

[DEFAULT]处启用Modular Layer 2 (ML2) plug-in、router service和overlapping IP addresses[DEFAULT] core_plugin = ml2 service_plugins = router allow_overlapping_ips = True在

[DEFAULT]和[oslo_messaging_rabbit]处配置 RabbitMQ 消息队列访问

注:将RABBIT_PASS替换为前面设计的实际密码[DEFAULT] rpc_backend = rabbit [oslo_messaging_rabbit] rabbit_host = controller rabbit_userid = openstack rabbit_password = RABBIT_PASS在

[DEFAULT]和[keystone_authtoken]处配置身份服务访问

注:将NEUTRON_PASS替换为前面设计的实际密码

注:注释或删除[keystone_authtoken]处其他配置信息[DEFAULT] auth_strategy = keystone [keystone_authtoken] auth_uri = http://controller:5000 auth_url = http://controller:35357 memcached_servers = controller:11211 auth_type = password project_domain_name = default user_domain_name = default project_name = service username = neutron password = NEUTRON_PASS在

[DEFAULT]和[nova]处配置网络来通知计算节点网络拓扑变化。

注:将NOVA_PASS替换为前面设计的实际密码[DEFAULT] notify_nova_on_port_status_changes = True notify_nova_on_port_data_changes = True [nova] auth_url = http://controller:35357 auth_type = password project_domain_name = default user_domain_name = default region_name = RegionOne project_name = service username = nova password = NOVA_PASS -

配置

Modular Layer 2 (ML2)插件

ML2 plug-in 使用 Linux 网桥机制为 OpenStack 实例建立 layer- 2 虚拟网络设施(桥接和交换)。

修改配置文件sudo vi /etc/neutron/plugins/ml2/ml2_conf.ini

① 在[ml2]处启用flat、VLAN、VXLAN网络

注:在配置ML2插件后,移除 type_drivers 设置项的部分值,将导致数据库不一致。[ml2] type_drivers = flat,vlan,vxlan② 在

[ml2]处启用VXLAN self-service网络[ml2] tenant_network_types = vxlan③ 在

[ml2]处启用Linux bridge和layer-2 population机制[ml2] mechanism_drivers = linuxbridge,l2population注:

Linux Bridge Agent只支持VXLAN overlay networks

④ 在[ml2]处启用端口安全扩展驱动[ml2] extension_drivers = port_security⑤ 在

[ml2_type_flat]处配置运营商虚拟网络为flat network[ml2_type_flat] flat_networks = provider⑥ 在

[ml2_type_vxlan]处配置自服务网络中的VXLAN网络标识符范围[ml2_type_vxlan] vni_ranges = 1:1000⑦ 在

[securitygroup]处启用ipset来增强安全组规则的效率[securitygroup] enable_ipset = True -

将配置信息写入

neutron数据库su root su -s /bin/sh -c "neutron-db-manage --config-file /etc/neutron/neutron.conf --config-file /etc/neutron/plugins/ml2/ml2_conf.ini upgrade head" neutron -

为计算服务配置网络访问服务

修改配置文件sudo vi /etc/nova/nova.conf

在[neutron]处配置访问参数,启用元数据服务代理,配置元数据代理共享密钥

注:将NEUTRON_PASS和METADATA_SECRET替换为前面设计的实际密码[neutron] url = http://controller:9696 auth_url = http://controller:35357 auth_type = password project_domain_name = default user_domain_name = default region_name = RegionOne project_name = service username = neutron password = NEUTRON_PASS service_metadata_proxy = True metadata_proxy_shared_secret = METADATA_SECRET -

重启计算服务 API 和网络服务

sudo service nova-api restart sudo service neutron-server restart

部署节点:Network Node

在 Network 节点上部署组件:neutron-linuxbridge-agent、neutron-l3-agent、neutron-dhcp-agent、neutron-metadata-agent

网络服务部署架构有两种方式 Provider Networks 和Self-Service Networks,在本文开头作了简要介绍。本文采用 Self-Service Networks 方式部署。

参考文档:Deploy Networking Service using the Architecture of Self-Service Networks

-

安装网络服务组件

sudo apt-get install neutron-linuxbridge-agent neutron-l3-agent neutron-dhcp-agent neutron-metadata-agent -

配置公共服务组件

公共组件配置包括认证机制、消息队列。修改配置文件sudo vi /etc/neutron/neutron.conf

① 在[database]处注释掉其他所有设置项,因为Network节点不需要直接访问数据库。

② 在[DEFAULT]和[oslo_messaging_rabbit]处配置 RabbitMQ 消息队列访问

注:将RABBIT_PASS替换为前面设计的实际密码[DEFAULT] rpc_backend = rabbit [oslo_messaging_rabbit] rabbit_host = controller rabbit_userid = openstack rabbit_password = RABBIT_PASS③ 在

[DEFAULT]和[keystone_authtoken]处配置身份服务访问

注:将NEUTRON_PASS替换为前面设计的实际密码

注:注释或删除[keystone_authtoken]处其他配置信息[DEFAULT] auth_strategy = keystone [keystone_authtoken] auth_uri = http://controller:5000 auth_url = http://controller:35357 memcached_servers = controller:11211 auth_type = password project_domain_name = default user_domain_name = default project_name = service username = neutron password = NEUTRON_PASS -

配置 Linux 网桥代理

Linux bridge agent 为实例建立了二层虚拟网络设施,而且可以管理安全组。

���改配置文件sudo vi /etc/neutron/plugins/ml2/linuxbridge_agent.ini

① 在[linux_bridge]处将虚拟网络映射到物理网络

注:将PROVIDER_INTERFACE_NAME替换为 Network 节点 External Network 网络接口名称eth0[linux_bridge] physical_interface_mappings = provider:PROVIDER_INTERFACE_NAME② 在

[vxlan]处启用VXLAN overlay networks,配置管理 Overlay 网络的物理网络 IP 地址,启用layer-2 population

注:将OVERLAY_INTERFACE_IP_ADDRESS替换为 Network 节点 Management Network 网络接口 IP 地址10.0.0.21[vxlan] enable_vxlan = True local_ip = OVERLAY_INTERFACE_IP_ADDRESS l2_population = True③ 在

[securitygroup]处启用安全组,并配置Linux bridge iptables firewall driver[securitygroup] enable_security_group = True firewall_driver = neutron.agent.linux.iptables_firewall.IptablesFirewallDriver -

配置三层网络代理

L3(Layer-3) Agent位自服务网络提供了路由和 NAT 服务。

修改配置文件sudo vi /etc/neutron/l3_agent.ini,在[DEFAULT]处配置 Linux 网桥接口驱动(Linux Bridge Interface Driver)和外网网桥。[DEFAULT] interface_driver = neutron.agent.linux.interface.BridgeInterfaceDriver external_network_bridge =注:

external_network_bridge值故意空缺,这样可使多个外部网络共用一个代理。 -

配置

DHCP代理

修改配置文件sudo vi /etc/neutron/dhcp_agent.ini,在[DEFAULT]处配置Linux bridge interface driver和Dnsmasq DHCP driver,启用独立的metadata使运营商网络实例可以访问虚拟网络元信息。[DEFAULT] interface_driver = neutron.agent.linux.interface.BridgeInterfaceDriver dhcp_driver = neutron.agent.linux.dhcp.Dnsmasq enable_isolated_metadata = True -

配置元数据代理

元数据代理提供一些诸如证书之类的配置信息。

修改配置文件sudo vi /etc/neutron/metadata_agent.ini,在[DEFAULT]处配置元数据主机和共享密钥。

注:将METADATA_SECRET替换为前面设计的实际密码[DEFAULT] nova_metadata_ip = controller metadata_proxy_shared_secret = METADATA_SECRET -

重启网络服务代理

sudo service neutron-linuxbridge-agent restart sudo service neutron-dhcp-agent restart sudo service neutron-metadata-agent restart sudo service neutron-l3-agent restart

部署节点:Compute Node

-

安装网络服务组件

sudo apt-get install neutron-linuxbridge-agent -

配置公共组件

公共组件配置包括认证机制、消息队列、插件。

修改配置文件sudo vi /etc/neutron/neutron.conf

① 在[database]处注释掉其他所有设置项,因为Compute节点不需要直接访问数据库。

② 在[DEFAULT]和[oslo_messaging_rabbit]处配置RabbitMQ消息队列访问

注:将RABBIT_PASS替换为前面设计的实际密码[DEFAULT] rpc_backend = rabbit [oslo_messaging_rabbit] rabbit_host = controller rabbit_userid = openstack rabbit_password = RABBIT_PASS③ 在

[DEFAULT]和[keystone_authtoken]处配置身份服务访问

注:将NEUTRON_PASS替换为前面设计的实际密码

注:注释或删除[keystone_authtoken]处其他项[DEFAULT] auth_strategy = keystone [keystone_authtoken] auth_uri = http://controller:5000 auth_url = http://controller:35357 memcached_servers = controller:11211 auth_type = password project_domain_name = default user_domain_name = default project_name = service username = neutron password = NEUTRON_PASS -

配置网络设置

配置 Linux 网桥代理,修改配置文件sudo vi /etc/neutron/plugins/ml2/linuxbridge_agent.ini

① 在[linux_bridge]处将虚拟网络映射到物理网络

注:将PROVIDER_INTERFACE_NAME替换为 Compute 节点 External Network 网络接口名称eth0。[linux_bridge] physical_interface_mappings = provider:PROVIDER_INTERFACE_NAME② 在

[vxlan]处启用VXLAN覆盖网络,配置管理覆盖网络的物理网络接口 IP 地址,启用layer-2 population

注:将OVERLAY_INTERFACE_IP_ADDRESS替换为 Compute 节点 Management Network 网络接口 IP 地址10.0.0.31[vxlan] enable_vxlan = True local_ip = OVERLAY_INTERFACE_IP_ADDRESS l2_population = True③ 在

[securitygroup]处启用安全组,配置Linux bridge iptables firewall driver[securitygroup] enable_security_group = True firewall_driver = neutron.agent.linux.iptables_firewall.IptablesFirewallDriver -

配置计算服务访问网络

修改配置文件sudo vi /etc/nova/nova.conf

① 在[neutron]处配置访问参数

注:将NEUTRON_PASS替换为前面设计的实际密码[neutron] url = http://controller:9696 auth_url = http://controller:35357 auth_type = password project_domain_name = default user_domain_name = default region_name = RegionOne project_name = service username = neutron password = NEUTRON_PASS② 重启计算服务

sudo service nova-compute restart③ 重启 Linux 网桥代理

sudo service neutron-linuxbridge-agent restart -

验证网络服务是否安装配置正确

① 在 Controller 节点上设置 OpenStack 管理用户admin的环境变量source ~/.openstack/.admin-openrc② 列出已加载的扩展包,验证成功启动的

neutron-server进程neutron ext-list neutron agent-list

4.6 仪表盘服务配置(Dashboard Service – Horizon)

仪表盘是一个 Web 接口,可使云管理员和用户管理各种各样的 OpenStack 资源和服务。本文采用 Apache Web Server 部署 Dashboard 服务。

部署节点:Controller Node

-

安装

Horizonsudo apt-get install openstack-dashboard若遇到由于

openstack-dashboard-ubuntu-theme无法安装的问题,可执行如下命令:dpkg --remove --force-remove-reinstreq openstack-dashboard-ubuntu-theme -

修改配置文件

sudo vi /etc/openstack-dashboard/local_settings.py

① 在controller节点上配置horizon使用OpenStack Service。OPENSTACK_HOST = "controller"② 配置允许所有主机都可以访问

horizonALLOWED_HOSTS = ['*', ]③ 配置

memcached session storage service

注:注释掉其他session storage配置信息SESSION_ENGINE = 'django.contrib.sessions.backends.cache' CACHES = {'default': {'BACKEND': 'django.core.cache.backends.memcached.MemcachedCache', 'LOCATION': 'controller:11211', } }④ 启用

Identity API version 3OPENSTACK_KEYSTONE_URL = "http://%s:5000/v3" % OPENSTACK_HOST⑤ 启用域名支持

OPENSTACK_KEYSTONE_MULTIDOMAIN_SUPPORT = True⑥ 配置 API 版本

OPENSTACK_API_VERSIONS = {"identity": 3, "image": 2, "volume": 2, }⑦ 配置通过

Dashboard创建的用户默认域名为defaultOPENSTACK_KEYSTONE_DEFAULT_DOMAIN = "default"⑧ 配置通过

Dashboard创建的用户的角色默认为userOPENSTACK_KEYSTONE_DEFAULT_ROLE = "user"⑨ 配置时区

注:该步骤可选配置TIME_ZONE = "Asia/Shanghai" -

重新加载 Apache 服务

sudo service apache2 reload -

验证

Dashboard服务是否部署成功http://controller/horizon -

在物理主机中为 Dashboard 外网访问配置端口映射

① 利用 Windows 自带的netsh配置端口映射,打开cmd命令行,输入:netsh interface portproxy add v4tov4 listenport=11180 connectaddress=192.168.1.11 connectport=80② 在系统防火墙高级设置中配置入站规则

新建规则–> 端口–> 特定本地端口:11180–> 允许连接–> 选择域 / 专用 / 公用–> 名称:VMware OpenStack Dashboard HTTP Service、描述:用于 VMware 中 OpenStack 云计算平台 Dashboard 服务的 Web 访问

③ 利用 Windows 自带的netsh配置端口映射,打开cmd命令行,输入:netsh interface portproxy add v4tov4 listenport=6080 connectaddress=192.168.1.11 connectport=6080④ 在系统防火墙高级设置中配置入站规则

新建规则–> 端口–> 特定本地端口:6080–> 允许连接–> 选择域 / 专用 / 公用–> 名称:VMware OpenStack Compute Service of Nova Proxy、描述:用于 VMware 中 OpenStack 云计算平台 Nova Proxy 服务的 Web 访问

4.7 块存储服务配置(Block Storage Service – Cinder)

部署节点:Controller Node

-

在 MariaDB(MySQL)中创建数据库

cinder

① 以root用户登录 MySQLmysql -u root -p② 创建

cinder数据库CREATE DATABASE cinder;③ 授予

cinder数据库适当权限

注:将CINDER_DBPASS替换为前面设计的实际密码GRANT ALL PRIVILEGES ON cinder.* TO 'cinder'@'localhost' IDENTIFIED BY 'CINDER_DBPASS'; GRANT ALL PRIVILEGES ON cinder.* TO 'cinder'@'%' IDENTIFIED BY 'CINDER_DBPASS'; -

创建 Cinder 服务实体和 API 路径

① 设置 OpenStack 中admin用户环境变量source ~/.openstack/.admin-openrc② 在 OpenStack 中创建一个

cinder用户openstack user create --domain default --password-prompt cinder输入用户

cinder的密码CINDER_PASS(将CINDER_PASS替换为前面设计的实际密码)。

③ 将admin角色授予cinder用户openstack role add --project service --user cinder admin④ 创建

cinder和cinderv2服务实体openstack service create --name cinder --description "OpenStack Block Storage" volume openstack service create --name cinderv2 --description "OpenStack Block Storage" volumev2⑤ 创建块存储服务 API 路径

openstack endpoint create --region RegionOne volume public http://controller:8776/v1/%\(tenant_id\)s openstack endpoint create --region RegionOne volume internal http://controller:8776/v1/%\(tenant_id\)s openstack endpoint create --region RegionOne volume admin http://controller:8776/v1/%\(tenant_id\)s openstack endpoint create --region RegionOne volumev2 public http://controller:8776/v2/%\(tenant_id\)s openstack endpoint create --region RegionOne volumev2 internal http://controller:8776/v2/%\(tenant_id\)s openstack endpoint create --region RegionOne volumev2 admin http://controller:8776/v2/%\(tenant_id\)s -

安装和配置 Cinder 服务组件

① 安装 Cindersudo apt-get install cinder-api cinder-scheduler② 修改配置文件

sudo vi /etc/cinder/cinder.conf。

注:将CINDER_DBPASS、CINDER_PASS和RABBIT_PASS替换为前面设计的实际密码。

在[database]处配置数据访问连接:[database] connection = mysql+pymysql://cinder:CINDER_DBPASS@controller/cinder在

[DEFAULT]和[oslo_messaging_rabbit]处配置 RabbitMQ 消息队列访问:[DEFAULT] rpc_backend = rabbit [oslo_messaging_rabbit] rabbit_host = controller rabbit_userid = openstack rabbit_password = RABBIT_PASS在

[DEFAULT]和[keystone_authtoken]处配置认证服务访问:

注:注释或删除[keystone_authtoken]处其他默认设置。[DEFAULT] auth_strategy = keystone [keystone_authtoken] auth_uri = http://controller:5000 auth_url = http://controller:35357 memcached_servers = controller:11211 auth_type = password project_domain_name = default user_domain_name = default project_name = service username = cinder password = CINDER_PASS在

[DEFAULT]处配置my_ip为 Controller 节点 Management Networ 网络接口地址:[DEFAULT] my_ip = 10.0.0.11在

[oslo_concurrency]处配置lock_path:[oslo_concurrency] lock_path = /var/lib/cinder/tmp③ 将配置信息写入块存储服务数据库

cindersu root su -s /bin/sh -c "cinder-manage db sync" cinder -

配置计算服务调用块存储服务

修改配置文件sudo vi /etc/nova/nova.conf,添加如下信息:[cinder] os_region_name = RegionOne -

重启计算服务 API 和块存储服务

sudo service nova-api restart sudo service cinder-scheduler restart sudo service cinder-api restart

部署节点:BlockStorage Node

-

安装配置 LVM

① 安装 LVM:sudo apt-get install lvm2② 创建 LVM 物理卷

/dev/sdb:sudo pvcreate /dev/sdb③ 创建 LVM 卷组

cinder-volumessudo vgcreate cinder-volumes /dev/sdb④ 配置只有 OpenStack 实例才可以访问块存储卷

修改配置文件sudo vi /etc/lvm/lvm.conf,在devices处添加一个过滤器,使 OpenStack 实例只允许访问/dev/sdb。filter = ["a/sdb/", "r/.*/"]注:如果块存储节点操作系统磁盘也使用了逻辑卷管理 LVM,则在过滤器中必须将操作系统磁盘 LVM 所在设备

/dev/sda也添加到允许访问列表。例如本文各节点系统磁盘均采用 LVM,则应添加下面过滤器:filter = ["a/sda/", "a/sdb/", "r/.*/"]注:如果 Compute 节点操作系统磁盘(如

/dev/sda)也使用 LVM,则必须在Compute 节点上修改配置文件sudo vi /etc/lvm/lvm.conf,将操作系统磁盘添加到过滤器允许访问列表。如下:filter = ["a/sda/", "r/.*/"] -

安装配置块存储服务组件

① 安装cindersudo apt-get install cinder-volume② 修改配置文件

sudo vi /etc/cinder/cinder.conf

注:将CINDER_DBPASS、CINDER_PASS和RABBIT_PASS替换为前面设计的实际密码。

在[database]处配置数据库访问连接:[database] connection = mysql+pymysql://cinder:CINDER_DBPASS@controller/cinder在

[DEFAULT]和[oslo_messaging_rabbit]处配置 RabbitMQ 消息队列访问服务:[DEFAULT] rpc_backend = rabbit [oslo_messaging_rabbit] rabbit_host = controller rabbit_userid = openstack rabbit_password = RABBIT_PASS在

[DEFAULT]和[keystone_authtoken]处配置身份认证服务访问:

注:注释或删除[keystone_authtoken]处其他默认配置信息[DEFAULT] auth_strategy = keystone [keystone_authtoken] auth_uri = http://controller:5000 auth_url = http://controller:35357 memcached_servers = controller:11211 auth_type = password project_domain_name = default user_domain_name = default project_name = service username = cinder password = CINDER_PASS在

[DEFAULT]处配置my_ip为 BlockStorage 节点 Management Networ 网络接口地址:[DEFAULT] my_ip = 10.0.0.41在

[lvm]处添加 LVM 后端驱动、卷组、iSCSI 协议和服务,如下:[lvm] volume_driver = cinder.volume.drivers.lvm.LVMVolumeDriver volume_group = cinder-volumes iscsi_protocol = iscsi iscsi_helper = tgtadm在

[DEFAULT]处配置 LVM 后端名称(可任意设置,为了简单,本文设置为 lvm):[DEFAULT] enabled_backends = lvm在

[DEFAULT]处配置镜像服务 API 路径:[DEFAULT] glance_api_servers = http://controller:9292在

[oslo_concurrency]处配置lock_path:[oslo_concurrency] lock_path = /var/lib/cinder/tmp③ 重启块存储服务

sudo service tgt restart sudo service cinder-volume restart -

验证块存储服务是否安装配置正确

① 在 Controller 节点上设置 OpenStack 管理用户admin的环境变量source ~/.openstack/.admin-openrc② 列出块存储服务组件,验证成功启动的

cinder进程cinder service-list

4.8 共享文件系统服务配置(Shared File Systems Service – Manila)

共享文件系统服务可以提供对共享文件系统或分布式文件系统的访问。

4.8.1 Shared File Systems Service(Manila)

部署节点:Controller Node

-

在 MariaDB(MySQL)中创建数据库

manila

① 以root用户登录 MySQLmysql -u root -p② 创建

manila数据库CREATE DATABASE manila;③ 授予

manila数据库适当权限

注:将MANILA_DBPASS替换为前面设计的实际密码GRANT ALL PRIVILEGES ON manila.* TO 'manila'@'localhost' IDENTIFIED BY 'MANILA_DBPASS'; GRANT ALL PRIVILEGES ON manila.* TO 'manila'@'%' IDENTIFIED BY 'MANILA_DBPASS'; -

创建 Manila 服务实体和 API 路径

① 设置 OpenStack 中admin用户环境变量source ~/.openstack/.admin-openrc② 在 OpenStack 中创建一个

manila用户openstack user create --domain default --password-prompt manila输入用户

manila的密码MANILA_PASS(将MANILA_PASS替换为前面设计的实际密码)。

③ 将admin角色授予manila用户openstack role add --project service --user manila admin④ 创建

manila和manilav2服务实体openstack service create --name manila --description "OpenStack Shared File Systems" share openstack service create --name manilav2 --description "OpenStack Shared File Systems" sharev2⑤ 创建共享文件系统服务 API 路径

openstack endpoint create --region RegionOne share public http://controller:8786/v1/%\(tenant_id\)s openstack endpoint create --region RegionOne share internal http://controller:8786/v1/%\(tenant_id\)s openstack endpoint create --region RegionOne share admin http://controller:8786/v1/%\(tenant_id\)s openstack endpoint create --region RegionOne sharev2 public http://controller:8786/v2/%\(tenant_id\)s openstack endpoint create --region RegionOne sharev2 internal http://controller:8786/v2/%\(tenant_id\)s openstack endpoint create --region RegionOne sharev2 admin http://controller:8786/v2/%\(tenant_id\)s -

安装和配置 Manila 服务组件

① 安装 Manilasudo apt-get install manila-api manila-scheduler python-manilaclient② 修改配置文件

sudo vi /etc/manila/manila.conf。

注:将MANILA_DBPASS、MANILA_PASS和RABBIT_PASS替换为前面设计的实际密码。

在[database]处配置数据访问连接:[database] connection = mysql+pymysql://manila:MANILA_DBPASS@controller/manila在

[DEFAULT]和[oslo_messaging_rabbit]处配置 RabbitMQ 消息队列访问:[DEFAULT] rpc_backend = rabbit [oslo_messaging_rabbit] rabbit_host = controller rabbit_userid = openstack rabbit_password = RABBIT_PASS在

[DEFAULT]处添加如下配置信息:default_share_type = default_share_type rootwrap_config = /etc/manila/rootwrap.conf在

[DEFAULT]和[keystone_authtoken]处配置认证服务访问:

注:注释或删除[keystone_authtoken]处其他默认设置。[DEFAULT] auth_strategy = keystone [keystone_authtoken] memcached_servers = controller:11211 auth_uri = http://controller:5000 auth_url = http://controller:35357 auth_type = password project_domain_name = default user_domain_name = default project_name = service username = manila password = MANILA_PASS在

[DEFAULT]处配置my_ip为 Controller 节点 Management Networ 网络接口地址:[DEFAULT] my_ip = 10.0.0.11在

[oslo_concurrency]处配置lock_path:[oslo_concurrency] lock_path = /var/lib/manila/tmp③ 将配置信息写入块存储服务数据库

manilasu root su -s /bin/sh -c "manila-manage db sync" manila -

重启共享文件系统服务

sudo service manila-scheduler restart sudo service manila-api restart

部署节点:BlockStorage Node

-

安装共享文件系统服务组件

① 安装manilasudo apt-get install manila-share python-pymysql② 修改配置文件

sudo vi /etc/manila/manila.conf

注:将MANILA_DBPASS、MANILA_PASS和RABBIT_PASS替换为前面设计的实际密码。

在[database]处配置数据库访问连接:[database] connection = mysql+pymysql://manila:MANILA_DBPASS@controller/manila在

[DEFAULT]和[oslo_messaging_rabbit]处配置 RabbitMQ 消息队列访问服务:[DEFAULT] rpc_backend = rabbit [oslo_messaging_rabbit] rabbit_host = controller rabbit_userid = openstack rabbit_password = RABBIT_PASS在

[DEFAULT]处添加如下配置信息:default_share_type = default_share_type rootwrap_config = /etc/manila/rootwrap.conf在

[DEFAULT]和[keystone_authtoken]处配置身份认证服务访问:

注:注释或删除[keystone_authtoken]处其他默认配置信息[DEFAULT] auth_strategy = keystone [keystone_authtoken] memcached_servers = controller:11211 auth_uri = http://controller:5000 auth_url = http://controller:35357 auth_type = password project_domain_name = default user_domain_name = default project_name = service username = manila password = MANILA_PASS在

[DEFAULT]处配置my_ip为 BlockStorage 节点 Management Networ 网络接口地址:[DEFAULT] my_ip = 10.0.0.41在

[oslo_concurrency]处配置lock_path:[oslo_concurrency] lock_path = /var/lib/manila/tmp -

安装配置共享服务器管理

① 针对两种不同的网络模式(provider 和 self-service),共享文件系统服务支持两种模式:

不需要驱动器支持的共享服务器管理:不需要安装任何驱动,默认使用 LVM 和 NFS 服务方式,支持 NFS 和 CIFS 协议,通过在共享服务器创建共享卷,利用 NFS 为虚拟机提供共享服务。

需要驱动器支持的共享服务器管理:需要计算 (Nova), 网络(Neutron) 和块存储管理 (Cinder) 服务管理共享服务器。用于创建共享服务器的信息被配置为共享网络。这种模式使用通用驱动程序,并需要启用驱动控制共享服务器(DHSS),还需要连接到公共网络路由器。本指南采用第二种模式。

② 安装网络服务组件sudo apt-get install neutron-plugin-linuxbridge-agent③ 配置网络服务公共组件

公共组件配置包括认证机制、消息队列、插件。修改配置文件sudo vi /etc/neutron/neutron.conf

在[database]处注释掉其他所有设置项,因为BlockStorage节点不需要直接访问数据库。

在[DEFAULT]和[oslo_messaging_rabbit]处配置RabbitMQ消息队列访问

注:将RABBIT_PASS替换为前面设计的实际密码[DEFAULT] rpc_backend = rabbit [oslo_messaging_rabbit] rabbit_host = controller rabbit_userid = openstack rabbit_password = RABBIT_PASS在

[DEFAULT]和[keystone_authtoken]处配置身份服务访问

注:将NEUTRON_PASS替换为前面设计的实际密码

注:注释或删除[keystone_authtoken]处其他项[DEFAULT] auth_strategy = keystone [keystone_authtoken] auth_uri = http://controller:5000 auth_url = http://controller:35357 memcached_servers = controller:11211 auth_type = password project_domain_name = default user_domain_name = default project_name = service username = neutron password = NEUTRON_PASS④ 配置网络设置

配置 Linux 网桥代理,修改配置文件sudo vi /etc/neutron/plugins/ml2/linuxbridge_agent.ini

在[linux_bridge]处将虚拟网络映射到物理网络

注:将PROVIDER_INTERFACE_NAME替换为 BlockStorage 节点 External Network 网络接口名称eth0。[linux_bridge] physical_interface_mappings = provider:PROVIDER_INTERFACE_NAME在

[vxlan]处启用VXLAN覆盖网络,配置管理覆盖网络的物理网络接口 IP 地址,启用layer-2 population

注:将OVERLAY_INTERFACE_IP_ADDRESS替换为 BlockStorage 节点 Management Network 网络接口 IP 地址10.0.0.41[vxlan] enable_vxlan = True local_ip = OVERLAY_INTERFACE_IP_ADDRESS l2_population = True在

[securitygroup]处启用安全组,配置Linux bridge iptables firewall driver[securitygroup] enable_security_group = True firewall_driver = neutron.agent.linux.iptables_firewall.IptablesFirewallDriver⑤ 修改配置文件

sudo vi /etc/manila/manila.conf

在[DEFAULT]处启用generic和NFS/CIFS协议:

注:下面共享后端名称可任意设置,本指南设置为驱动名称。[DEFAULT] enabled_share_backends = generic enabled_share_protocols = NFS,CIFS在

[neutron]、[nova]和[cinder]处启用这些服务的认证信息:

注:将NEUTRON_PASS、NOVA_PASS和CINDER_PASS替换为前面设计的实际密码[neutron] url = http://controller:9696 auth_uri = http://controller:5000 auth_url = http://controller:35357 memcached_servers = controller:11211 auth_type = password project_domain_name = default user_domain_name = default region_name = RegionOne project_name = service username = neutron password = NEUTRON_PASS [nova] auth_uri = http://controller:5000 auth_url = http://controller:35357 memcached_servers = controller:11211 auth_type = password project_domain_name = default user_domain_name = default region_name = RegionOne project_name = service username = nova password = NOVA_PASS [cinder] auth_uri = http://controller:5000 auth_url = http://controller:35357 memcached_servers = controller:11211 auth_type = password project_domain_name = default user_domain_name = default region_name = RegionOne project_name = service username = cinder password = CINDER_PASS在

[generic]处配置generic驱动:[generic] share_backend_name = GENERIC share_driver = manila.share.drivers.generic.GenericShareDriver driver_handles_share_servers = True service_instance_flavor_id = 100 service_image_name = manila-service-image service_instance_user = manila service_instance_password = manila interface_driver = manila.network.linux.interface.BridgeInterfaceDriver⑥ 重启服务

sudo service manila-share restart sudo service neutron-linuxbridge-agent restart -

验证共享文件系统服务和网络服务代理是否安装配置正确

① 在 Controller 节点上设置 OpenStack 管理用户admin的环境变量source ~/.openstack/.admin-openrc② 列出共享文件系统服务组件,验证成功启动的

manila进程manila service-list③ 列出网络服务代理

neutron agent-list

4.8.2 Manila Dashboard(Manila UI)

注:在 OpenStack Mitaka 发行版中 Horizon 中不包括 Manila,需要安装额外的插件 manila-ui 才能在 Horizon 中显示 Share 菜单。

-

安装

Manila UI

查看列表:http://tarballs.openstack.org/manila-ui/sudo pip install 'http://tarballs.openstack.org/manila-ui/manila-ui-stable-mitaka.tar.gz' -

在

Horizon中启用Manila UI

查看Manila UI安装路径:find /usr -name 'manila_ui'cd /usr/local/lib/python2.7/dist-packages/manila_ui sudo cp ./enabled/_90_manila_*.py /usr/share/openstack-dashboard/openstack_dashboard/local/enabled -

配置中文语言支持

sudo apt-get install gettext python-pip python-dev build-essential cd /usr/share/openstack-dashboard/horizon sudo /usr/share/openstack-dashboard/manage.py makemessages -l en --no-obsolete sudo /usr/share/openstack-dashboard/manage.py makemessages -d djangojs -l en --no-obsolete cd /usr/share/openstack-dashboard/openstack_dashboard sudo /usr/share/openstack-dashboard/manage.py makemessages --extension=html,txt,csv --ignore=openstack -l en --no-obsolete cd /usr/share/openstack-dashboard/horizon sudo /usr/share/openstack-dashboard/manage.py compilemessages cd /usr/share/openstack-dashboard/openstack_dashboard sudo /usr/share/openstack-dashboard/manage.py compilemessages cd /usr/local/lib/python2.7/dist-packages/manila_ui sudo service apache2 reload -

重新加载

Apache Web Serversudo service apache2 reload参考链接:

https://github.com/openstack/manila-ui

http://docs.openstack.org/developer/horizon/topics/install.html

https://www.howtoinstall.co/en/ubuntu/xenial/python-manila-ui

4.9 对象存储服务配置(Object Storage Service – Swift)

通过 REST API 提供对象存储和检索服务。

部署节点:Controller Node

-

创建对象存储服务实体和 API 路径

注:对象存储服务不使用 Controller 节点上的 SQL 数据库 MariaDB,它使用每个存储节点上的分布式数据库 SQLite。

① 设置 OpenStack 中admin用户环境变量source ~/.openstack/.admin-openrc② 在 OpenStack 中创建一个

swift用户openstack user create --domain default --password-prompt swift输入用户

swift的密码SWIFT_PASS(将SWIFT_PASS替换为前面设计的实际密码)。

③ 将admin角色授予swift用户openstack role add --project service --user swift admin④ 创建

swift服务实体openstack service create --name swift --description "OpenStack Object Storage" object-store⑤ 创建对象存储服务 API 路径

openstack endpoint create --region RegionOne object-store public http://controller:8080/v1/AUTH_%\(tenant_id\)s openstack endpoint create --region RegionOne object-store internal http://controller:8080/v1/AUTH_%\(tenant_id\)s openstack endpoint create --region RegionOne object-store admin http://controller:8080/v1 -

安装和配置 Swift 服务组件

① 安装 Swift 相关服务组件sudo apt-get install swift swift-proxy python-swiftclient python-keystoneclient python-keystonemiddleware memcached② 创建目录

/etc/swiftsudo mkdir /etc/swift③ 从对象存储软件源仓库下载对象存储代理服务配置文件

sudo curl -o /etc/swift/proxy-server.conf https://git.openstack.org/cgit/openstack/swift/plain/etc/proxy-server.conf-sample?h=stable/mitaka② 修改配置文件

sudo vi /etc/swift/proxy-server.conf。

在[DEFAULT]处配置代理服务绑定端口、用户和目录:[DEFAULT] bind_port = 8080 user = swift swift_dir = /etc/swift在

[pipeline:main]处移除tempurl和tempauth模块,并添加authtoken和keystoneauth模块:[pipeline:main] pipeline = catch_errors gatekeeper healthcheck proxy-logging cache container_sync bulk ratelimit authtoken keystoneauth container-quotas account-quotas slo dlo versioned_writes proxy-logging proxy-server在

[app:proxy-server]处启用账户自动创建:[app:proxy-server] use = egg:swift#proxy account_autocreate = True在

[filter:keystoneauth]处设置操作用户角色:[filter:keystoneauth] use = egg:swift#keystoneauth operator_roles = admin,user在

[filter:authtoken]处配置认证服务访问:

注:将SWIFT_PASS替换为前面设计的实际密码。

注:注释或删除[filter:authtoken]处其他默认设置。[filter:authtoken] paste.filter_factory = keystonemiddleware.auth_token:filter_factory auth_uri = http://controller:5000 auth_url = http://controller:35357 memcached_servers = controller:11211 auth_type = password project_domain_name = default user_domain_name = default project_name = service username = swift password = SWIFT_PASS delay_auth_decision = True在

[filter:cache]处配置 Memcached 位置:[filter:cache] use = egg:swift#memcache memcache_servers = controller:11211

部署节点:ObjectStorage Node

注:每个对象存储节点都需执行以下步骤

-

安装配置

XFS

① 安装 XFS:sudo apt-get install xfsprogs rsync② 将存储设备

/dev/sdb和/dev/sdc格式化为XFS文件系统:sudo mkfs.xfs /dev/sdb sudo mkfs.xfs /dev/sdc③ 创建挂载点目录:

sudo mkdir -p /srv/node/sdb sudo mkdir -p /srv/node/sdc④ 修改文件

sudo vi /etc/fstab,添加如下信息:/dev/sdb /srv/node/sdb xfs noatime,nodiratime,nobarrier,logbufs=8 0 2 /dev/sdc /srv/node/sdc xfs noatime,nodiratime,nobarrier,logbufs=8 0 2⑤ 挂载设备:

sudo mount /srv/node/sdb sudo mount /srv/node/sdc⑥ 新建或修改置文件

sudo vi /etc/rsyncd.conf,添加如下信息:

注:将下面MANAGEMENT_INTERFACE_IP_ADDRESS替换为对象存储节点Management Network网络接口地址10.0.0.51或10.0.0.52uid = swift gid = swift log file = /var/log/rsyncd.log pid file = /var/run/rsyncd.pid address = MANAGEMENT_INTERFACE_IP_ADDRESS [account] max connections = 2 path = /srv/node/ read only = False lock file = /var/lock/account.lock [container] max connections = 2 path = /srv/node/ read only = False lock file = /var/lock/container.lock [object] max connections = 2 path = /srv/node/ read only = False lock file = /var/lock/object.lock⑦ 修改

sudo vi /etc/default/rsync,启用rsync服务:RSYNC_ENABLE=true⑧ 启动

rsync服务:sudo service rsync start -

安装配置 Swift 服务组件

① 安装swift组件sudo apt-get install swift swift-account swift-container swift-object② 从对象存储软件源仓库下载账户、容器和对象服务配置文件

sudo curl -o /etc/swift/account-server.conf https://git.openstack.org/cgit/openstack/swift/plain/etc/account-server.conf-sample?h=stable/mitaka sudo curl -o /etc/swift/container-server.conf https://git.openstack.org/cgit/openstack/swift/plain/etc/container-server.conf-sample?h=stable/mitaka sudo curl -o /etc/swift/object-server.conf https://git.openstack.org/cgit/openstack/swift/plain/etc/object-server.conf-sample?h=stable/mitaka③ 修改配置文件

sudo vi /etc/swift/account-server.conf。

在[DEFAULT]处配置绑定 IP 地址、绑定端口、用户、目录和挂载点:

注:将下面MANAGEMENT_INTERFACE_IP_ADDRESS替换为对象存储节点Management Network网络接口地址10.0.0.51或10.0.0.52[DEFAULT] bind_ip = MANAGEMENT_INTERFACE_IP_ADDRESS bind_port = 6002 user = swift swift_dir = /etc/swift devices = /srv/node mount_check = True在

[pipeline:main]处启用相关模块:[pipeline:main] pipeline = healthcheck recon account-server在

[filter:recon]处配置recon(meters)缓存:[filter:recon] use = egg:swift#recon recon_cache_path = /var/cache/swift④ 修改配置文件

sudo vi /etc/swift/container-server.conf

在[DEFAULT]处配置绑定 IP 地址、绑定端口、用户、目录和挂载点:

注:将下面MANAGEMENT_INTERFACE_IP_ADDRESS替换为对象存储节点Management Network网络接口地址10.0.0.51或10.0.0.52[DEFAULT] bind_ip = MANAGEMENT_INTERFACE_IP_ADDRESS bind_port = 6001 user = swift swift_dir = /etc/swift devices = /srv/node mount_check = True在

[pipeline:main]处启用相关模块:[pipeline:main] pipeline = healthcheck recon container-server在

[filter:recon]处配置recon(meters)缓存:[filter:recon] use = egg:swift#recon recon_cache_path = /var/cache/swift⑤ 修改配置文件

sudo vi /etc/swift/object-server.conf

在[DEFAULT]处配置绑定 IP 地址、绑定端口、用户、目录和挂载点:

注:将下面MANAGEMENT_INTERFACE_IP_ADDRESS替换为对象存储节点Management Network网络接口地址10.0.0.51或10.0.0.52[DEFAULT] bind_ip = MANAGEMENT_INTERFACE_IP_ADDRESS bind_port = 6000 user = swift swift_dir = /etc/swift devices = /srv/node mount_check = True在

[pipeline:main]处启用相关模块:[pipeline:main] pipeline = healthcheck recon object-server在

[filter:recon]处配置recon(meters)缓存:[filter:recon] use = egg:swift#recon recon_cache_path = /var/cache/swift recon_lock_path = /var/lock⑥ 修改挂载点目录所有者:

sudo chown -R swift:swift /srv/node⑦ 创建

recon目录,并修改所有者:sudo mkdir -p /var/cache/swift sudo chown -R root:swift /var/cache/swift sudo chmod -R 775 /var/cache/swift

部署节点:Controller Node

创建和分发初始环

-

创建账户环

① 将当前工作目录设置为/etc/swift:cd /etc/swift② 创建基础的

account.builder文件:sudo swift-ring-builder account.builder create 10 3 1③ 将每个对象存储节点设备添加到账户环:

sudo swift-ring-builder account.builder add --region 1 --zone 1 --ip STORAGE_NODE_MANAGEMENT_INTERFACE_IP_ADDRESS --port 6002 --device DEVICE_NAME --weight DEVICE_WEIGHT注:将

STORAGE_NODE_MANAGEMENT_INTERFACE_IP_ADDRESS替换为对象存储节点Management Network网络接口地址,将DEVICE_NAME替换为对应的对象存储节点上的存储设备名称,将DEVICE_WEIGHT替换为实际权重值。

注:重复以上命令,将每个存储节点上的每个存储设备添加到账户环。

例如,本文采用如下命令将每个存储节点上的每个存储设备添加到账户环:sudo swift-ring-builder account.builder add --region 1 --zone 1 --ip 10.0.0.51 --port 6002 --device sdb --weight 100 sudo swift-ring-builder account.builder add --region 1 --zone 1 --ip 10.0.0.51 --port 6002 --device sdc --weight 100 sudo swift-ring-builder account.builder add --region 1 --zone 2 --ip 10.0.0.52 --port 6002 --device sdb --weight 100 sudo swift-ring-builder account.builder add --region 1 --zone 2 --ip 10.0.0.52 --port 6002 --device sdc --weight 100④ 验证账户环内容:

sudo swift-ring-builder account.builder⑤ 平衡账户环:

sudo swift-ring-builder account.builder rebalance -

创建容器环

① 将当前工作目录设置为/etc/swift:cd /etc/swift② 创建基础的

container.builder文件:sudo swift-ring-builder container.builder create 10 3 1③ 将每个对象存储节点设备添加到容器环:

sudo swift-ring-builder container.builder add --region 1 --zone 1 --ip STORAGE_NODE_MANAGEMENT_INTERFACE_IP_ADDRESS --port 6001 --device DEVICE_NAME --weight DEVICE_WEIGHT注:将

STORAGE_NODE_MANAGEMENT_INTERFACE_IP_ADDRESS替换为对象存储节点Management Network网络接口地址,将DEVICE_NAME替换为对应的对象存储节点上的存储设备名称,将DEVICE_WEIGHT替换为实际权重值。

注:重复以上命令,将每个存储节点上的每个存储设备添加到容器环。

例如,本文采用如下命令将每个存储节点上的每个存储设备添加到容器环:sudo swift-ring-builder container.builder add --region 1 --zone 1 --ip 10.0.0.51 --port 6001 --device sdb --weight 100 sudo swift-ring-builder container.builder add --region 1 --zone 1 --ip 10.0.0.51 --port 6001 --device sdc --weight 100 sudo swift-ring-builder container.builder add --region 1 --zone 2 --ip 10.0.0.52 --port 6001 --device sdb --weight 100 sudo swift-ring-builder container.builder add --region 1 --zone 2 --ip 10.0.0.52 --port 6001 --device sdc --weight 100④ 验证容器环内容:

sudo swift-ring-builder container.builder⑤ 平衡容器环:

sudo swift-ring-builder container.builder rebalance -

创建对象环

① 将当前工作目录设置为/etc/swift:cd /etc/swift② 创建基础的

object.builder文件:sudo swift-ring-builder object.builder create 10 3 1③ 将每个对象存储节点设备添加到对象环:

sudo swift-ring-builder object.builder add --region 1 --zone 1 --ip STORAGE_NODE_MANAGEMENT_INTERFACE_IP_ADDRESS --port 6000 --device DEVICE_NAME --weight DEVICE_WEIGHT注:将

STORAGE_NODE_MANAGEMENT_INTERFACE_IP_ADDRESS替换为对象存储节点Management Network网络接口地址,将DEVICE_NAME替换为对应的对象存储节点上的存储设备名称,将DEVICE_WEIGHT替换为实际权重值。

注:重复以上命令,将每个存储节点上的每个存储设备添加到对象环。

例如,本文采用如下命令将每个存储节点上的每个存储设备添加到对象环:sudo swift-ring-builder object.builder add --region 1 --zone 1 --ip 10.0.0.51 --port 6000 --device sdb --weight 100 sudo swift-ring-builder object.builder add --region 1 --zone 1 --ip 10.0.0.51 --port 6000 --device sdc --weight 100 sudo swift-ring-builder object.builder add --region 1 --zone 2 --ip 10.0.0.52 --port 6000 --device sdb --weight 100 sudo swift-ring-builder object.builder add --region 1 --zone 2 --ip 10.0.0.52 --port 6000 --device sdc --weight 100④ 验证对象环内容:

sudo swift-ring-builder object.builder⑤ 平衡对象环:

sudo swift-ring-builder object.builder rebalance -

分发环配置文件

将环配置文件account.ring.gz、container.ring.gz和object.ring.gz拷贝到每个对象存储节点以及代理服务节点的/etc/swift目录。在每个 存储节点 或代理服务节点 执行以下命令:sudo scp controller@controller:/etc/swift/*.ring.gz /etc/swift注:本文将

swift-proxy部署到 controller 节点,因此无需再讲环配置文件拷贝到代理服务节点的/etc/swift目录。若对象存储代理服务swift-proxy部署在其他节点,则需将环配置文件拷贝到该代理服务节点/etc/swift目录下。 -

添加、分发

swift配置文件

① 从对象存储软件源仓库下载配置文件/etc/swift/swift.confsudo curl -o /etc/swift/swift.conf https://git.openstack.org/cgit/openstack/swift/plain/etc/swift.conf-sample?h=stable/mitaka② 修改配置文件

sudo vi /etc/swift/swift.conf

在[swift-hash]处哈希路径前缀和后缀

注:将HASH_PATH_PREFIX和HASH_PATH_SUFFIX替换为前面设计的唯一值。[swift-hash] swift_hash_path_suffix = HASH_PATH_SUFFIX swift_hash_path_prefix = HASH_PATH_PREFIX在

[storage-policy:0]处设置默认存储策略:[storage-policy:0] name = Policy-0 default = yes③ 分发

swift配置文件

将/etc/swift/swift.conf拷贝到每个对象存储节点以及代理服务节点的/etc/swift目录。在每个 存储节点 或代理服务节点 执行以下命令:sudo scp controller@controller:/etc/swift/swift.conf /etc/swift④ 在所有存储节点和代理服务节点上设置 swift 配置目录所有权

sudo chown -R root:swift /etc/swift -

重启服务,完成安装

① 在 Controller 节点和其他 Swift 代理服务节点上执行:sudo service memcached restart sudo service swift-proxy restart② 在所有对象存储节点上执行:

注:忽略其他未配置的服务报错信息sudo swift-init all start -

验证对象存储服务是否安装配置正确

① 在 Controller 节点上设置 OpenStack 示例用户demo的环境变量source ~/.openstack/.demo-openrc② 查看对象存储服务状态

controller@controller:~$ swift stat Account: AUTH_4bedcb61d9eb47cfb5fc79ea4a1a03b0 Containers: 0 Objects: 0 Bytes: 0 X-Put-Timestamp: 1465023102.25072 X-Timestamp: 1465023102.25072 X-Trans-Id: tx4a14ec8f1e6c46179a9b8-0057527a7d Content-Type: text/plain; charset=utf-8③ 创建一个容器

container1openstack container create container1④ 上传一个测试文件到容器

container1

注:将FILE替换为任意本地测试文件名openstack object create container1 FILE⑤ 列出容器

container1中的文件:openstack object list container1⑥ 从容器

container1下载文件:openstack object save container1 FILE

4.10 编排服务配置(Orchestration Service – Heat)

提供一种基于模板的编排,用于创建和管理云资源。

部署节点:Controller Node

-

在 MariaDB(MySQL)中创建数据库

heat

① 以root用户登录 MySQLmysql -u root -p② 创建

heat数据库CREATE DATABASE heat;③ 授予

heat数据库适当权限

注:将HEAT_DBPASS替换为前面设计的实际密码GRANT ALL PRIVILEGES ON heat.* TO 'heat'@'localhost' IDENTIFIED BY 'HEAT_DBPASS'; GRANT ALL PRIVILEGES ON heat.* TO 'heat'@'%' IDENTIFIED BY 'HEAT_DBPASS'; -

创建 Orchestration 服务实体和 API 路径

① 设置 OpenStack 中admin用户环境变量source ~/.openstack/.admin-openrc② 在 OpenStack 中创建一个

heat用户openstack user create --domain default --password-prompt heat输入用户

heat的密码HEAT_PASS(将HEAT_PASS替换为前面设计的实际密码)。

③ 将admin角色授予heat用户openstack role add --project service --user heat admin④ 创建

heat和heat-cfn服务实体openstack service create --name heat --description "Orchestration" orchestration openstack service create --name heat-cfn --description "Orchestration" cloudformation⑤ 创建 Orchestration 服务 API 路径

openstack endpoint create --region RegionOne orchestration public http://controller:8004/v1/%\(tenant_id\)s openstack endpoint create --region RegionOne orchestration internal http://controller:8004/v1/%\(tenant_id\)s openstack endpoint create --region RegionOne orchestration admin http://controller:8004/v1/%\(tenant_id\)s openstack endpoint create --region RegionOne cloudformation public http://controller:8000/v1 openstack endpoint create --region RegionOne cloudformation internal http://controller:8000/v1 openstack endpoint create --region RegionOne cloudformation admin http://controller:8000/v1 -

创建 Orchestration 管理域、用户、角色

① 创建heat域openstack domain create --description "Stack projects and users" heat② 创建