共计 1861 个字符,预计需要花费 5 分钟才能阅读完成。

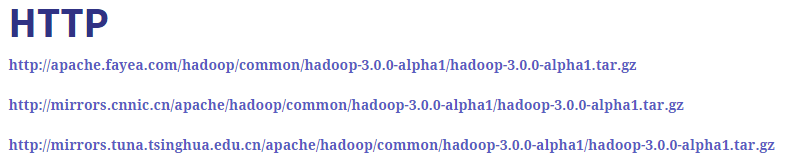

1. 官网下载

wget http://apache.fayea.com/Hadoop/common/hadoop-3.0.0-alpha1/hadoop-3.0.0-alpha1.tar.gz

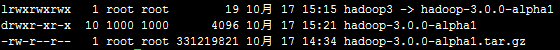

2. 解压

tar -zxvf hadoop-3.0.0-alpha1.tar.gz

ln -s hadoop-3.0.0-alpha1 hadoop3

3. 环境变量

vi /etc/profile

#Hadoop 3.0

export HADOOP_HOME=/usr/local/hadoop3

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

source /etc/profile

注意:/usr/local/hadoop3为解压路径

4. 配置文件 hadoop3/etc/hadoop

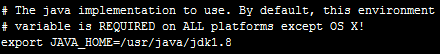

1) hadoop-env.sh

注意: /usr/java/jdk1.8为 jdk 安装路径

2)core-site.xml

注意:hdfs://ha01:9000 中 ha01 是主机名

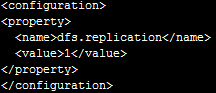

3) hdfs-site.xml

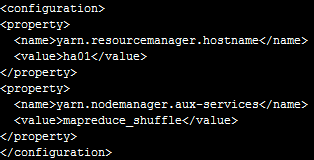

4) yarn-site.xml

注意:ha01是主机名

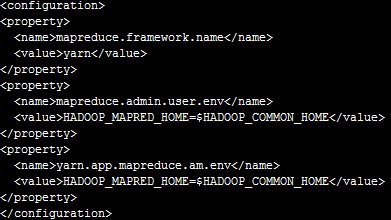

5) mapred-site.xml

注意:如果不配置 mapreduce.admin.user.env 和 yarn.app.mapreduce.am.env 这两个参数mapreduce 运行时有可能报错。

6)workers

这里跟以前的 slaves 配置文件类似,写上从节点的主机名

5. 复制到其他节点

scp -r hadoop-3.0.0-alpha1 root@ha02:/usr/local

scp -r hadoop-3.0.0-alpha1 root@ha03:/usr/local

6. 启动

start-dfs.sh

start-yarn.sh

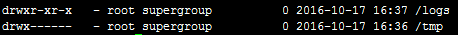

hdfs dfs -ls /

7. 运行 wordcount

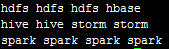

hdfs dfs -cat /logs/wordcount.log

hadoop jar /usr/local/hadoop3/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.0.0-alpha1.jar wordcount /logs/wordcount.log /output/wordcount

注意: /usr/local/hadoop3是解压路径,/logs/wordcount.log是输入文件路径,/output/wordcount运行结果路径

查看运行结果: hdfs dfs -text /output/wordcount/part-r-00000

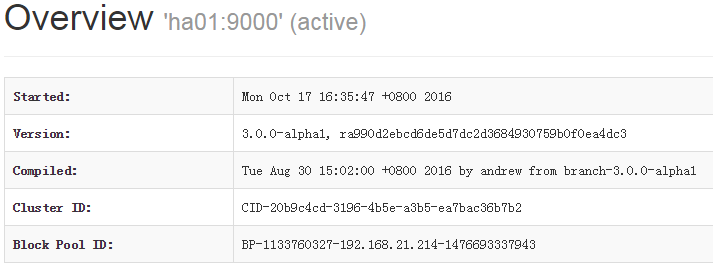

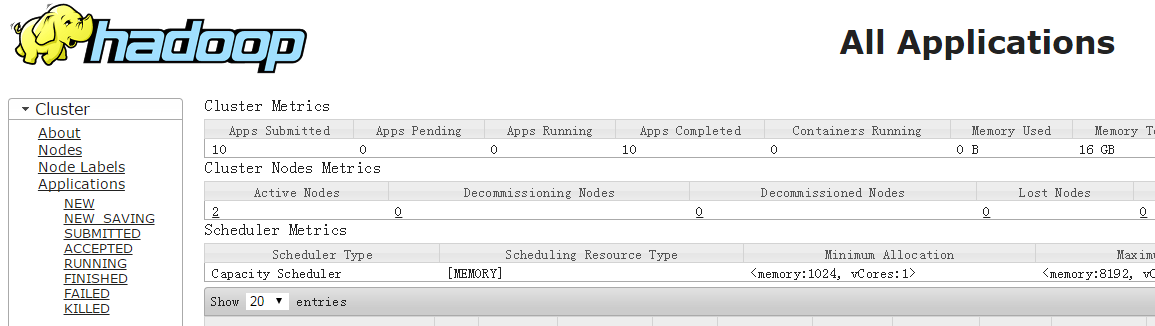

8. Web 界面

http://ha01:9870/

http://ha01:8088/

下面关于 Hadoop 的文章您也可能喜欢,不妨看看:

Ubuntu14.04 下 Hadoop2.4.1 单机 / 伪分布式安装配置教程 http://www.linuxidc.com/Linux/2015-02/113487.htm

CentOS 安装和配置 Hadoop2.2.0 http://www.linuxidc.com/Linux/2014-01/94685.htm

Ubuntu 14.04 LTS 下安装 Hadoop 1.2.1(伪分布模式)http://www.linuxidc.com/Linux/2016-09/135406.htm

Ubuntu 上搭建 Hadoop 环境(单机模式 + 伪分布模式)http://www.linuxidc.com/Linux/2013-01/77681.htm

Ubuntu 下 Hadoop 环境的配置 http://www.linuxidc.com/Linux/2012-11/74539.htm

单机版搭建 Hadoop 环境图文教程详解 http://www.linuxidc.com/Linux/2012-02/53927.htm

Hadoop 2.6.0 HA 高可用集群配置详解 http://www.linuxidc.com/Linux/2016-08/134180.htm

Spark 1.5、Hadoop 2.7 集群环境搭建 http://www.linuxidc.com/Linux/2016-09/135067.htm

更多 Hadoop 相关信息见Hadoop 专题页面 http://www.linuxidc.com/topicnews.aspx?tid=13

本文永久更新链接地址:http://www.linuxidc.com/Linux/2016-10/136166.htm