共计 2215 个字符,预计需要花费 6 分钟才能阅读完成。

客户在实际进行迁移的时候,往往碰到需要将本地数据中心的超大文件,比如单个 200GB 的文件,或者总共 1TB 的无数文件上传到 Azure 上的情况,尤其是传到 Azure 的 Linux 虚拟机的场景,这种场景包括:

大日志文件上传到 Azure 进行分析

数据库备份文件导入导出

大数据文件下载到本地等等

尤其是要将数据库备份文件导入到 Linux 虚拟机进行数据库恢复,一般用户常常会选择传统的 FTP 方式进行处理,这样的方式通常会花费用户十几个小时,甚至几天的时间进行文件传输,但是在云计算的时代,其实有非常多的工具和方法可以使用,让你大幅度降低时间和成本,今天我们就以 250GB 数据库文件上传到 Linux 虚拟机为例,来看看怎么利用这些工具。

基本流程:

在本地安装或者使用一个 Windows 机器,内核数目和内存可能的话最好大一些,因为 azcopy 会根据内核数计算并发线程数

安装 azcopy

在 Azure 上创建 storage account,容器 container

利用 azcopy 上传本地文件到 Blob storage

在 Linux 虚拟机利用 Azure CLI 下载云端文件到本地 Linux 虚拟机

如果 Azure 上是 Windows 虚拟机,使用 azcopy 下载

限制和优化建议:

单个 block blob 的文件不能超过 195GB,所以如果你的本地单个文件超过这个大小,你可以选择:

分割文件成小份

利用压缩软件压缩文件到较小大小

如果你本地的机器比较强大,并且单个文件的确比较大,建议你本地压缩,可以节约总体时间,你开始压缩的时候,大致可以知道这个压缩需要多长时间,

你的虚拟机和你的存储帐号入伍特别需要,请放在一个区域,比如都在北京或者上海,一边最大限度的降低延迟,提升速度

Azcopy 会最大限度的利用你的数据中心的带宽,如果你希望降低带宽占用,可以限制 azcopy 的并发处理数目,利用 /NC 来做限制,默认情况下,如果你是操作 blob storage,azcopy 的并发线程数是你处理器数目的 8 倍;对于 Table 的操作,默认的并发线程数是你的处理器数目。

上传下载速度和你的磁盘速度,网络带宽等都有关系,如果需要处理大规模文件,可以考虑临时调整你的数据中心带宽大小

在本示例中,基本环境如下:

备份文件未压缩前 210GB,压缩后 60GB

用户数据中心服务器,Windows Server 2012,16 cores,32GB

Azure Linux 虚拟机:A4,SUSE 11 SP3

基本配置步骤如下:

在用户数据中心 Windows Server 上下载并安装 azcopy,请安装最新版本:

http://aka.ms/downloadazcopy

在 Azure 上创建一个存储账号,并取得存储账号的主访问密钥:

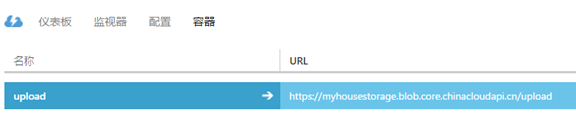

3. 在该存储账号下创建一个容器,名字为 upload,你可以按照自己的需要命名:

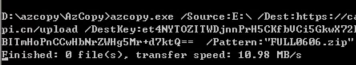

4. 利用 Azcopy,上传你本地的文件到 Blob storage,注意要用到上个步骤创建到的存储账号和账号的 key,假定当前的上传文件名为 FULL0606.zip, 放在你的 E 盘:

Azcopy.exe /Source:E:\ /Dest: https://myhousestorage.blob.core.linuxidc.com/upload /DestKey:YOURSTORAGEKEY /Pattern:”FULL0606.zip”

参数说明:

/Souce: 你的源文件地址,写目录,具体文件名写后面,如 C:\data

/Dest:你的存储账号的容器地址,可以在你的容器页面看到

/DestKey:存储帐号的主访问密钥

更多关于 azcopy 的详细用法和命令,请参考:

https://azure.microsoft.com/en-us/documentation/articles/storage-use-azcopy/

5. 传统方式下,用户会使用 FTP 的模式,经过调优,大概速度是 3.5MB/s, 而使用了 azcopy,由于它有多线程,网络优化等底层功能的支持,速度可以达到近 11MB/s,用户数据中心带宽 100M, 这个速度是相当不错的:

6. 在将数据上传到 Azure blob storage 之后,需要在 Linux 虚拟机上将他下载到本地,在 Windows 上有 Powershell,azcopy 等工具,在 Linux 系统上,有 Azure CLI 作为跨平台的工具可以管理 Azure 的各项服务,关于如何在 Linux 上安装配置 Azure CLI,请参考:

http://www.linuxidc.com/Linux/2016-11/136978.htm

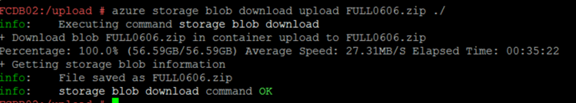

7. 在 Linux 虚拟机上,直接使用 Azure 的 CLI 命令下载上传到 Blob storage 上的压缩文件即可,在同一个 region,速度大约 30MB,但实际速度依赖于网络状况和当前负载:

# azure storage blob download upload FULL0606.zip ./

如果需要把 Linux 虚拟机上的大文件下载到本地,可以考虑逆序使用上述方法,azcopy 经过了网络优化,压缩优化和算法优化,是 Azure 上数据处理的神器:)

在之前客户的方案中,文件上传到 Linux 虚拟机大约需要 17 个小时,经过选择合适的方法,数据上传,下载大约总共 2 个小时的时间,所以根据不同的场景选择不同的工具和方法很重要。

本文永久更新链接地址 :http://www.linuxidc.com/Linux/2016-11/136977.htm