共计 2956 个字符,预计需要花费 8 分钟才能阅读完成。

Spark2.0.2 Hadoop2.6.4 全分布式配置详解

一、Scala 安装

下载目录 http://www.scala-lang.org/download/

修改 /etc/profile。

export SCALA_HOME=/usr/local/scala/scala-2.0.2

export PATH=/usr/local/scala/scala-2.0.2/bin:$PATH

然后测试

scala -version

Scala code runner version 2.0.2– Copyright 2002-2013, LAMP/EPFL

二、安装 Spark

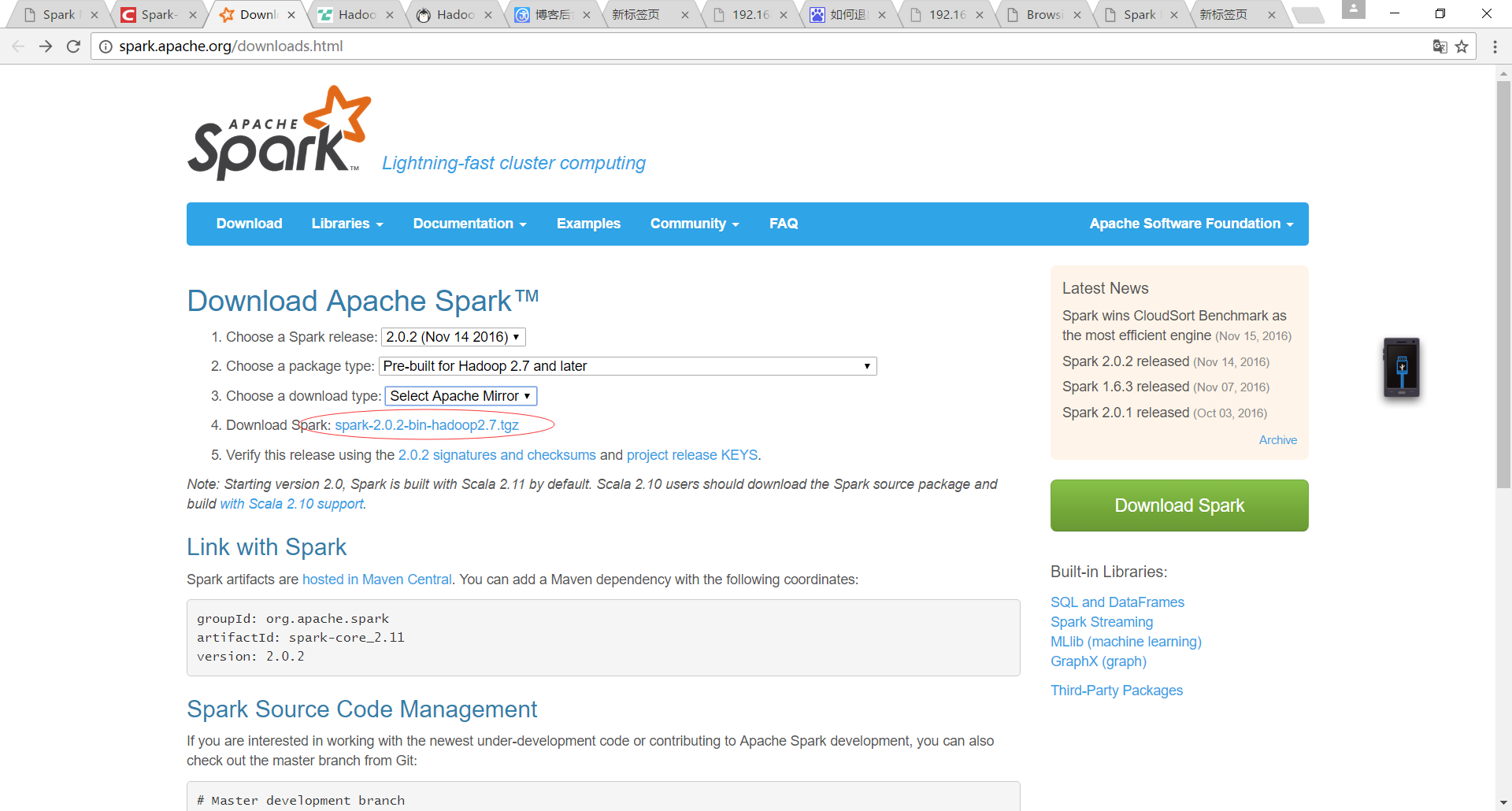

官网下载地址:http://spark.apache.org/downloads.html

需要下载预编译版本

我当时直接从花圈的地方复制链接,然后迅雷下载,去 linux 下 tar 解压,一直不行,高了几个小时,后来我仔细看了看发现才 17k,也用了 tgz 解压工具在 win 下也是打不开,说是未知类型,感觉下载有问题,需要点击

2.1 spark-env.sh

安装后,需要在 ./conf/spark-env.sh 中修改 Spark 的 Classpath,执行如下命令拷贝一个配置文件:

cp ./conf/spark-env.sh.template ./conf/spark-env.sh

这样就有了 spark-env.sh,否则只有.template。

编辑 ./conf/spark-env.sh(gedit ./conf/spark-env.sh),在最后面加上如下(里面的具体路径我没改动):

export JAVA_HOME=/usr/local/java/jdk1.8.0_73

export SCALA_HOME=/usr/local/scala/scala-2.11.7

export HADOOP_HOME=/usr/local/hadoop

export HADOOP_CONF_DIR=/usr/local/hadoop/etc/hadoop

export SPARK_MASTER_IP=192.168.58.180

export SPARK_WORKER_INSTANCES=2 #删掉

export SPARK_WORKER_MEMORY=1g

export SPARK_WORKER_CORES=1

export SPARK_HOME=/usr/local/spark

export SPARK_DIST_CLASSPATH=$(/usr/local/hadoop/bin/hadoop classpath)

2.2 slaves

然后修改 slaves

cd conf/

cp slaves.template slaves

vim slaves

#insert

CentOSMaster

StandByNameNode

吧同样的配置拷贝到 StandByNameNode 上,这样启动 spark 后发现有四个 worker,webui 上显示每台有两个 worker,然后启动 spark shell 时候提示 SPARK_WORKER_INSTANCES 他已经废弃,中间改成 EXECTOR 就好,我看其他人没配置,我直接删除了,然后就是两个 worker 了,jps 看到一个 Master 和一个 Worker,否则是两个 Worker。

2.3 spark-defaults.conf

cp spark-defaults.conf.template spark-defaults.conf

# 加入

spark.executor.extraJavaOptions -XX:+PrintGCDetails -DKey=value -Dnumbers=”one two three”

spark.eventLog.enabled true

spark.eventLog.dir hdfs://CentOSMaster:8020/historyserverforSpark

spark.yarn.historySever.address Master:18080

spark.history.fs.logDirectory hdfs://CentOSMaster:8020/historyserverforSpark

在 hdfs 上穿件历史服务器文件夹

hdfsdfs -mkdir /historyserverforSpark

否则打不开 18080,开启的时候不提示,关闭的时候提示没有 historyserver 来关闭。

hadoop 的历史服务器是 JHistoryServer,Spark 的服务器是 HistoryServer。

三、测试 Spark

sbin 目录下

start-all.sh

./start-history-server.sh

启动之前需要启动 hadoop 的 dfs 和 yarn。

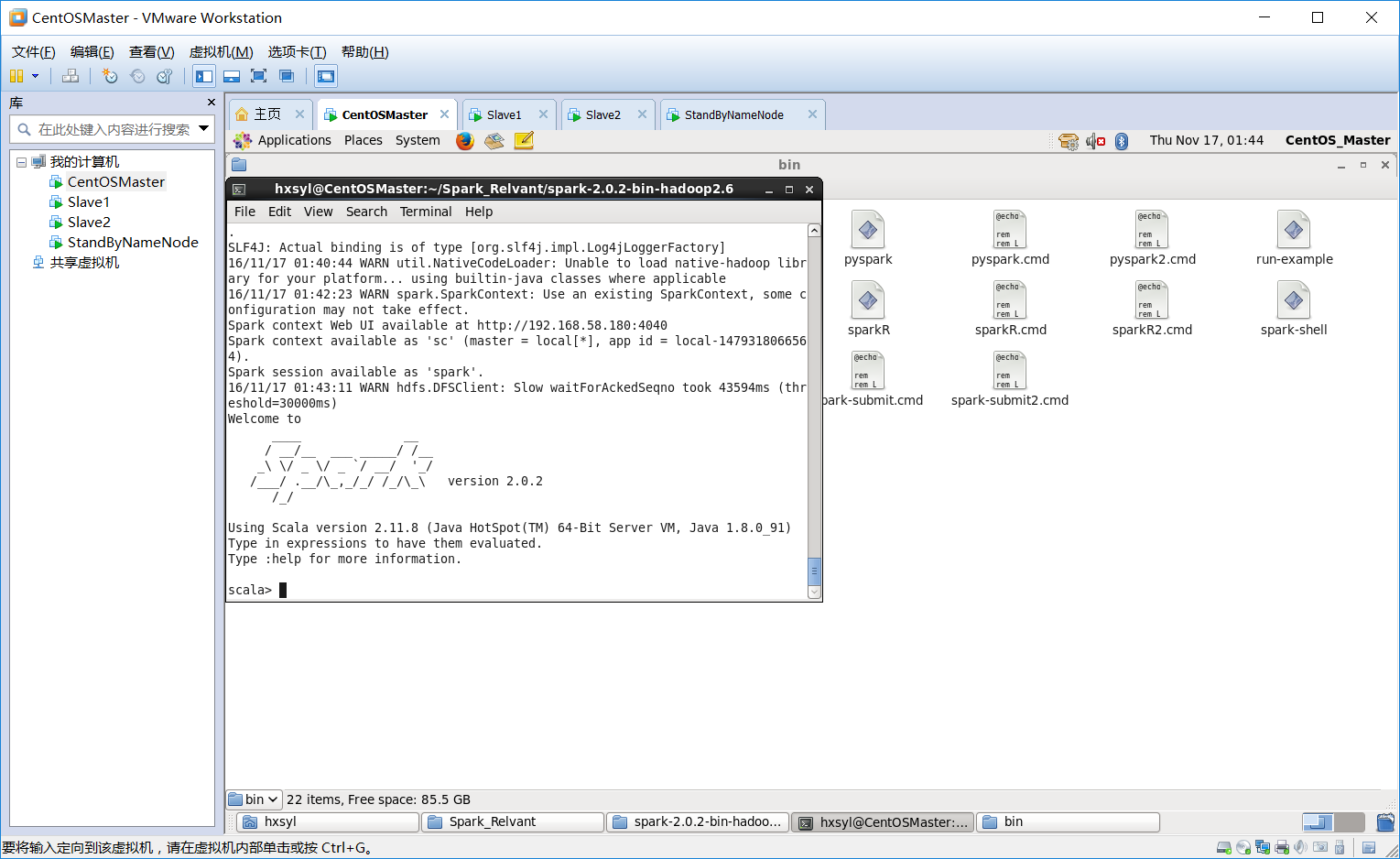

bin/spark-shell

注意后边没有.sh

出现 scala> 时说明成功。

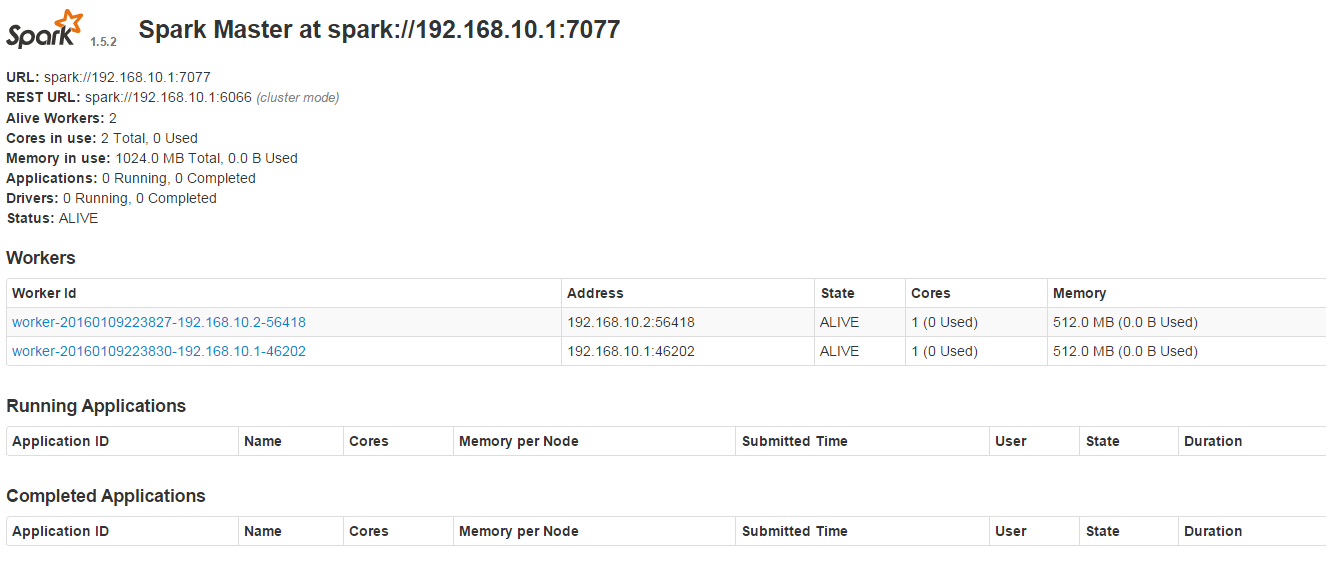

在浏览器中输入 192.168.10.1:8080 时,会看到如下图,有两个 Worker

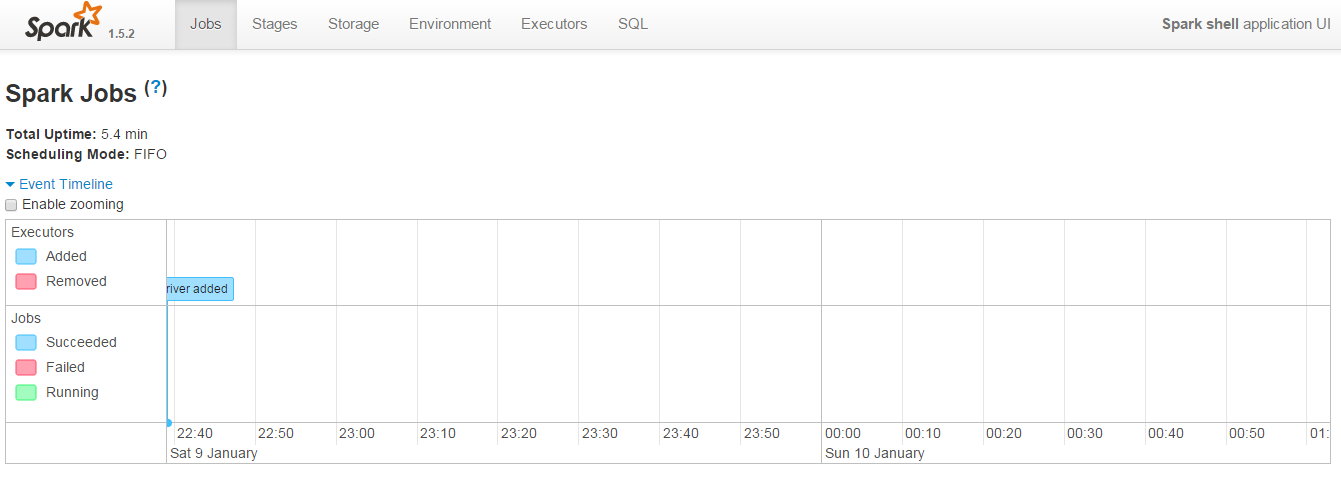

在浏览器中输入 192.168.10.1:4040(必须先启动 spark-shell,否则打不开 4040)

出现如图:

四、总结

spark-shell 的启动真的好慢。

下面关于 Hadoop 的文章您也可能喜欢,不妨看看:

Ubuntu14.04 下 Hadoop2.4.1 单机 / 伪分布式安装配置教程 http://www.linuxidc.com/Linux/2015-02/113487.htm

CentOS 安装和配置 Hadoop2.2.0 http://www.linuxidc.com/Linux/2014-01/94685.htm

CentOS 6.3 下 Hadoop 伪分布式平台搭建 http://www.linuxidc.com/Linux/2016-11/136789.htm

Ubuntu 14.04 LTS 下安装 Hadoop 1.2.1(伪分布模式)http://www.linuxidc.com/Linux/2016-09/135406.htm

Ubuntu 上搭建 Hadoop 环境(单机模式 + 伪分布模式)http://www.linuxidc.com/Linux/2013-01/77681.htm

实战 CentOS 系统部署 Hadoop 集群服务 http://www.linuxidc.com/Linux/2016-11/137246.htm

单机版搭建 Hadoop 环境图文教程详解 http://www.linuxidc.com/Linux/2012-02/53927.htm

Hadoop 2.6.0 HA 高可用集群配置详解 http://www.linuxidc.com/Linux/2016-08/134180.htm

Spark 1.5、Hadoop 2.7 集群环境搭建 http://www.linuxidc.com/Linux/2016-09/135067.htm

更多 Hadoop 相关信息见Hadoop 专题页面 http://www.linuxidc.com/topicnews.aspx?tid=13

本文永久更新链接地址:http://www.linuxidc.com/Linux/2016-11/137367.htm