共计 2077 个字符,预计需要花费 6 分钟才能阅读完成。

Hadoop 集群中的 Mahout-distribution-0.7 安装与配置

系统配置:

Ubuntu 12.04

hadoop-1.1.2

jdk1.6.0_45

Mahout 是 Hadoop 的一种高级应用。运行 Mahout 需要提前安装好 Hadoop,Mahout 只在 Hadoop 集群的 NameNode 节点上安装一个即可,其他数据节点上不需要安装。

1、下载二进制解压安装。

到 http://labs.renren.com/apache-mirror/mahout/0.7 下载,我选择下载二进制包,直接解压及可。

hadoop@ubuntu:~$ tar -zxvf mahout-distribution-0.7.tar.gz

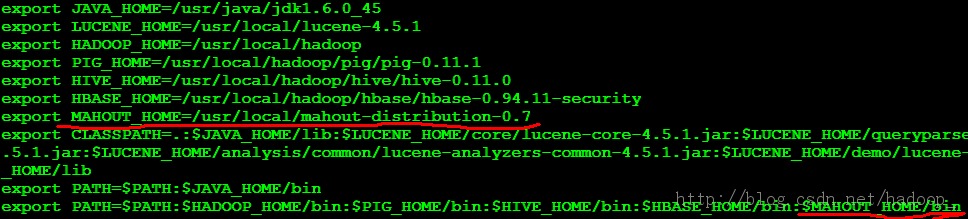

2、配置环境变量:/etc/profile

使环境变量生效:source /etc/profile

3、启动 hadoop

4、mahout –help

检查 Mahout 是否安装完好,看是否列出了一些算法

当然,这种方法并不准确,可以通过接下来的步骤进行验证。

5、mahout 使用准备

a. 下载一个文件 synthetic_control.data,下载地址:http://archive.ics.uci.edu/ml/databases/synthetic_control/synthetic_control.data

b. 创建测试目录 testdata,并把数据导入到这个 tastdata 目录中 (这里的目录的名字只能是 testdata)

hadoop@ubuntu:~/$ hadoop fs -mkdir testdata

hadoop@ubuntu:~/$ hadoop fs -put /usr/local/mahout-distribution-0.7/synthetic_control.data testdatac. 使用 kmeans 算法

hadoop@ubuntu:~/$ hadoop jar /usr/local/mahout-distribution-0.7/mahout-examples-0.7-job.jar org.apache.mahout.clustering.syntheticcontrol.kmeans.Job

6. 查看结果

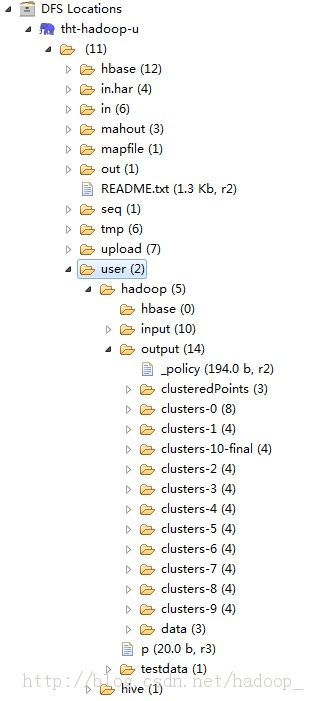

hadoop@ubuntu:~/$ hadoop fs -lsr output 如果看到以下结果那么算法运行成功,你的安装也就成功了。

clusteredPoints clusters-0 clusters-1 clusters-10 clusters-2 clusters-3 clusters-4 clusters-5 clusters-6 clusters-7 clusters-8 clusters-9 data

这是在 my-eclipse 下的目录树:

注:

clusteredPoints:存放的是最后聚类的结果,将 cluster-id 和 documents-id 都展示出来了,用 mahout seqdumper 读 clusteredPoints 结果的 key-value 类型是 (IntWritable,WeightedVectorWritable)

clusters-N:是第 N 次聚类的结果,其中 n 为某类的样本数目,c 为各类各属性的中心,r 为各类属性的半径。clusters- N 结果类型是 (Text,Cluster)

data:存放的是原始数据,这个文件夹下的文件可以用 mahout vectordump 来读取,原始数据是向量形式的,其它的都只能用 mahout seqdumper 来读取,向量文件也可以用 mahout seqdumper 来读取,只是用 vectordump 读取出来的是数字结果,没有对应的 key,用 seqdumper 读出来的可以看到 key,即对应的 url,而 value 读出来的是一个类描述,而不是数组向量

7、分析结果

![]()

相关阅读 :

Ubuntu 13.04 上搭建 Hadoop 环境 http://www.linuxidc.com/Linux/2013-06/86106.htm

Ubuntu 12.10 +Hadoop 1.2.1 版本集群配置 http://www.linuxidc.com/Linux/2013-09/90600.htm

Ubuntu 上搭建 Hadoop 环境(单机模式 + 伪分布模式)http://www.linuxidc.com/Linux/2013-01/77681.htm

Ubuntu 下 Hadoop 环境的配置 http://www.linuxidc.com/Linux/2012-11/74539.htm

单机版搭建 Hadoop 环境图文教程详解 http://www.linuxidc.com/Linux/2012-02/53927.htm

搭建 Hadoop 环境(在 Winodws 环境下用虚拟机虚拟两个 Ubuntu 系统进行搭建)http://www.linuxidc.com/Linux/2011-12/48894.htm

更多 Hadoop 相关信息见 Hadoop 专题页面 http://www.linuxidc.com/topicnews.aspx?tid=13