共计 2712 个字符,预计需要花费 7 分钟才能阅读完成。

一、准备工作

l 基本工具

1) 安装 epel,epel 是一个提供高质量软件包的项目。先检查主机上是否安装:

rpm -q epel-release2) 如果没有安装,使用 rpm 命令安装:

rpm -ivh http://dl.Fedoraproject.org/pub/epel/6/x86_64/epel-release-6-8.noarch.rpm(也可手动下载安装包安装)

3) 成功后查看其所依附的软件包:

rpm -qR epel-release4) 导入 key:

rpm --import /etc/pki/rpm-gpg/RPM-GPG-KEY-EPEL-65) 安装 yum-priority:

yum install yum-priorities6) 在主机仓库目录中可以查到 epel.repo, 命令:

①

cd /etc/yum.repos.d②

ls | grep epel7) 安装 pdsh:

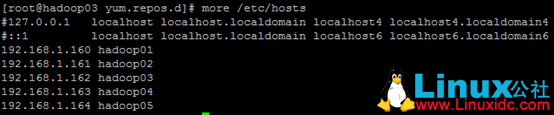

yum install pdshl 配置 /etc/hosts 和 /etc/sysconfig/network

以 Ambari 节点下修改 hosts 文件为例说明:(本机 192.168.1.162/Hadoop03)

l 设置 ssh 免密码登录

略…

l 关闭 SELinux、防火墙、packagekit

1) 关闭 SELinux

① 暂时关闭:

setenforce 0② 永久关闭:

vi /etc/selinux/config,将其中的 SELinux 设置:SELINUX=disabled

2) 关闭防火墙 :

chkconfig iptables off3) 关闭 packagekit:

vi /etc/yum/pluginconf.d/refresh-packagekit.conf, 将 enabled 设为 0

二、安装

l 下载 Ambari 仓库

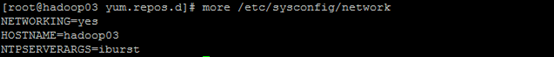

1) 进入 yum.repos.d 仓库目录:

cd /etc/yum.repos.d2) 下载 Ambari 仓库的资源清单文件:

wget http://public-repo-1.hortonworks.com/ambari/CentOS6/1.x/updates/1.6.1/ambari.repo

l 安装 epel repository

1) 安装 epel:

yum install epel-release2) 查看是否配置成功,命令:

yum repolist, 若成功,则应显示如下:

l 用 yum 安装 Ambari, 同时也会安装 PostgreSQL.

安装命令:

yum install ambari-serverl 配置 ambari-server

执行命令:

ambari-server setup,如果还没有关闭 SELinux,执行这个命令的过程中会提示,选择 y。然后会配置 PostgreSQL,选择 y 自动下载安装 jdk。之后配置数据库,选 n 使用默认数据库用户名 ambari-server 和密码 bigdata,选 y 自己创建用户名密码。

三、启动

l 启动 Ambari

1) 执行命令:

ambari-server start启动服务, 出现如下页面表示启动成功:

注意:如果是用普通用户例如 hadoop 安装 ambari, 并且数据库是 mysql, 启动时会报错,解决方案:

① 在 mysql 中建立用户

grant all privileges on *.* to 'admin'@'hadoop05' identified by‘admin’;

创建 ambari 数据库。

② 用 admin 用户登录 mysql,

use ambari; 然后

source /var/lib/ambari-server/resources/Ambari-DDL-MySQL-CREATE.sql,

导入 ambari 的 sql 脚本。

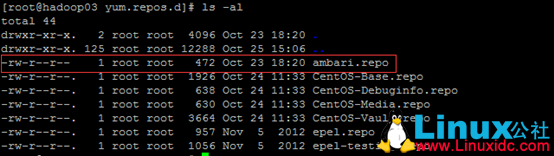

2) 在浏览器中输入“主机 IP:8080”进入登陆界面,默认用户名密码为 admin/admin。

这里要注意,前提是必须安装好 httpd, 并且启动 httpd 服务:

① 查看是否安装:

rpm -qa | grep httpd,如果没有,安装命令:

yum install httpd② 修改配置文件:

vi /etc/httpd/conf/httpd.conf, 如下:

![]()

![]()

③ 重启主机:

shutdown -r now, 等启动完成后,启动 httpd 服务:

servie httpd start3) Ambari 的相关配置命令

① 修改端口号:

vi /etc/ambari-server/conf/ambari.properties, 在文件中增加 client.api.port=<port_number>,本机 port_number 修改为 8888。

② 查看 Ambari 进程:

ps -ef | grep ambari③ 停止 Ambari 进程:

ambari-server stop④ 重启 Ambari 进程:

ambari-server restart四、磁盘扩容

问题引入:后续进行 MR Job 执行时,会报类似“磁盘空间不够”的错误,原因是 Ambari 安装所在目录的磁盘容量不够导致。

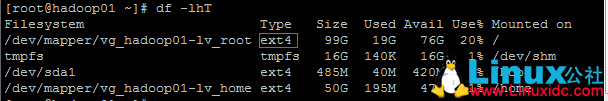

解决方案:由于 Ambari 安装后,会创建一个 LVM 的逻辑卷,供 Hadoop 运行产生的临时文件存储用,如下:

所以,我们只需要对 vg_hadoop01 进行扩容。操作如下:

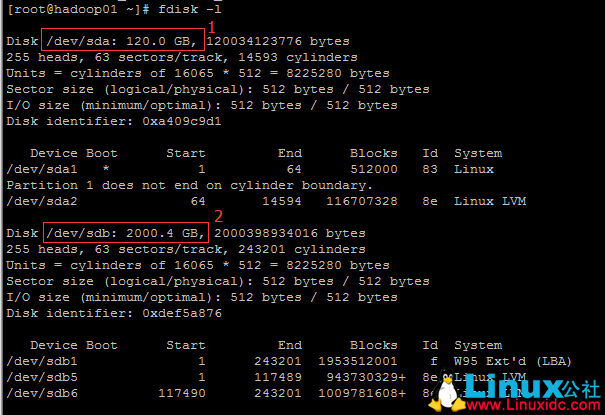

1) 1 表示第一块分区的信息,该分区已经被 Hadoop 占满;2 表示第二块分区的信息,也就是我们需要将它扩容到 vg_hadoop01 上的分区。如下:

2) 现将 /dev/sdb5 分区块(注意这里 Id 必须是 8e,System 必须是 Linux LVM)分配给 vg_hadoop01.

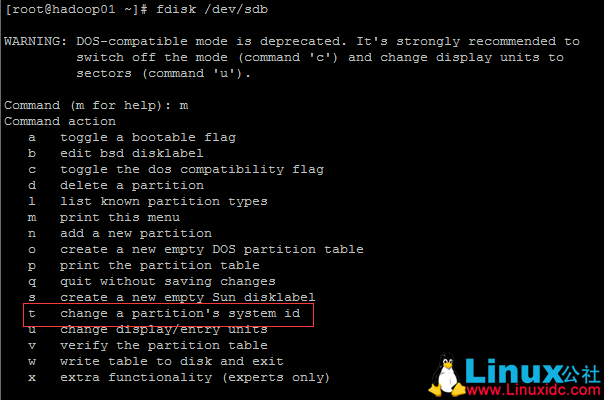

① 8e 和 Linux LVM 的设置命令:

fdisk /dev/sdb, 接着按 m,根据提示设置。

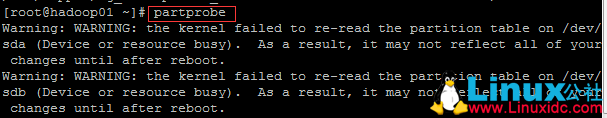

② 输入命令:partprobe, 让分区表生效。

③ 由于 LVM 所在的文件类型是 ext4, 所以新的分区必须格式化为 ext4.

格式化命令:

mkfs –t ext4 /dev/sdb5.

④ 创建 PV(物理卷),命令:

pvcreate /dev/sdb5,利用:pvdisplay 查看:

⑤ 扩容 LVM, 命令:

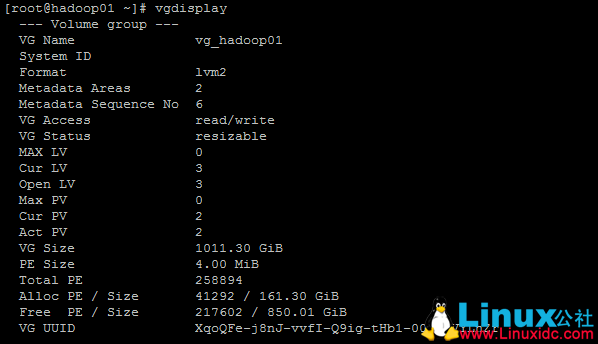

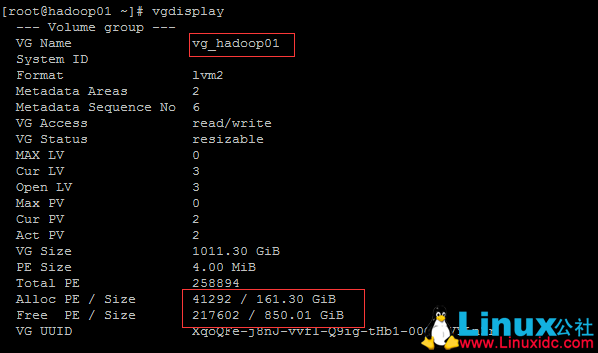

vgextend vg_hadoop01 /dev/sdb5,利用:vgdisplay 查看:

⑥ 将 LVM 中的容量扩展到 LV(逻辑卷),命令:

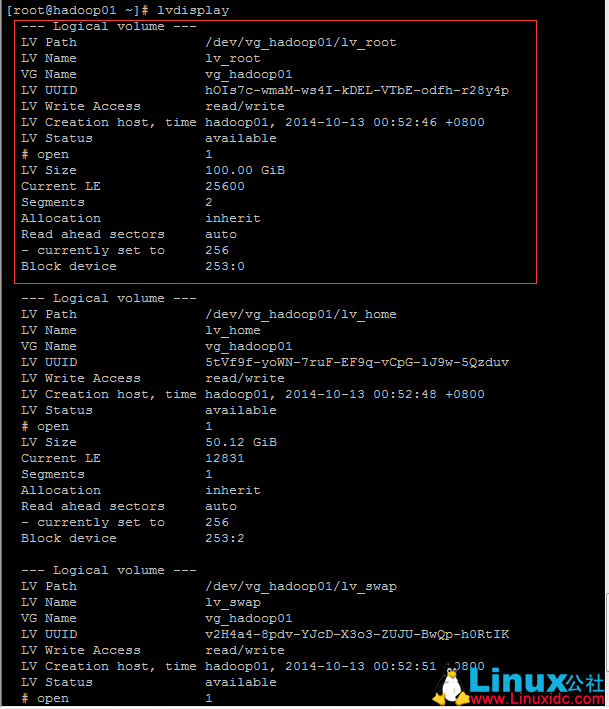

lvextend –L 100G /dev/vg_hadoop01/lv_root,将分区 /dev/vg_hadoop01/lv_root 的容量扩充到 100G. 利用 lvdisplay 查看:

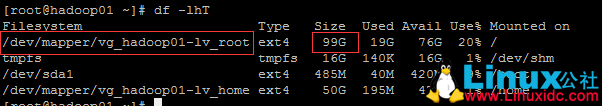

3) 执行该重设大小,对于当前正在使用的 /dev/vg_hadoop01/lv_root 有效. 命令:

resize2fs /dev/vg_hadoop01/lv_root,查看扩容后的挂载情况:df -lhT.

本文永久更新链接地址 :http://www.linuxidc.com/Linux/2017-03/141295.htm