共计 2835 个字符,预计需要花费 8 分钟才能阅读完成。

0. 抱怨与其他(此部分与标题没有太多联系):

首先一点想说的是版本问题,为什么标题我会写清楚版本号呢!原因就是版本不对真的很会坑人。

就在写这篇文章的同一天,我还写了另一篇,是

Hadoop2.7.3+Spark2.1.0 完全分布式环境 搭建全过程 http://www.linuxidc.com/Linux/2017-06/144926.htm

坑人的地方在哪里呢,Zeppelin0.6.2 不支持 Spark2.1.0 这个版本

于是我又仔细的查看了官网的教程:

得出的结论是我必须要装老版本的,还好的是支持 Spark2.0,于是我又安装了 Spark2.0.2

不过呢如果你没有任何的集群环境,上面这篇是值得参考的,只不过你得自己改下版本号,从 2.1.0 到 2.0.2,其他完全一样。

1. 下载 Zeppelin

wget http://www-eu.apache.org/dist/zeppelin/zeppelin-0.6.2/zeppelin-0.6.2-bin-all.tgz2. 解压并移动到相应的文件夹:

tar -xvf zeppelin-0.6.2-bin-all.tgz

mv zepplin-0.6.2-bin-all /opt3. 安装并修改配置文件:

(1)安装

网络安装版需要运行下面的命令:

./bin/install-interpreter.sh --all而完整版不需要,直接进入到 zeppelin 的根目录修改配置文件即可。

cd zepplin-0.6.2-bin-all(2)/opt/zeppelin-0.6.2-bin-all/conf/zeppelin-env.sh

export Java_HOME=/usr/java/jdk1.8.0_112/

export MASTER="spark://master:7077"

export SPARK_HOME=/opt/spark-2.0.2-bin-hadoop2.7/

export HADOOP_HOME=/opt/hadoop-2.7.3/

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop(3)/opt/zeppelin-0.6.2-bin-all/conf/zeppelin-site.xml

为了防止端口冲突我们将 8080 改为 8099,具体情况要看自己的机子决定:

<property>

<name>zeppelin.server.port</name>

<value>8099</value>

<description>Server port.</description>

</property>4. 启动或关闭:

修改之前的启动脚本为:

#!/bin/bash

echo -e "\033[31m ========Start The Cluster======== \033[0m"

echo -e "\033[31m Starting Hadoop Now !!! \033[0m"

/opt/hadoop-2.7.3/sbin/start-all.sh

echo -e "\033[31m Starting Spark Now !!! \033[0m"

/opt/spark-2.0.2-bin-hadoop2.7/sbin/start-all.sh

echo -e "\033[31m Starting Zeppelin Now !!! \033[0m"

/opt/zeppelin-0.6.2-bin-all/bin/zeppelin-daemon.sh start

echo -e "\033[31m The Result Of The Command \"jps\": \033[0m"

jps

echo -e "\033[31m ========END======== \033[0m"修改之前的关闭脚本为:

5. 运行官网的例子:

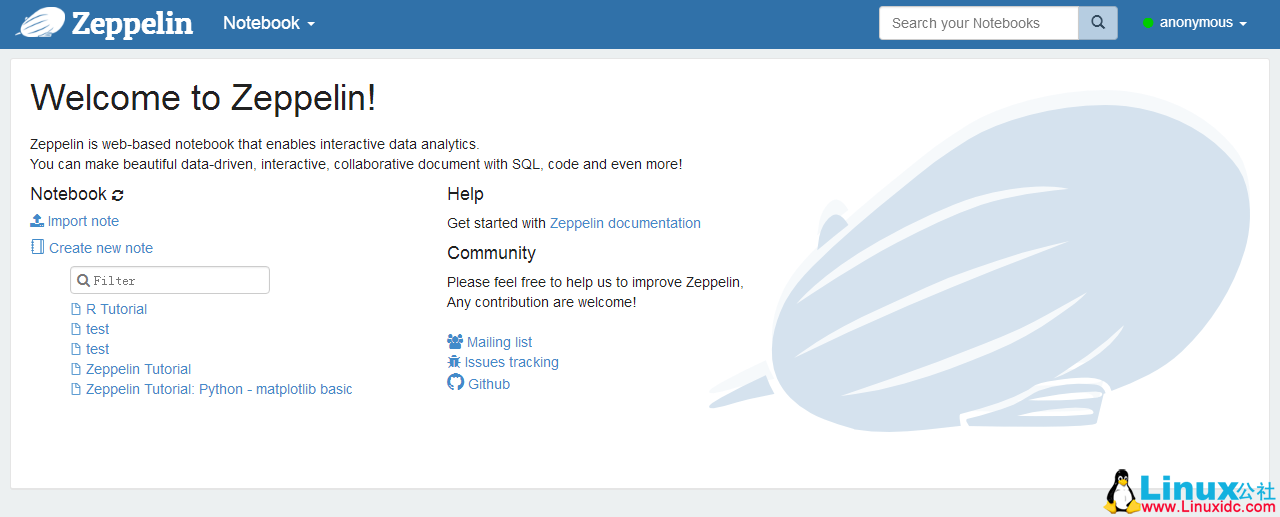

在浏览器里输入地址:

z-ip 指代 zepplin 所在机子的 ip(xxx.xxx.xxx.xxx)

即:http://z-ip:8099/#/

如下图:

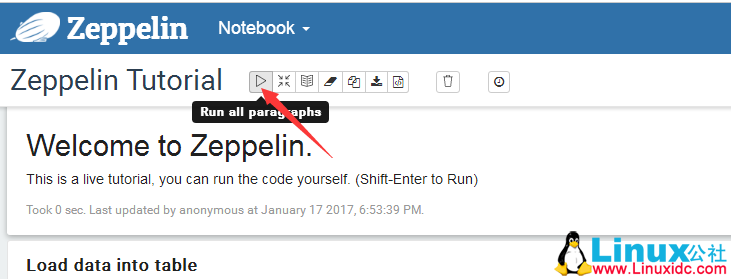

然后我们点 Notebook->Zeppelin Tutorial

然后点击 save

然后在最上面的部分点击如下图所示的位置:

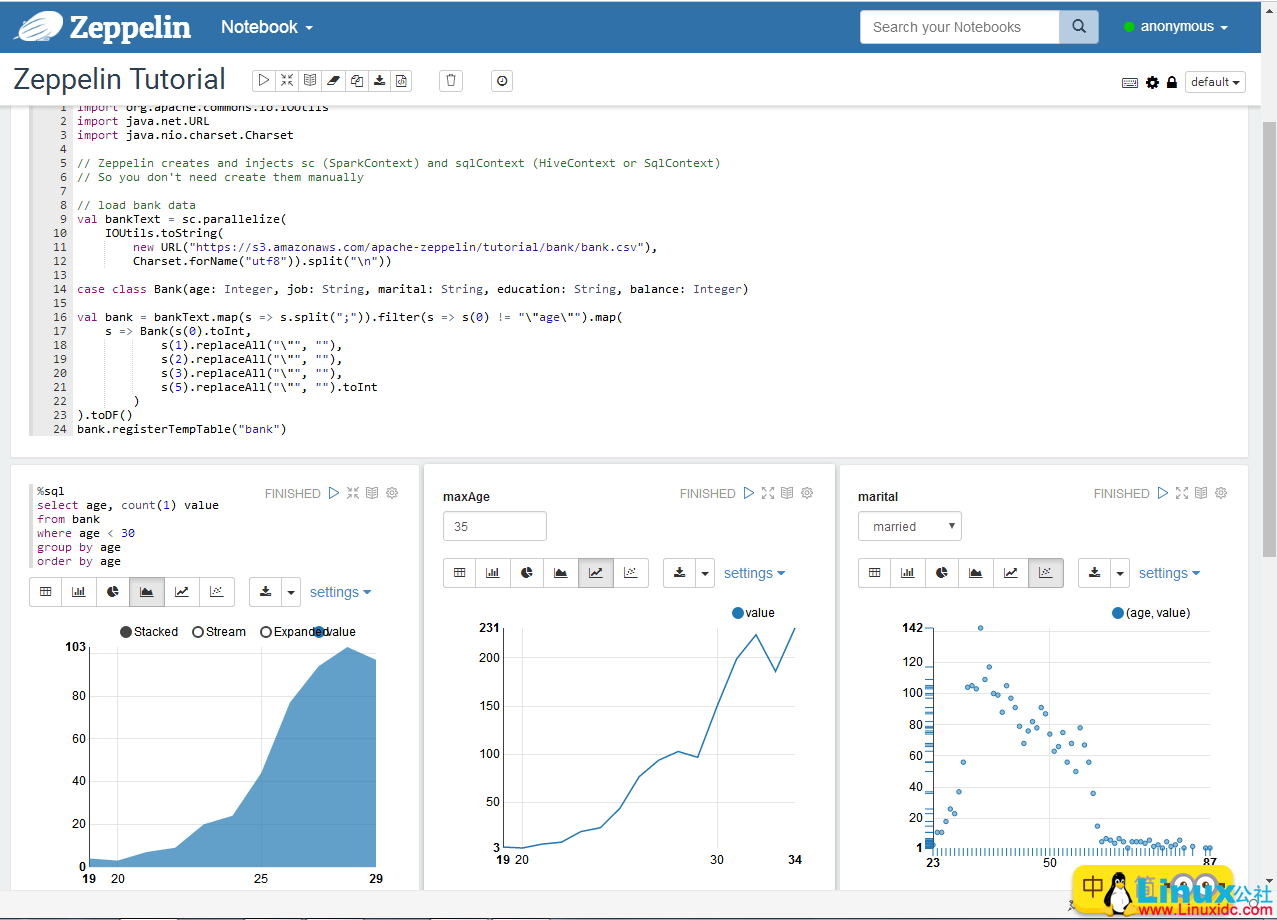

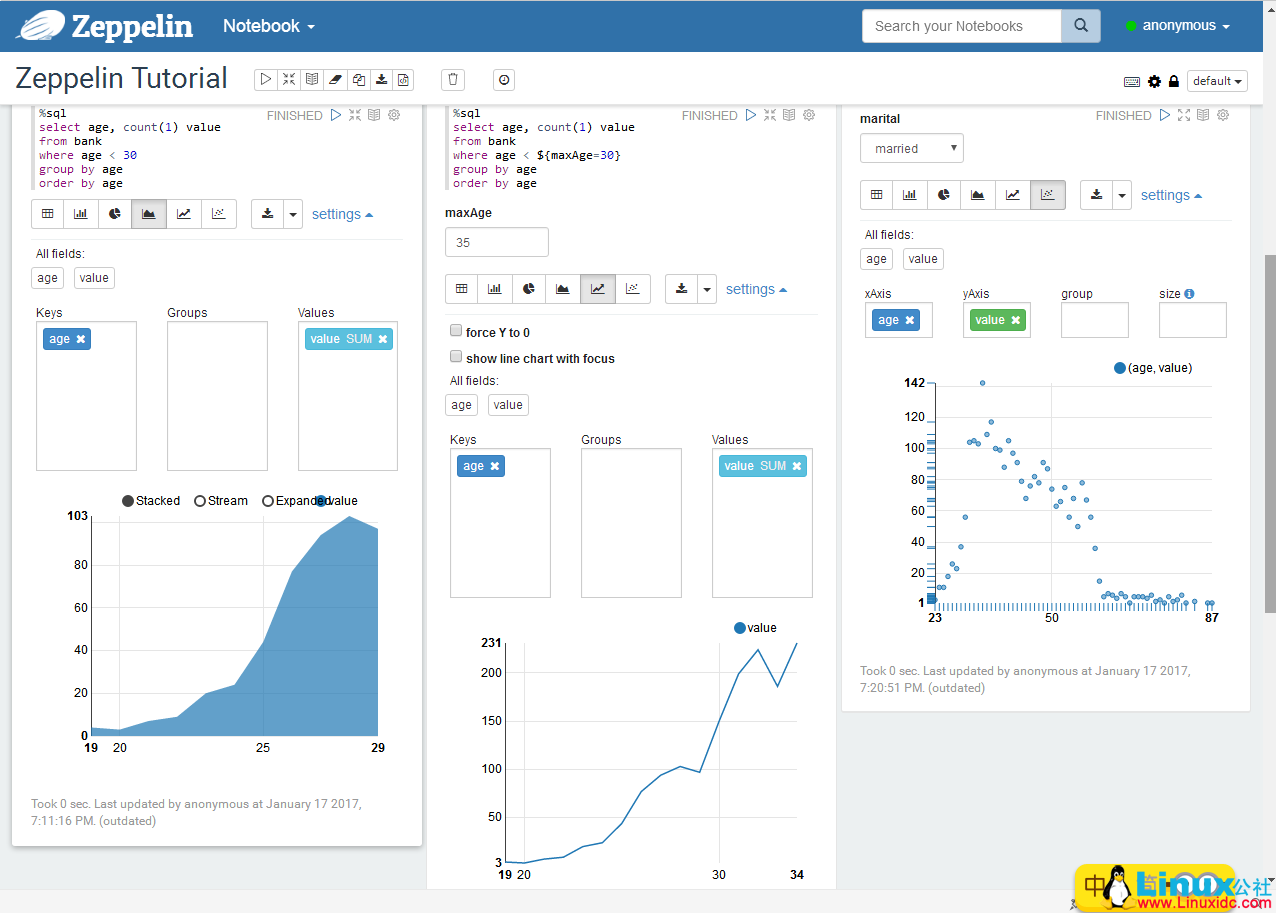

运行结果在截取两张图给大家:

最后一个要注意的是,这是我自己摸索着搞得,有问题发生是正常的,所以标题加上了初探两个字!

更多 Spark 相关教程见以下内容:

CentOS 7.0 下安装并配置 Spark http://www.linuxidc.com/Linux/2015-08/122284.htm

Spark1.0.0 部署指南 http://www.linuxidc.com/Linux/2014-07/104304.htm

Spark2.0 安装配置文档 http://www.linuxidc.com/Linux/2016-09/135352.htm

Spark 1.5、Hadoop 2.7 集群环境搭建 http://www.linuxidc.com/Linux/2016-09/135067.htm

Spark 官方文档 – 中文翻译 http://www.linuxidc.com/Linux/2016-04/130621.htm

CentOS 6.2(64 位)下安装 Spark0.8.0 详细记录 http://www.linuxidc.com/Linux/2014-06/102583.htm

Spark2.0.2 Hadoop2.6.4 全分布式配置详解 http://www.linuxidc.com/Linux/2016-11/137367.htm

Ubuntu 14.04 LTS 安装 Spark 1.6.0(伪分布式)http://www.linuxidc.com/Linux/2016-03/129068.htm

Spark 的详细介绍:请点这里

Spark 的下载地址:请点这里

本文永久更新链接地址:http://www.linuxidc.com/Linux/2017-06/144929.htm