共计 2572 个字符,预计需要花费 7 分钟才能阅读完成。

一、hadoop 伪分布式搭建

其实官网有比较详实的说明,英语好的可以直接看官网,地址

1、安装 openjdk-7-jdk、scala

$ sudo apt-get install openjdk-7-jdk scala

2、安装 ssh、rsync

$ sudo apt-get install ssh rsync

3、下载 hadoop 编译包,镜像地址(国内镜像竟然比 US 的还慢,不能忍,注意 2.7 的编译包为 64 位)

查是 32 还是 64 位的办法

$ cd hadoop-2.7.2/lib/native

$ file libhadoop.so.1.0.0

hadoop-2.7.0/lib/native/libhadoop.so.1.0.0: ELF 64-bit LSB shared object, AMD x86-64, version 1 (SYSV), not stripped

4、配置环境变量

hadoop 配置文件指定 java 路径

$ vim etc/hadoop/hadoop-env.sh

export JAVA_HOME=/usr/lib/jvm/java-7-openjdk-amd64

执行命令查看是否成功

$ bin/hadoop version

5、修改 hadoop 配置文件

$ vim etc/hadoop/core-site.xml:

< configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

< /configuration>

$ vim etc/hadoop/hdfs-site.xml:

< configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

< /configuration>

6、设置 hadoop ssh 无密码访问

$ ssh-keygen -t dsa -P ” -f ~/.ssh/id_dsa

$ cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys

7、格式化节点和启动 hadoop

$ bin/hdfs namenode -format

$ sbin/start-dfs.sh

打开浏览器 http://localhost:50070/ 看是否成功

hdfs 配置:在 hdfs 上创建用户文件夹,username 最好和当前用户名相同,不然会可能出现权限问题

$ bin/hdfs dfs -mkdir /user

$ bin/hdfs dfs -mkdir /user/<username>

上传文件及文件夹使用命令:

$ bin/hdfs dfs -put /home/admin/README.md /user/<username>

8、yarn 配置

$ vim etc/hadoop/mapred-site.xml:

< configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

< /configuration>

$ vim etc/hadoop/yarn-site.xml:

< configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

< /configuration>

启动 yarn

$ sbin/start-yarn.sh

http://localhost:8088/ 查看是否成功

至此 hadoop 单节点伪分布式安装配置完成

二、spark 安装配置

spark 的安装相对就要简单多了

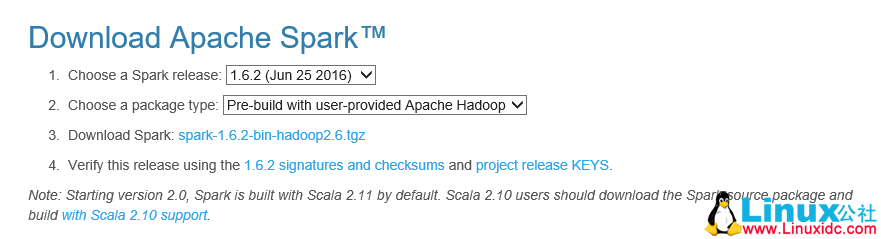

1、首先下载,地址

因为我之前已经有 hadoop 了所以选择第二个下载

2、下载解压后进入目录

$ cd spark-1.6.2-bin-without-hadoop/conf

$ cp spark-env.sh.template spark-env.sh

$ cp spark-defaults.conf.template spark-defaults.conf

$ vim conf/spark-env.sh

最后添加

export HADOOP_HOME=/home/administrator/project/hadoop-2.7.2

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

export SPARK_DIST_CLASSPATH=$($HADOOP_HOME/bin/hadoop classpath)

最后一个需要 hadoop 添加了环境变量才行。

官网配置中没有前两个配置,我运行例子时总报错,找不到 hdfs jar 包。

3、回到解压目录运行示例

对于 Python 例子,使用 spark-submit 脚本代替:

$ bin/spark-submit examples/src/main/python/pi.py

成功则到此配置完成。

更多 Hadoop 相关信息见 Hadoop 专题页面 http://www.linuxidc.com/topicnews.aspx?tid=13

本文永久更新链接地址 :http://www.linuxidc.com/Linux/2017-11/148349.htm