共计 11297 个字符,预计需要花费 29 分钟才能阅读完成。

本文所需环境:Linux(Ubuntu 15.04 Server),Hadoop(hadoop-2.7.2),OS(Windows amd 64)

1. 安装 Java JDK

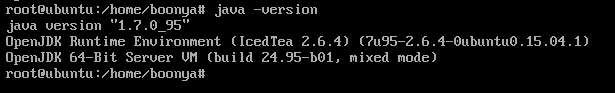

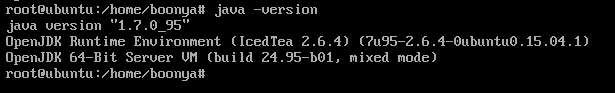

Hadoop 运行依赖环境,安装 JDK6 及以上版本。首先检查是否存在 JDK.

- java -version

下面表示已经安装了:

- root@ubuntu:~# java -version

- java version “1.7.0_95”

- OpenJDK Runtime Environment (IcedTea 2.6.4) (7u95-2.6.4-0ubuntu0.15.04.1)

- OpenJDK 64-Bit Server VM (build 24.95-b01, mixed mode)

| root@ubuntu:~# java -version | |

| java version "1.7.0_95" | |

| OpenJDK Runtime Environment (IcedTea 2.6.4) (7u95-2.6.4-0ubuntu0.15.04.1) | |

| OpenJDK 64-Bit Server VM (build 24.95-b01, mixed mode) |

注:因为我自己在 Ubuntu 上安装过 Java 的默认版本所以这里就会显示我的 java 版本。

如果没有安装,可以使用以下命令来安装:

- # 首先更新 apt-get 命令

- apt-get update

- # 安装 jdk:你可以使用 jps 命令查看是否安装支持 jps 的 jdk 版本,jps 命令 Java1.5 以上版本支持

- jps

- # 如果不存在会提示 jdk 的版本,输入如下命令进行安装

- apt-get install openjdk-7-jdk

| apt-get update | |

| jps | |

| apt-get install openjdk-7-jdk |

2. 安装 Apache Hadoop 需要做的准备工作

2.1创建专用用户

Hadoop 需要一个单独的专用用户来执行。 具有对 Hadoop 可执行文件和数据文件夹的完全控制。要创建新用户,请在终端中使用以下命令。

- #create a user group for hadoop

- sudo addgroup hadoop

- #create user hduser and add it to the hadoop usergroup

- sudo adduser –ingroup hadoop hduser

| #create a user group for hadoop | |

| sudo addgroup hadoop | |

| #create user hduser and add it to the hadoop usergroup | |

| sudo adduser --ingroup hadoop hduser |

直接默认按 Enter 即可。

2.3禁用 ipv6

下一步是在所有机器上禁用 ipv6。 Hadoop 设置为使用 ipv4,这就是为什么我们需要在创建 hadoop 集群之前禁用 ipv6。使用 vi(或您选择的任何其他编辑器,如:nano)以 root 身份打开 /etc/sysctl.conf:

- vi /etc/sysctl.conf

并在文件末尾添加以下行:

- #commands to disable ipv6

- net.ipv6.conf.all.disable-ipv6=1

- net.ipv6.conf.default.disable-ipv6=1

- net.ipv6.conf.lo.disable-ipv6=1

| #commands to disable ipv6 | |

| net.ipv6.conf.all.disable-ipv6=1 | |

| net.ipv6.conf.default.disable-ipv6=1 | |

| net.ipv6.conf.lo.disable-ipv6=1 |

vi 命令——i: 进行编辑 ;ESC :wq 保存退出

要检查 ipv6 是否正确禁用,我们可以使用以下命令:

- cat /proc/sys/net/ipv6/conf/all/disable-ipv6

2.4 安装 SSH 和设置证书

Hadoop 需要 SSH 访问来管理其远程节点以及本地机器上的节点。对于此示例,我们需要配置 SSH 访问 localhost。

因此,我们将确保我们已经启动并运行 SSH 并设置公钥访问权限,以允许它在没有密码的情况下登录。 我们将设置 SSH 证书以允许密码较少的身份验证。使用以下命令执行所需的步骤。

ssh 有两个主要组件:

- ssh:我们用来连接远程机器的命令 – 客户端

- sshd:在服务器上运行并允许客户端连接到服务器的守护程序

SSH 在 Ubuntu 上预先启用,但为了确保 sshd 启用,我们需要使用以下命令首先安装 ssh。

- #installing ssh

- sudo apt-get install ssh

| sudo apt-get install ssh |

要确保一切都正确设置,请使用以下命令:

验证的输出如下:

- root@ubuntu:~# which ssh

- /usr/local/ssh

- root@ubuntu:~# which sshd

- /usr/local/sshd

| root@ubuntu:~# which ssh | |

| /usr/local/ssh | |

| root@ubuntu:~# which sshd | |

| /usr/local/sshd |

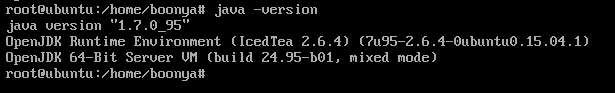

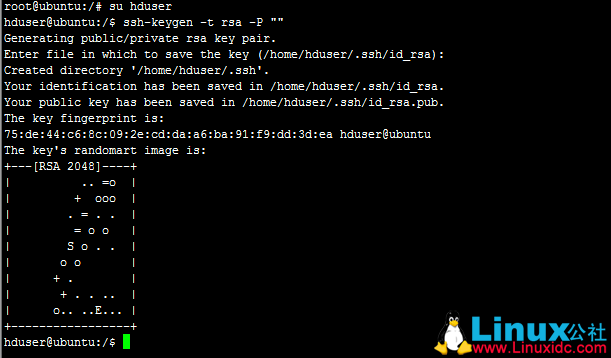

现在,为了生成 ssh 证书,我们将切换到 hduser 用户。在以下命令中,我们保持密码为空,同时生成 ssh 的密钥,如果您愿意,可以给它一些密码。

- #change to user hduser

- su hduser

- #generate ssh key

- ssh-keygen -t rsa -P “”

| #change to user hduser | |

| su hduser | |

| #generate ssh key | |

| ssh-keygen -t rsa -P "" |

第二个命令将为机器创建一个 RSA 密钥对。 此键的密码将为空,如命令中所述。它将要求存储密钥的路径,默认路径为 $ HOME / .ssh / id-rsa.pub,当提示保持同一路径时,按 Enter 键。如果您计划更改路径,请记住它,因为它将在下一步中需要。

使用上一步中创建的密钥启用对机器的 SSH 访问。为此,我们必须将密钥添加到机器的授权密钥列表。

- cat $HOME/.ssh/id_rsa.pub >> $HOME/.ssh/authorized_keys

我们可以检查 ssh 是否工作如下,是 ssh 到 localhost 成功没有密码提示,然后证书正确启用。

- ssh localhost

到目前为止,我们已经完成了 Apache Hadoop 的所有先决条件。我们将在下一节中检查如何设置 Hadoop。

更多��情见请继续阅读下一页的精彩内容:http://www.linuxidc.com/Linux/2017-11/148343p2.htm

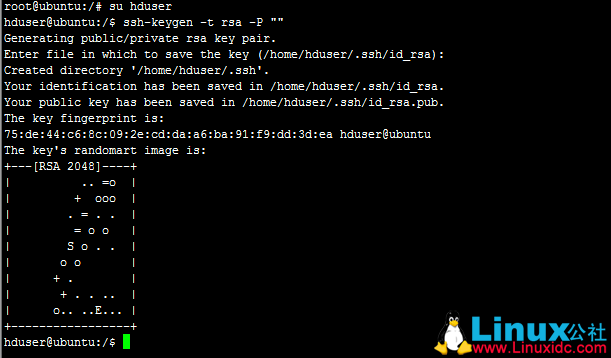

3. 安装 Apache Hadoop

3.1 wget 下载 Hadoop

- wget http://mirrors.tuna.tsinghua.edu.cn/apache/hadoop/common/hadoop-2.7.2/hadoop-2.7.2.tar.gz

3.2 解压并修改用户分组权限

1. 创建 usr/local/hadoop 文件夹

- mk /usr/local/hadoop

2.将./ 路径下的 hadoop-2.7.2.tar.gz 的文件拷贝到 usr/local/hadoop 文件夹

- cp hadoop-2.7.2.tar.gz /usr/local/hadoop/hadoop-2.7.2.tar.gz

3. 解压hadoop-2.7.2.tar.gz

- tar -zxf /usr/local/hadoop/hadoop-2.7.2.tar.gz

4.更改文件夹的所有者为 hduser 和 hadoop 组

- chown -R hduser:hadoop /usr/local/hadoop

3.2 更新 bash

1. 更新用户 hduser 的 bashrc 文件。

- su hduser

- vi $HOME/.bashrc

| su hduser | |

| vi $HOME/.bashrc |

2.在文件末尾,添加以下行。

- export HADOOP_HOME=/usr/local/hadoop

- export JAVA_HOME=/usr/lib/jvm/java-7-openjdk-amd64

- #Some convenient aliases

- unalias fs &> /dev/null

- alias fs=”hadoop fs”

- unalias hls &> /dev/null

- alias hls=”fs -ls”

- export PATH=$PATH:$HADOOP_HOME/bin

| export HADOOP_HOME=/usr/local/hadoop | |

| export JAVA_HOME=/usr/lib/jvm/java-7-openjdk-amd64 | |

| #Some convenient aliases | |

| unalias fs &> /dev/null | |

| alias fs="hadoop fs" | |

| unalias hls &> /dev/null | |

| alias hls="fs -ls" | |

| export PATH=$PATH:$HADOOP_HOME/bin |

方便别名的块是可选的,可以省略。 JAVA_HOME,HADOOP_HOME 和 PATH 是唯一的强制要求。

3.3配置 Hadoop

在这一步中,我们将配置 Hadoop。

1.在 / usr / local / hadoop / etc / hadoop 中打开 hadoop-env.sh 并设置 JAVA_HOME 变量,如下所示:

- export JAVA_HOME=/usr/lib/jvm/java-7-openjdk-amd64

注意:到 java 的路径应该是 java 在系统中存在的路径。默认情况下,它应该在 / usr / lib/jvm 文件夹中,但确保它是根据您的系统的正确路径。此外,确保您要使用的 java 版本是正确的。下面的截图显示了需要在 hadoop-env.sh 中修改它的位置。

2.接下来,我们将在 / usr / local / hadoop / etc / hadoop / 文件夹中配置 core-site.xml,并添加以下属性

- <configuration>

- <property>

- <name>fs.defaultFS</name>

- <value>hdfs://localhost:54310</value>

- </property>

- </configuration>

| <configuration> | |

| <property> | |

| <name>fs.defaultFS</name> | |

| <value>hdfs://localhost:54310</value> | |

| </property> | |

| </configuration> |

这将告诉系统系统上应运行默认文件系统的位置。

3.接下来,我们需要更新 hdfs-site.xml。此文件用于指定将用作 namenode 和 datanode 的目录。

- <configuration>

- <property>

- <name>dfs.replication</name>

- <value>2</value>

- </property>

- <property>

- <name>dfs.namenode.name.dir</name>

- <value>/usr/local/hadoop/hdfs/namenode</value>

- </property>

- <property>

- <name>dfs.datanode.data.dir</name>

- <value>/usr/local/hadoop/hdfs/datanode</value>

- </property>

- </configuration>

| <configuration> | |

| <property> | |

| <name>dfs.replication</name> | |

| <value>2</value> | |

| </property> | |

| <property> | |

| <name>dfs.namenode.name.dir</name> | |

| <value>/usr/local/hadoop/hdfs/namenode</value> | |

| </property> | |

| <property> | |

| <name>dfs.datanode.data.dir</name> | |

| <value>/usr/local/hadoop/hdfs/datanode</value> | |

| </property> | |

| </configuration> |

4.现在,我们将更新 mapred-site.xml 文件。文件夹 / usr / local / hadoop / etc / hadoop / 包含文件 mapred-site.xml.template。在修改之前将此文件重命名为 mapred-site.xml。

- <configuration>

- <property>

- <name>mapreduce.jobtracker.address</name>

- <value>localhost:54311</value>

- </property>

- </configuration>

| <configuration> | |

| <property> | |

| <name>mapreduce.jobtracker.address</name> | |

| <value>localhost:54311</value> | |

| </property> | |

| </configuration> |

3.4 格式化 Apache Hadoop 文件系统

我们现在完成所有的配置,所以在启动集群之前,我们需要格式化 namenode。为此,请在终端上使用以下命令。

- hdfs namenode -format

此命令应该在控制台输出上没有任何错误的情况下执行。如果它没有任何错误地执行,我们很好在我们的 Ubuntu 系统上启动 Apache Hadoop 实例。

3.5 启动 Apache Hadoop

现在是开始 Hadoop 的时候了。以下是这样做的命令:

/usr/local/hadoop/sbin/start-dfs.sh

注:可能会遇到执行文件 Permission Denied,只需要对 hduser 相关路径和类型的文件权限就可以了。

chmod 777 /usr/local/hadoop/sbin/start-dfs.sh

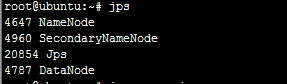

一旦 dfs 启动没有任何错误,我们可以使用命令 jps 检查一切是否正常工作

cd /usr/local/hadoop/sbin

#Checking the status of the Hadoop components

jps

| cd /usr/local/hadoop/sbin | |

| #Checking the status of the Hadoop components | |

| jps |

此命令显示正确运行的 Hadoop 的所有组件,我们应该看到至少一个 Namenode 和 Datanode:

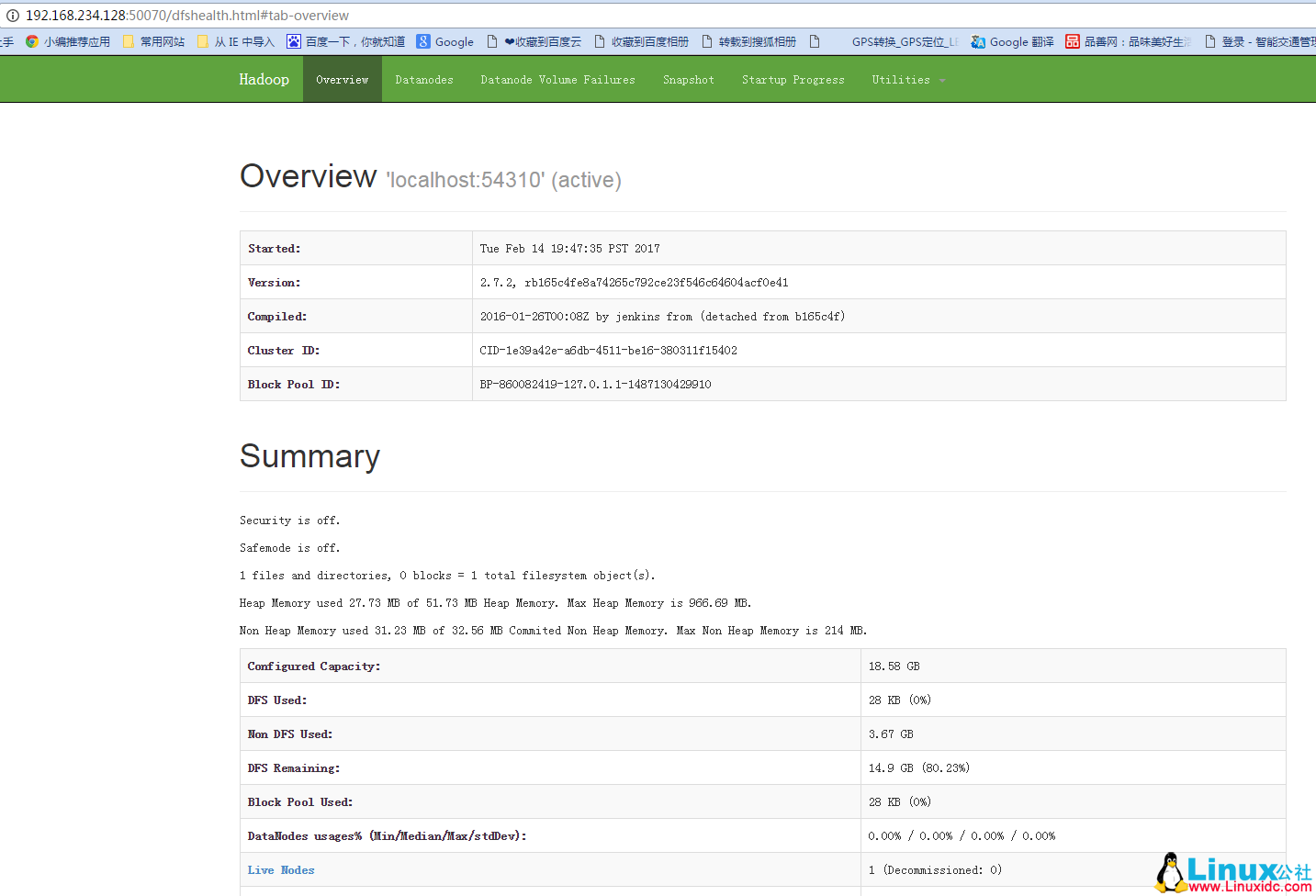

用 http://192.168.234.128:50070 上的 Namenode 的 Web 界面检查 Apache Hadoop 的状态。

3.5 停止 Apache Hadoop

现在是开始 Hadoop 的时候了。以下是这样做的命令:

至此 Ubuntu Server 安装 Apache Hadoop 结束!

Hadoop 项目之基于 CentOS7 的 Cloudera 5.10.1(CDH)的安装部署 http://www.linuxidc.com/Linux/2017-04/143095.htm

Hadoop2.7.2 集群搭建详解(高可用)http://www.linuxidc.com/Linux/2017-03/142052.htm

使用 Ambari 来部署 Hadoop 集群(搭建内网 HDP 源)http://www.linuxidc.com/Linux/2017-03/142136.htm

Ubuntu 14.04 下 Hadoop 集群安装 http://www.linuxidc.com/Linux/2017-02/140783.htm

CentOS 6.7 安装 Hadoop 2.7.2 http://www.linuxidc.com/Linux/2017-08/146232.htm

Ubuntu 16.04 上构建分布式 Hadoop-2.7.3 集群 http://www.linuxidc.com/Linux/2017-07/145503.htm

CentOS 7.3 下 Hadoop2.8 分布式集群安装与测试 http://www.linuxidc.com/Linux/2017-09/146864.htm

CentOS 7 下 Hadoop 2.6.4 分布式集群环境搭建 http://www.linuxidc.com/Linux/2017-06/144932.htm

Hadoop2.7.3+Spark2.1.0 完全分布式集群搭建过程 http://www.linuxidc.com/Linux/2017-06/144926.htm

更多 Hadoop 相关信息见Hadoop 专题页面 http://www.linuxidc.com/topicnews.aspx?tid=13

完整 PDF 文档可以到 Linux 公社资源站下载:

—————————————— 分割线 ——————————————

免费下载地址在 http://linux.linuxidc.com/

用户名与密码都是www.linuxidc.com

具体下载目录在 /2017 年资料 /11 月 / 7 日 /Ubuntu 15.04 Server 安装 Apache Hadoop 2.7.2/

下载方法见 http://www.linuxidc.com/Linux/2013-07/87684.htm

—————————————— 分割线 ——————————————

本文永久更新链接地址:http://www.linuxidc.com/Linux/2017-11/148343tm

本文所需环境:Linux(Ubuntu 15.04 Server),Hadoop(hadoop-2.7.2),OS(Windows amd 64)

1. 安装 Java JDK

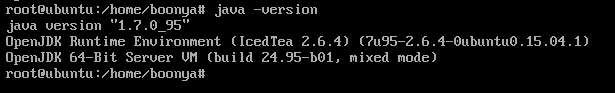

Hadoop 运行依赖环境,安装 JDK6 及以上版本。首先检查是否存在 JDK.

- java -version

下面表示已经安装了:

- root@ubuntu:~# java -version

- java version “1.7.0_95”

- OpenJDK Runtime Environment (IcedTea 2.6.4) (7u95-2.6.4-0ubuntu0.15.04.1)

- OpenJDK 64-Bit Server VM (build 24.95-b01, mixed mode)

| root@ubuntu:~# java -version | |

| java version "1.7.0_95" | |

| OpenJDK Runtime Environment (IcedTea 2.6.4) (7u95-2.6.4-0ubuntu0.15.04.1) | |

| OpenJDK 64-Bit Server VM (build 24.95-b01, mixed mode) |

注:因为我自己在 Ubuntu 上安装过 Java 的默认版本所以这里就会显示我的 java 版本。

如果没有安装,可以使用以下命令来安装:

- # 首先更新 apt-get 命令

- apt-get update

- # 安装 jdk:你可以使用 jps 命令查看是否安装支持 jps 的 jdk 版本,jps 命令 Java1.5 以上版本支持

- jps

- # 如果不存在会提示 jdk 的版本,输入如下命令进行安装

- apt-get install openjdk-7-jdk

| apt-get update | |

| jps | |

| apt-get install openjdk-7-jdk |

2. 安装 Apache Hadoop 需要做的准备工作

2.1创建专用用户

Hadoop 需要一个单独的专用用户来执行。 具有对 Hadoop 可执行文件和数据文件夹的完全控制。要创建新用户,请在终端中使用以下命令。

- #create a user group for hadoop

- sudo addgroup hadoop

- #create user hduser and add it to the hadoop usergroup

- sudo adduser –ingroup hadoop hduser

| #create a user group for hadoop | |

| sudo addgroup hadoop | |

| #create user hduser and add it to the hadoop usergroup | |

| sudo adduser --ingroup hadoop hduser |

直接默认按 Enter 即可。

2.3禁用 ipv6

下一步是在所有机器上禁用 ipv6。 Hadoop 设置为使用 ipv4,这就是为什么我们需要在创建 hadoop 集群之前禁用 ipv6。使用 vi(或您选择的任何其他编辑器,如:nano)以 root 身份打开 /etc/sysctl.conf:

- vi /etc/sysctl.conf

并在文件末尾添加以下行:

- #commands to disable ipv6

- net.ipv6.conf.all.disable-ipv6=1

- net.ipv6.conf.default.disable-ipv6=1

- net.ipv6.conf.lo.disable-ipv6=1

| #commands to disable ipv6 | |

| net.ipv6.conf.all.disable-ipv6=1 | |

| net.ipv6.conf.default.disable-ipv6=1 | |

| net.ipv6.conf.lo.disable-ipv6=1 |

vi 命令——i: 进行编辑 ;ESC :wq 保存退出

要检查 ipv6 是否正确禁用,我们可以使用以下命令:

- cat /proc/sys/net/ipv6/conf/all/disable-ipv6

2.4 安装 SSH 和设置证书

Hadoop 需要 SSH 访问来管理其远程节点以及本地机器上的节点。对于此示例,我们需要配置 SSH 访问 localhost。

因此,我们将确保我们已经启动并运行 SSH 并设置公钥访问权限,以允许它在没有密码的情况下登录。 我们将设置 SSH 证书以允许密码较少的身份验证。使用以下命令执行所需的步骤。

ssh 有两个主要组件:

- ssh:我们用来连接远程机器的命令 – 客户端

- sshd:在服务器上运行并允许客户端连接到服务器的守护程序

SSH 在 Ubuntu 上预先启用,但为了确保 sshd 启用,我们需要使用以下命令首先安装 ssh。

- #installing ssh

- sudo apt-get install ssh

| sudo apt-get install ssh |

要确保一切都正确设置,请使用以下命令:

验证的输出如下:

- root@ubuntu:~# which ssh

- /usr/local/ssh

- root@ubuntu:~# which sshd

- /usr/local/sshd

| root@ubuntu:~# which ssh | |

| /usr/local/ssh | |

| root@ubuntu:~# which sshd | |

| /usr/local/sshd |

现在,为了生成 ssh 证书,我们将切换到 hduser 用户。在以下命令中,我们保持密码为空,同时生成 ssh 的密钥,如果您愿意,可以给它一些密码。

- #change to user hduser

- su hduser

- #generate ssh key

- ssh-keygen -t rsa -P “”

| #change to user hduser | |

| su hduser | |

| #generate ssh key | |

| ssh-keygen -t rsa -P "" |

第二个命令将为机器创建一个 RSA 密钥对。 此键的密码将为空,如命令中所述。它将要求存储密钥的路径,默认路径为 $ HOME / .ssh / id-rsa.pub,当提示保持同一路径时,按 Enter 键。如果您计划更改路径,请记住它,因为它将在下一步中需要。

使用上一步中创建的密钥启用对机器的 SSH 访问。为此,我们必须将密钥添加到机器的授权密钥列表。

- cat $HOME/.ssh/id_rsa.pub >> $HOME/.ssh/authorized_keys

我们可以检查 ssh 是否工作如下,是 ssh 到 localhost 成功没有密码提示,然后证书正确启用。

- ssh localhost

到目前为止,我们已经完成了 Apache Hadoop 的所有先决条件。我们将在下一节中检查如何设置 Hadoop。

更多��情见请继续阅读下一页的精彩内容:http://www.linuxidc.com/Linux/2017-11/148343p2.htm