共计 6870 个字符,预计需要花费 18 分钟才能阅读完成。

背景

技术说明

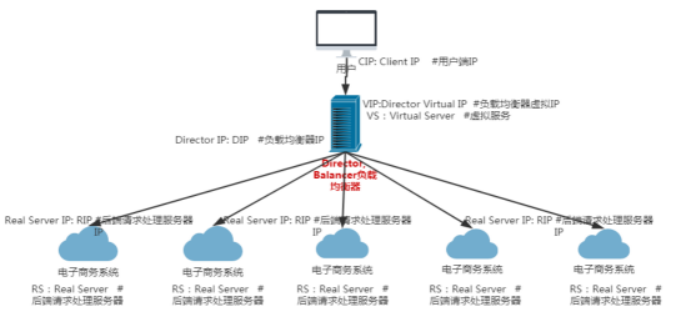

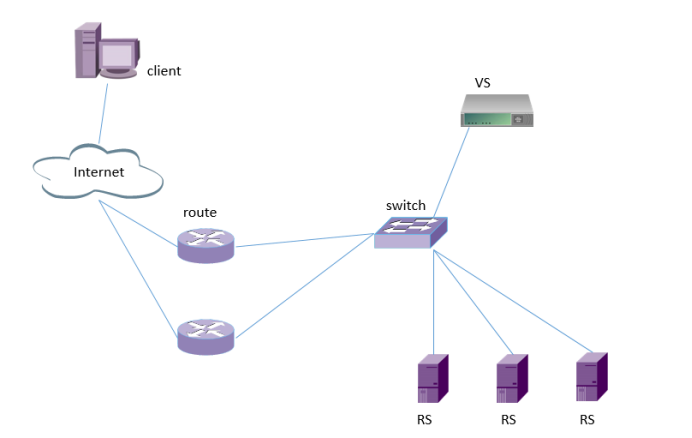

负载均衡集群技术

负载均衡集群技术实现

负载均衡技术演示图

lvs 是实现负载均衡技术的一种,下面来介绍一下 lvs

LVS 是什么

LVS 特性

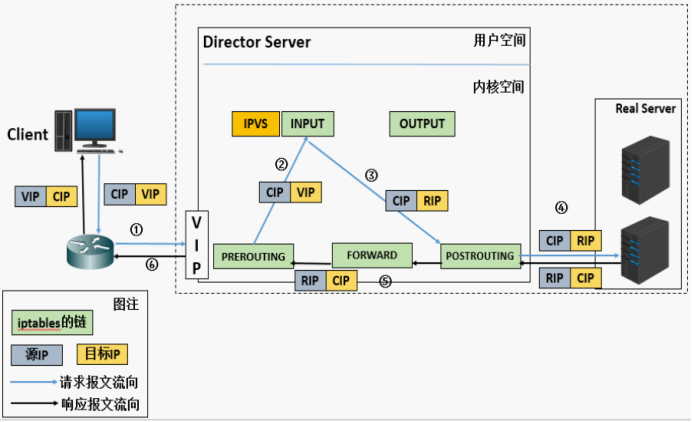

LVS 工作流程图

LVS 工作内核模型

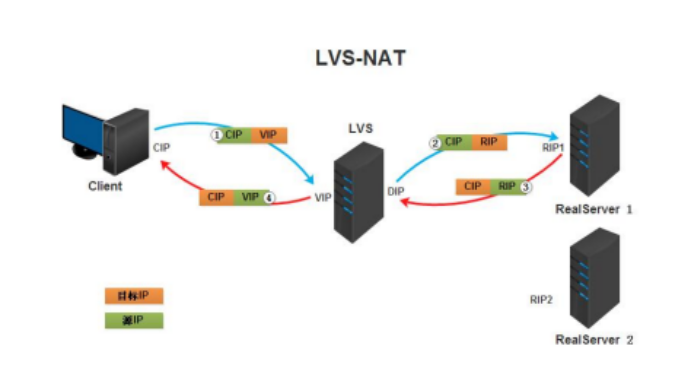

LVS 负载均衡 NAT 工作流程

实验:负载均衡集群企业级应用实战 -LVS-nat 模式

一. 在 DR 负载均衡器配置

二. 在 real server 配置

三,验证

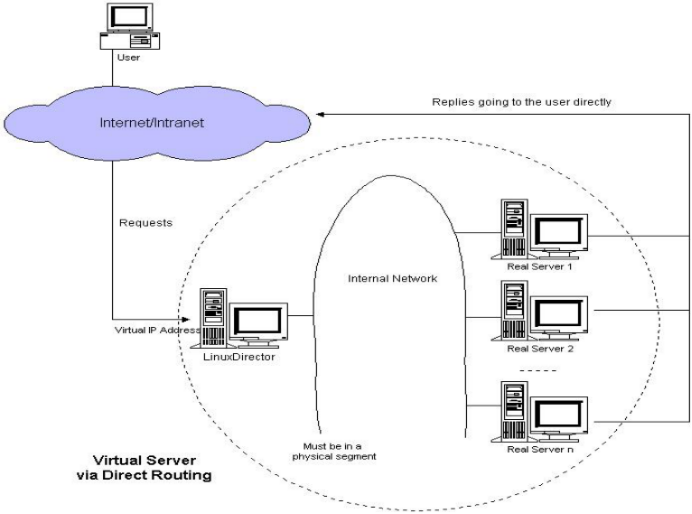

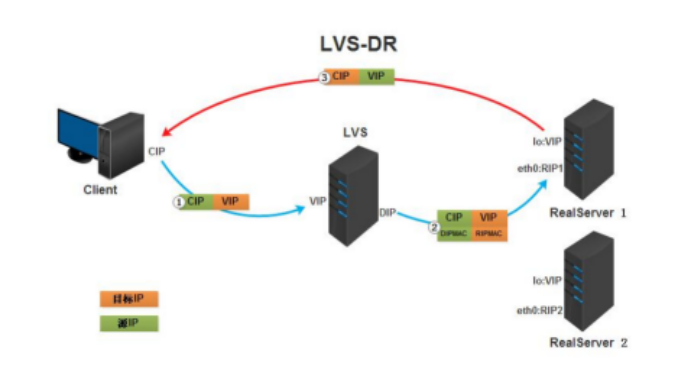

LVS 负载均衡 DR 工作模式

数据包到后端服务器时经过负载均衡器,回来的时候,直接发送到客户端,不经过负载均衡器,大大提高了效率。

LVS 负载均衡 DR 工作流程

特点:

实验:负载均衡集群企业级应用实战 -LVS-DR 模式:

一,在 DR 负载均衡器上

二,在 RS 后端服务器上

三,验证

好了,这期的内容就到这里,下期再见。

一些关于 Keepalived 相关教程集合:

CentOS 7 下 Keepalived + HAProxy 搭建配置详解 http://www.linuxidc.com/Linux/2017-03/141593.htm

Keepalived 高可用集群应用场景与配置 http://www.linuxidc.com/Linux/2017-03/141866.htm

Nginx+Keepalived 实现站点高可用 http://www.linuxidc.com/Linux/2016-12/137883.htm

Nginx+Keepalived 实现站点高可用(负载均衡) http://www.linuxidc.com/Linux/2016-12/138221.htm

构建高可用集群 Keepalived+Haproxy 负载均衡 http://www.linuxidc.com/Linux/2016-12/138917.htm

Keepalived 高可用 LVS http://www.linuxidc.com/Linux/2017-03/142235.htm

CentOS6.5 下 Keepalived 高可用服务单实例配置 http://www.linuxidc.com/Linux/2016-12/138110.htm

Keepalived 安装与配置 http://www.linuxidc.com/Linux/2017-02/140421.htm

LVS 实现负载均衡集群企业级应用实战 http://www.linuxidc.com/Linux/2017-11/148270.htm

Keepalived+LVS-DR 实现实现负载均衡高可用集群 http://www.linuxidc.com/Linux/2017-12/149030.htm

Linux 下 Keepalived 服务安装文档 http://www.linuxidc.com/Linux/2017-03/141441.htm

本文永久更新链接地址:http://www.linuxidc.com/Linux/2017-12/149078.htm