共计 10215 个字符,预计需要花费 26 分钟才能阅读完成。

1.1 什么是SolrCloud

SolrCloud(solr 云 ) 是Solr提供的分布式搜索方案,当你需要大规模,容错,分布式索引和检索能力时使用 SolrCloud。当一个系统的索引数据量少的时候是不需要使用 SolrCloud 的,当索引量很大,搜索请求并发很高,这时需要使用SolrCloud 来满足这些需求。

SolrCloud是基于 Solr 和Zookeeper的分布式搜索方案,它的主要思想是使用 Zookeeper 作为集群的配置信息中心。

它有几个特色功能:

1)集中式的配置信息

2)自动容错

3)近实时搜索

4)查询时自动负载均衡

—————————————— 分割线 ——————————————

本文要用到的相关文件可从以下信息得到下载:

点击这个 http://www.linuxidc.com/Linux/2013-12/93755.htm 链接 关注 Linux 公社官方微信,关注后回复数字159306。即可得到网友的分享密码。

如果取消关注 Linux 公社公众号,即使再次关注,也将无法提供本服务!

链接: https://pan.baidu.com/s/1eYvEUUvUBMV4j7RMUxwtZQ 密码:获得见上面的方法,地址失效请在下面留言。

—————————————— 分割线 ——————————————

1.1.1 zookeeper是个什么玩意?

顾名思义 zookeeper 就是动物园管理员,他是用来管 Hadoop(大象)、Hive( 蜜蜂 )、pig( 小猪 ) 的管理员,Apache Hbase和 Apache Solr 的分布式集群都用到了 zookeeper;Zookeeper: 是一个分布式的、开源的程序协调服务,是 hadoop 项目下的一个子项目。

1.1.2 Zookeeper可以干哪些事情

1、配置管理

在我们的应用中除了代码外,还有一些就是各种配置。比如数据库连接等。一般我们都是使用配置文件的方式,在代码中引入这些配置文件。但是当我们只有一种配置,只有一台服务器,并且不经常修改的时候,使用配置文件是一个很好的做法,但是如果我们配置非常多,有很多服务器都需要这个配置,而且还可能是动态的话使用配置文件就不是个好主意了。这个时候往往需要寻找一种集中管理配置的方法,我们在这个集中的地方修改了配置,所有对这个配置感兴趣的都可以获得变更。比如我们可以把配置放在数据库里,然后所有需要配置的服务都去这个数据库读取配置。但是,因为很多服务的正常运行都非常依赖这个配置,所以需要这个集中提供配置服务的服务具备很高的可靠性。一般我们可以用一个集群来提供这个配置服务,但是用集群提升可靠性,那如何保证配置在集群中的一致性呢? 这个时候就需要使用一种实现了一致性协议的服务了。Zookeeper就是这种服务,它使用 Zab 这种一致性协议来提供一致性。现在有很多开源项目使用 Zookeeper 来维护配置,比如在 HBase 中,客户端就是连接一个 Zookeeper,获得必要的HBase 集群的配置信息,然后才可以进一步操作。还有在开源的消息队列 Kafka 中,也使用 Zookeeper 来维护 broker 的信息。在 Alibaba 开源的 SOA 框架 Dubbo 中也广泛的使用 Zookeeper 管理一些配置来实现服务治理。

2、名字服务

名字服务这个就很好理解了。比如为了通过网络访问一个系统,我们得知道对方的 IP 地址,但是 IP 地址对人非常不友好,这个时候我们就需要使用域名来访问。但是计算机是不能是别域名的。怎么办呢?如果我们每台机器里都备有一份域名到 IP 地址的映射,这个倒是能解决一部分问题,但是如果域名对应的 IP 发生变化了又该怎么办呢?于是我们有了 DNS 这个东西。我们只需要访问一个大家熟知的 (known) 的点,它就会告诉你这个域名对应的 IP 是什么。在我们的应用中也会存在很多这类问题,特别是在我们的服务特别多的时候,如果我们在本地保存服务的地址的时候将非常不方便,但是如果我们只需要访问一个大家都熟知的访问点,这里提供统一的入口,那么维护起来将方便得多了。

3、分布式锁

其实在第一篇文章中已经介绍了 Zookeeper 是一个分布式协调服务。这样我们就可以利用 Zookeeper 来协调多个分布式进程之间的活动。比如在一个分布式环境中,为了提高可靠性,我们的集群的每台服务器上都部署着同样的服务。但是,一件事情如果集群中的每个服务器都进行的话,那相互之间就要协调,编程起来将非常复杂。而如果我们只让一个服务进行操作,那又存在单点。通常还有一种做法就是使用分布式锁,在某个时刻只让一个服务去干活,当这台服务出问题的时候锁释放,立即 fail over 到另外的服务。这在很多分布式系统中都是这么做,这种设计有一个更好听的名字叫 Leader Election(leader 选举 )。比如HBase 的Master就是采用这种机制。但要注意的是分布式锁跟同一个进程的锁还是有区别的,所以使用的时候要比同一个进程里的锁更谨慎的使用。

4、集群管理

在分布式的集群中,经常会由于各种原因,比如硬件故障,软件故障,网络问题,有些节点会进进出出。有新的节点加入进来,也有老的节点退出集群。这个时候,集群中其他机器需要感知到这种变化,然后根据这种变化做出对应的决策。比如我们是一个分布式存储系统,有一个中央控制节点负责存储的分配,当有新的存储进来的时候我们要根据现在集群目前的状态来分配存储节点。这个时候我们就需要动态感知到集群目前的状态。还有,比如一个分布式的 SOA 架构中,服务是一个集群提供的,当消费者访问某个服务时,就需要采用某种机制发现现在有哪些节点可以提供该服务 ( 这也称之为服务发现,比如 Alibaba 开源的 SOA 框架 Dubbo 就采用了 Zookeeper 作为服务发现的底层机制 )。还有开源的Kafka 队列就采用了 Zookeeper 作为 Cosnumer 的上下线管理。

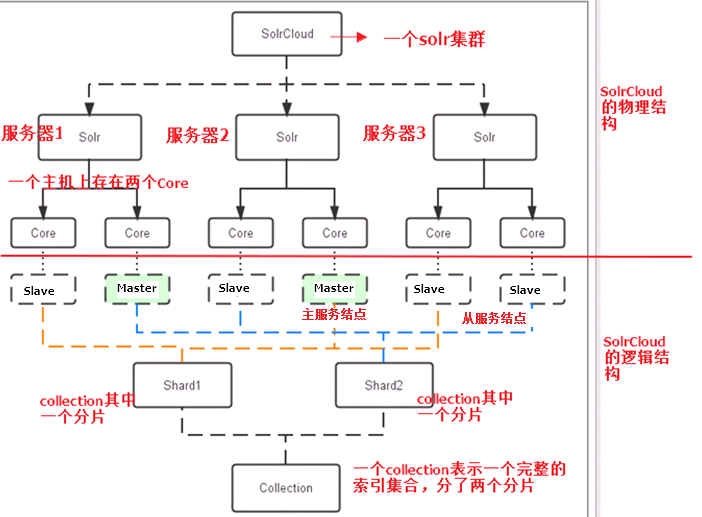

1.2 Solr集群的结构

1.3 Solr集群的搭建

本教程的这套安装是单机版的安装,所以采用伪集群的方式进行安装,如果是真正的生产 环境,将伪集群的 ip 改下就可以了,步骤是一样的。

SolrCloud结构图如下:

需要三个 zookeeper 节点

四个 solr 节点。

使用伪分布式实现 solr 集群。需要三个 zookeeper 实例,4个 tomcat 实例,可以在一台虚拟机上模拟。建议虚拟机 1G 以上内存。

1.4 Zookeeper集群的搭建

1.4.1 前台条件

三个 zookeeper 实例。Zookeeper也是 Java 开发的所以需要安装jdk。

1、Linux系统

2、Jdk环境。

3、Zookeeper。

1.4.2 Zookeeper的安装步骤

准备安装包:

链接:https://pan.baidu.com/s/1DnjSW-4mpdkPCR5v3UN7mw

提取码:8ilt

第一步:把 zookeeper 的安装包上传到服务器

第二步:解压缩。

[root@bogon ~]# tar -zxf zookeeper-3.4.6.tar.gz

[root@bogon ~]#

第三步:在 /usr/local/ 目录下创建一个 solrcloud 目录。把 zookeeper 解压后的文件夹复制到此目录下三份。分别命名为zookeeper1、2、3

[root@bogon ~]# mkdir /usr/local/solrcloud

[root@bogon ~]# mv zookeeper-3.4.6 /usr/local/solrcloud/zookeeper1

[root@bogon ~]# cd /usr/local/solrcloud

[root@bogon solrcloud]# ll

total 4

drwxr-xr-x. 10 1000 1000 4096 Feb 20 2014 zookeeper1

[root@bogon solrcloud]# cp -r zookeeper1/ zookeeper2

[root@bogon solrcloud]# cp -r zookeeper1/ zookeeper3

[root@bogon solrcloud]#

第四步:配置zookeeper。

1、在每个 zookeeper 文件夹下创建一个 data 目录。

2、在 data 文件夹下创建一个文件名称为 myid,文件的内容就是此zookeeper 的编号1、2、3

[root@bogon data]# echo 1 >> myid

[root@bogon data]# ll

total 4

-rw-r–r–. 1 root root 2 Sep 17 23:43 myid

[root@bogon data]# cat myid

1

[root@bogon data]#

在 zookeeper2、3 文件夹下分别创建 data 目录和 myid 文件

[root@bogon solrcloud]# mkdir zookeeper2/data

[root@bogon solrcloud]# echo 2 >> zookeeper2/data/myid

[root@bogon solrcloud]# ll zookeeper2/data

total 4

-rw-r–r–. 1 root root 2 Sep 17 23:44 myid

[root@bogon solrcloud]# cat zookeeper2/data/myid

2

[root@bogon solrcloud]# mkdir zookeeper3/data

[root@bogon solrcloud]# echo 3 >> zookeeper3/data/myid

[root@bogon solrcloud]#

3、把 zookeeper1 下conf目录下的 zoo_sample.cfg 文件复制一份改名为zoo.cfg

[root@bogon conf]# cp zoo_sample.cfg zoo.cfg

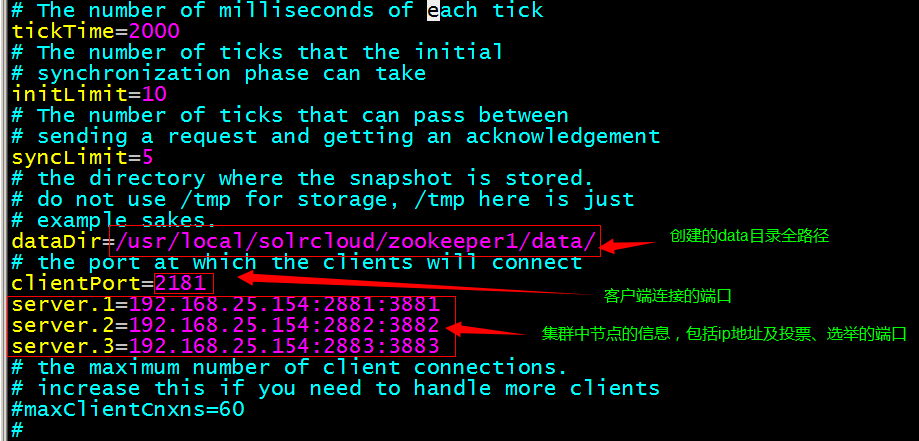

4、修改 zoo.cfg 的配置

vim zoo.cfg

对 zookeeper2、3 中的设置做第二步至第四步修改。

zookeeper2:

myid 内容为 2

dataDir=/usr/local/solrcloud/zookeeper2/data

clientPort=2182

Zookeeper3:

的 myid 内容为 3

dataDir=/usr/local/solrcloud/zookeeper3/data

clientPort=2183

第五步:

启动三个 zookeeper

/usr/local/solrcloud/zookeeper1/bin/zkServer.sh start

/usr/local/solrcloud/zookeeper2/bin/zkServer.sh start

/usr/local/solrcloud/zookeeper3/bin/zkServer.sh start

查看集群状态:

/usr/local/solrcloud/zookeeper1/bin/zkServer.sh status

/usr/local/solrcloud/zookeeper2/bin/zkServer.sh status

/usr/local/solrcloud/zookeeper3/bin/zkServer.sh status

状态信息如下:

[root@bogon solrcloud]# /usr/local/solrcloud/zookeeper1/bin/zkServer.sh status

JMX enabled by default

Using config: /usr/local/solrcloud/zookeeper1/bin/../conf/zoo.cfg

Mode: follower

[root@bogon solrcloud]# /usr/local/solrcloud/zookeeper2/bin/zkServer.sh status

JMX enabled by default

Using config: /usr/local/solrcloud/zookeeper2/bin/../conf/zoo.cfg

Mode: leader

[root@bogon solrcloud]# /usr/local/solrcloud/zookeeper3/bin/zkServer.sh status

JMX enabled by default

Using config: /usr/local/solrcloud/zookeeper3/bin/../conf/zoo.cfg

Mode: follower

[root@bogon solrcloud]#

1.5 Solr实例的搭建

第一步:将 apache-tomcat-7.0.47.tar.gz 解压

tar -zxvf apache-tomcat-7.0.47.tar.gz

第二步:把解压后的 tomcat 复制到 /usr/local/solrcloud/ 目录下复制四份。

cp apache-tomcat-7.0.47 /usr/local/solrcloud/tomcat1 -r

cp apache-tomcat-7.0.47 /usr/local/solrcloud/tomcat2 -r

cp apache-tomcat-7.0.47 /usr/local/solrcloud/tomcat3 -r

cp apache-tomcat-7.0.47 /usr/local/solrcloud/tomcat4 -r

第三步:修改 tomcat 的 server.xml

vim tomcat2/conf/server.xml,把其中的端口后都加一。保证两个 tomcat 可以正常运行不发生端口冲突。

第四步:解压 solr-4.10.3.tar.gz 压缩包。复制 solr.war 到tomcat。

cd solr-4.10.3/dist

cp solr-4.10.3.war /usr/local/solrcloud/tomcat1/webapps/solr.war

cp solr-4.10.3.war /usr/local/solrcloud/tomcat2/webapps/solr.war

cp solr-4.10.3.war /usr/local/solrcloud/tomcat3/webapps/solr.war

cp solr-4.10.3.war /usr/local/solrcloud/tomcat4/webapps/solr.war

第五步:启动 tomcat 解压 war 包。把 solr-4.10.3 目录下 example 目录下的关于日志相关的 jar 包添加到 solr 工程中(可参考上一篇 solr 单机版的文章 https://www.cnblogs.com/hxun/p/11159031.html)。

这里直接拷贝上篇文章搭建 配置好的 solr 文件

cd solr/tomcat/webapps/

cp solr -r ../../../solrcloud/tomcat1/webapps/

cp solr -r ../../../solrcloud/tomcat2/webapps/

cp solr -r ../../../solrcloud/tomcat3/webapps/

cp solr -r ../../../solrcloud/tomcat4/webapps/

第六步:拷贝单机版的 solrhome。修改每个web.xml 指定 solrhome 的位置。

cd /usr/local/solr/

cp -r solrhome/ ../solrcloud/solrhome1

cp -r solrhome/ ../solrcloud/solrhome2

cp -r solrhome/ ../solrcloud/solrhome3

cp -r solrhome/ ../solrcloud/solrhome4

vim tomcat1/webapps/solr/WEB-INF/web.xml

vim tomcat2/webapps/solr/WEB-INF/web.xml

vim tomcat3/webapps/solr/WEB-INF/web.xml

vim tomcat4/webapps/solr/WEB-INF/web.xml

分别修改路径为

/usr/local/solrcloud/solrhome1

/usr/local/solrcloud/solrhome2

/usr/local/solrcloud/solrhome3

/usr/local/solrcloud/solrhome4

1.6 solr集群的搭建

1.6.1 第一步

把 solrhome 中的配置文件上传到 zookeeper 集群。使用 zookeeper 的客户端上传。

进入客户端命令位置:cd /root/solr-4.10.3/example/scripts/cloud-scripts

./zkcli.sh -zkhost 192.168.25.154:2181,192.168.25.154:2182,192.168.25.154:2183 -cmd upconfig -confdir /usr/local/solrcloud/solrhome1/collection1/conf -confname myconf |

查看配置文件是否上传成功:

[root@bogon bin]# cd /usr/local/solrcloud/zookeeper1/bin/

[root@bogon bin]# ./zkCli.sh

Connecting to localhost:2181

[zk: localhost:2181(CONNECTED) 0] ls /

[configs, zookeeper]

[zk: localhost:2181(CONNECTED) 1] ls /configs

[myconf]

[zk: localhost:2181(CONNECTED) 2] ls /configs/myconf

[admin-extra.menu-top.html, currency.xml, protwords.txt, mapping-FoldToASCII.txt, _schema_analysis_synonyms_english.json, _rest_managed.json, solrconfig.xml, _schema_analysis_stopwords_english.json, stopwords.txt, lang, spellings.txt, mapping-ISOLatin1Accent.txt, admin-extra.html, xslt, synonyms.txt, scripts.conf, update-script.js, velocity, elevate.xml, admin-extra.menu-bottom.html, clustering, schema.xml]

[zk: localhost:2181(CONNECTED) 3]

1.6.2 第二步

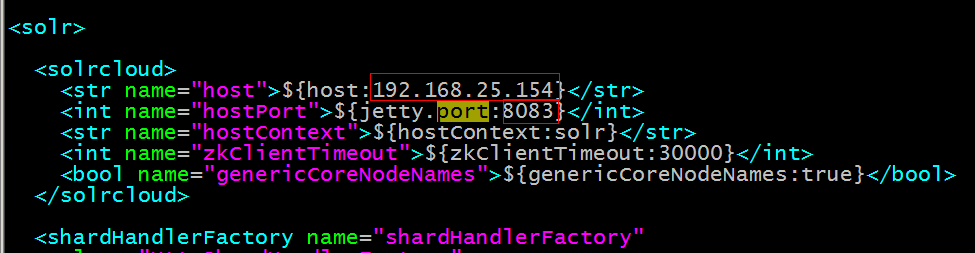

修改 solrhome 下的 solr.xml 文件,指定当前实例运行的 ip 地址及端口号。

vim /usr/local/solrcloud/solrhome1/solr.xml

vim /usr/local/solrcloud/solrhome2/solr.xml

vim /usr/local/solrcloud/solrhome3/solr.xml

vim /usr/local/solrcloud/solrhome4/solr.xml

修改 host 和 prot 从 8080 到 8083

1.6.3 第三步

修改每一台 solr 的tomcat 的 bin目录下 catalina.sh 文件中加��DzkHost指定 zookeeper 服务器地址:

vim /usr/local/solrcloud/tomcat1/bin/catalina.sh

vim /usr/local/solrcloud/tomcat2/bin/catalina.sh

vim /usr/local/solrcloud/tomcat3/bin/catalina.sh

vim /usr/local/solrcloud/tomcat4/bin/catalina.sh

JAVA_OPTS=”-DzkHost=192.168.25.154:2181,192.168.25.154:2182,192.168.25.154:2183″

(可以使用 vim的查找功能查找到JAVA_OPTS 的定义的位置,然后添加)

1.6.4 第四步

重新启动tomcat。

如果觉得一个个启动 tomcat 麻烦可以编写脚本一键启动 如下:

vim /usr/local/solrcloud/startall.sh

编写内容:

/usr/local/solrcloud/tomcat1/bin/startup.sh

/usr/local/solrcloud/tomcat2/bin/startup.sh

/usr/local/solrcloud/tomcat3/bin/startup.sh

/usr/local/solrcloud/tomcat4/bin/startup.sh

加权限:

chmod +x /usr/local/solrcloud/startall.sh

执行脚本:/usr/local/solrcloud/startupall.sh

一键关闭同理。

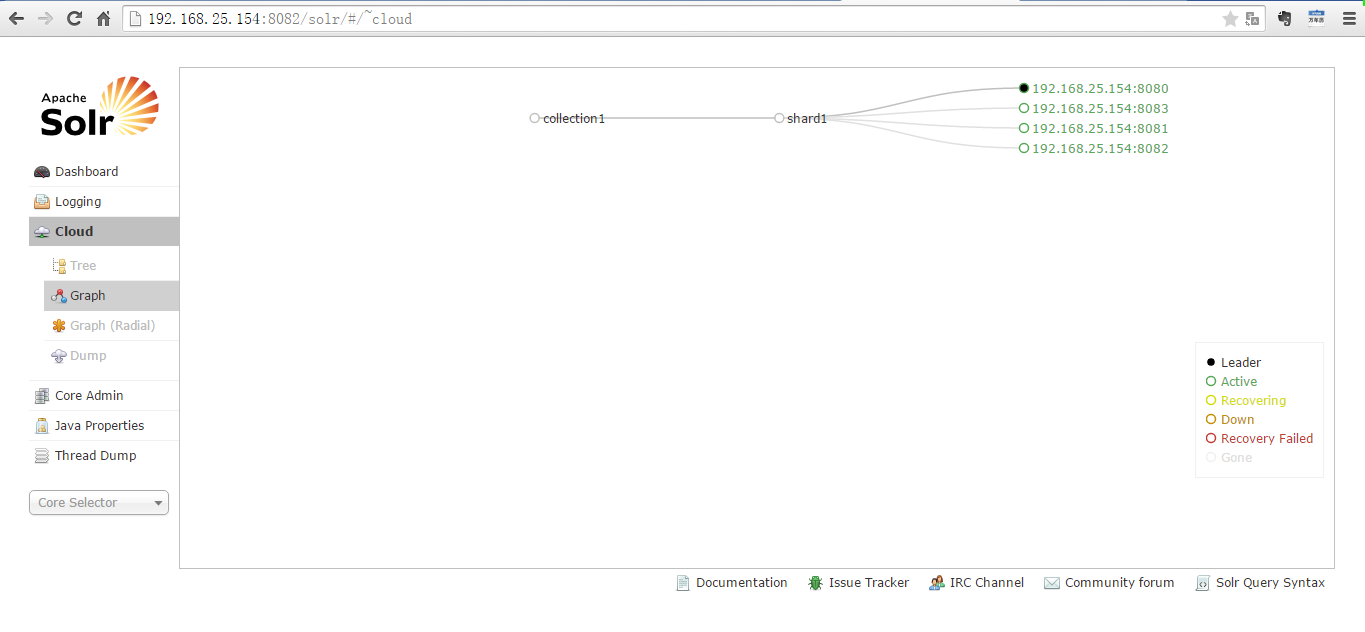

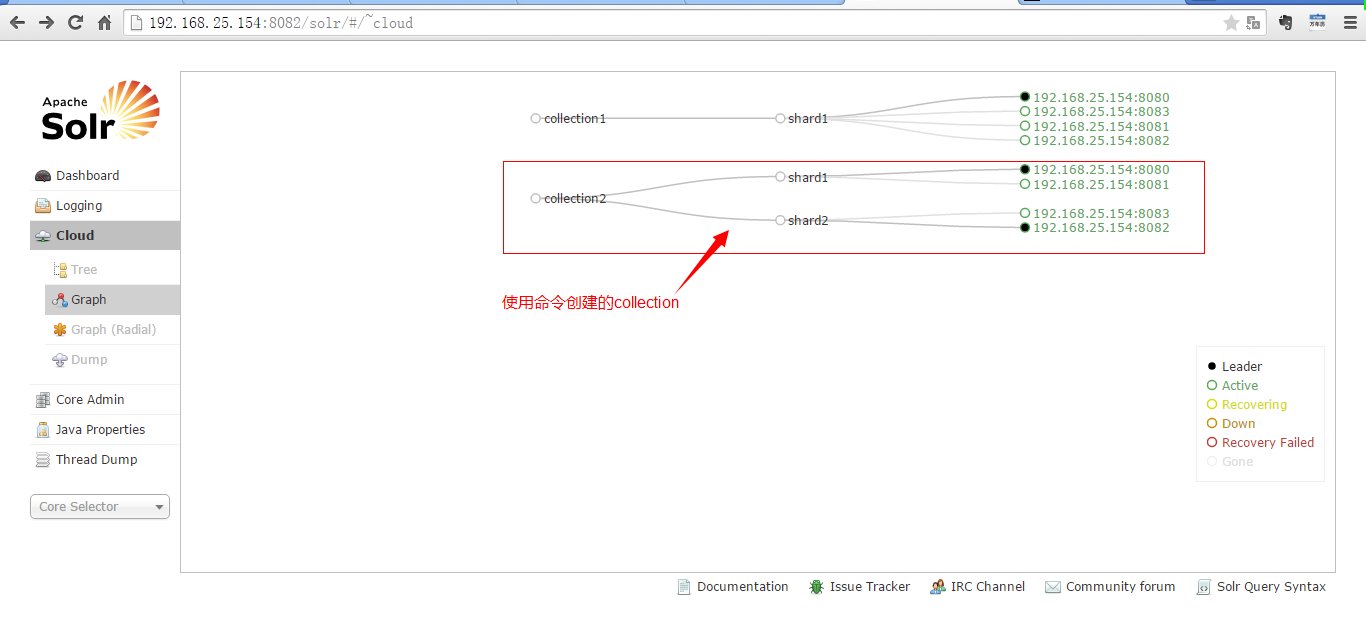

一个主节点多个备份节点,集群只有一片。

1.6.5 第五步

创建一个两片的 collection,每片是一主一备。

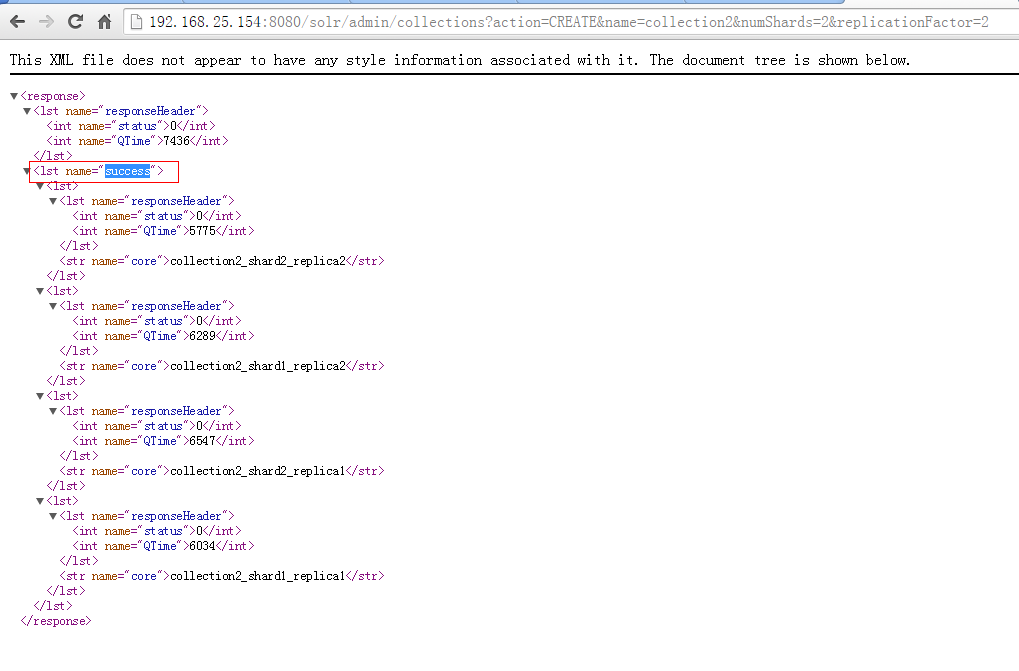

在浏览器地址栏使用以下命令创建:

http://192.168.25.154:8080/solr/admin/collections?action=CREATE&name=collection2&numShards=2&replicationFactor=2

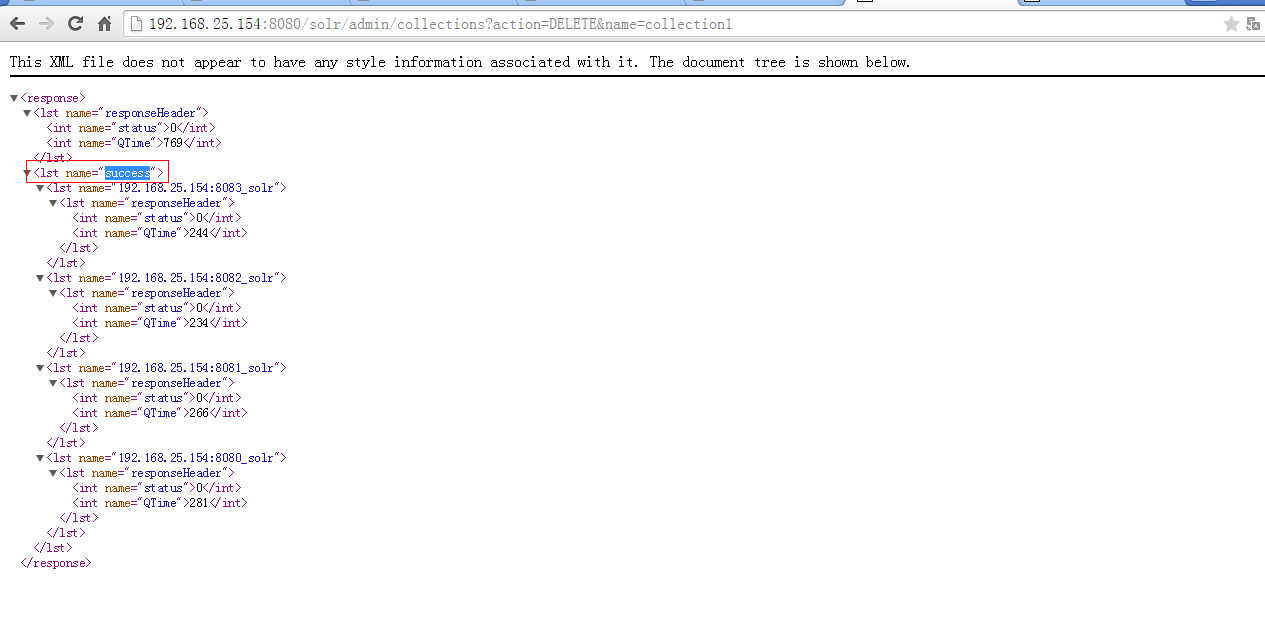

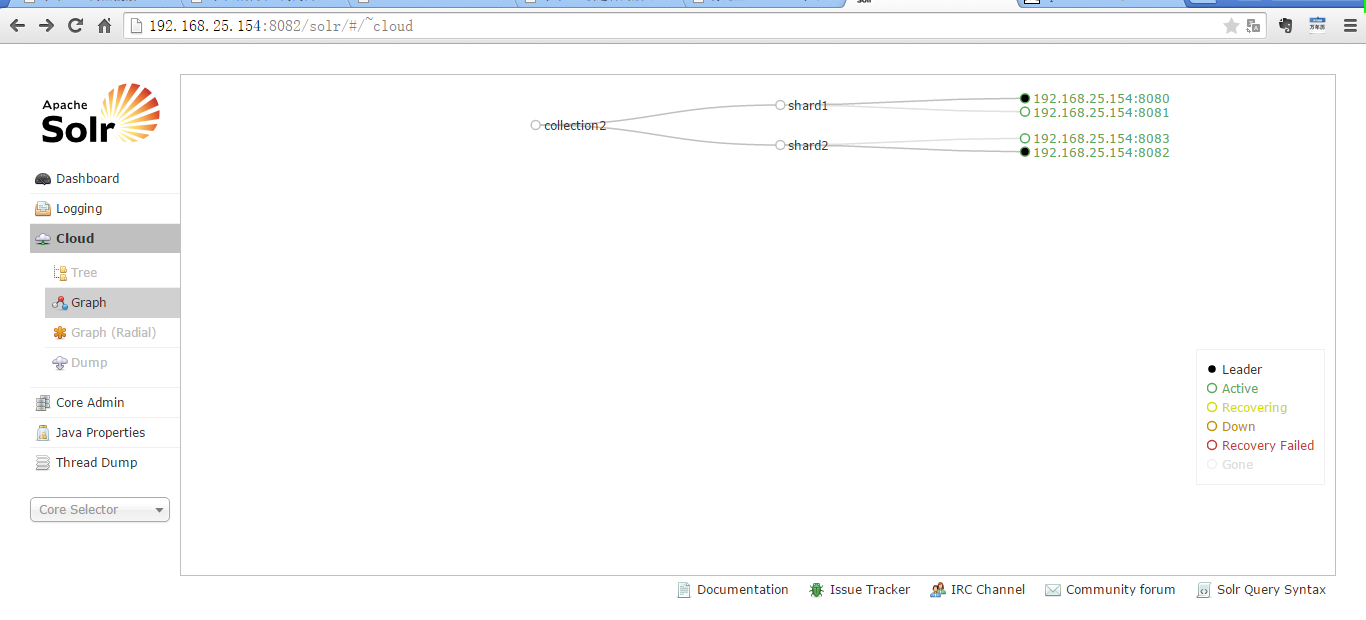

1.6.6 第六步

删除 collection1.

http://192.168.25.154:8080/solr/admin/collections?action=DELETE&name=collection1

2 Solr集群的使用

使用 solrj 操作集群环境的索引库。

2.1 Solrj测试

public class SolrCloudTest { @Test public void testAddDocument() throws Exception { // 创建一个和 solr 集群的连接 // 参数就是 zookeeper 的地址列表,使用逗号分隔 String zkHost = “192.168.25.154:2181,192.168.25.154:2182,192.168.25.154:2183”; CloudSolrServer solrServer = new CloudSolrServer(zkHost); // 设置默认的 collection solrServer.setDefaultCollection(“collection2”); // 创建一个文档对象 SolrInputDocument document = new SolrInputDocument(); // 向文档中添加域 document.addField(“id”, “test001”); document.addField(“item_title”, “ 测试商品 ”); // 把文档添加到索引库 solrServer.add(document); // 提交 solrServer.commit(); } @Test public void deleteDocument() throws SolrServerException, IOException { // 创建一个和 solr 集群的连接 // 参数就是 zookeeper 的地址列表,使用逗号分隔 String zkHost = “192.168.25.154:2181,192.168.25.154:2182,192.168.25.154:2183”; CloudSolrServer solrServer = new CloudSolrServer(zkHost); // 设置默认的 collection solrServer.setDefaultCollection(“collection2”); solrServer.deleteByQuery(“*:*”); solrServer.commit(); } } |

2.2 Solrj和 spring 集成

修改 spring 的配置文件,添加集群版的配置:

<!– 集群版 –> <bean id=“cloudSolrServer” class=“org.apache.solr.client.solrj.impl.CloudSolrServer”> <constructor-arg name=“zkHost” value=“192.168.25.154:2181,192.168.25.154:2182,192.168.25.154:2183”></constructor-arg> <property name=“defaultCollection” value=“collection2”></property> </bean> |

: