共计 3574 个字符,预计需要花费 9 分钟才能阅读完成。

CRM: Cluster Resources Manager

为那些非 ha-ware 的应用程序提供调用的基础平台

一般情况下,一个高可用服务包括多个资源,从属于同一个服务的多个资源必须运行于一个节点上,默认情况下是平列的(做完该实验相信你对集群资源节点的相关机制会有一定的认识)

配置过程:(这里我继续使用上节的环境)http://www.linuxidc.com/Linux/2014-03/98672.htm

# ssh node2 ‘service heartbeat stop’

# service heartbeat stop

# vim ha.cf

mcast eth0 225.0.100.1 694 1 0

crm respawn

#CRM 与 Resources 并不兼容,如果 ha.cf 中定义了 CRM,HA 服务不会去读取 /etc/ha.d/haresources 配置文件。如果你执意要使用这种配置,也是行的,下面看一下他的配置方法:

# cd /usr/lib/heartbeat

# ./haresources2cib.py /etc/ha.d/haresources

当然了,我们这里主要介绍 crm 配置方法,下面继续

# /usr/lib/heartbeat/ha_propagate //heartbeat 自带的复制本节点的 ha.cf&authkeys 文件到其它节点

查看日志:

# tail -f /var/log/messages

info: update_dc: Set DC to node2.neo.com (2.0)

# netstat -tnlp

tcp 0 0 0.0.0.0:5560 0.0.0.0:* LISTEN 4877/mgmtd

此时我们可以使用各种 crm/cib 的命令行工具

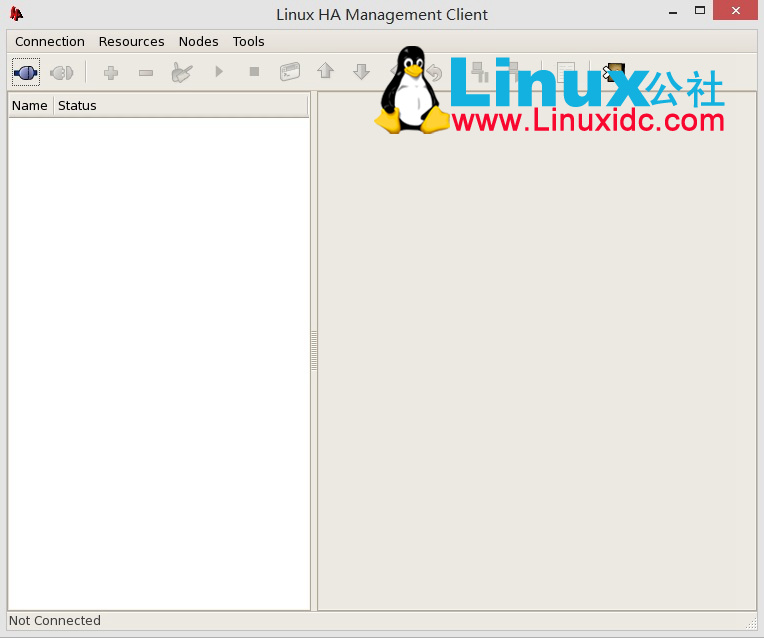

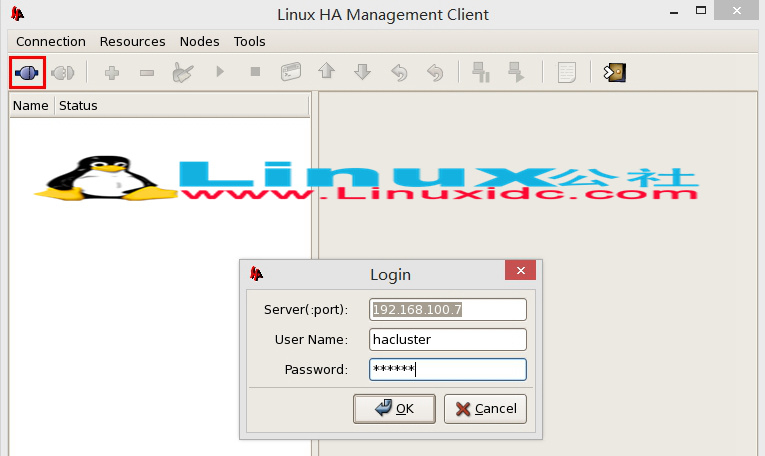

下面我们通过 heartbeat-gui 配置集群服务

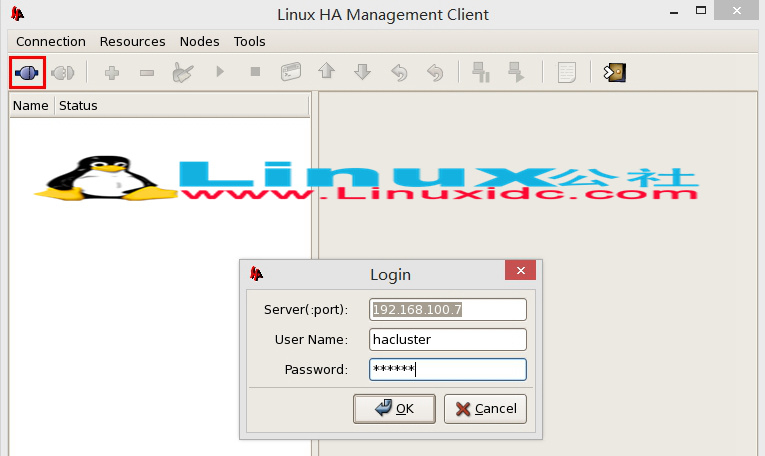

由于使用 GUI 配置需要 heartbeat 包自带的帐号 hacluster 连接,所以需要为其设置密码

# passwd hacluster

# hb_gui

注意:这里配置过程我们先建立 group, 然后依先后顺序建立资源, 并且需要连接到 DC 节点上进行配置,查看哪个节点是 DC 我们可以使用 crm_mon 进行查看

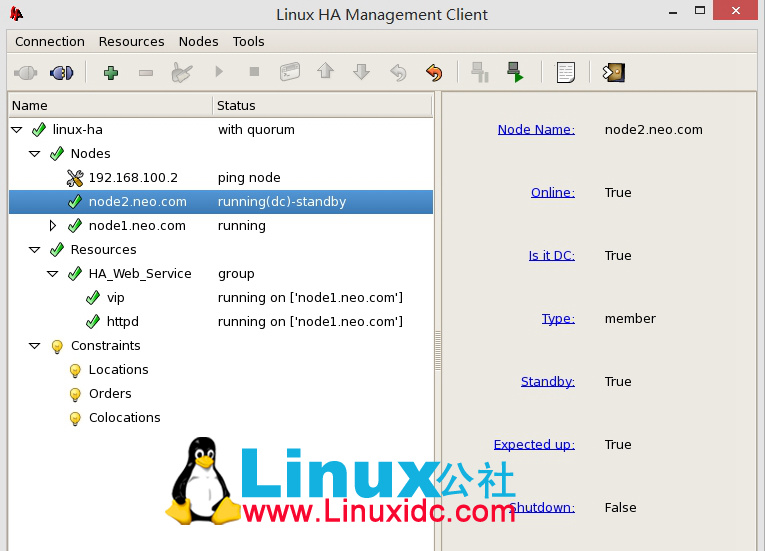

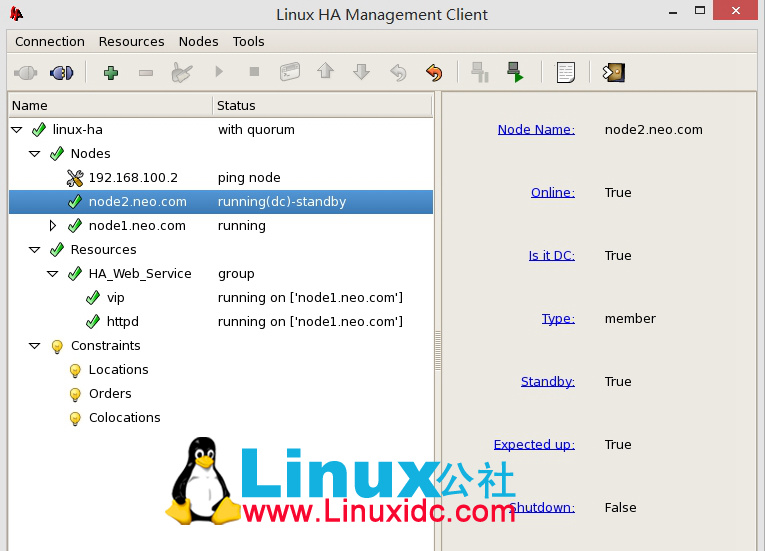

然后测试浏览器是否能访问 node2, 而后我们手动测试将 node2 设置为 standby,看其是否能将服务转移到 node1 上来

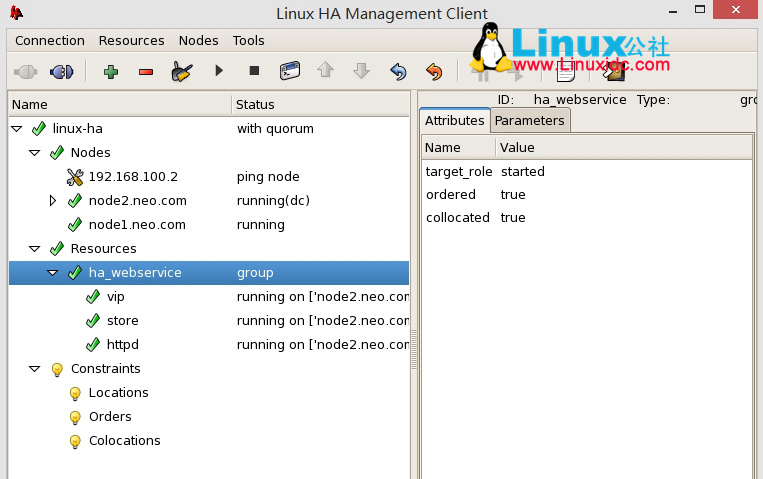

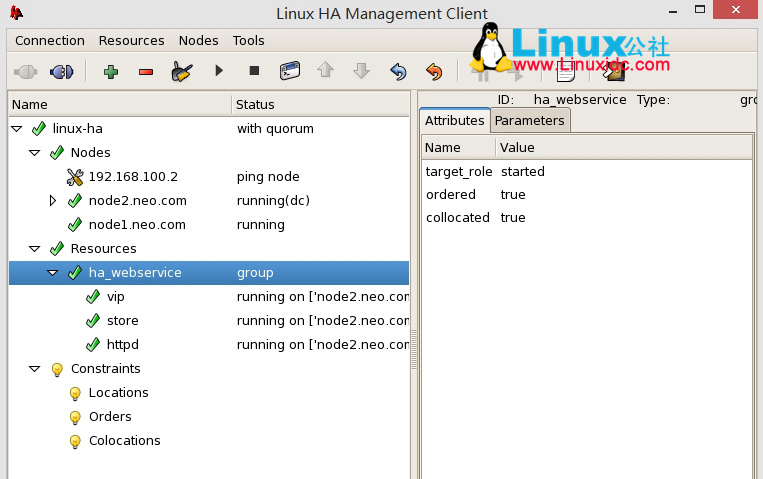

添加 NFS 共享存储到该资源

注意:这里需要按次序新建资源节点,如果不能在 GUI 界面调整上下次序需要删除原有资源再新建(由于 httpd 与 nfs 不在同一台主机,我们肯定是先启动文件服务再启动 httpd 服务吧),并且要记得在删除资源时需要清除缓存数据,否则可能会影响后面启动

以上是通过组的方式创建的

推荐阅读:

Linux 高可用(HA)集群之 heartbeat 基于 crm 进行资源管理详解 http://www.linuxidc.com/Linux/2013-08/89167.htm

Heartbeat+httpd+NFS 实现高可用的 Web 服务器 http://www.linuxidc.com/Linux/2013-08/88520.htm

Linux 高可用(HA)集群之 Heartbeat 详解 http://www.linuxidc.com/Linux/2013-08/88521.htm

Linux 高可用性方案之 Heartbeat 的 CRM 配置 http://www.linuxidc.com/Linux/2012-05/60838.htm

高可用集群 Heartbeat v1 实例 http://www.linuxidc.com/Linux/2013-09/90757.htm

LVS+heartbeat+ldirectord 高可用负载均衡集群解决方案 http://www.linuxidc.com/Linux/2011-09/42911.htm

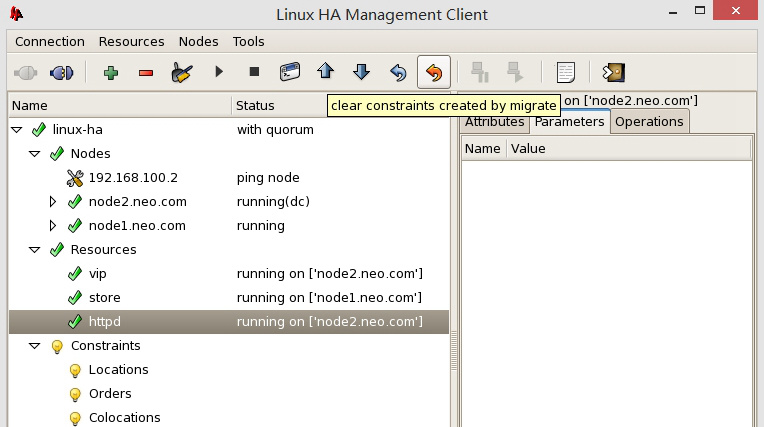

下面我们通过约束的方式创建集群:

分别建立资源

上图可以看出,如果我们现在就启动,你会看到各资源会运行在不同节点上,这显然不符合我们的要求

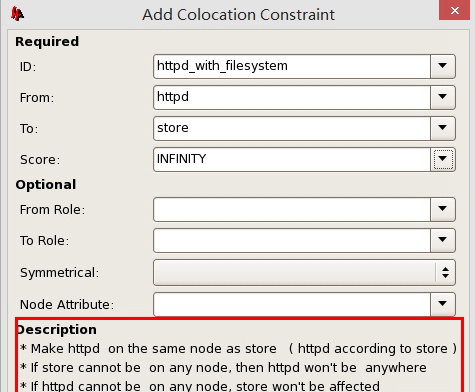

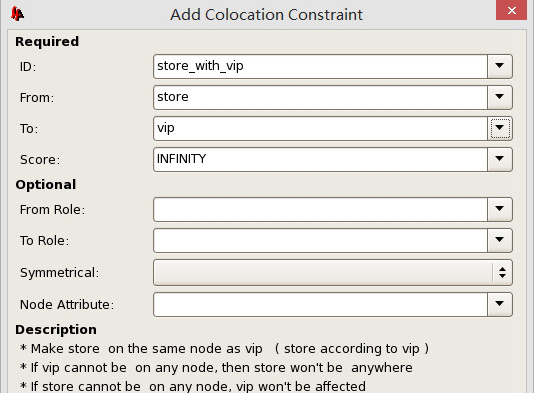

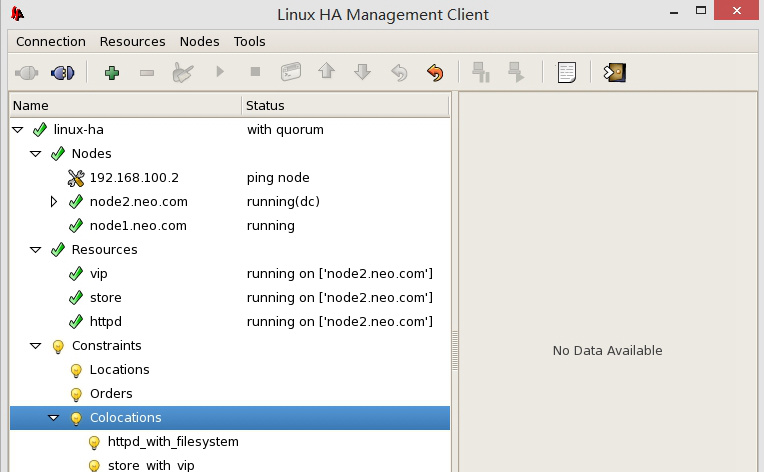

创建 Colocations

这时我们可以看到各资源都运行到同一节点上了

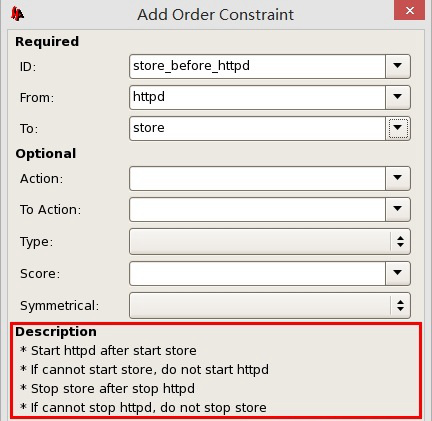

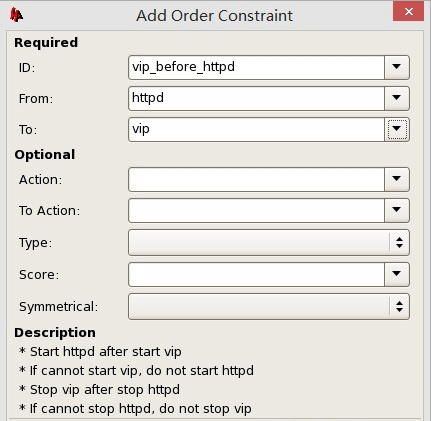

下面继续设定资源启动次序

我们手动资源迁移时可以看到它的启动和关闭次序

全局参数中:

Default Resource Stickiness: 当设置为大于 0 的值时,表示资源更趋向运行于当前节点上

我们也可以设定 Locations(位置约束)值来定义资源运行在哪个节点上

总结,我们的资源到底是运行于哪一节点是看:这个组内或节点的所有资源的粘性值,约束值的和

当我们强制断电某一节点,heartbeat 会尝试与这一节点保持通信,所以它没有关闭服务转移的速度快,另外如果我们将设置 Stickiness 和 Locations 值,更趋向于运行于这一节点,且 heartbeat 开机自动启动,当它重新上线时,所有资源将自动切换到这一节点上。

CRM: Cluster Resources Manager

为那些非 ha-ware 的应用程序提供调用的基础平台

一般情况下,一个高可用服务包括多个资源,从属于同一个服务的多个资源必须运行于一个节点上,默认情况下是平列的(做完该实验相信你对集群资源节点的相关机制会有一定的认识)

配置过程:(这里我继续使用上节的环境)http://www.linuxidc.com/Linux/2014-03/98672.htm

# ssh node2 ‘service heartbeat stop’

# service heartbeat stop

# vim ha.cf

mcast eth0 225.0.100.1 694 1 0

crm respawn

#CRM 与 Resources 并不兼容,如果 ha.cf 中定义了 CRM,HA 服务不会去读取 /etc/ha.d/haresources 配置文件。如果你执意要使用这种配置,也是行的,下面看一下他的配置方法:

# cd /usr/lib/heartbeat

# ./haresources2cib.py /etc/ha.d/haresources

当然了,我们这里主要介绍 crm 配置方法,下面继续

# /usr/lib/heartbeat/ha_propagate //heartbeat 自带的复制本节点的 ha.cf&authkeys 文件到其它节点

查看日志:

# tail -f /var/log/messages

info: update_dc: Set DC to node2.neo.com (2.0)

# netstat -tnlp

tcp 0 0 0.0.0.0:5560 0.0.0.0:* LISTEN 4877/mgmtd

此时我们可以使用各种 crm/cib 的命令行工具

下面我们通过 heartbeat-gui 配置集群服务

由于使用 GUI 配置需要 heartbeat 包自带的帐号 hacluster 连接,所以需要为其设置密码

# passwd hacluster

# hb_gui

注意:这里配置过程我们先建立 group, 然后依先后顺序建立资源, 并且需要连接到 DC 节点上进行配置,查看哪个节点是 DC 我们可以使用 crm_mon 进行查看

然后测试浏览器是否能访问 node2, 而后我们手动测试将 node2 设置为 standby,看其是否能将服务转移到 node1 上来

添加 NFS 共享存储到该资源

注意:这里需要按次序新建资源节点,如果不能在 GUI 界面调整上下次序需要删除原有资源再新建(由于 httpd 与 nfs 不在同一台主机,我们肯定是先启动文件服务再启动 httpd 服务吧),并且要记得在删除资源时需要清除缓存数据,否则可能会影响后面启动

以上是通过组的方式创建的

推荐阅读:

Linux 高可用(HA)集群之 heartbeat 基于 crm 进行资源管理详解 http://www.linuxidc.com/Linux/2013-08/89167.htm

Heartbeat+httpd+NFS 实现高可用的 Web 服务器 http://www.linuxidc.com/Linux/2013-08/88520.htm

Linux 高可用(HA)集群之 Heartbeat 详解 http://www.linuxidc.com/Linux/2013-08/88521.htm

Linux 高可用性方案之 Heartbeat 的 CRM 配置 http://www.linuxidc.com/Linux/2012-05/60838.htm

高可用集群 Heartbeat v1 实例 http://www.linuxidc.com/Linux/2013-09/90757.htm

LVS+heartbeat+ldirectord 高可用负载均衡集群解决方案 http://www.linuxidc.com/Linux/2011-09/42911.htm